基于视频识别的防尾随检测方法与流程

- 国知局

- 2024-10-09 15:40:27

本发明涉及防尾随检测,尤其涉及一种基于视频识别的防尾随检测方法。

背景技术:

1、现有的视频防尾随算法通常是基于目标检测的方法,利用深度学习目标检测方法对摄像头捕捉的图像进行行人或人头检测,通过人头或行人数目判断监控区域是否存在尾随,普通摄像头难免存在视角盲区,无法应对一些特殊的尾随情况,如身体被大人遮挡的儿童、怀抱的小婴儿等,再者,行人运动较快时捕捉到的图像帧常会出现运动模糊,运动模糊对检测算法又是一大挑战,常会出现误检情况;基于视频识别的方法对图像序列进行时空特征提取,综合时间和空间特征信息做出预测,可以避免视角盲区和运动模糊的难题,当前的视频识别架构大多基于3d卷积块或配合额外时间建模操作的2d卷积,均需将时间轴视为视频序列中的一个独立维度,需要大量的计算和内存资源,且限制了在移动设备上的应用,并且,视频识别的方法应用于防尾随场景时,需获取大量的正常和尾随视频来训练,而在实际应用中尾随案例为偶发现象,很难获取大量的视频作为训练集,而且视频数据的标注需要耗费较多的时间和精力,算力成本较大。

技术实现思路

1、本发明的一个目的在于提供一种基于视频识别的防尾随检测方法,通过视频识别将输入的视频数据分为不同的类别或标签,从而能够自动理解和识别视频内容,实现视频内容的智能分类和检索,此外,基于视频识别的方法能对图像序列进行时空特征提取,综合时间和空间特征信息做出预测,可以避免视角盲区和运动模糊的难题,并且,通过一个轻量级的视频识别网络,将视频序列的时间轴压缩到通道维度中,利用时间通道学习模块(ctl)帮助模型学习视频图像序列的时间位置动态和时间对象关系,免去额外对时间轴进行建模运算,大大降低了模型运算量且提高了识别准确率,使得该网络在移动设备上运行时,能够实现更快的视频理解速度,同时保持相当高的准确率。

2、本发明的其它优势和特点通过下述的详细说明得以充分体现并可通过所附权利要求中特地指出的手段和装置的组合得以实现。

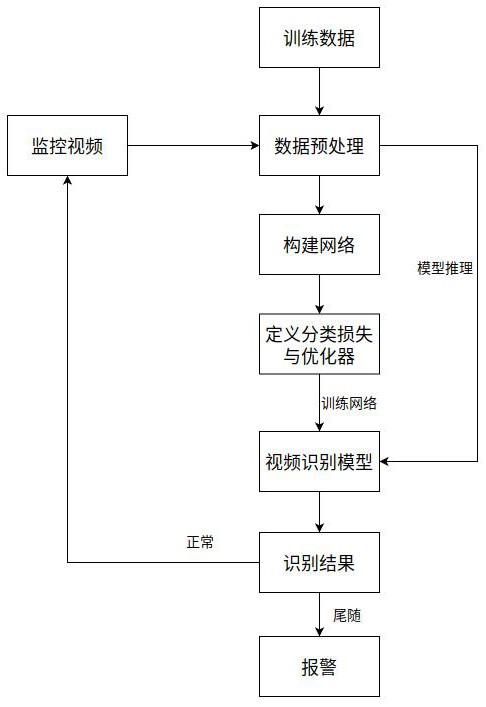

3、依本发明的一个方面,能够实现前述目的和其他目的和优势的本发明的一种基于视频识别的防尾随检测方法,包括以下步骤:

4、步骤a:输入视频图像帧序列,采用等间隔的采样策略截取视频图像;

5、步骤b:数据预处理时,将视频图像帧序列转化为视频识别网络所需的输入格式;

6、步骤c:构建一个视频识别网络模型,以供实现模型的精准识别和实时预测;

7、步骤d:定义分类损失函数监督模型训练,模型在训练过程中通过权重参数的迭代逐步达到收敛状态,训练期间,选取验证集中的最优的网络权重参数进行保存,生成视频识别模型;

8、步骤e:在实际推理过程中,直接载入视频识别网络模型权重参数来完成模型的推理过程,在推理模式下,对输入的防尾随监控视频进行采样抽帧得到视频图像帧序列,进行图像预处理,把预处理后数据输入视频识别模型进行预测,如果识别结果为正常,则不触发报警,继续输入视频流进行监控,如果识别结果为尾随,则触发报警信号。

9、根据本发明的一个实施例,所述步骤a包括子步骤a1:每间隔固定的帧数截取一帧图像,间隔帧数取值范围为4~8,输入视频识别网络的t帧图像序列记为。

10、根据本发明的一个实施例,所述步骤b包括子步骤b1:转化输入格式包括尺寸调整、标准化、维度转换。

11、根据本发明的一个实施例,所述步骤c包括子步骤c1:视频识别网络为轻量级,采用时间压缩,视频识别网络包括维度转换模块、卷积模块、最大池化模块、四个ctl模块、降采样模块、平均池化模块和全连接模块。

12、根据本发明的一个实施例,所述步骤c包括子步骤c2:ctl模块包括两个分支:一个分支负责时间重要性的学习,另一个具有时间位置恢复能力的分支能够增强跨时间的对象建模能力。

13、根据本发明的一个实施例,所述步骤c包括子步骤c3:ctl模块为残差结构,包括1x1卷积、ctl模组和1x1卷积,

14、根据本发明的一个实施例,所述步骤c包括子步骤c4:ctl模组为双分支结构,ctl模组的输出是两个分支输出特征向量的和。

15、根据本发明的一个实施例,所述步骤c包括子步骤c5:ctl模组的第一分支是由tfc即时间聚焦卷积构成,tfc引入注意力机制计算每个特征通道的权重,得到有时间重要性的特征向量,ctl模组的第二分支是由ioi跨时间交互构成,ioi还原时间位置动态和时间对象关系。

16、根据本发明的一个实施例,所述步骤c包括子步骤c6:ioi模块由两个分支构成,一个分支使用tfc将通道数c减少到帧数t,同时捕获时间重要性,注入时间位置编码信息,恢复时间动态,利用7 × 7卷积对t帧之间的对象关系进行建模,使用3 × 3卷积把通道数从t映射到c,使用激活函数得到在时间和位置二维空间上的权重向量,另一分支使用3 × 3卷积输出通道为c的特征图,与权重向量进行对应元素乘法运算,得到有时间位置动态和时间对象关系的特征向量。

17、根据本发明的一个实施例,所述步骤d包括子步骤d1:在训练模式下,对每个训练视频解析为图像序列,进行打标签动作,标签分为两类:正常和尾随,标签规则为:当视频里没有人或只有一个人时,标注为正常,当视频里人数大于一个人时,标注为尾随。

18、本发明的有益效果是:通过一个轻量级的视频识别网络,将视频序列的时间轴压缩到通道维度中,利用时间通道学习模块(ctl)帮助模型学习视频图像序列的时间位置动态和时间对象关系,免去额外对时间轴进行建模运算,大大降低了模型运算量且提高了识别准确率,使得该网络在移动设备上运行时,能够实现更快的视频理解速度,同时保持相当高的准确率,此外,深度学习预训练加微调的方法能够解决标注数据稀缺的难题,以监督或无监督的方式在大型数据集上预训练模型,通过微调将预训练的模型在较小的数据集上适应特定的下游任务,能够避免为不同的任务或数据集从头开始训练新模型,在较大的数据集上进行预训练有助于学习通用表征,从而提高下游任务的性能。

技术特征:1.一种基于视频识别的防尾随检测方法,其特征在于,包括以下步骤:

2.根据权利要求1所述的防尾随检测方法,其特征在于,所述步骤a包括子步骤a1:每间隔固定的帧数截取一帧图像,间隔帧数取值范围为4~8,输入视频识别网络的t帧图像序列记为。

3.根据权利要求2所述的防尾随检测方法,其特征在于,所述步骤b包括子步骤b1:转化输入格式包括尺寸调整、标准化、维度转换。

4.根据权利要求3所述的防尾随检测方法,其特征在于,所述步骤c包括子步骤c1:视频识别网络为轻量级,采用时间压缩,视频识别网络包括维度转换模块、卷积模块、最大池化模块、四个ctl模块、降采样模块、平均池化模块和全连接模块。

5.根据权利要求4所述的防尾随检测方法,其特征在于,所述步骤c包括子步骤c2:ctl模块包括两个分支:一个分支负责时间重要性的学习,另一个具有时间位置恢复能力的分支能够增强跨时间的对象建模能力。

6.根据权利要求5所述的防尾随检测方法,其特征在于,所述步骤c包括子步骤c3:ctl模块为残差结构,包括1x1卷积、ctl模组和1x1卷积。

7.根据权利要求6所述的防尾随检测方法,其特征在于,所述步骤c包括子步骤c4:ctl模组为双分支结构,ctl模组的输出是两个分支输出特征向量的和。

8.根据权利要求7所述的防尾随检测方法,其特征在于,所述步骤c包括子步骤c5:ctl模组的第一分支是由tfc即时间聚焦卷积构成,tfc引入注意力机制计算每个特征通道的权重,得到有时间重要性的特征向量,ctl模组的第二分支是由ioi跨时间交互构成,ioi还原时间位置动态和时间对象关系。

9.根据权利要求8所述的防尾随检测方法,其特征在于,所述步骤c包括子步骤c6:ioi模块由两个分支构成,一个分支使用tfc将通道数c减少到帧数t,同时捕获时间重要性,注入时间位置编码信息,恢复时间动态,利用7 × 7卷积对t帧之间的对象关系进行建模,使用3 × 3卷积把通道数从t映射到c,使用激活函数得到在时间和位置二维空间上的权重向量,另一分支使用3 × 3卷积输出通道为c的特征图,与权重向量进行对应元素乘法运算,得到有时间位置动态和时间对象关系的特征向量。

10.根据权利要求1所述的防尾随检测方法,其特征在于,所述步骤d包括子步骤d1:在训练模式下,对每个训练视频解析为图像序列,进行打标签动作,标签分为两类:正常和尾随,标签规则为:当视频里没有人或只有一个人时,标注为正常,当视频里人数大于一个人时,标注为尾随。

技术总结本发明公开了一种基于视频识别的防尾随检测方法,包括以下步骤:步骤A:输入视频图像帧序列,采用等间隔的采样策略截取视频图像;步骤B:数据预处理时,将视频图像帧序列转化为视频识别网络所需的输入格式;步骤C:构建一个视频识别网络模型,以供实现模型的精准识别和实时预测;步骤D:定义分类损失函数监督模型训练,模型在训练过程中通过权重参数的迭代逐步达到收敛状态,训练期间,选取验证集中的最优的网络权重参数进行保存,生成视频识别模型;步骤E:在实际推理过程中,直接载入视频识别网络模型权重参数来完成模型的推理过程,把预处理后数据输入视频识别模型进行预测。技术研发人员:赖时伍,聂芸芸,夏炉系,张浒,苗应亮受保护的技术使用者:盛视科技股份有限公司技术研发日:技术公布日:2024/9/29本文地址:https://www.jishuxx.com/zhuanli/20241009/309570.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表