基于隐私保护的联邦学习中毒攻击防御方法

- 国知局

- 2024-10-21 15:10:15

本发明属于网络安全,尤其是涉及一种基于隐私保护的联邦学习中毒攻击防御方法。

背景技术:

1、联邦学习的安全问题一直以来都是业界关注的重点,联邦学习训练过程中,共享的模型参数可能泄露数据持有者的隐私信息。出于隐私考虑,数据持有者和中央服务器之间通常难以达成完全互信,且各参与方可能出现系统错误、掉线以及恶意篡改等导致的数据正确性问题。攻击者可以对模型参数发起成员推理、属性推理以及数据重构等攻击,推测出参与者训练数据中的隐私属性。参与方可能出现计算错误或产生恶意行为,如中毒攻击,导致模型训练过程异常或模型训练结果受损。因此,构建隐私保护联邦学习方案与中毒攻击防御方案是将联邦学习大规模应用的前提。

2、论文shielding collaborative learning:mitigating poisoning attacksthrough client-side detection(l.zhao et al.,ieee transactions on dependableand secure computing,vol.18,no.5,pp.2029-2041,1sept.-oct.2021)提出,可利用差分隐私解决中毒攻击防御方案中的隐私问题。然而,使用差异隐私会降低模型的可用性,并且需要在隐私性和可用性之间找到一个平衡。论文privacy-enhanced federated learningagainst poisoning adversaries(x.liu,h.li,g.xu,z.chen,x.huang and r.lu,ieeetransactions on information forensics and security,vol.16,pp.4574-4588,2021)利用同态加密技术对客户端上传的数据进行安全聚合,然后使用相关系数来评估每个参与者的训练质量,并剔除低质量的梯度信息,来实现在隐私保护的前提下,对中毒攻击进行防御。但该方法的计算较为复杂,且需要可信第三方的参与,实际应用中有很大的难度。因此,需要设计一种联邦学习中毒攻击防御方法,提高联邦学习的安全性,同时减少防御手段的计算开销。

技术实现思路

1、本发明的目的就是为了克服上述现有技术存在的缺陷而提供一种基于隐私保护的联邦学习中毒攻击防御方法,提高联邦学习的安全性,同时减少防御手段的计算开销。

2、本发明的目的可以通过以下技术方案来实现:

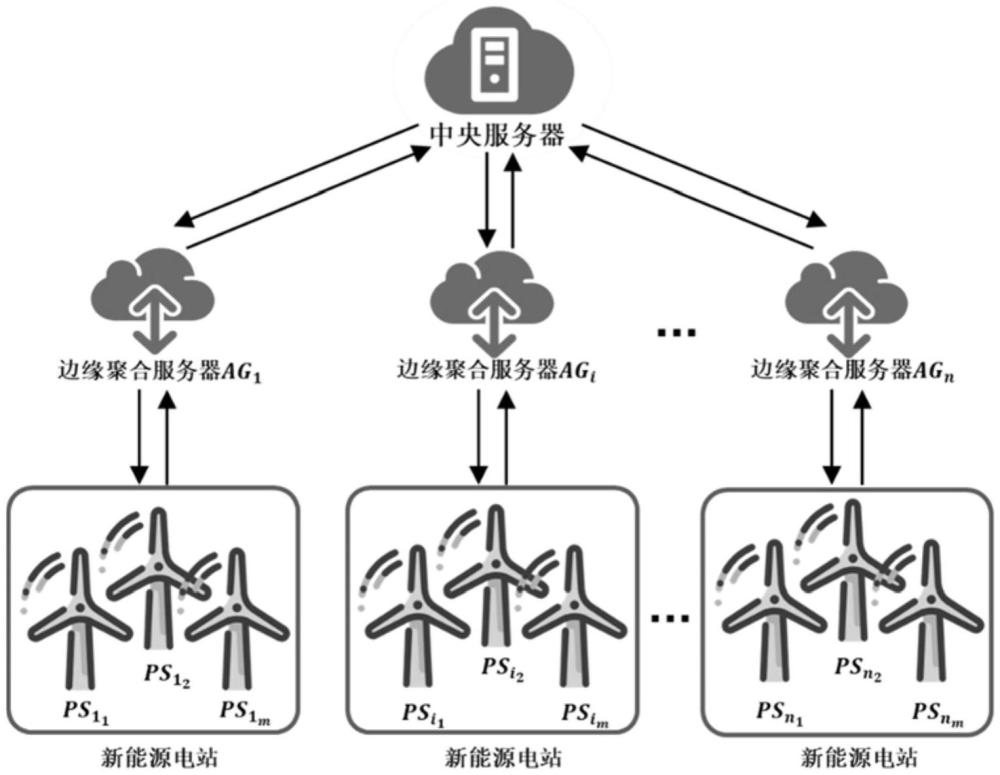

3、本发明提供一种基于隐私保护的联邦学习中毒攻击防御方法,适用于分层聚合架构的联邦学习框架,所述联邦学习框架包括一个云服务器和n个客户端组ag,每个客户端组包含m个客户端ps,每个客户端组通过一个边缘聚合服务器与所述云服务器相连,所述的基于隐私保护的联邦学习中毒攻击防御方法包括如下步骤:

4、所述云服务器初始化全局模型的参数,通过各边缘聚合服务器逐级下发至各客户端;

5、所述云服务器通过各边缘聚合服务器逐级获取并聚合各客户端根据所述云服务器下发的参数对全局模型进行本地训练得到的参数更新,迭代更新全局模型的参数,同时更新各客户端的诚信指标,通过所述诚信指标定位发起中毒攻击的恶意客户端,对恶意客户端采取安全操作;

6、其中,全局模型参数的更新过程中,各参数通过基于paillier同态加密技术设计的聚合方案进行传输,使同态加密聚合操作和解密操作分离;

7、所述诚信指标基于聚合梯度与基础梯度之间的欧氏距离以及本地梯度与基础梯度之间的欧氏距离进行更新,所述聚合梯度基于各客户端的聚合权重和各客户端通过本地训练获得的本地梯度计算,所述聚合权重为被映射为整数的诚信指标,所述基础梯度通过所述云服务器计算。

8、进一步地,具体包括以下步骤:

9、s1、云服务器根据paillier同态加密方案初始化系统参数,paillier同态加密方案包括密钥生成算法、加密算法和解密算法;

10、s2、云服务器接受并验证边缘聚合服务器和客户端的注册信息:第i个边缘聚合服务器agi随机选择作为其私钥,计算yi=xip作为公钥,p为生成元,然后选择一个随机数计算数字签名h1为安全哈希函数,生成注册信息并发送给云服务器,ts为时间戳,收到注册信息后,云服务器检查时间戳ts的有效性,如果有效,则进行验证,若验证通过,边缘聚合服务器agi以公开参数{yi,idi}注册;

11、第i个边缘聚合服务器中的j个客户端随机选择作为其私钥,计算作为其公钥,然后选择随机值计算数字签名生成注册信息并发送给云服务器,收到后,云服务器检查时间戳ts的有效性,如果有效,则进行验证,若验证通过,客户端以公开参数注册;

12、s3、云服务器初始化训练参数,并逐级下发给客户端:云服务器首先为每个客户端初始化诚信指标其中numtotal为所有客户端的总数,然后生成一个数字mt将诚信指标映射为整数,获得聚合权重

13、云服务器生成一个超递增序列a={a1,a2,...,am+1},其中a1=1,a2,a3,…,am+1均为大素数,其中i=2,...,m+1且n=pq,p和q为两个大质数,d为模型参数映射至整数域的上界,d为聚合权重映射至整数域的上界。

14、云服务器计算参数其中j=1,2,…,m+1,并为每个客户端计算参数然后,云服务器将联邦学习全局模型参数wt和加密参数通过边缘聚合服务器发送给相应的客户端

15、s4、云服务器逐级获取并验证客户端根据云服务器下发的训练参数对全局模型进行本地训练得到的参数更新:客户端使用自身本地的数据集训练全局模型并计算本地更新梯度并计算本地训练得到的梯度与云服务器计算的基础梯度之间的欧氏距离然后根据paillier同态加密方案的加密算法对梯度更新和欧氏距离进行加密生成密文并根据密文生成签名客户端生将密文报告并发送到相应的边缘聚合服务器agi;

16、边缘聚合服务器接收到客户端发送的密文报告后,将其中的身份信息形成一个数据集然后对这些数据进行批量验证,如果验证失败,则边缘聚合服务器agi就停止后续操作;如果验证通过,则对加密数据进行同态计算,获得聚合密文;边缘聚合服务器agi随机选择并使用其私钥xi为聚合密文生成数字签名边缘聚合服务器agi生成聚合密文报告并上传至云服务器;

17、收到来自边缘聚合服务器agi的聚合密文报告后,云服务器对聚合密文进行批量验证,如果验证失败,则云服务器对收到的每条聚合密文执行验证,请求重新传输未通过验证的数据;若验证通过,云服务器使用paillier同态加密方案的解密算法对聚合密文进行解密;定义加权梯度通过解密算法恢复加权梯度和欧氏距离

18、s5、云服务器对聚合权重和训练参数进行更新,下发给客户端,开启新一轮的训练:云服务器使用通过解密算法恢复的加权梯度与欧氏距离计算全局模型更新:

19、

20、云服务器计算全局模型参数wt+1=wt+wt+1后,更新这一轮的欧氏距离根据本轮的欧氏距离云服务器更新每个客户端的诚信指标生成参数mt+1,将诚信指标映射为聚合权重云服务器利用聚合权重更新参数云服务器生成一个随机掩码向量rg,更新基础梯度云服务器将更新后的参数下发到各客户端,开始下一轮训练;

21、s6、结束训练后,通过诚信指标定位发起中毒攻击的恶意客户端,对恶意客户端采取安全操作:将所有客户端的诚信指标按升序排序,将诚信指标最小的前k个客户端定位为恶意客户端,然后对其采取安全操作,所述安全操作包括隔离、数据分析和修复。

22、进一步地,步骤s2中,通过双线性配对操作对注册信息进行验证,

23、边缘聚合服务器执行的双线性配对操作为:

24、

25、客户端执行的双线性配对操作为:

26、

27、进一步地,步骤s4中,密文的构造如下:

28、

29、数字签名计算如下:

30、

31、其中,为一随机值。

32、进一步地,步骤s4中,边缘聚合服务器进行的批量验证为使用双线性配对运算对客户端上传的数据进行运算,具体公式如下:

33、

34、进一步地,步骤s4中,聚合密文如下所示:

35、

36、聚合密文的数字签名表示如下:

37、

38、进一步地,步骤s5中,所述诚信指标的更新方法为:

39、

40、其中,为第i个边缘聚合服务器中第j个客户端的诚信指标,为第t轮训练中第i个边缘聚合服务器中第j个客户端的归一化的诚信指标,为受限诚信指标变化量。

41、进一步地,利用sigmoid函数计算所述受限诚信指标变化量

42、

43、其中,为诚信指标变化量,numtotal为所有客户端的数量、numround为总训练轮数。

44、进一步地,所述诚信指标变化量的计算公式为:

45、

46、其中,为第t轮训练中聚合梯度与基础梯度之间的欧氏距离,为第t轮训练中第i个边缘聚合服务器中第j个客户端的本地梯度与基础梯度。

47、进一步地,步骤s6中,根据归一化后的诚信指标定位发起中毒攻击的恶意客户端。

48、与现有技术相比,本发明具有以下有益效果:

49、1、本发明提出了一种基于隐私保护的联邦学习中毒攻击防御方法,适用于分层聚合架构的联邦学习框架,联邦学习框架在训练过程中,本发明设计了一个诚信指标用于定位发起中毒攻击的恶意客户端,诚信指标基于聚合梯度与基础梯度之间的欧氏距离以及本地梯度与基础梯度之间的欧氏距离进行更新,且在诚信指标的更新过程中,各参数通过基于paillier同态加密技术设计的聚合方案进行传输,使同态加密聚合操作和解密操作分离,可以提高联邦学习的安全性,同时减少通信代价和计算代价。

50、2、本发明更新各客户端的诚信指标后进行归一化处理,可以消除舍入误差的影响,提高诚信参与者的权重比例,提高恶意客户端检测结果的准确性。

51、3、本发明中,边缘聚合服务器对客户端、云服务器对边缘聚合服务器上传的数据均先使用双线性配对运算进行批量验证,可以减少验证的计算开销,提高验证效率。

本文地址:https://www.jishuxx.com/zhuanli/20241021/320719.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表