一种知识增强的图像描述方法与装置

- 国知局

- 2024-11-06 14:29:13

本发明涉及图像描述,尤其涉及一种知识增强的图像描述方法与装置。

背景技术:

1、图像描述是一个备受关注的研究领域,其旨在使计算机能够自动理解图像内容并生成自然语言描述,从而实现对图像的语义理解和生成。图像描述任务结合了计算机视觉和自然语言处理两个不同的研究领域,不仅要求模型拥有完备的图像语义理解能力,还要求其具有符合人类感知的自然语言表达能力。该技术已经被用于一些重要的应用场景中,例如帮助残障人士识别周围环境、促进人与计算机之间的交互等。

2、图像描述模型大多基于编码-解码范式。早期的图像描述模型使用基于卷积的预训练的分类网络或目标检测网络提取视觉特征。虽然预训练网络在mscoco(它是一种目标检测数据集)基准上有良好的表现,但在其他数据集上则并非如此。因此,早期的图像描述模型只能局限于相对较小的域内,这限制了模型描述开放世界的能力。最近,受自然语言处理领域的先进工作的启发,vision-language model pre-training(视觉语言模型预训练)和zero-shot prediction(零样本预测)范式获得了关注,clip(采用对比学习的文本-图像预训练模型)使用图像文本对比目标从大规模图像-文本对中学习图像文本的对应关系,并被拓展到了图像描述下游任务中,表现出了强大的描述开放世界的能力。得益于视觉语言预训练,最近先进的图像描述方法不断扩大模型的规模,从而在域外获得更好的性能,提升模型描述开放世界的能力。然而,这些提升是以增加可学习参数量、训练数据量和训练成本为代价的。虽然这些模型可以通过在更大的数据集上进一步训练来扩展以实现跨域迁移,但这一过程是昂贵且费力的。因此,昂贵的训练成本限制了模型描述开放世界的能力。导致这一问题的原因在于模型将学习到的知识储存在自身的权重参数中,因此在不更新权重参数的情况下提升模型在域外数据集的泛化性是困难的。

3、图象描述一直是计算机视觉研究领域的热点之一。早期的图像描述生成方法使用基于检索的方法,从预先定义的语句集中利用相似度匹配的方法检索出一组语句作为该图像的描述语句。

4、随着编码器-解码器框架的广泛流行,许多研究者使用预训练cnn(卷积神经网络)或faster r-cnn作为编码器将图像编码成网格状的特征向量,然后使用带有注意力机制的lstm(长短期记忆网络)作为解码器,通过关注图像的不同部分来预测生成的单词。得益于transformer模型(变换神经网络模型)在自然语言处理和计算机视觉领域的出色表现,研究者们越来越多地基于transformer结构来构建模型,从而在更大规模的数据集上获得更高的收益,这一点在最先进的视觉语言模型(vision-and-language model)上可以明显体现出来。这些模型通常在大规模的图像文本对数据集上进行训练,从而得以学习到通用的模态特征,然后通过全微调操作以适应图像描述等下游任务。

5、视觉语言预训练(vlp)通过在大规模图像-文本对上预训练模型来提高下游视觉和语言任务的性能。其中先进的工作包括oscar、vinvl、blip、flamingo等,它们对大规模vision-language transformer模型进行预训练,然后对预训练模型进行微调以应用于下游任务。这些模型虽然拥有强大的图像描述性能,但他们将所有知识存储在了模型内部,这导致模型需要大量的参数以支撑其泛化到域外的数据上。总的来说,参数规模更大的模型往往拥有更强的泛化能力。其中,blip模型使用图像-文本对比损失进行预训练,通过拉近正样本对在嵌入空间的距离,并推远负图像-文本对的距离来对齐视觉转换器和文本转换器的特征空间,从而构造出强大的视觉编码器和文本编码器。随后针对图像描述生成这一下游任务,通过在coco数据集上简单地进行全微调便得到了很好的效果,并展现出了一定的泛化能力。但可惜的是,这种泛化能力依然有限,往往需要进一步微调才能够适应全新的数据,这是由于模型的知识储备不足导致的。

6、早期基于检索的方法(基于检索增强的图像描述模型)严重依赖于预先定义的语句集,在语句集规模不足时,可能生成与图像无关的描述。基于cnn与lstm的图像描述模型无法充分利用大规模数据集进行预训练,缺乏泛化性。基于vlp的先进模型,如blip等,展现了出色的描述能力和泛化能力,但受到训练截至的影响,模型学到的知识依然有限,通常需要利用新的知识对模型进行扩展以实现对开放世界的描述。但庞大的参数量导致通过微调方法对模型扩展是极其困难的。而最近的检索增强模型,如smallcap、extra等,虽然尝试通过检索额外数据的方式增强模型的泛化性,但这些方法没有充分利用预训练模型的描述能力,并且通用性较低。

技术实现思路

1、本发明的目的是提供一种知识增强的图像描述方法与装置,充分利用了预训练文本编码器的优势,构建了知识编码器,使其能够从外部知识库中获取域外的知识,以提高在域外数据集上的图像描述质量。

2、本发明的目的是通过以下技术方案实现的:

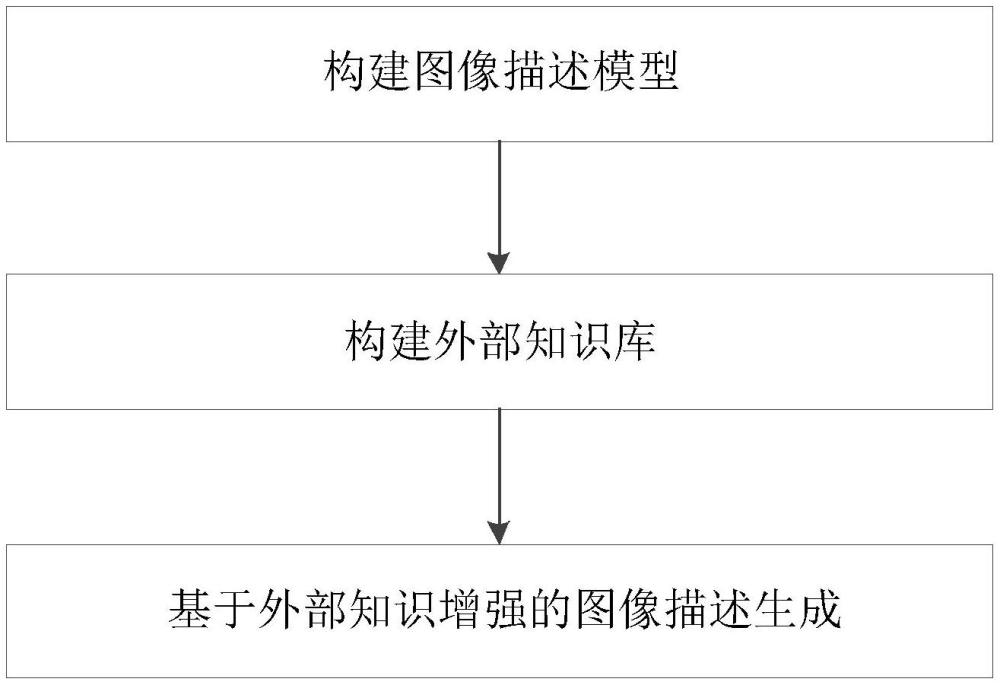

3、一种知识增强的图像描述方法,包括:

4、构建包含图像编码器、知识编码器与文本解码器的图像描述模型;

5、结合所述图像编码器构建外部知识库;

6、将图像输入至所述图像描述模型中,通过图像编码器提取图像特征,并使用所述图像特征在外部知识库中检索出辅助知识序列,通过所述知识编码器对辅助知识序列进行编码,获得文本特征,利用所述文本特征对所述图像特征进行增强,获得外部知识增强的图像特征;通过文本解码器结合所述外部知识增强的图像特征生成图像对应的文本描述。

7、一种知识增强的图像描述装置,包括:

8、模型构建单元,用于构建包含图像编码器、知识编码器与文本解码器的图像描述模型;

9、外部知识库构建单元,用于结合所述图像编码器构建外部知识库;

10、图像描述生成单元,用于将图像输入至所述图像描述模型中,通过图像编码器提取图像特征,并使用所述图像特征在外部知识库中检索出辅助知识序列,通过所述知识编码器对辅助知识序列进行编码,获得文本特征,利用所述文本特征对所述图像特征进行增强,获得外部知识增强的图像特征;通过文本解码器结合所述外部知识增强的图像特征生成图像对应的文本描述。

11、由上述本发明提供的技术方案可以看出,提出一个针对图像描述模型的外部知识增强方法,通过从外部知识库中检索出的辅助知识序列来增强模型在域外数据集上生成描述的质量,可以解决域迁移导致大量训练成本、图像描述任务性能不佳的问题。

技术特征:1.一种知识增强的图像描述方法,其特征在于,包括:

2.根据权利要求1所述的一种知识增强的图像描述方法,其特征在于,还包括:先对图像进行处理,获得嵌入向量序列,再将嵌入向量序列输入至所述图像描述模型中;

3.根据权利要求1所述的一种知识增强的图像描述方法,其特征在于,所述图像编码器包括:多个变换神经网络编码器模块,

4.根据权利要求3所述的一种知识增强的图像描述方法,其特征在于,所述多头自注意力层中并行运行h个自注意力层块,每个自注意力层块将输入x转化至三个不同嵌入空间,获得注意力机制中的qkv,并使用不同的线性变换层进行投影,之后,基于注意力机制获得自注意力层块的输出,将h个自注意力层块的输出拼接后,经过线性层投影,得到头自注意力层的输出,表示为:

5.根据权利要求1所述的一种知识增强的图像描述方法,其特征在于,所述结合所述图像编码器构建外部知识库包括:

6.根据权利要求1或5所述的一种知识增强的图像描述方法,其特征在于,所述使用所述图像特征在外部知识库中检索出辅助知识序列包括:

7.根据权利要求1所述的一种知识增强的图像描述方法,其特征在于,所述文本解码器包括:依次设置的因果自注意力层、交叉注意力层与前馈网络层;

8.根据权利要求1所述的一种知识增强的图像描述方法,其特征在于,该图像描述模型需要预先进行训练,训练时损失函数为:

9.根据权利要求8所述的一种知识增强的图像描述方法,其特征在于,还包括:

10.一种知识增强的图像描述装置,其特征在于,用于实现权利要求1~9任一项所述的方法,该装置包括:

技术总结本发明公开了一种知识增强的图像描述方法与装置,它是针对图像描述模型的外部知识增强方案,方案中充分利用了预训练文本编码器的优势,构建了知识编码器,通过从外部知识库中检索出的辅助知识序列来增强模型在域外数据集上生成描述的质量,可以提高在域外数据集上的图像描述质量,从而解决域迁移导致大量训练成本、图像描述任务性能不佳的问题。技术研发人员:曹丹阳,周宏博,林子峰,王涌赋受保护的技术使用者:北方工业大学技术研发日:技术公布日:2024/11/4本文地址:https://www.jishuxx.com/zhuanli/20241106/322359.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表