一种事件隐式关系抽取方法

- 国知局

- 2024-11-18 18:15:34

本发明属于自然语言处理领域,涉及一种融合图卷积网络和长短记忆网络的事件隐式关系抽取方法。

背景技术:

1、事件关系抽取为自然语言处理领域的重要任务,这一任务旨在从文本中识别和提取事件间的逻辑关系,主要包括但不限于因果、顺承等关系类型。通过准确抽取这些关系,为深入理解事件的发展脉络和相互作用提供支持。在识别文本中的事件实体之后,需要确定这些事件实体之间的逻辑关系。这要求模型不仅需要对文本进行深入的语义分析,还需要能够理解和推断事件之间的隐含逻辑联系。

2、为了提高关系抽取的准确性,近年来的研究工作越来越多地采用了深度学习技术,特别是自然语言处理(nlp)领域的最新进展,如预训练语言模型(例如bert、ernie等)和图神经网络。这些技术能够有效地捕捉文本中的复杂语义信息,并在更广泛的上下文中理解事件之间的关系,从而在关系抽取任务中取得了显著的性能提升。此外,一些研究还尝试融合额外的知识信息,如利用外部知识库或采用知识增强的方法来丰富事件表示,增强模型对复杂事件关系的识别能力。该方法通过引入外部知识,为模型提供了更为丰富和精确的语义信息,有助于提升关系抽取的准确率和鲁棒性。

3、隐式关系由于缺少明显的因果关系提示词,所以传统关系抽取方法难以应对隐式事件关系缺乏明显提示词和中文句法变体多样性的情况。本模型采用采用bilstm+gcn+attention模型进行隐式关系抽取:使用双向长短期记忆网络(bilstm)和图卷积网络(gcn)进行联合特征抽取,并采用注意力机制进一步增强模型对关键信息的关注能力。其中,bilstm负责捕获文本序列中的上下文信息,在此基础上利用gcn构建事件元素之间的图表示,充分利用图结构信息捕获词汇级语义信息,理解词汇之间的复杂关系,从文本中抽取出事件之间的复杂关系,为构建准确的事理图谱奠定基础。

技术实现思路

1、本发明将事件关系抽取视为分类任务,以事件抽取模型输出的结构化事件作为输入,采用bilstm+gcn+attention模型进行隐式关系抽取:使用双向长短期记忆网络(bilstm)和图卷积网络(gcn)进行联合特征抽取,并采用注意力机制进一步增强模型对关键信息的关注能力。其中,bilstm负责捕获文本序列中的上下文信息,在此基础上利用gcn构建事件元素之间的图表示,充分利用图结构信息捕获词汇级语义信息,理解词汇之间的复杂关系,从文本中抽取出事件之间的复杂关系

2、一种事件隐式关系抽取的方法,包括:

3、embedding层,将文本转换为上下文语义表示向量;

4、特征提取层,分别获得bilstm和gcn的特征向量;

5、attention层,自动识别并标记关键词汇;

6、softmax,进行分类并输出结果。

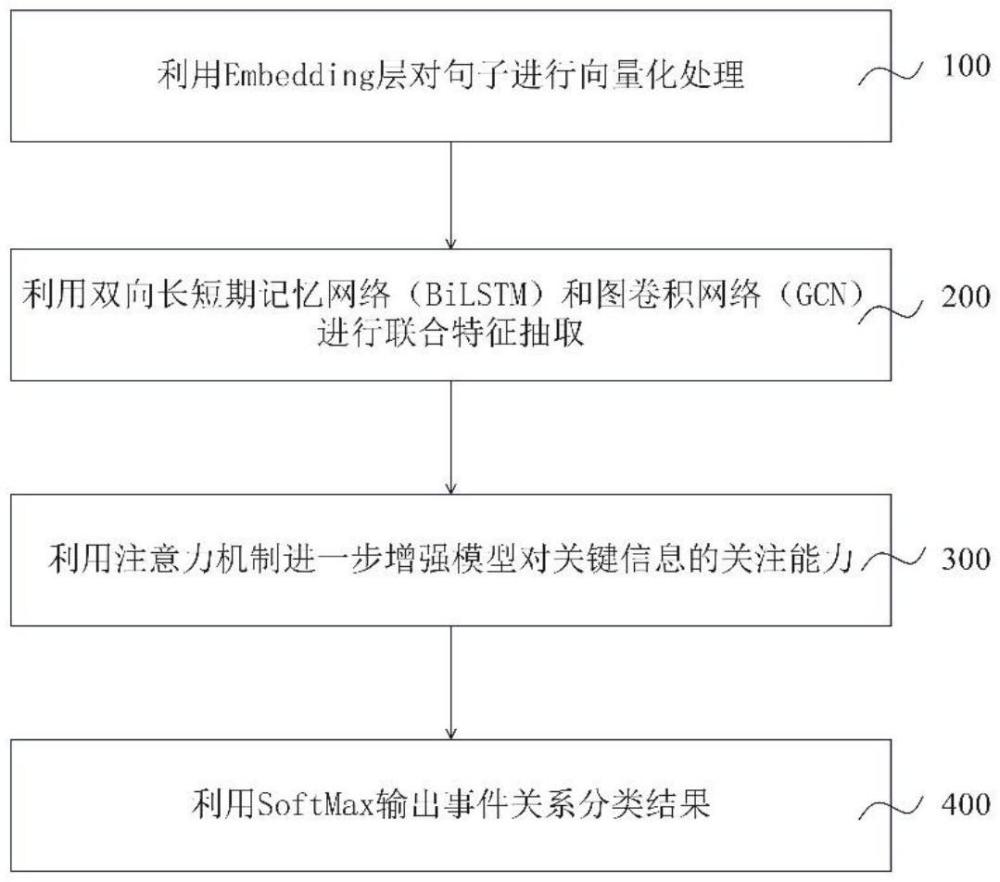

7、一种事件隐式关系抽取的方法,包括如下步骤:

8、步骤100,利用embedding层对句子进行向量化处理;

9、步骤200,利用双向长短期记忆网络(bilstm)和图卷积网络(gcn)进行联合特征抽取;

10、步骤300,注意力机制进一步增强模型对关键信息的关注能力;

11、步骤400,利用softmax输出事件关系分类结果。

12、在一些实施方式中,所述步骤100包括如下子步骤:

13、步骤110,利用ernie预训练模型对数据进行处理,将事件对<ei,ej>转化为一个包含t个词汇的序列s={x1,x2,…,xt}构成的句子。

14、步骤120,通过多头自注意力模块,获得s的上下文语义表示t=[t1,t2,t3…,tn]

15、在一些实施方式中,所述步骤200包括如下子步骤:

16、步骤210,双向bilstm期记忆网络中包含着两个传播方向相反的网络,t时刻的输出由t时刻的输入tt、前向传播的和后向传播的共同决定,t=0时,t0为上层输出t。

17、

18、hb=lstm(t)

19、步骤220,在特征提取的过程中,进一步采用了gcn。该网络的核心操作在于卷积,它针对图结构数据中的特定范围节点进行加权求平均。具体而言,将每个节点的邻居节点特征进行加权平均,以得到该节点的聚合特征值。通过这种方式,gcn能够有效捕获图结构中节点间的相互关系,并提取出更为丰富和具有表现力的特征信息。这一步骤对于后续的分析和模型性能的提升具有关键作用,然后将该节点的特征值传播到下一层作为输入,计算更新橙色节点时,只需要橙色周边相邻的两个节点的信息。l为卷积层数,w为权重,cij为节点i和节点j的连接信息,ni为相邻节点,σ为激活函数。求和的前半部分为上一层该节点的特征值,后半部分为相邻节点的聚合特征值,其中当l=0时,

20、

21、步骤230,输入样本句子对应的矩阵,经过隐层聚合特征,最后得到输出结果。式中l代表层数,w代表权重矩阵,σ代表激活函数,gcn与bilstm融合,获得的联合特征。

22、hl+1=σ(ahlwl)

23、hg=gcn(t)

24、

25、在一些实施方式中,所述步骤300包括如下子步骤:

26、步骤310,采用attention机制来自动识别并学习这些语料中对演化关系分类具有影响的关键部分。此过程涉及对相关重要词汇的识别和标注,以促进演化关系抽取任务的执行。句子的表示形式r是通过计算输出向量的加权和来构成的。

27、m=tanh(h)

28、α=softmax(wtm)

29、r=hαt

30、步骤320,w是经过训练的参数向量,wt是转置,r为句子的向量表示,维度为dw。是lstm-gcn层产生的输出向量,t是句子长度,dw是单词向量的维数。

31、h*=tanh(r)

32、在一些实施方式中,所述步骤400包括如下子步骤:

33、步骤410,过迭代优化,softmax分类器的attention层参数完成了对句子中触发词的识别学习。这一过程最终迭代出用于事件演化关系抽取的最优参数,从而提高了关系抽取的效果。

34、p(y|s)=softmax(wsh*+bs)

35、步骤420,softmax分类器通过利用其隐藏状态作为输入h*,从句子s的一组离散类别y中预测代表候选事件因果关系对<ei,ej>的分类标签以实现关系的准确分类。

36、

技术特征:1.一种事件隐式关系抽取方法,其特征在于,所述方法包括:

2.根据权利要求1所述的一种事件隐式关系抽取方法,其特征在于,利用embedding层对句子进行向量化处理,包括如下步骤:

3.根据权利要求1或2所述的一种事件隐式关系抽取方法,其特征在于,利用双向长短期记忆网络(bilstm)和图卷积网络(gcn)进行联合特征抽取,步骤包括:

4.根据权利要求1~3的任一项所述的一种事件隐式关系抽取方法,其特征在于,注意力机制进一步增强模型对关键信息的关注能力,步骤如下:

5.根据权利要求1~4任一项所述的一种事件隐式关系抽取方法,其特征在于,利用softmax输出事件关系分类结果,步骤包括:

技术总结本发明公开了一种事件隐式关系抽取方法,来进行因果关系分类和回归识别。该模型结合双向长短记忆网络和图卷积网络进行融合特征提取,并将中心触发词的距离信息整合到语义特征中,以丰富语义特征的提取。实验表明,本文所提出的模型在隐式关系抽取任务中的表现性能更佳。包括:Embedding层将文本转换为上下文语义表示向量;特征提取层使用双向长短期记忆网络(BiLSTM)和图卷积网络(GCN)进行联合特征抽取,BiLSTM负责捕获文本序列中的上下文信息,在此基础上利用GCN构建事件元素之间的图表示,充分利用图结构信息捕获词汇级语义信息,理解词汇之间的复杂关系;Attenton层采用注意力机制进一步增强模型对关键信息的关注能力,从文本中抽取出事件之间的复杂关系,Softmax输出层使用Softmax模型进行分类并输出结果。技术研发人员:李钝,叶亚文,汪晨阳,葛伟力,马立远受保护的技术使用者:郑州大学技术研发日:技术公布日:2024/11/14本文地址:https://www.jishuxx.com/zhuanli/20241118/327842.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。