基于多智能体强化学习的多交通信号灯控制方法及系统

- 国知局

- 2024-11-21 12:05:09

本发明涉及交叉口信号灯相位控制,具体而言,涉及一种基于多智能体强化学习的多交通信号灯控制方法及系统。

背景技术:

1、随着城市的快速发展和交通需求的日益增长,交通供求之间的矛盾愈加突出,交通拥堵问题成为目前的研究热点之一。交通拥堵不仅影响了城市生活的效率和质量,还会带来环境污染、能源紧张等一系列经济社会问题。因此,治理交通拥堵、优化现代城市路网组织和管控,对推进经济社会发展有着积极的意义。

2、多交叉口的信号灯控制具有一定的复杂性,需要注意多个路口之间的协调控制。在多交叉口的信号灯控制中,完全孤立的多智能体控制面临着移动目标学习和唯一均衡对策的难题,系统无法收敛到均衡的联合策略,因此智能体之间的协调控制策略很重要。智能体的协作方式主要体现在智能体通信机制和智能体的学习目标函数上,目前多交叉口信号灯控制算法在通信机制上无法捕捉相邻交叉口之间的动态车流特征,并且相邻信号灯之间的影响关系也无法准确计算,最终会导致各信号灯的协调控制效果较差。

3、有鉴于此,申请人在研究了现有的技术后特提出本技术。

技术实现思路

1、本发明旨在提供一种基于多智能体强化学习的多交通信号灯控制方法及系统,以解决现有多交叉口信号灯控制算法在通信机制上无法捕捉相邻交叉口之间的动态车流特征,并且相邻信号灯之间的影响关系也无法准确计算,导致各信号灯的协调控制效果较差的问题。

2、为解决上述技术问题,本发明通过以下技术方案实现:

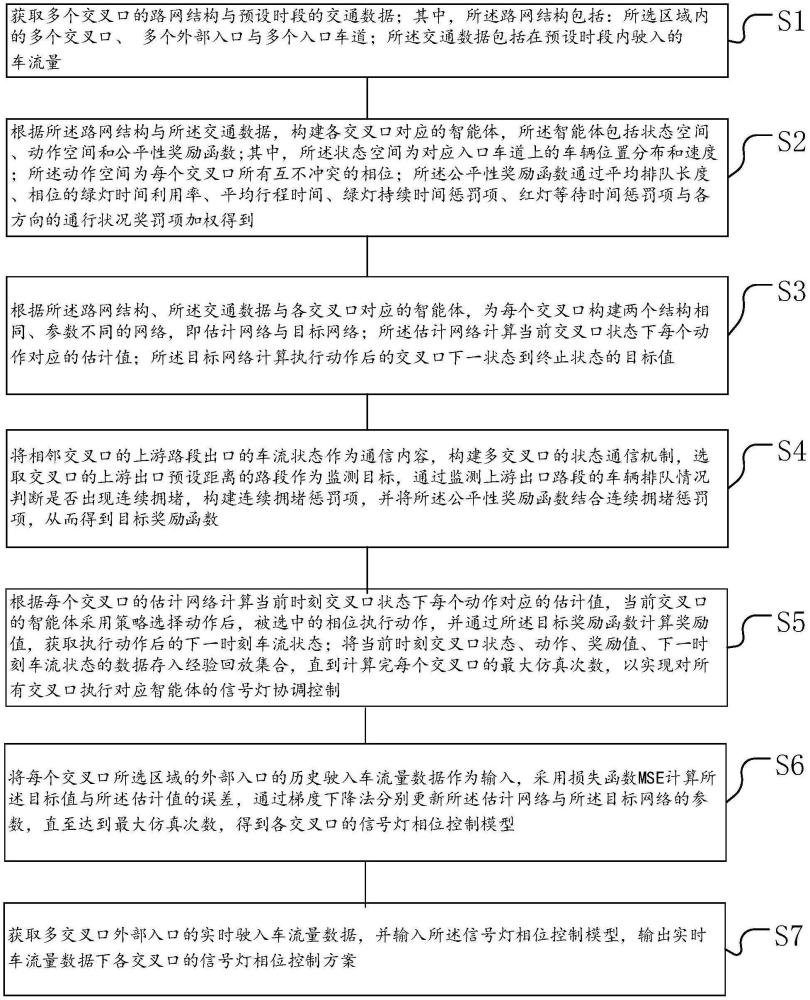

3、一种基于多智能体强化学习的多交通信号灯控制方法,包括:

4、s1,获取多个交叉口的路网结构与预设时段的交通数据;其中,所述路网结构包括:所选区域内的多个交叉口、多个外部入口与多个入口车道;所述交通数据包括在预设时段内驶入的车流量;

5、s2,根据所述路网结构与所述交通数据,构建各交叉口对应的智能体,所述智能体包括状态空间、动作空间和公平性奖励函数;其中,所述状态空间为对应入口车道上的车辆位置分布和速度;所述动作空间为每个交叉口所有互不冲突的相位;所述公平性奖励函数通过平均排队长度、相位的绿灯时间利用率、平均行程时间、绿灯持续时间惩罚项、红灯等待时间惩罚项与各方向的通行状况奖罚项加权得到;

6、s3,根据所述路网结构、所述交通数据与各交叉口对应的智能体,为每个交叉口构建两个结构相同、参数不同的网络,即估计网络与目标网络;所述估计网络计算当前交叉口状态下每个动作对应的估计q值;所述目标网络计算执行动作后的交叉口下一状态到终止状态的目标值;

7、s4,将相邻交叉口的上游路段出口的车流状态作为通信内容,构建多交叉口的状态通信机制,选取交叉口的上游出口预设距离的路段作为监测目标,通过监测上游出口路段的车辆排队情况判断是否出现连续拥堵,构建连续拥堵惩罚项,并将所述公平性奖励函数结合连续拥堵惩罚项,从而得到目标奖励函数;

8、s5,根据每个交叉口的估计网络计算当前时刻交叉口状态下每个动作对应的估计q值,当前交叉口的智能体采用ε-greedy策略选择动作后,被选中的相位执行动作,并通过所述目标奖励函数计算奖励值,获取执行动作后的下一时刻车流状态;将当前时刻交叉口状态、动作、奖励值、下一时刻车流状态的数据存入经验回放集合,直到计算完每个交叉口的最大仿真次数,以实现对所有交叉口执行对应智能体的信号灯协调控制;

9、s6,将每个交叉口所选区域的外部入口的历史驶入车流量数据作为输入,采用损失函数mse计算所述目标值与所述估计q值的误差,通过梯度下降法分别更新所述估计网络与所述目标网络的参数,直至达到最大仿真次数,得到各交叉口的信号灯相位控制模型;

10、s7,获取多交叉口外部入口的实时驶入车流量数据,并输入所述信号灯相位控制模型,输出实时车流量数据下各交叉口的信号灯相位控制方案。

11、本发明还提供了一种基于多智能体强化学习的多交通信号灯控制系统,包括:

12、多交叉口数据获取单元,用于获取多个交叉口的路网结构与预设时段的交通数据;其中,所述路网结构包括:所选区域内的多个交叉口、多个外部入口与多个入口车道;所述交通数据包括在预设时段内驶入的车流量;

13、多智能体构建单元,用于构建智能体,根据所述路网结构与所述交通数据,构建各交叉口对应的智能体,所述智能体包括状态空间、动作空间和公平性奖励函数;其中,所述状态空间为对应入口车道上的车辆位置分布和速度;所述动作空间为每个交叉口所有互不冲突的相位;所述公平性奖励函数通过平均排队长度、相位的绿灯时间利用率、平均行程时间、绿灯持续时间惩罚项、红灯等待时间惩罚项与各方向的通行状况奖罚项加权得到;

14、算法网络构建单元,用于根据所述路网结构、所述交通数据与各交叉口对应的智能体,为每个交叉口构建两个结构相同、参数不同的网络,即估计网络与目标网络;所述估计网络计算当前交叉口状态下每个动作对应的估计q值;所述目标网络计算执行动作后的交叉口下一状态到终止状态的目标值;

15、目标奖励函数构建单元,用于将相邻交叉口的上游路段出口的车流状态作为通信内容,构建多交叉口的状态通信机制,选取交叉口的上游出口预设距离的路段作为监测目标,通过监测上游出口路段的车辆排队情况判断是否出现连续拥堵,构建连续拥堵惩罚项,并根据所述公平性奖励函数结合连续拥堵惩罚项,从而得到目标奖励函数;

16、多交叉口协调控制单元,用于根据每个交叉口的估计网络计算当前时刻交叉口状态下每个动作对应的估计q值,当前交叉口的智能体采用策略选择动作后,被选中的相位执行动作,并通过所述目标奖励函数计算奖励值,获取执行动作后的下一时刻车流状态;并将当前时刻交叉口状态、动作、奖励值、下一时刻车流状态的数据存入经验回放集合,直到计算完每个交叉口的最大仿真次数,以实现对所有交叉口执行对应智能体的信号灯协调控制;

17、模型训练更新单元,用于将每个交叉口所选区域的外部入口的历史驶入车流量数据作为输入,采用损失函数mse计算所述目标值与所述估计q值的误差,通过梯度下降法分别更新所述估计网络与所述目标网络的参数,直至达到最大仿真次数,得到各交叉口的信号灯相位控制模型;

18、输出单元,用于获取多交叉口外部入口的实时驶入车流量数据,并输入所述信号灯相位控制模型,输出实时车流量数据下各交叉口的信号灯相位控制方案。

19、本发明还提供了一种基于多智能体强化学习的多交通信号灯控制设备,包括处理器以及存储器,所述存储器内存储有计算机程序,所述计算机程序能够被所述处理器执行,以实现如上所述的一种基于多智能体强化学习的多交通信号灯控制方法。

20、本发明还提供了一种计算机可读存储介质,所述计算机可读存储介质上存储有计算机可读指令,所述计算机可读指令被计算机可读存储介质所在设备的处理器执行时实现如上所述的一种基于多智能体强化学习的多交通信号灯控制方法。

21、综上所述,与现有技术相比,本发明具有如下有益效果:

22、本发明针对多个信号灯之间的关系提取车流影响因素,为多个交叉口构建相应的智能体结构,建立智能体之间的状态通信机制,捕捉相邻交叉口之间的动态车流特征。然后,结合各交叉口的局部通行效率和区域的整体通行效率,并基于各交叉口信号灯协调控制的公平性奖励机制来构建多信号灯协调控制的目标奖励函数,得到多交叉口信号灯协调控制模型。训练后的模型可用于工况下的实时交通数据,对治理交通拥堵、优化现代城市路网组织和管控,推进经济社会发展有着积极的意义。

23、此外,本发明在公平性奖励函数的基础上,额外考虑通过区域的车辆数与连续拥堵影响因素,构建目标奖励函数,以避免受相邻信号灯控制的影响,出现错误决策。例如,当下游信号灯不能及时将上游流入的车流量释放时,会使上游出口路段出现堆积车辆,进而造成上下游交叉口连续拥堵,本发明给出惩罚项,避免下一次智能体的错误决策,实现多交叉口信号灯协调控制。

本文地址:https://www.jishuxx.com/zhuanli/20241120/334208.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。