一种通过文字驱动的AIGC视频生成方法及装置与流程

- 国知局

- 2025-01-10 13:25:49

本发明涉及人工智能,尤其涉及一种通过文字驱动的aigc视频生成方法及装置。

背景技术:

1、近年来,随着深度学习技术的发展,通过语音驱动三维数字人的脸部,生成说话视频的技术得到了迅速发展,并且已经在多个领域得到了应用。该说话视频为aigc(artificial intelligence generated content,人工智能生成内容)视频。现有的数字人说话视频通常以驱动语音音频作为输入,这增加了数字人说话视频的成本。并且,通过驱动语音作为输入的数字人说话视频需要对语音音频进行识别。在识别语音音频的过程中,由于背景噪音、口音差异或快速说话等因素,对语音音频产生识别错误。这样导致数字人说话视频的生成速度较慢、生成效果较差的问题。

技术实现思路

1、本申请实施例通过提供一种通过文字驱动的aigc视频生成方法及装置,解决了现有技术中数字人说话视频的生成速度较慢、生成效果较差的技术问题,实现了以驱动文字作为输入,使得数字人说话视频的生成速度较快,还能通过文字挖掘出语义信息,使得数字人说话视频生成效果优异,数字人物逼真,数字人表情自然,提高用户使用体验度等技术效果。

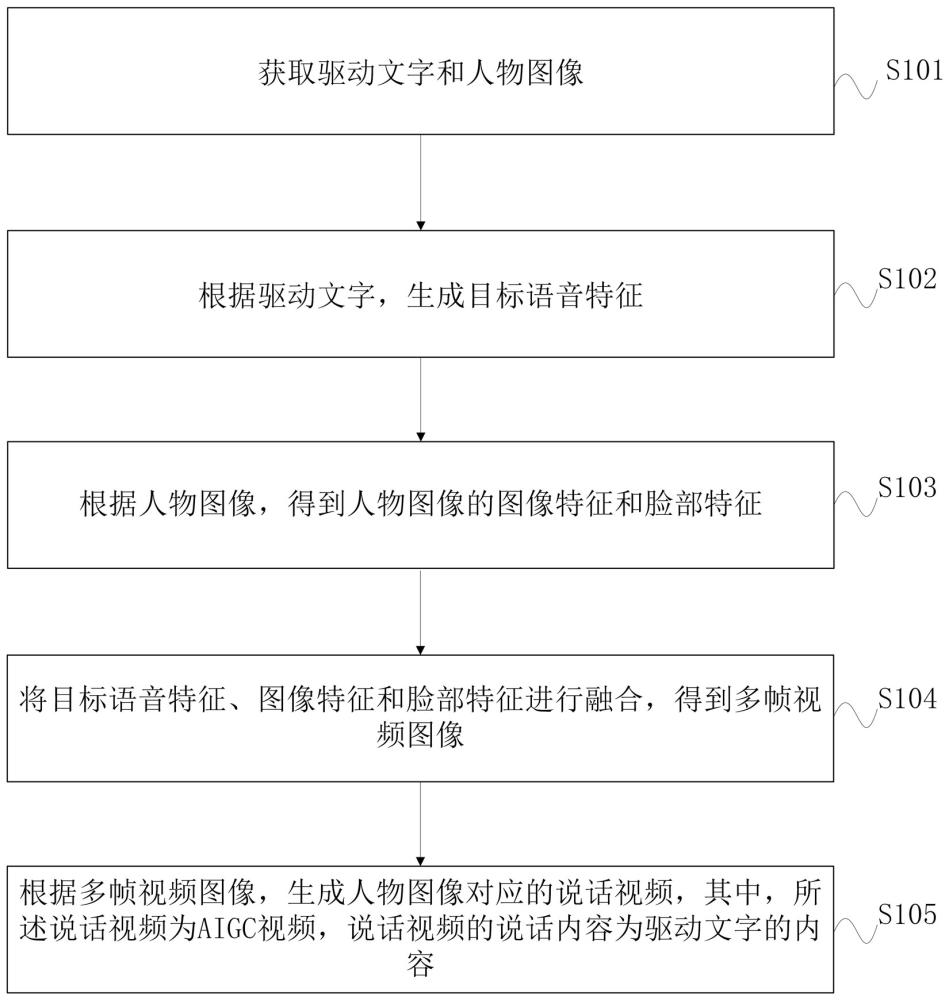

2、第一方面,本发明实施例提供一种通过文字驱动的aigc视频生成方法,包括:获取驱动文字和人物图像;

3、根据所述驱动文字,生成目标语音特征;

4、根据所述人物图像,得到所述人物图像的图像特征和脸部特征;

5、将所述目标语音特征、所述图像特征和所述脸部特征进行融合,得到多帧视频图像;

6、根据多帧所述视频图像,生成所述人物图像对应的说话视频,其中,所述说话视频为aigc视频,所述说话视频的说话内容为所述驱动文字的内容。

7、优选的,所述根据所述驱动文字,生成目标语音特征,包括:

8、根据所述驱动文字,得到所述驱动文字对应的语音和文字特征;

9、根据所述语音,得到语音特征,其中,所述语音特征为包含语义特征的特征向量;

10、根据所述语音特征和所述文字特征,得到所述目标语音特征。

11、优选的,所述根据所述语音特征和所述文字特征,得到所述目标语音特征,包括:

12、通过lstm网络,从所述语音特征中提取出音频特征,以及通过文本提取器,从所述文字特征中提取出文本特征;

13、通过方差适配器,将所述音频特征和所述文本特征进行残差连接,得到潜在属性特征;

14、通过编码器,将所述潜在属性特征与所述语音特征进行拼接,得到所述目标语音特征。

15、优选的,根据所述驱动文字,得到所述文字特征,包括:

16、通过clip编码器对所述驱动文字进行编码,得到所述文字特征。

17、优选的,所述根据所述语音,得到语音特征,包括:

18、通过卷积网络,将所述语音映射到隐空间,得到所述隐空间中的所述语音的隐特征;

19、通过transformer网络,将所述隐特征进行编码,得到所述语音特征。

20、优选的,所述将所述目标语音特征、所述图像特征和所述脸部特征进行融合,得到多帧视频图像,包括:

21、通过扩散模型,对所述目标语音特征、所述图像特征和所述脸部特征进行融合,直到达到运动估计矩阵的姿态约束条件,得到一帧所述视频图像,进而得到多帧所述视频图像。

22、优选的,所述运动估计矩阵为:

23、m = mt,t,e[||e - et(gt,t,c)||2];

24、其中,m为运动估计矩阵,t为时间步长,c为所述语音特征,e为多层感知机,gt为高斯噪声,mt为在t时间步长下的运动空间矩阵,et为多层感知线性运算。

25、优选的,所述运动估计矩阵的姿态约束条件为通过所述运动估计矩阵得到目标特征的目标姿态,且所述目标特征从当前姿态调整至所述目标姿态的条件,其中,所述目标特征为所述图像特征的指定特征和/或所述脸部特征的指定特征。

26、优选的,根据多帧所述视频图像,生成所述人物图像对应的说话视频,包括:

27、通过人脸修复模型,对多帧所述视频图像进行修复,得到多帧修复后的视频图像;

28、将多帧所述修复后的视频图像按序进行视频编码,得到所述说话视频。

29、基于同一发明构思,第二方面,本发明还提供一种通过文字驱动的aigc视频生成装置,包括:存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现第一方面的通过文字驱动的aigc视频生成方法的步骤。

30、本发明实施例中的一个或多个技术方案,至少具有如下技术效果或优点:

31、在本发明实施例中,在获取驱动文字和人物图像之后,根据驱动文字得到目标语音特征,并根据人物图像得到图像特征和脸部特征。这里,以驱动文字作为数字人说话视频的输入,大大降低说话视频的生成成本,提高生成效率和生成速度。并且,通过驱动文字得到的目标语音特征具有高层语义信息,便于说话视频生成效果逼真。

32、再将目标语音特征、图像特征和脸部特征进行融合,得到多帧视频图像。这里,将目标语音特征与图像特征和脸部特征进行嵌入融合,逐帧生成视频图像。基于具有语音信息的目标语音特征,使得视频图像中的数字人逼真,数字人的说话表情和口型自然,进而使得视频图像能反映出说话时的情绪,还能制定个性化地视频图像和说话视频。然后,根据多帧视频图像,生成人物图像对应的说话视频。如此,使得说话视频生成效率高、生成效果优异,增强用户体验度。

技术特征:1.一种通过文字驱动的aigc视频生成方法,其特征在于,包括:

2.如权利要求1所述的方法,其特征在于,所述根据所述驱动文字,生成目标语音特征,包括:

3.如权利要求2所述的方法,其特征在于,所述根据所述语音特征和所述文字特征,得到所述目标语音特征,包括:

4.如权利要求2所述的方法,其特征在于,根据所述驱动文字,得到所述文字特征,包括:

5.如权利要求2所述的方法,其特征在于,所述根据所述语音,得到语音特征,包括:

6.如权利要求1所述的方法,其特征在于,所述将所述目标语音特征、所述图像特征和所述脸部特征进行融合,得到多帧视频图像,包括:

7.如权利要求6所述的方法,其特征在于,所述运动估计矩阵为:

8.如权利要求6所述的方法,其特征在于,所述运动估计矩阵的姿态约束条件为通过所述运动估计矩阵得到目标特征的目标姿态,且所述目标特征从当前姿态调整至所述目标姿态的条件,其中,所述目标特征为所述图像特征的指定特征和/或所述脸部特征的指定特征。

9.如权利要求1所述的方法,其特征在于,根据多帧所述视频图像,生成所述人物图像对应的说话视频,包括:

10.一种通过文字驱动的aigc视频生成装置,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,其特征在于,所述处理器执行所述程序时实现如权利要求1-9中任一权利要求所述的通过文字驱动的aigc视频生成方法步骤。

技术总结本发明涉及人工智能技术领域,尤其涉及一种通过文字驱动的AIGC视频生成方法,该方法包括:获取驱动文字和人物图像;根据所述驱动文字,生成目标语音特征;根据所述人物图像,得到所述人物图像的图像特征和脸部特征;将所述目标语音特征、所述图像特征和所述脸部特征进行融合,得到多帧视频图像;根据多帧所述视频图像,生成所述人物图像对应的说话视频,其中,所述说话视频为AIGC视频,所述说话视频的说话内容为所述驱动文字的内容。该方法以驱动文字作为输入,使得数字人说话视频的生成速度较快,还能通过文字挖掘出语义信息,使得数字人说话视频生成效果优异,数字人物逼真,数字人表情自然,提高用户使用体验度。技术研发人员:杨恒,龙涛,李娟,吴永杰,韦健文受保护的技术使用者:深圳爱莫科技有限公司技术研发日:技术公布日:2025/1/6本文地址:https://www.jishuxx.com/zhuanli/20250110/353088.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表