基于Transformer自回归模型的音乐舞蹈MV生成系统及方法

- 国知局

- 2024-06-21 11:55:52

本发明涉及艺术领域,特别涉及一种基于transformer自回归模型的音乐舞蹈mv生成系统及方法。

背景技术:

1、近年来,随着生成对抗网络(gan)的诞生和机器学习相关算法的在图形生成越来越成熟,人工智能艺术(ai-art)得到了长足的发展,在艺术相关领域(绘画、视频、音乐)都取得了丰富的研究成果和应用案例。概况起来,ai-art从单一的艺术内容生成逐渐转移到艺术表现的致敬与重构,即将ai、算法作为媒介,再转化为艺术语言对当下生活经验的表现,强调戏剧化张力与诗意化表现的有机结合。

2、聚焦到ai-music领域,现有的音乐生成技术包括melody rnn、seqgans、musictransformer、midinet、ssmgan、musegan等。其中基于gan的音乐生成成为当前的主流技术,实现从音乐数据集中自动学习音乐风格、结构等,再从估计的分布中生成音乐样本。

3、文本到图像合成的最新进展主要集中在生成对抗网络(gans)、自回归模型和扩散模型。像stackgan,attngan,mirrorgan和mxc-gan这样的gan在生成器和鉴别器之间进行对抗性训练,以学习生成高质量的图像。dall·e、make-a-scene和parti等大型自回归模型可以很容易地按比例扩展,并显示出出色的图像合成能力。但这些模型都只是专注于单幅图像的生成,没有考虑文本上下文的影响,造成生成的图像序列没有连续性。

4、通过对大规模运动捕捉数据集的训练来探索神经网络生成三维运动的适用性,其中网络结构如cnns、gans、rbms、rnns和transformer。而这些工作主要集中在探索不同的神经架构,忽略了舞蹈动作合成中的冻结动作问题。

5、而新方法dance revolution将音乐条件下的舞蹈生成形式化为一个序列到序列的学习问题,其中音乐和舞蹈之间的细粒度对应关系通过序列建模来表示,它们的对齐是通过从音乐的声学特征序列到舞蹈的动作序列的映射来建立。并设计了一个新颖的sequence-to-sequence架构来有效地处理长序列的音乐特征,并捕捉音乐和舞蹈之间的细微对应关系。

6、全注意跨模式转换器fact模型通过全局翻译产生更真实的长三维人体运动。该网络可以从音乐中稳健地生成逼真的3d舞蹈动作,同时还有一个大规模的多模式3d舞蹈动作数据集aist++来训练这样一个模型。该模型有效地学习了音乐-动作的相关性,并能生成舞蹈动作。这个模型被训练来预测n个未来的运动序列,并在测试时以自动回归的方式应用来产生连续运动。

7、还有一种有两个阶段的编舞框架的方法:在第一阶段,利用量化自编码器(vq-vae)将舞蹈动作数据中有意义的舞蹈成分编码和量化到一个名为“舞蹈记忆”的编码本中;第二阶段,利用生成预训练transformer(gpt)将音乐转换为视觉上令人满意的舞蹈。此外,模型进一步通过引入评论家网络给生成的舞蹈打分,以指导gpt编排出与背景音乐节奏更加吻合的舞蹈动作。

8、通过分析现有的歌词生成音乐(lyrics-to-midi)的相关方法,大部分方法都没有涉及到歌词对应的场景图像的生成,即能否通过歌词生成一段符合歌词语义的视频mv,同时也没有生成带场景图像的舞蹈动作的方法。

9、基于此,本发明想从音乐歌曲中提取歌曲的歌词和旋律,根据歌词生成与歌词语义一致的场景图像,通过音乐旋律生成相应的舞蹈动作,然后把舞蹈动作和场景图像按照音乐片段进行融合,最终生成一段音乐舞蹈视频,并将此方法应用音乐文化的传播中。

技术实现思路

1、本发明提供了一种基于transformer自回归模型的音乐舞蹈mv生成系统及方法,能够从音乐中提取歌曲的歌词和旋律,根据歌词生成与歌词语义一致的场景图像,通过音乐旋律生成相应的舞蹈动作,然后把舞蹈动作和场景图像按照音乐片段进行融合,最终生成一段与歌曲的主题和情感相匹配的音乐舞蹈mv。

2、为了解决上述技术问题,本技术提供如下技术方案:

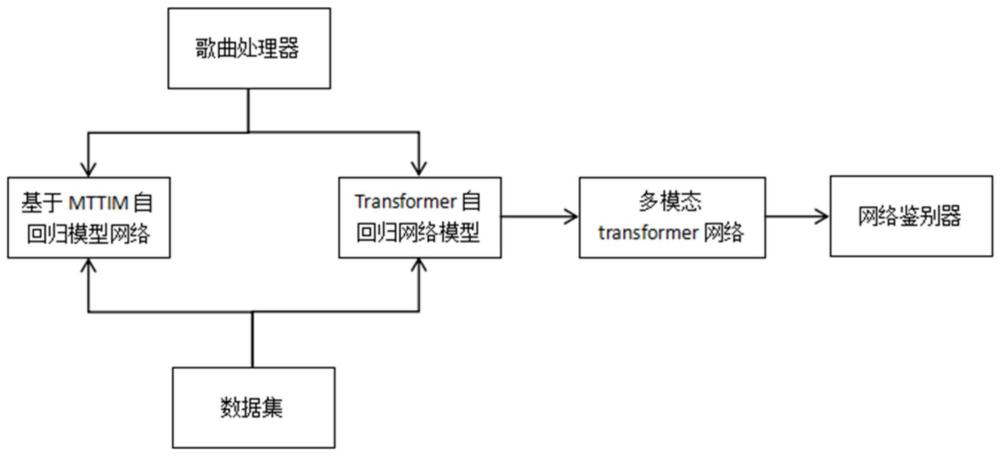

3、一种基于transformer自回归模型的音乐舞蹈mv生成系统,包括歌曲处理器、数据集、基于mttim的自回归模型网络、基于transformer的自回归模型网络、多模态transformer网络以及网络鉴别器;

4、所述歌曲处理器用于将歌曲分离成歌词和歌曲旋律;

5、所述数据集包括训练数据集、验证数据集和测试数据集;其中训练数据集包含图片和数据标签两部分,是深度学习模型进行有监督学习的基础;

6、所述基于mttim的自回归模型网络用于接收歌词并将歌词按语句提取歌词特征序列,生成与歌词相匹配的场景图像;

7、所述基于transformer的自回归模型网络用于接收歌曲旋律,并生成与该歌曲旋律相对应的舞蹈动作特征;

8、所述多模态transformer网络用于将生成的场景图像和舞蹈动作特征进行融合得到舞蹈场景图像序列;

9、所述网络鉴别器用于在相同的分辨率尺度下同时接受到真实场景和舞蹈动作输入、生成图像场景和舞蹈动作组合输入,再利用多分类交叉损失熵判断合成图像是否与真实图像一致,若是,则输出;若不是,则重新生成。

10、基础方案原理及有益效果如下:由于歌曲处理器将歌曲分离成歌词和歌曲旋律;基于mttim的自回归模型网络接收歌词并将歌词按语句提取歌词特征序列,生成与歌词相匹配的场景图像;基于transformer的自回归模型网络接收歌曲旋律并生成与该歌曲旋律相对应的舞蹈动作特征;多模态transformer网络将生成的场景图像和舞蹈动作特征进行融合得到舞蹈场景图像序列;网络鉴别器在相同的分辨率尺度下同时接受到真实场景和舞蹈动作输入、生成图像场景和舞蹈动作组合输入,再利用多分类交叉损失熵判断合成图像是否与真实图像一致,所以本发明能够从音乐中提取歌曲的歌词和旋律,根据歌词生成与歌词语义一致的场景图像,通过音乐旋律生成相应的舞蹈动作,然后把舞蹈动作和场景图像按照音乐片段进行融合,最终生成一段与歌曲的主题和情感相匹配的音乐舞蹈mv。

11、进一步,所述基于mttim的自回归模型网络是一种交错视觉和语言生成模型,引入生成vokens的概念和先进的训练策略,并且由两级mttim网络模块构成,模型的输入由多模态的文字和图像构成,系统模型利用预训练好的一级mttim模型为语句级歌词生成一幅场景图像,生成的图像再反馈给下一级mttim模型,使其生成下一帧场景图像时充分利用历史信息。

12、通过上述方法,能够实现文本和图像的协调输出,同时也能够实现生成场景图像连续性和一致性的优化。

13、进一步,所述基于mttim的自回归模型网络中的多模态文本生成图像模块mttim利用“vokenization”技术生成vokens,可视化标记vokens是将语言标记在上下文中映射到相关图像,在文字转图像的任务中作为视觉监督。向mttim模块的输入由多模态的文字和图像构成,系统首先将文字输入到预训练好的llm模型(大规模语言模型)生成vokens,第二步将图像输入到图像编码器进行特征编码,然后将voken features和图像特征送入到跨模态转换器中进行训练学习获取多模态的融合特征,mttim模型通过解码器为语句级歌词生成一幅场景图像,生成的图像作为参考图像再反馈给下一级mttim模型。

14、通过上述自回归模式学习,能够让歌曲生成的场景能够保持图像的连贯性。

15、进一步,所述基于transformer的自回归模型网络采用了一个音频编码器和舞蹈运动解码器来构成。编码器和解码器采用了多头注意力机制multi-head attention,它可以帮助模型学习到不同类型的上下文影响情况。首先音频旋律经过特征提取后分为n个音乐片段,将一个音乐片段特征输入到音频变换器进行编码,编码器将输入音乐片段的低层次声学特征转化为高层次的潜在表征,通过多头注意力,有效地处理长序列的音乐特征。然后将编码和一个舞蹈动作特征编码进行连接输入到舞蹈动作解码器中,解码器利用多头注意力机制,以音乐特征序列的潜在表征中的相应元素为条件,逐帧预测舞蹈动作。利用生成的舞蹈动作作为输入反馈给舞蹈动作解码器,以自回归的方式来产生连续运动。

16、通过上述方法,能够将歌曲的上下文联系起来,并通过音乐特征生成相应的舞种和舞蹈动作。

17、进一步,所述歌曲处理器还用于将歌词进行排列,并根据歌词的意境和情感对歌词进行分段;并用于将旋律进行排列,根据旋律所需要的情感来判断所需要的音质,根据音质选择相应的乐器。

18、通过上述方法,能够对歌曲的意境和情绪进一步理解,也能够使得最终生成音乐舞蹈mv有其独特的意境和情绪价值。

19、进一步,所述基于transformer的自回归模型网络还用于根据歌曲旋律对生成视频中的人物装束进行设定。

20、通过对舞蹈人物的装束进行约束设定,能够更好的表达歌曲中的意境与情绪。

21、进一步,所述数据集的建立从三个方向入手,分别是:第一,有效利用网络资源,从internet检索用于音乐舞蹈生成的公开数据集;第二,利用相关图像算法自动合成仿真数据集,通过openpose等算法对已经存在舞蹈视频进行人体动作的捕捉;第三,通过人工处理方法来获取数据集。

22、通过上述方法获取数据集,能够获取足够的带标注的音乐舞蹈mv数据。

23、进一步,所述多模态transformer网络用于在实现歌词驱动生成的连续图像序列和音乐旋律驱动的舞蹈动作序列基础上,对场景图像和舞蹈动作进行合成,其中的解码器对场景图像和舞蹈动作之间的分布进行相关性建模,合成舞蹈动作场景;所述相关性建模公式如下:

24、用于度量场景图像x和舞蹈动作y之间的相关程度,其值介于-1和1之间,定义为场景图像x和舞蹈动作y的协方差除以他们的标准差之积:

25、

26、计算公式如下:

27、

28、通过对场景图像和舞蹈动作之间的分布相关性建模,能够通过场景图像来预测n个未来的舞蹈运动序列,也可以让场景图像与舞蹈动作之间有更多的因果关系和联系。

29、进一步,所述多分类交叉损失熵公式如下:

30、

31、其中p=[p0,···,pc-1]是一个概率分布,每个元素pi表示样本属于第i类的概率;y=[y0,···,yc-1]是样本标签的onehot表示,当样本属于第类别i时yi=1,否则yi=0;c是样本标签。

本文地址:https://www.jishuxx.com/zhuanli/20240618/24545.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。