多任务风险泛化的分布式多无人机策略获取方法及装置

- 国知局

- 2024-08-01 00:02:46

本技术涉及无人机,特别是涉及一种多任务风险泛化的分布式多无人机策略获取方法及装置。

背景技术:

1、将强化学习应用于分布式无人机系统能够显著提升无人机的自主决策和协同工作能力。这些系统在环境监测、灾害救援和物流配送等领域具有广泛应用前景。通过强化学习算法,无人机可以在复杂和动态的环境中学习最佳行动策略,执行任务如路径规划、目标识别和协同操作。然而,分布式无人机系统涉及多个无人机协同完成多种任务,因此,算法的适应性和泛化能力至关重要,以应对各种未知和变化的任务需求。

2、然而,传统的单任务强化学习算法在适应新任务或环境时表现不佳,导致任务适应性差,需要频繁重新训练模型。同时,这些算法容易过拟合到特定任务,降低在其他任务中的性能。缺乏风险管理使得在不同任务中的表现不稳定,增加任务失败的风险。此外,单任务训练的算法难以有效协调多个无人机的互动,减弱系统的协同效应。最后,面对新任务时需要大量重新训练,浪费资源并降低系统效率。这些缺点显著限制了分布式无人机系统在实际应用中的灵活性和可靠性。同时,在分布式无人机系统面临的新任务中,可能还会存在诸如通信故障、环境突变以及未预见的障碍等其他风险。因此,需要能够适应风险变化的策略泛化方法,以确保系统在不同任务和环境下的稳定性和可靠性。

技术实现思路

1、基于此,有必要针对上述技术问题,提供一种能够跨任务适用的多任务风险泛化的分布式多无人机策略获取方法及装置。

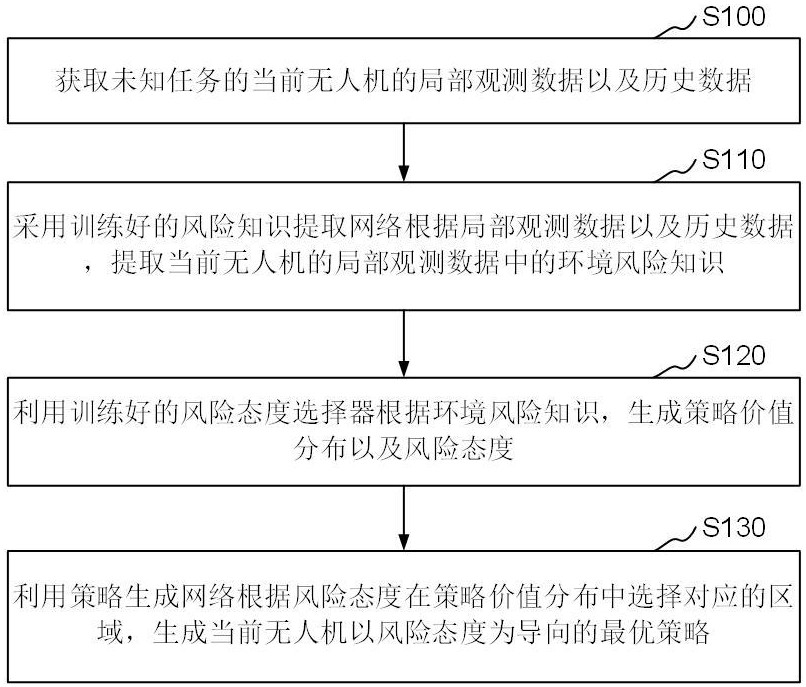

2、一种多任务风险泛化的分布式多无人机策略获取方法,所述方法实施于分布式无人机集群中每一个无人机中,所述方法包括:

3、获取未知任务的当前无人机的局部观测数据以及历史数据;

4、采用训练好的风险知识提取网络根据所述局部观测数据以及历史数据,提取所述当前无人机的局部观测数据中的环境风险知识;

5、利用训练好的风险态度选择器根据所述环境风险知识以及局部观测数据,生成策略价值分布以及风险态度;

6、利用策略生成网络根据所述风险态度在所述策略价值分布中选择对应的区域,生成当前无人机以所述风险态度为导向的最优策略。

7、在其中一实施例中,在对所述风险知识提取网络和风险态度选择器进行训练时:

8、基于已知任务离线数据中的状态信息提取环境风险知识,利用状态环境风险知识对风险态度选择器进行训练,得到训练好的风险态度选择器;

9、基于已知任务离线数据中的多个局部观测数据,通过训练好的风险态度选择器以及混合网络对所述风险知识提取网络进行训练,得到训练好的风险知识提取网络。

10、在其中一实施例中,在对所述风险态度选择器进行训练时:

11、采用状态信息风险知识提取网络,从所述已知任务离线数据中的状态信息中提取出所述状态环境风险知识;

12、在所述状态信息风险知识提取网络中,将所述状态信息解耦为协作方特征信息以及对抗方特征信息,并分别利用多层感知器进行固定维数的嵌入后,基于自注意力机制得到所述状态环境风险知识。

13、在其中一实施例中,在对所述风险态度选择器进行训练时,采用的损失函数表示为:

14、;

15、在上式中,表示智能体从状态信息中获取的风险知识,是智能体基于学到的风险态度,表示根据所述状态环境风险知识对所述风险态度选择器进行训练,表示所述风险态度选择器输出的策略价值分布,表示离线数据中的真实动作。

16、在其中一实施例中,在对所述风险知识提取网络进行训练时,利用混合网络以及训练好的风险态度选择器,在集中训练与分散执行的训练框架下,通过训练协调策略来优化基于智能体局部观测数据的风险知识提取网络。

17、在其中一实施例中,在对所述风险知识提取网络进行训练时:

18、利用所述风险知识提取网络,分别从局部观测数据中提取观测环境风险知识;

19、利用所述训练好的风险态度选择器根据将所述观测环境风险知识,生成对应的策略价值分布以及风险态度;

20、利用混合网络将各所述策略价值分布进行加权求和生成联合策略价值分布,并采用隐式分位数网络将环境风险融入联合策略价值分布中;

21、利用td-huber损失函数、根据联合策略价值分布以及环境风险融入后的联合策略价值分布构建的损失函数,以及基于状态信息和局部观测数据分别提取得到的风险态度构建的损失函数对所述风险知识提取网络进行训练,得到训练好的风险知识提取网络。

22、在其中一实施例中,在所述训练好的风险知识提取网络中:

23、将各所述局部观测数据解耦为己方特征信息、观测协作方特征信息以及观测对抗方特征信息;

24、利用多层感知器分别对各所述己方特征信息、观测协作方特征信息、观测对抗方特征信息以及历史数据进行处理后,采用transformer神经网络生成所述局部观测数据中的风险环境知识。

25、在其中一实施例中,在所述训练好的风险态度选择器中:

26、利用option网络采用全连接层将所述风险环境知识映射到预设数量维度的嵌入中得到对应的风险态度;

27、利用解码器根据所述风险态度生成所述策略价值分布。

28、在其中一实施例中,所述方法还包括对所述训练好的风险知识提取网络以及训练好的风险态度选择器进行在线训练,采用的在线总损失函数表示为:

29、;

30、在上式中,和分别表示td-huber损失函数,以及根据联合策略价值分布以及环境风险融入后的联合策略价值分布构建的损失函数,表示在优化联合策略价值分布时引入了quota算法中的选项误差构建的损失函数,和分别表示在线训练时的权重。

31、本技术还提供了一种多任务风险泛化的分布式多无人机策略获取装置,所述装置包括:

32、数据获取模块,用于获取未知任务的当前无人机的局部观测数据以及历史数据;

33、环境风险知识提取模块,用于采用训练好的风险知识提取网络根据所述局部观测数据以及历史数据,提取所述当前无人机的局部观测数据中的环境风险知识;

34、策略价值分布以及风险态度生成模块,用于利用训练好的风险态度选择器根据所述环境风险知识以及局部观测数据,生成策略价值分布以及风险态度;

35、最优策略得到模块,用于利用策略生成网络根据所述风险态度在所述策略价值分布中选择对应的区域,生成当前无人机以所述风险态度为导向的最优策略。

36、一种计算机设备,包括存储器和处理器,所述存储器存储有计算机程序,所述处理器执行所述计算机程序时实现以下步骤:

37、获取未知任务的当前无人机的局部观测数据以及历史数据;

38、采用训练好的风险知识提取网络根据所述局部观测数据以及历史数据,提取所述当前无人机的局部观测数据中的环境风险知识;

39、利用训练好的风险态度选择器根据所述环境风险知识以及局部观测数据,生成策略价值分布以及风险态度;

40、利用策略生成网络根据所述风险态度在所述策略价值分布中选择对应的区域,生成当前无人机以所述风险态度为导向的最优策略。

41、一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器执行时实现以下步骤:

42、获取未知任务的当前无人机的局部观测数据以及历史数据;

43、采用训练好的风险知识提取网络根据所述局部观测数据以及历史数据,提取所述当前无人机的局部观测数据中的环境风险知识;

44、利用训练好的风险态度选择器根据所述环境风险知识以及局部观测数据,生成策略价值分布以及风险态度;

45、利用策略生成网络根据所述风险态度在所述策略价值分布中选择对应的区域,生成当前无人机以所述风险态度为导向的最优策略。

46、上述多任务风险泛化的分布式多无人机策略获取方法及装置,通过采用训练好的风险知识提取网络根据局部观测数据以及历史数据,提取局部观测数据中的环境风险知识,再利用训练好的风险态度选择器根据环境风险知识,生成策略价值分布以及风险态度,利用策略生成网络根据风险态度在策略价值分布中选择对应的区域,生成以风险态度为导向的最优策略。采用本方法可以将对已知任务的学习到的风险知识迁移至未知任务中,从而得到适应于位置任务的最优策略。

本文地址:https://www.jishuxx.com/zhuanli/20240730/199522.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表