音频驱动视频生成方法、装置、计算机设备以及存储介质与流程

- 国知局

- 2024-08-02 12:40:57

本技术涉及视频处理,特别是涉及一种音频驱动视频生成方法、装置、计算机设备以及存储介质。

背景技术:

1、在一些人工智能应用场景中,往往设置拟人形态的人工智能视频影像执行语音播报的任务,在此过程中需要音频驱动人工智能的视频影像进行动作。但是现有的通过音频驱动视频影像进行说话动作时,仅关注视频影像的人物唇部动作,并未关注与音频密切相关的面部表情。在实际对话场景中,人物的面部动画通常与相应的语音紧密联系在一起,其中包含强烈的非言语信息,有助于用户理解说话内容。现有的音频驱动视频影像进行对话动作时,一般是通过确定性的方式建模音频到视觉的映射,将导致音频驱动回归到平均面部表情,使得生成的视频影像面部表情变化幅度较小,无法准确的表达音频中的情感信息。因此,如何通过音频驱动视频影像执行准确的说话动作,以便于用户更好的理解音频内容,是需要解决的问题。

技术实现思路

1、基于此,有必要针对上述技术问题,提供一种能够通过音频驱动视频影像执行准确的说话动作,在视频人物说话时,丰富视频人物的面部表情的音频驱动视频生成方法、装置、计算机设备以及存储介质。

2、第一方面,本技术提供了一种音频驱动视频生成方法,所述方法包括:

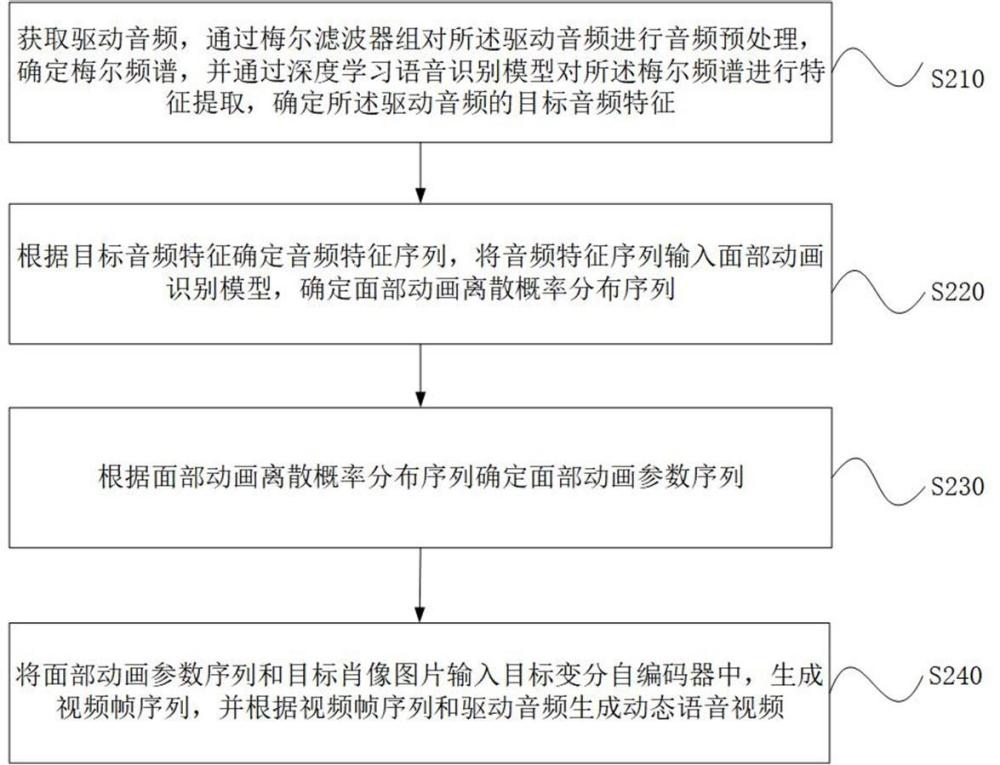

3、获取驱动音频,通过梅尔滤波器组对所述驱动音频进行音频预处理,确定梅尔频谱,并通过深度学习语音识别模型对所述梅尔频谱进行特征提取,确定所述驱动音频的目标音频特征;

4、根据所述目标音频特征确定音频特征序列,将所述音频特征序列输入面部动画识别模型,确定面部动画离散概率分布序列;

5、根据所述面部动画离散概率分布序列确定面部动画参数序列;

6、将所述面部动画参数序列和目标肖像图片输入目标变分自编码器中,生成视频帧序列,并根据所述视频帧序列和所述驱动音频生成动态语音视频。

7、在其中一个实施例中,根据所述面部动画离散概率分布序列确定面部动画参数序列,包括:

8、对所述面部动画离散概率分布序列进行采样,确定面部动画离散特征序列;

9、将面部动画离散特征序列进行数值转换,确定离散特征函数,对所述离散特征函数进行插值处理,确定面部动画参数序列。

10、在其中一个实施例中,上述音频驱动视频生成方法还包括:

11、获取第一样本视频,从所述第一样本视频中提取样本音频特征;

12、通过动作单元识别模型识别第一样本视频的样本面部动作单元,并采用姿态估计模型标注所述第一样本视频的样本头部动作;

13、采用所述样本音频特征、所述样本面部动作单元和所述样本头部动作对深度学习模型进行模型训练,确定面部动画识别模型。

14、在其中一个实施例中,采用所述样本音频特征、所述样本面部动作单元和所述样本头部动作对深度学习模型进行模型训练,确定面部动画识别模型,包括:

15、将所述样本音频特征输入深度学习模型,根据模型输出确定样本音频特征对应的样本概率分布数据;所述样本概率分布数据包括面部动作单元概率分布和头部动作概率分布;

16、根据所述样本概率分布数据、所述样本面部动作单元和所述样本头部动作确定所述深度学习模型的模型损失函数;

17、若所述模型损失函数满足预设的损失函数条件,则确定所述深度学习模型训练完成,并将训练完成的深度学习模型作为面部动画识别模型。

18、在其中一个实施例中,上述音频驱动视频生成方法还包括:

19、获取第二样本视频,通过待训练变分自编码器中的待训练编码器确定所述第二样本视频的样本视频表示信息;

20、采用所述待训练变分自编码器中的待训练解码器,基于所述样本视频表示信息进行视频帧重建,确定重构视频信息;

21、根据所述第二样本视频和所述重构视频信息确定样本视频损失数据;

22、基于所述样本视频损失数据优化所述待训练变分自编码器中待训练解码器的解码器参数和待训练编码器的编码器参数,确定目标变分自编码器。

23、在其中一个实施例中,所述待训练编码器包括第一编码器和第二编码器,所述获取第二样本视频,通过待训练变分自编码器中的待训练编码器确定所述第二样本视频的样本视频表示信息,包括:

24、获取第二样本视频,对所述第二样本视频进行采样,确定采样视频帧;

25、通过待训练变分自编码器中的第一编码器对所述采样视频帧进行编码处理,确定视频静态表示信息;

26、提取所述第二样本视频中每一个视频帧的面部动画参数,并通过所述变分自编码器中的第二编码器对所述面部动画参数进行编码处理,确定视频动态表示序列,并将所述视频静态表示信息和所述视频动态表示序列作为所述第二样本视频的样本视频表示信息。

27、在其中一个实施例中,将所述面部动画参数序列和目标肖像图片输入目标变分自编码器中,生成视频帧序列,包括:

28、将所述面部动画参数序列和目标肖像图片输入目标变分自编码器中,以通过所述目标变分自编码器,根据所述目标肖像图片确定目标静态表示信息,并根据所述面部动画参数序列确定目标动态表示序列;

29、根据所述目标静态表示信息和所述目标动态表示序列生成视频帧序列。

30、第二方面,本技术还提供了一种音频驱动视频生成装置,所述装置包括:

31、音频特征确定模块,用于获取驱动音频,通过梅尔滤波器组对所述驱动音频进行音频预处理,确定梅尔频谱,并通过深度学习语音识别模型对所述梅尔频谱进行特征提取,确定所述驱动音频的目标音频特征;

32、离散概率分布确定模块,用于根据所述目标音频特征确定音频特征序列,将所述音频特征序列输入面部动画识别模型,确定面部动画离散概率分布序列;

33、面部参数序列确定模块,用于根据所述面部动画离散概率分布序列确定面部动画参数序列;

34、动态语音视频确定模块,用于将所述面部动画参数序列和目标肖像图片输入目标变分自编码器中,生成视频帧序列,并根据所述视频帧序列和所述驱动音频生成动态语音视频。

35、第三方面,本技术还提供了一种计算机设备,所述计算机设备包括存储器和处理器,所述存储器存储有计算机程序,所述处理器执行所述计算机程序时实现以下步骤:

36、获取驱动音频,通过梅尔滤波器组对所述驱动音频进行音频预处理,确定梅尔频谱,并通过深度学习语音识别模型对所述梅尔频谱进行特征提取,确定所述驱动音频的目标音频特征;

37、根据所述目标音频特征确定音频特征序列,将所述音频特征序列输入面部动画识别模型,确定面部动画离散概率分布序列;

38、根据所述面部动画离散概率分布序列确定面部动画参数序列;

39、将所述面部动画参数序列和目标肖像图片输入目标变分自编码器中,生成视频帧序列,并根据所述视频帧序列和所述驱动音频生成动态语音视频。

40、第四方面,本技术还提供了一种计算机可读存储介质,所述计算机可读存储介质,其上存储有计算机程序,所述计算机程序被处理器执行时实现以下步骤:

41、获取驱动音频,通过梅尔滤波器组对所述驱动音频进行音频预处理,确定梅尔频谱,并通过深度学习语音识别模型对所述梅尔频谱进行特征提取,确定所述驱动音频的目标音频特征;

42、根据所述目标音频特征确定音频特征序列,将所述音频特征序列输入面部动画识别模型,确定面部动画离散概率分布序列;

43、根据所述面部动画离散概率分布序列确定面部动画参数序列;

44、将所述面部动画参数序列和目标肖像图片输入目标变分自编码器中,生成视频帧序列,并根据所述视频帧序列和所述驱动音频生成动态语音视频。

45、上述音频驱动视频生成方法、装置、计算机设备以及存储介质,获取驱动音频,对驱动音频进行特征预处理确定所述驱动音频的目标音频特征;根据目标音频特征确定音频特征序列,将音频特征序列输入面部动画识别模型,确定面部动画离散概率分布序列;根据面部动画离散概率分布序列确定面部动画参数序列;将面部动画参数序列和目标肖像图片输入目标变分自编码器中,生成视频帧序列,并根据视频帧序列和驱动音频生成动态语音视频。解决了音频驱动视频影像进行对话动作时,一般是通过确定性的方式建模音频到视觉的映射,将导致音频驱动回归到平均面部表情,使得生成的视频影像面部表情变化幅度较小,无法准确的表达音频中的情感信息的问题。上述方案,通过驱动音频的目标音频特征确定面部动画离散概率分布序列,可以丰富面部动画的选择灵活性,且能够获得可以表征音频感知信息的面部动画,基于面部动画离散概率分布序列和目标肖像图片生成动态语音视频,能够丰富动态语音视频中的数字人在发声过程中面部表情,提高人像面部说话的自然度和多样性,使得数字人在发声时可以通过面部表情表达驱动音频中的感情信息,以便于用户更好的理解音频内容。

本文地址:https://www.jishuxx.com/zhuanli/20240802/237302.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

上一篇

扫描系统及扫描方法与流程

下一篇

返回列表