基于ESAttention的前后对称分解长期时序预测方法

- 国知局

- 2024-08-08 16:59:03

本发明属于深度学习,具体涉及一种基于esattention的前后对称分解长期时序预测方法。

背景技术:

1、时间序列是一个按时间顺序排列的数据点序列。全面分析和挖掘这类数据,如预测发展趋势,在现实世界中得到了广泛的应用,如传感器网络监测、天气预报、经济和金融、疾病传播分析和电力预测。特别是,对未来很长一段时间进行时序预测在现实中的需求越来越大。然而,随着大数据时代的快速发展,采集到的数据规模庞大,从而给长期预测任务带来了巨大的挑战。

2、传统的时序预测算法主要基于统计学的原理和方法,对时间序列数据进行建模和预测。移动平均模型(ma)通过对过去时间序列的随机噪声和误差值的线性组合来表示当前的预测。差分自回归移动平均模型(arima)通过将不稳定的时间序列转换为稳定的时间序列,可以较准确地预测未来的趋势和变化。但是在面对复杂、非线性或高维的时间序列数据时,传统时序算法预测性能会急速下降,无法满足长期时序预测任务的需要。

3、近几年来,最先用于计算机视觉领域的卷积神经网络(cnn)被广泛应用于时序预测领域。tcn引入空洞因果卷积,同时使用残差连接使得信息在网络间传递时可以跨层传递以解决卷积在层数过多时导致的信息丢失问题。scinet采用下采样—卷积—交互体系结构,使用多个卷积滤波器从下采样的子序列中提取独特而有价值的时间特征,取得了显著的效果。micn采用多尺度分解结构分别对不同的潜在模式进行建模预测,每个模式分别采用下采样卷积和等距卷积来提取局部特征和全局相关性,从而保证时序数据的底层信息得到充分利用。但是基于卷积神经网络的方法依然存在以下问题:一方面,顺序特征是时序数据最为重要的特征之一,但现有的卷积方法却忽略了对顺序特征的提取和学习;另一方面,卷积能够捕捉序列中局部和短期的依赖关系,在处理长序列时可能无法捕捉到序列中的长期依赖关系,在长时间时序预测任务当中取得的效果不理想。

技术实现思路

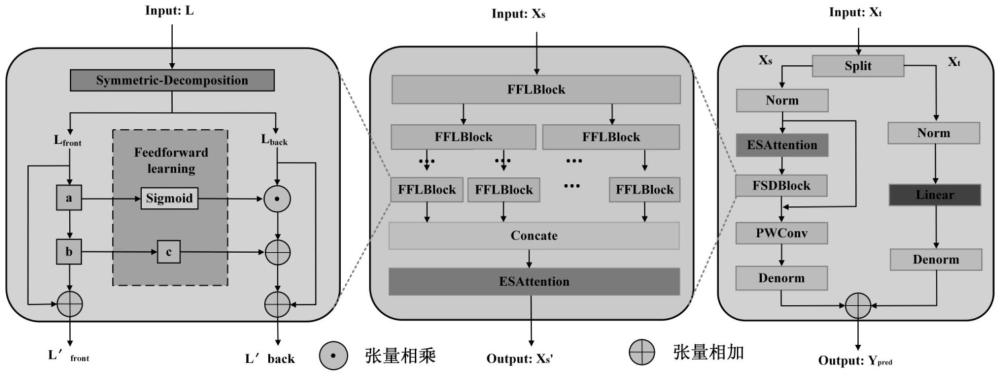

1、针对上述技术问题,本发明提供了一种基于esattention的前后对称分解长期时序预测方法。首次提出序列前后对称分解思想,以保证序列的顺序性,同时提出了前馈学习使得前后对称分解后的后半部分序列可以学习到前半部分序列的信息,从而提取到序列中的顺序特征;其次为了弥补卷积处理长期时序任务不理想表现,引入爱因斯坦求和约定(einsum)构造基于einsum的自注意力机制esattention,提高网络提取全局特征的能力。

2、为了解决上述技术问题,本发明采用的技术方案为:

3、基于esattention的前后对称分解长期时序预测方法,包括下列步骤:

4、s1、构建以卷积神经网络为主的基于esattention的前后对称分解长期时序预测模型essdnet;

5、s2、使用前后对称分解方式分解序列以保证序列的顺序性不被改变;

6、s3、对s2中分解所得的两条子序列使用前馈学习将前半部分序列的信息经过卷积块和sigmoid函数处理传递给后半部分序列,从而对顺序特征进行提取;

7、s4、使用爱因斯坦求和约定einsum构造基于einsum的自注意力机制esattention保证数据的关联性,提高模型捕获全局特征的能力。

8、所述s1中模型的主体框架是一个卷积神经网络,包含趋势季节项分解模块、esattention模块、下采样模块以及前馈学习模块四部分;首先,对输入到网络模型中的时序数据x进行趋势季节项分解,通过分解,时序数据x将被分解为两个部分:趋势项xt和季节项xs;其次,使用线性层处理xt得到时序数据的整体趋势特征;然后,将xs送入到esattention模块提取全局特征,再送入到下采样模块中的前馈学习模块以提取顺序特征;最后,将处理后的xt和xs进行融合得到最终的预测结果。

9、所述s2中前后对称分解方式可以将序列分解成两个子序列,并且保证序列的顺序性不被改变,分解过程为:

10、lfront,lback=fbsd(l)

11、式中,l表示送入到fflblock的特征数据,fbsd(·)表示前后对称分解操作,lfront和lback分别表示经过前后对称分解操作所得到的前半部分序列和后半部分序列。

12、所述s3中的前馈学习由3个卷积块、一个sigmoid函数以及残差连接组成;对于分解得到的lfront,仅使用不同的卷积块处理lfront从而得到最终输出,并使用残差连接保证模型的性能;而对于分解所得到的lback,先使用卷积块处理lfront得到特征lfront_mid,其次使用sigmoid函数处理特征lfront_mid并将其传给lback得到特征lback_mid,然后再使用多个卷积块处理lfront_mid得到特征lfront_late,最后将特征lfront_late和lback_mid融合得到最终输出,并结合残差连接保证学习的性能;前馈学习完成后,便会得到两条具有丰富特征的新序列;前馈学习过程为:

13、lfront_mid=a(lfront)

14、l′front=lfront+b(lfront_mid)

15、lback_mid=lback⊙sigmoid(lfront_mid)

16、lfront_late=c(b(lfront_mid))

17、l′back=lback+lback_mid+lfront_late

18、式中:l′front表示lfront经过卷积块处理后的最终输出结果,l′back表示lback经过特征融合后的最终输出结果,a、b、c分别表示三组不同的卷积块,⊙表示元素乘积。

19、所述s4中einsum能够根据数据原先的位置构建索引,然后根据索引来计算数据的乘积;对于复杂的时序数据,使用einsum构造自注意力机制可以更准确地计算出数据之间的关系,在捕获全局信息的同时保证了数据之间的关联性;esattention的计算过程为:

20、

21、式中:q、k、v分别表示每个数据的查询query、键key、值value,d表示输入数据的特征维度。

22、本发明与现有技术相比,具有的有益效果是:

23、本发明使用前后对称分解思想以及前馈学习能够有效地提取时序数据中的顺序特征,并使用esattention提高了模型捕捉全局特征的能力以及数据间的关联性,使得预测的结果更符合真实数据。本发明在变压器数据集中在mse和mae两种评价指标上获得了很好的定量结果,且在定性结果中也表现出更接近真实值的直观感受。

技术特征:1.基于esattention的前后对称分解长期时序预测方法,其特征在于,包括下列步骤:

2.根据权利要求1所述的基于esattention的前后对称分解长期时序预测方法,其特征在于,所述s1中模型的主体框架是一个卷积神经网络,包含趋势季节项分解模块、esattention模块、下采样模块以及前馈学习模块四部分;首先,对输入到网络模型中的时序数据x进行趋势季节项分解,通过分解,时序数据x将被分解为两个部分:趋势项xt和季节项xs;其次,使用线性层处理xt得到时序数据的整体趋势特征然后,将xs送入到esattention模块提取全局特征,再送入到下采样模块中的前馈学习模块以提取顺序特征;最后,将处理后的xt和xs进行融合得到最终的预测结果。

3.根据权利要求1所述的基于esattention的前后对称分解长期时序预测方法,其特征在于,所述s2中前后对称分解方式可以将序列分解成两个子序列,并且保证序列的顺序性不被改变,分解过程为:

4.根据权利要求1所述的基于esattention的前后对称分解长期时序预测方法,其特征在于,所述s3中的前馈学习由3个卷积块、一个sigmoid函数以及残差连接组成;对于分解得到的lfront,仅使用不同的卷积块处理lfront从而得到最终输出,并使用残差连接保证模型的性能;而对于分解所得到的lback,先使用卷积块处理lfront得到特征lfront_mid,其次使用sigmoid函数处理特征lfront_mid并将其传给lback得到特征lback_mid,然后再使用多个卷积块处理lfront_mid得到特征lfront_late,最后将特征lfront_late和lback_mid融合得到最终输出,并结合残差连接保证学习的性能;前馈学习完成后,便会得到两条具有丰富特征的新序列;前馈学习过程为:

5.根据权利要求1所述的基于esattention的前后对称分解长期时序预测方法,其特征在于,所述s4中einsum能够根据数据原先的位置构建索引,然后根据索引来计算数据的乘积;对于复杂的时序数据,使用einsum构造自注意力机制可以更准确地计算出数据之间的关系,在捕获全局信息的同时保证了数据之间的关联性;esattention的计算过程为:

技术总结本发明属于深度学习技术领域,具体涉及一种基于ESAttention的前后对称分解长期时序预测方法,包括下列步骤:构建神经网络模型ESSDNet;利用两种数据集在所构建的ESSDNet网络上进行训练并测试;建立评价指标用于对ESSDNet模型的预测性能进行评估。本发明主体框架是一个卷积神经网络,使用前后对称分解思想以及前馈学习处理时序数据,可以有效地提取时序数据中的顺序特征;构建的ESAttention提高了模型捕捉全局特征的能力且保证了数据间的关联性,两者融合有效地提高了模型长期预测的性能,使得预测结果更接近真实数据。技术研发人员:邓红霞,程倚宁,张军,贾凡,彭俊驰,杨雨晴,韩飞墨,荣禹森受保护的技术使用者:太原理工大学技术研发日:技术公布日:2024/8/5本文地址:https://www.jishuxx.com/zhuanli/20240808/271626.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。