一种基于LSTM-PPO算法的分布式能源系统能量调度优化方法与流程

- 国知局

- 2024-08-19 14:21:31

本发明涉及电力系统自动化技术,特别涉及一种基于lstm-ppo算法的分布式能源系统能量调度优化方法。

背景技术:

1、随着分布式可再生能源发电的快速增长,分布式能源优化调度已引起专家学者的广泛关注,然而对于分布式能源系统的能源调度问题有两大挑战,一是分布式能源出力的间歇性给能量调度问题带来了不确定性,二是分布式资源的增加带来的复杂性。因此,迫切需要创新的方法,能够实时提供高质量的解决方案,同时处理像光伏(pv)这样的分布式资源的不确定性。

2、为了实现更准确的能源产量预测、负荷预测和电力价格预测,为优化能源分配和系统调度提供更可靠的依据,同时能够捕获长期依赖关系,适应系统的动态变化,优化能源存储策略,并为分布式能源系统的长期规划和控制提供有力支持,最终有助于提高能源系统的效率和可靠性。可以采用循环神经网络(rnn)对分布式能源系统调度提取时序特征,有助于更好地处理系统的时序数据,包括能源产生、需求和价格的时间变化,然而目前的研究存在预测模型输入特征维度不足、以及单一模型预测精度不高而导致的短期功率预测效果较差的问题。

3、目前,使用深度神经网络(dnn)作为函数逼近器的深度强化学习(drl)在解决具有连续动作的不同能源相关调度问题方面表现出良好的性能,现有的研究在电网调度方面展开研究。然而这些工作依赖于基于值的rl算法,其不能很好地扩展。相反,基于策略的drl算法,通过集成演员-评论家结构,在复杂的mdp任务(如机器人控制和视频游戏)上表现出出色的性能。当前drl最先进的技术包括部分研究所提出的诸如深度确定性策略梯度(ddpg)算法和soft actor-critic(sac)算法。ddpg是一种用于解决连续动作空间问题的确定性策略梯度算法,采用dpg算法,并引入了off-policy采样以解决无法探索的问题,同时采用目标网络和经验回放技术,但用了大量计算资源,需要更多的算力,导致其运行时间过长,在用电成本和性能方面都有很大的缺陷。在sac算法中所有样本都以等概率随机采样,造成了训练速度慢、训练过程不稳定的情况。

技术实现思路

1、发明目的:针对以上问题,本发明目的是提供一种基于lstm-ppo算法的分布式能源系统能量调度优化方法,将长短期记忆神经网络lstm嵌入到近端策略优化算法中,来捕获分布式能源数据的时序特征,达到最小化系统运行成本并实时确保功率平衡约束的目的。

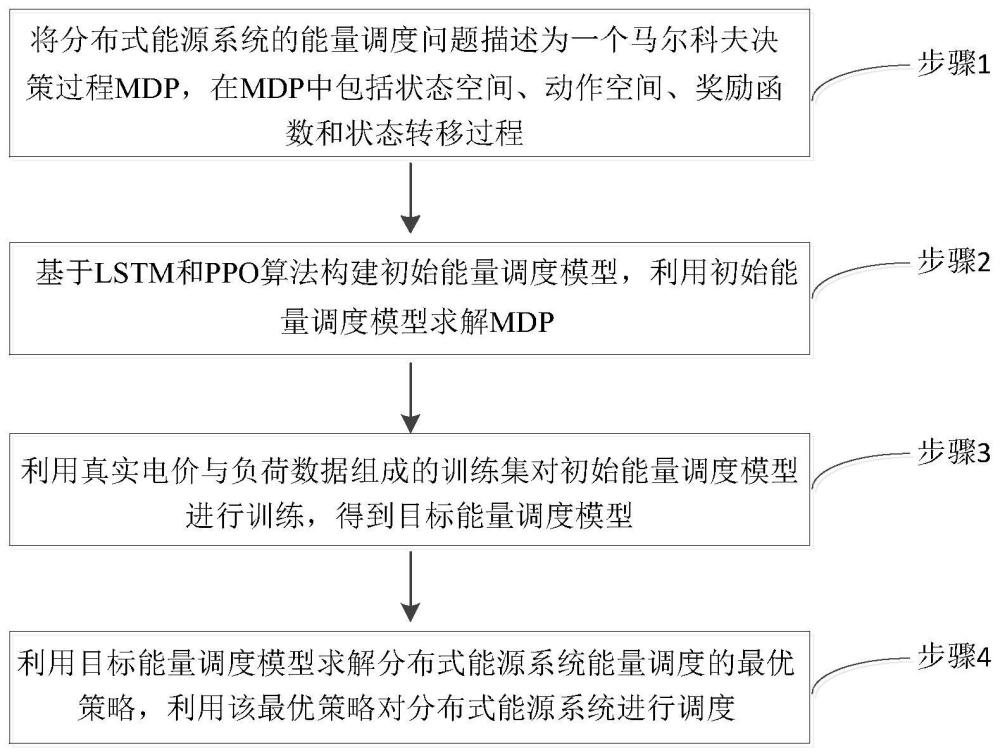

2、技术方案:本发明的一种基于lstm-ppo算法的分布式能源系统能量调度优化方法,包括如下步骤:

3、步骤1,将分布式能源系统的能量调度问题描述为一个马尔科夫决策过程mdp,在mdp中包括状态空间、动作空间、奖励函数和状态转移过程;

4、步骤2,基于lstm和ppo算法构建初始能量调度模型,利用初始能量调度模型求解mdp;该初始能量调度模型包括lstm神经网络、策略网络actor和价值网络critic,将当前的时隙电价以及历史状态信息作为输入项输入至lstm神经网络中,将lstm神经网络提取的特征作为输入项输入至actor和critic,利用actor生成能量调度策略,利用critic生成策略的价值来评价actor策略;

5、步骤3,利用真实电价与负荷数据组成的训练集对初始能量调度模型进行训练,得到目标能量调度模型;

6、步骤4,利用目标能量调度模型求解分布式能源系统能量调度的最优策略,利用该最优策略对分布式能源系统进行调度。

7、进一步,在步骤1中的状态空间、动作空间、奖励函数和状态转移过程分别表示如下:

8、状态空间:将强化学习智能体的状态空间用xt=(st,st-1,st-2,st-3…)表示,包含当前时刻和之前时刻的状态信息st,其中st=(pv t,pl t,pg t-1,soct,ρt),pv t为t时刻光伏发电机的有功输出;pl t为t时刻需求侧负荷的用电量;pg t-1为t-1时刻分布式电源dg发电单元的有功功率输出;soct为t时刻储能设备的充电状态;ρt表示t时刻的电价;

9、动作空间:将动作空间用表示,其中at∈a,a表示动作空间,pi,tg为第i台dg在t时刻向微电网中输出的有功功率;为t时刻储能设备的有功出力;

10、奖励函数:在满足功率平衡约束的基础上,奖励函数指导智能体采取使运行成本最小的动作,t时刻的奖励函数表达式为:

11、

12、其中,表示分布式电源dg机组的运行成本,表示分布式电源的个数;表示向主网购买和出售电力的成本;σ1表示运行成本最小惩罚系数,σ2表示功率不平衡约束惩罚系数;δpt表示t时刻功率的不平衡度,表达式为:

13、

14、其中,表示光伏发出的有功功率,ptn表示从上级电网购买的有功功率,表示储能的有功功率,表示用电负荷的有功功率,表示光伏的个数,表示储能的个数,表示用电负荷的个数;

15、状态转移过程:表示在状态st下做出动作at转移到一下时刻状态st+1的概率,计算表达式为:

16、

17、其中,pr表示状态转移概率,s'表示下一时刻的状态。

18、进一步,lstm神经网络包括24层神经元,每个神经元的输入是当前的时隙电价ρt,以及来自最后一个神经元处理后信息,24层神经元对应过去24小时的电价,输出是从当前和历史信息中提取的特征;

19、每个神经元包括遗忘门、输入门和输出门,每个门的计算表达式分别为:

20、oforget=σ(wf[yt-1,xt]+rf)

21、oinput=σ(wi[yt-1,xt]+rp)*tanh(wi′[yt-1,xt]+rp'),

22、oout=σ(wo[yt-1,xt]+ro)

23、其中,σ表示sigmoid激活函数;wf分别表示遗忘门的权重参数,wi、wi'表示输入门的权重参数,wo表示输出门的权重系数;rf、rp、rp'、ro分别为三个门各自的偏差,xt表示输入项即当前的时隙电价,yt-1表示最后一个神经元处理后的信息,记yt-1=(ct-1,ht-1),ct-1、ht-1表示单元t-1时刻的状态信息。

24、进一步,ppo算法的目标函数的表达式为:

25、

26、式中,表示新旧策略比值,θ为策略参数,表示原来的旧策略,πθ表示算法训练中得到的新策略,表示t时刻优势函数的平均估计值,ρπθ表示策略的概率分布,πθ表示策略;clip(·)为截断函数,将新旧策略的比值范围限制在[1-ε,1+ε]内,ε为截断常数用来设定策略更新的范围;

27、当时,表明当前基于策略选择的动作为最优选择,需要更新策略概率分布以提高该动作被选中的概率;

28、当时,表明当前策略并不理想,需要改进策略以降低该动作被选中的概率。

29、进一步,利用真实电价与负荷数据组成的训练集对初始能量调度模型进行训练的过程包括如下步骤:

30、步骤301,初始化策略网络参数θ、价值网络参数θv以及经验存储池;设置最大迭代次数k、ac网络学习率、经验池容量d以及终止时刻t;

31、步骤302,根据观测状态st,基于策略πθ选取动作at,执行动作at,更新t+1时刻状态st+1,计算实时奖励rt,并存储经验轨迹(s0,a0,r0,s1,a1,r1,...,st,at,rt)至经验存储池;

32、步骤303,从经验存储池中随机抽取经验样本,计算新旧策略比r(θ)和

33、步骤304,将新策略网络参数θ赋值旧网络参数,以更新旧网络;

34、步骤305,裁剪目标函数更新策略网络参数θ;

35、步骤306,计算时序差分误差ξ,更新价值网络参数θv,更新迭代次数;

36、步骤307,重复执行步骤302-步骤306,直至到达最大迭代次数时,训练策略收敛至最优策略,输出最优能量策略πθ。

37、有益效果:本发明与现有技术相比,其显著优点是:

38、本发明将长短期记忆神经网络(lstm)嵌入到近端策略优化(ppo)算法中,提出了一种基于长短期记忆神经网络的近端策略优化(lstm-ppo)算法来捕获分布式能源数据的时序特征,达到最小化系统运行成本并实时确保功率平衡约束的目的;相比常见的ddpg与ppo算法,本发明所提出的lstm-ppo算法提高了ppo智能体对时序状态的感知能力,从累计运行成本和功率不平衡度综合比较来看,lstm-ppo算法在测试集的效果上优于ddpg和ppo算法,能够提供更好的实时调度方案;本发明利用历史数据捕获能源系统的不确定性,利用深度学习模型的良好泛化能力,实时提供高质量的解决方案,并避免运行期间的任何计算负担。

本文地址:https://www.jishuxx.com/zhuanli/20240819/274873.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表