约束下的强化学习的制作方法

- 国知局

- 2024-08-19 14:33:39

背景技术:

1、本发明总体上涉及人工智能,并且更具体地涉及约束下的逐步不确定性感知离线强化学习。

2、诸如传统的离线rl、侧约束下的离线rl和风险敏感离线rl之类的先前方法遭受各种挑战。

3、例如,关于传统的离线rl,针对离线rl的先前研究中的大部分不能考虑约束。换句话说,它们只能处理单个度量(即,奖励)。

4、关于侧约束下的离线rl,众所周知,由于分布偏移,传统的在线rl算法在离线rl设置中不能很好地工作。

5、关于风险敏感的离线ri,该问题设置允许我们结合值函数的分布。然而,难以并入侧面约束。

6、因此,需要一种用于约束(优选地多个约束)下的逐步不确定性感知的离线强化学习的方法。

技术实现思路

1、根据本发明的各方面,提供了一种用于利用数据集进行离线强化学习的计算机实现的方法。该方法包括训练神经网络,该神经网络输入状态-动作对并分别针对一个或多个安全约束和奖励中的每一个输出相应的q函数。神经网络具有线性输出层和由特征映射函数表示的剩余非线性层。训练包括通过根据离线强化算法基于数据集构建q函数来获得特征映射函数。训练还包括使用特征映射函数调整奖励和一个或多个安全约束之间的权重,其中在获得和调整步骤期间,通过从q函数的期望值中减去不确定性来提供q函数的估计。不确定性是将状态-动作对映射到误差大小的函数。

2、根据本发明的其他方面,提供了一种用于利用数据集进行离线强化学习的计算机程序产品。计算机程序产品包括非暂时性计算机可读存储介质,该非暂时性计算机可读存储介质具有随其体现的程序指令。程序指令能够由计算机执行以使计算机执行方法。该方法包括由计算机的处理器设备训练神经网络,该神经网络输入状态-动作对并分别针对一个或多个安全约束和奖励中的每一个输出相应的q函数。神经网络具有线性输出层和由特征映射函数表示的剩余非线性层。训练包括通过根据离线强化算法基于数据集构建q函数来获得特征映射函数。训练还包括使用特征映射函数调整奖励和一个或多个安全约束之间的权重,其中在获得和调整步骤期间,通过从q函数的期望值中减去不确定性来提供q函数的估计。不确定性是将状态-动作对映射到误差大小的函数。

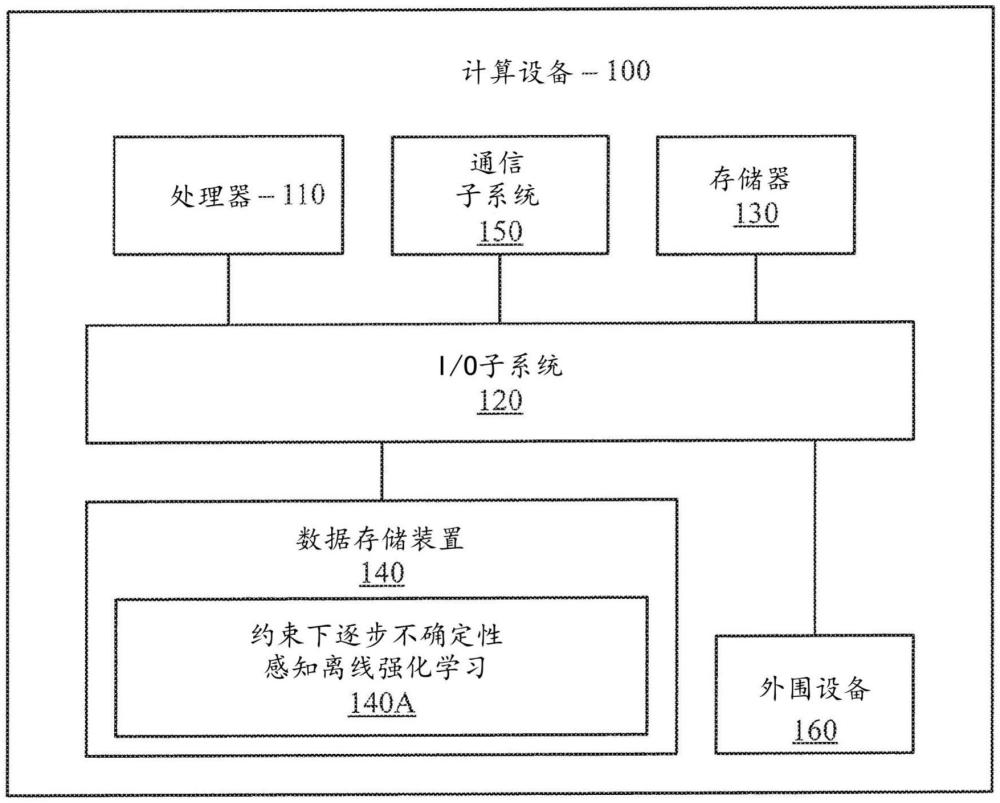

3、根据本发明的其他方面,提供了一种用于利用数据集进行离线强化学习的计算机处理系统。计算机处理系统包括用于存储程序代码的存储器设备。计算机处理系统还包括处理器设备,其可操作地耦合到存储器设备,用于运行程序代码以训练神经网络,该神经网络输入状态-动作对并分别针对一个或多个安全约束和奖励中的每一个输出相应的q函数。神经网络具有线性输出层和由特征映射函数表示的剩余非线性层。训练包括处理器设备通过根据离线强化算法基于数据集构建q函数来获得特征映射函数。训练包括处理器设备使用特征映射函数来调整奖励与一或多个安全约束之间的权重。在获得和调整期间,通过从q函数的期望值中减去不确定性来提供q函数的估计。不确定性是将状态-动作对映射到误差大小的函数。

4、根据本发明的另外的方面,提供了一种用于利用数据集进行离线强化学习的计算机实现的方法。该方法包括使用不确定性感知强化学习算法训练神经网络,该神经网络输入状态-动作对并分别针对一个或多个安全约束和奖励中的每一个输出相应的q函数。神经网络具有线性输出层和由特征映射函数表示的剩余非线性层。训练包括通过根据离线强化算法基于数据集构建q函数来获得特征映射函数。训练还包括使用特征映射函数调整奖励和一个或多个安全约束之间的权重,其中在获得和调整步骤期间,通过从q函数的期望值中减去不确定性来提供q函数的估计。不确定性是将状态-动作对映射到误差大小的函数。拉格朗日乘数用于调整奖励和一个或多个安全约束的权重。

5、这些和其他特征和优点将从以下结合附图阅读的其说明性实施例的详细描述中变得显而易见。

技术特征:1.一种用于利用数据集进行离线强化学习的计算机实现的方法,包括:

2.根据权利要求1所述的计算机实现的方法,其中所述不确定性仅取决于所述特征映射函数。

3.根据权利要求1所述的计算机实现的方法,其中,在所述获得步骤中,确定所述特征映射以降低所述q函数的不确定性并且与所述q函数具有线性关系。

4.根据权利要求1所述的计算机实现的方法,其中,所述剩余非线性层在所述神经网络内部。

5.根据权利要求1所述的计算机实现的方法,其中,所述训练步骤使用不确定性感知强化学习算法来训练所述神经网络。

6.根据权利要求1所述的计算机实现的方法,其中,所述方法由高级驾驶员辅助系统执行,所述高级驾驶员辅助系统使用经调整的权重来控制车辆系统。

7.根据权利要求1所述的计算机实现的方法,其中,所述方法由机器人执行,所述机器人使用经调整的权重来执行下一动作。

8.根据权利要求1所述的计算机实现的方法,其中,拉格朗日乘数用于调整所述奖励的权重。

9.根据权利要求1所述的计算机实现的方法,其中,拉格朗日乘数用于调整所述一个或多个安全约束的权重。

10.一种用于利用数据集进行离线强化学习的计算机程序产品,所述计算机程序产品包括非暂时性计算机可读存储介质,所述非暂时性计算机可读存储介质具有随其体现的程序指令,所述程序指令能够由计算机执行以使所述计算机执行方法,所述方法包括:

11.根据权利要求10所述的计算机程序产品,其中,所述不确定性仅取决于所述特征映射函数。

12.根据权利要求10所述的计算机程序产品,其中,在所述获得步骤中,确定所述特征映射以降低所述q函数的不确定性并且与所述q函数具有线性关系。

13.根据权利要求10所述的计算机程序产品,其中,所述剩余非线性层在所述神经网络内部。

14.根据权利要求10所述的计算机程序产品,其中,所述训练步骤使用不确定性感知强化学习算法来训练所述神经网络。

15.根据权利要求10所述的计算机程序产品,其中,所述方法由高级驾驶员辅助系统执行,所述高级驾驶员辅助系统使用经调整的权重来控制车辆系统。

16.根据权利要求10所述的计算机程序产品,其中,所述方法由机器人执行,所述机器人使用经调整的权重来执行下一动作。

17.根据权利要求10所述的计算机程序产品,其中,拉格朗日乘数用于调整所述奖励的权重。

18.根据权利要求10所述的计算机程序产品,其中,拉格朗日乘数用于调整所述一个或多个安全约束的权重。

19.一种用于利用数据集进行离线强化学习的计算机处理系统,包括:

20.根据权利要求19所述的计算机处理系统,其中,所述不确定性仅取决于所述特征映射函数。

21.根据权利要求19所述的计算机处理系统,其中,在所述获得步骤中,确定所述特征映射以降低所述q函数的不确定性并与所述q函数具有线性关系。

22.根据权利要求19所述的计算机处理系统,其中,所述剩余非线性层在所述神经网络内部。

23.根据权利要求19所述的计算机处理系统,其中,所述训练步骤使用不确定性感知强化学习算法来训练所述神经网络。

24.根据权利要求19所述的计算机处理系统,其中,所述方法由高级驾驶员辅助系统执行,所述高级驾驶员辅助系统使用经调整的权重来控制车辆系统。

25.一种用于利用数据集进行离线强化学习的计算机实现的方法,包括:

技术总结提供了一种用于利用数据集进行离线强化学习的计算机实现的方法。该方法包括训练神经网络,该神经网络输入状态‑动作对并分别针对一个或多个安全约束和奖励中的每一个输出相应的Q函数。神经网络具有线性输出层和由特征映射函数表示的剩余非线性层。训练包括通过根据离线强化算法基于数据集构建Q函数来获得特征映射函数。训练还包括使用特征映射函数调整奖励和一个或多个安全约束之间的权重,其中在获得和调整步骤期间,通过从Q函数的期望值中减去不确定性来提供Q函数的估计。不确定性是将状态‑动作对映射到误差大小的函数。技术研发人员:和地瞭良,恐神贵行受保护的技术使用者:国际商业机器公司技术研发日:技术公布日:2024/8/16本文地址:https://www.jishuxx.com/zhuanli/20240819/275628.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表