一种在隐私保护约束下分布式数据资源的联邦学习方法

- 国知局

- 2024-08-19 14:32:16

本发明涉及异构数据下的联邦学习,特别涉及一种在隐私保护约束下分布式数据资源的联邦学习方法、装置、计算机设备和存储介质。

背景技术:

1、现如今,基于机器学习的人工智能技术越来越得到人们的青睐,但其在使用时往往严重依赖于大量的训练数据;然而,在实际应用中,如在医疗健康领域中,数据往往分布在数百万甚至数十亿个个人或互联网设备上,并且将分布式数据收集到集中式存储设备中是昂贵和耗时的;此外,在医疗健康领域中,由于隐私问题或法律法规的限制,分散的数据是不允许被直接共享,例如,各大医院和争夺可能拥有大量宝贵的医疗数据,但由于隐私和安全问题,无法直接进行数据交换和集中处理;这种情况限制了医疗领域中人工智能技术的发展和应用,这就迫切地需要一种能够在保护数据隐私的前提下,充分利用分布式数据资源的解决方案。

2、联邦学习是一种分布式的机器学习范式,它允许多个客户端(如医疗机构)在隐私保护的前提下进行协作训练,并且只需要共享模型权重或梯度信息;联邦学习打破了在隐私保护约束下不同客户(例如地区和行业)之间的数据障碍,有效地解决了“数据孤岛”问题,具有重要的研究价值和实际应用意义;即使联邦学习目前受到广泛认可,但它目前仍然面临着诸多挑战;例如,客户端之间可能存在计算能力、存储容量、通信带宽等方面的差异,比如不同医院和诊所的计算能力、存储容量,通信带宽等方面存在差异;这将导致客户端往往不能采用相同的模型体系结构来进行训练;然而,当客户端拥有不同的模型结构时,简单的模型平均方法就不再适用;不同模型结构可能导致模型参数数量、层次结构以及模型类型的不同,从而使得简单的平均操作不再有效。

3、除了模型结构的差异,联邦学习还面临着数据分布不均匀的挑战;由于每个客户端(如医疗机构)的训练数据都是由他们自己生成或收集的,因此客户端之间的数据分布可能存在显著差异,即统计异质性,这种数据分布不均匀可能导致常见的非独立同分布数据问题;在非独立同分布数据的情况下,模型在不同客户端的表现可能会受到显著影响,表现为模型在某些数据上的性能较差,甚至出现收敛缓慢的情况;这种情况下,简单地将局部模型进行平均可能无法达到理想的效果。

4、因此,现阶段联邦学习在模型异构的场景下,联邦学习系统中非独立同分布数据对模型性能的影响较大,实际应用中难度较大。

技术实现思路

1、本发明实施例提供一种在隐私保护约束下分布式数据资源的联邦学习方法,可以解决现有技术中,存在的现阶段联邦学习在模型异构的场景下,联邦学习系统中非独立同分布数据对模型性能的影响较大的问题。

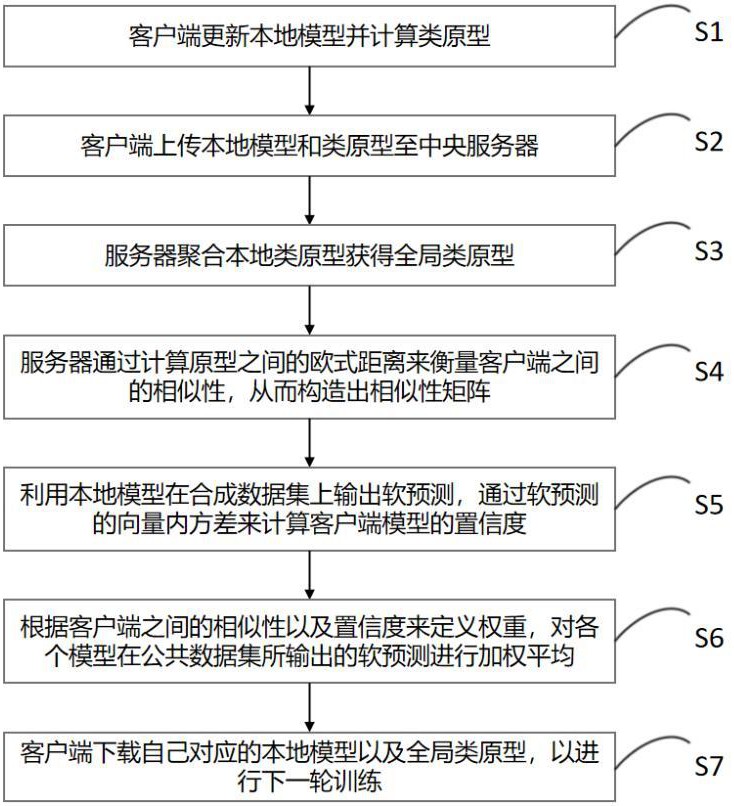

2、本发明实施例提供一种在隐私保护约束下分布式数据资源的联邦学习方法,包括以下步骤:

3、每个分布式客户端训练各自客户端内包含多个数据类型的本地私有数据集,得到各自客户端本地模型,并获取各自客户端本地模型每个数据类型的类原型,及对每个数据类型的类原型在服务器上进行加权聚合,获得全局类原型;

4、获取每个客户端本地模型每个数据类型的类原型与全局类原型的欧式距离,利用每个客户端原型之间的欧式距离,获得客户端之间的相似性;利用每个客户端本地模型在伪数据集上获取各自客户端软预测,根据每个客户端软预测的向量内方差,获得每个客户端本地模型的置信度;根据客户端之间的相似性和每个客户端本地模型的置信度,获得客户端之间的权重;

5、根据客户端之间的权重对每个客户端本地模型在公共数据集上输出的软预测进行加权平均,获得各个客户端的目标软预测集合,并通过知识蒸馏学习各个客户端的目标软预测集合内的知识。

6、优选地,所述获得全局类原型,包括:

7、客户端利用私有数据对本地模型进行训练,并更新模型参数利用其获取本地模型每个类别的类原型;

8、客户端将更新后的本地模型和类原型上传至中央服务器,服务器对每个类别的类原型进行加权聚合,获得全局类原型;其获取公式为:

9、

10、其中:表示来自客户端i的类k的原型;表示拥有类的客户端集合;表示类的全局原型;表示局部数据集的一个子集。

11、优选地,所述客户端原型之间的欧式距离的获取方式为:

12、

13、其中:表示来自客户端的类的局部原型和来自客户端的类的全局原型的距离度量。

14、优选地,所述获得客户端之间的相似性,包括:

15、首先判断两个客户端是否有公共类;

16、若有公共类,则对两个客户端进行相似性获取;若无公共类,则判断两个客户端的相似性为0;其获取方式为:

17、

18、其中:表示客户端与客户端之间的相似性系数;表示缩放超参数;表示客户端数量;表示客户端原型以及客户端原型之间的距离。

19、优选地,所述获得客户端本地模型的置信度,包括:

20、利用客户端本地模型在伪数据集上获取客户端软预测,根据客户端软预测的向量内方差获取客户端模型的置信度;则置信度获取方式为:

21、

22、其中:表示归一化之后的置信度权重;表示客户端软预测的向量内方差,为;表示客户端数量;l表示客户端。

23、优选地,所述客户端之间的权重的获取方式为:

24、

25、其中:表示客户端对于客户端的权重;表示客户端与客户端之间的相似性系数;表示归一化之后的置信度权重;和是超参数,且。

26、优选地,所述知识蒸馏,包括:

27、将全局生成器生成的伪数据输入到各个客户端模型,得到各个模型的分类软预测集合;

28、根据权重参数对软预测进行加权平均得到各个客户端的目标软预测集合;

29、通过最小化各个模型分类软预测与对应目标软预测的kl散度获取其他客户端的知识;其对应目标软预测的kl散度获取方式为:

30、

31、其中:n表示伪数据样本数;

32、的目标是让最小化分布和之间的距离。

33、本发明实施例还提供一种在隐私保护约束下分布式数据资源的联邦学习装置,包括:

34、原型模块,每个分布式客户端训练各自客户端内包含多个数据类型的本地私有数据集,得到各自客户端本地模型,并获取各自客户端本地模型每个数据类型的类原型,及对每个数据类型的类原型在服务器上进行加权聚合,获得全局类原型。

35、评估模块,用于获取每个客户端本地模型每个数据类型的类原型与全局类原型的欧式距离,利用每个客户端原型之间的欧式距离,获得客户端之间的相似性;利用每个客户端本地模型在伪数据集上获取各自客户端软预测,根据每个客户端软预测的向量内方差,获得每个客户端本地模型的置信度;根据客户端之间的相似性和每个客户端本地模型的置信度,获得客户端之间的权重。

36、学习模块,用于根据客户端之间的权重对每个客户端本地模型在公共数据集上输出的软预测进行加权平均,获得各个客户端的目标软预测集合,并通过知识蒸馏学习各个客户端的目标软预测集合内的知识。

37、本发明实施例还提供一种计算机设备,包括:存储器和处理器;

38、所述存储器,用于存储计算机程序;

39、所述处理器,用于执行所述存储器中存储的计算机程序时,实现如上所述的一种在隐私保护约束下分布式数据资源的联邦学习方法的步骤。

40、本发明实施例还提供一种计算机可读存储介质,其特征在于,用于存储计算机程序,所述计算机程序被处理器执行时实现如上所述的一种在隐私保护约束下分布式数据资源的联邦学习方法的步骤。

41、本发明实施例提供一种在隐私保护约束下分布式数据资源的联邦学习方法,与现有技术相比,其有益效果如下:

42、本发明将客户端本地模型量化为本地局部原型信息和全局原型信息,利用本地局部原型信息和全局原型信息衡量用户本地数据分布之间的相似性,以及用户本地模型对伪数据样本的置信度,并根据用户本地数据分布之间的相似性和置信度来获取客户端之间的权重,以利用权重参数促进具有相似数据分布的用户之间的高效互学习,降低在模型异构的场景下联邦学习的非独立同分布数据对模型性能的影响,解决了跨设备场景下的用户资源受限,提高了本地模型的鲁棒性和泛化能力,使其应用在医疗领域中能大大促进医疗机构之间的相互学习,从而促进医疗数据间的共享和协作。

43、而且,本发明是根据客户端之间的数据分布来衡量相似性,为客户端之间的相互学习提供了优良的基础。

44、并且,本发明利用客户端传输的原型信息作为标准去生成数据,构建知识蒸馏所需的辅助数据集,确保了在医疗健康场景下知识蒸馏所需的辅助数据集的隐私性和安全性。

本文地址:https://www.jishuxx.com/zhuanli/20240819/275545.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。