一种面向二对二飞行员博弈对抗的规则化策略构建方法

- 国知局

- 2024-09-19 14:38:10

本发明涉及二对二空战智能体的行为建模与仿真,具体涉及一种面向二对二飞行员博弈对抗的规则化策略构建方法。

背景技术:

1、空战是一种高度动态变化以争夺制空权的复杂对抗过程。空战中的行为决策,是在获取敌我双方的所处位置、海拔高度、飞行速度和运动姿态等态势信息的情况下,比较双方的优势情况,根据作战目的选择合理的机动动作进行攻击、迂回或是逃逸,直到作战任务结束或远离敌方飞机。空战中决策策略的优劣直接关系着空战的结果。二对二空战的决策需要同时考虑己方协作和对手的协作,因此难以被人类专家有效解决。

2、在空战决策中,专家系统决策法由于其具有更低的时间复杂度,决策过程更加快速、准确,满足空战决策的实时性要求,因此应用广泛。专家系统决策法可以认为是“知识库”和“推理机”的有机结合,其中知识库包含相关领域专家的专业知识,以数字、符号或其他数据形式进行存储。专家系统决策法简单易懂,在现实中具有较强的实用性;但当所遇到的情况不包含在知识库中时,专家系统决策就会失效。同时,专家系统也存在专家知识难以获取的问题:专家知识的缺少难以指导人类在实际空战中进行决策,更无法启发人类进行进一步的战术探索。

3、深度强化学习作为近年来人工智能中的热点技术,在多种策略性任务中均实现了优于人类专家的策略生成。深度强化学习通过构建深度神经网络来学习复杂的策略映射,能够生成高效且具有泛化能力的策略,使得智能体能够在未知环境中做出准确的决策。但由于引入了神经网络等黑盒模型,受制于网络层数多、参数意义不明确、空战决策影响因素多等情况,人类无法理解深度强化学习算法的策略依据,进而不肯将对应算法应用于昂贵的实际空战测试中。因此,对深度强化学习所探索得到的策略进行可解释化构建的需求也便日益增高。

4、针对二对二空战,需要进行决策方面的知识探索;同时为保证其应用价值,又需要构建可解释的策略。进行二对二空战决策时,专家系统面临着专家知识缺少导致的失效问题,而新兴的深度强化学习方法使用了黑盒模型,难以被人类所理解和信任,存在着落地应用困难的问题。

技术实现思路

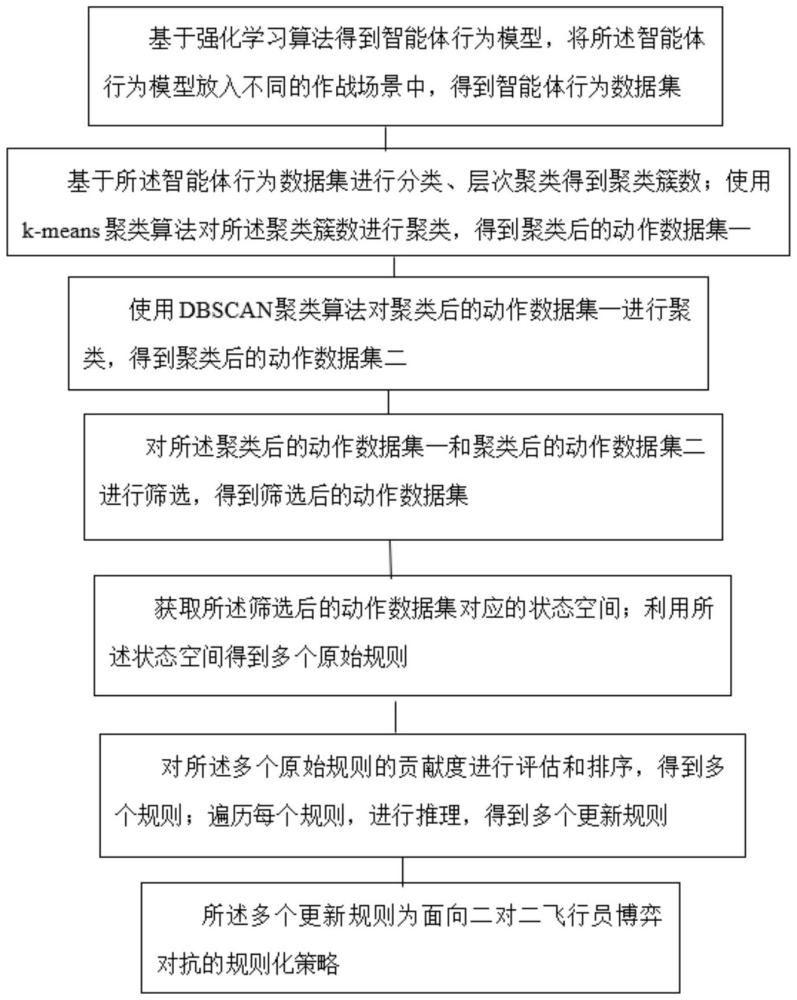

1、鉴于上述问题,本发明提供了一种面向二对二飞行员博弈对抗的规则化策略构建方法,通过聚类分析从深度强化学习算法训成的智能体行为数据中提取构建智能体的策略逻辑,将其进行规则化,并且采取shapley值方法分析所生成规则的优劣,形成一套可读性强、可解释的基于规则的策略,为深度强化学习在空战决策中的实际应用提供技术支撑,同时也为空战智能体的行为建模提供了一种新的思路,针对二对二空战智能体行为策略建模困难、专业知识难以获取、行为模型应用困难的现状和技术瓶颈。

2、本发明提供了一种面向二对二飞行员博弈对抗的规则化策略构建方法,包括:

3、步骤s1、确定双方战机的状态空间和动作空间;基于所述状态空间和动作空间建立初始智能体行为模型;所述双方战机包括:我方长机和我方僚机,敌方长机和敌方僚机;

4、基于强化学习算法对所述初始智能体行为模型进行训练,得到智能体行为模型;

5、将所述智能体行为模型放入不同的作战场景中,得到智能体行为数据集;所述智能体行为数据集为智能体的状态和动作数据集;

6、优选的,步骤s1所述获得智能体行为数据集具体步骤包括:

7、确定二对二空战场景;确定我方长机、我方僚机、敌方长机和敌方僚机;

8、根据实际经验选择我方长机和/或僚机进入角、敌方长机和/或僚机偏离角和我方长机和/或僚机方位角作为状态空间;选择我方和敌方长机和僚机的拉起、盘旋等经典机动动作以及是否发射武器作为动作空间;

9、基于所述状态空间和动作空间建立初始智能体行为模型;

10、基于所述状态空间和强化学习算法对所述初始智能体行为模型进行训练,直至算法收敛,得到智能体行为模型;

11、将所述智能体行为模型放入不同的二对二空战作战场景中,得到智能体的状态和动作数据集;如图2;

12、示例性的,步骤s1所述获得智能体的状态和动作数据集的具体步骤包括:

13、步骤101、获取典型空战二对二场景;基于所述典型空战二对二场景以及工程经验确定多个状态空间;所述典型空战二对二场景,例如超视距侦察场景、超视距协同作战场景或视距内进攻占位场景;

14、具体地,所述状态空间共20维,如表1所示;

15、进一步的,所述每维状态空间中包括两个与敌方长机或僚机相关的状态数据;

16、表1状态空间的状态数据

17、

18、

19、其中,我机包括我方长机和/或僚机;

20、进一步的,所述我方长机和/或僚机进入角(angle of attack,aoa)和敌方长机和/或僚机偏离角(angle of deflection,aod)的表达式为:

21、

22、aoa=acos(cosfai)

23、aod=acos(coslan)

24、其中,fai为我方长机或僚机进入角;state表示我方长机或僚机的状态数据;vx为我方长机或僚机在北天东坐标系下的x向速度,vy为我方长机或僚机在北天东坐标系下y向速度,vz为我方长机或僚机在北天东坐标系下z向速度;δx为机体坐标系下我方长机或僚机与敌机在x轴上的距离,δy为机体坐标系下我方长机或僚机与敌机在y轴上的距离,δz为机体坐标系下我方长机或僚机与敌机在z轴上的距离,vxq为气流轴下机体的速度;distance为我方长机或僚机与敌方长机或僚机的相对距离;lan为敌方长机或僚机偏离角,target表示敌方长机或僚机的状态数据;aoa为我方长机或僚机进入角,aod为我方长机或僚机偏离角。

25、进一步的,在北天东坐标系下,我方长机和/或僚机与敌方长机和/或僚机的各项相对距离:

26、

27、其中,δx为机体坐标系下我方长机或僚机与敌方长机或僚机在x轴上的距离,δy为机体坐标系下我方长机或僚机与敌方长机或僚机在y轴上的距离,δz为机体坐标系下我方长机或僚机与敌方长机或僚机在z轴上的距离,target表示敌方长机或僚机的状态数据,state表示我方长机或僚机的状态数据。

28、步骤102、选取机动动作和是否发射导弹作为动作空间;

29、具体地,所述动作空间共2维;

30、所述机动动作包括:追踪、急拉起、左/右拉起、左/右急转、截击、斜筋斗、高速/低速摇摇、半滚倒转、急盘旋、俯冲拉起、增速转弯、斜俯冲增速、平飞增速、急下降和远距截击;

31、步骤103、基于状态空间和动作空间建立原始智能体行为模型;基于深度强化学习算法对所述原始智能体行为模型进行训练,得到智能体行为模型;

32、步骤104、将所述智能体行为模型,放入不同的二对二空战的作战场景中,获得多组智能体的状态-动作数据,建立智能体状态-动作数据集;

33、更进一步,所述深度强化学习算法为适用于离散动作空间下的深度强化学习算法;

34、更进一步,所述深度强化学习算法为深度q网络dqn算法、彩虹rainbow算法或柔性演员-评论家sac算法。

35、步骤s2、基于智能体行为数据集得到多个动作数据<s,a>,对所述多个动作数据作分类、聚类得到聚类后的动作数据集和聚类簇数;计算聚类后的动作数据集的轮廓系数,并分析,选取轮廓系数大的动作数据作为分析后的动作数据;对所述分析后的动作数据进行筛选,得到筛选后的动作数据集;

36、优选的,步骤s2所述得到筛选后的动作数据的具体步骤包括:

37、步骤201、基于智能体行为数据集得到多个动作数据<s,a>;其中s为17维状态空间,a为2维动作空间,所述2维动作空间包括机动动作(18种)和是否发射导弹;

38、步骤202、对多个动作数据进行分类,构建分类后的动作数据集;

39、步骤203、基于hopkins算法判断所述分类后的动作数据集是否具有聚类意义,得到判断后的动作数据集;

40、对判断后的动作数据集进行层次聚类,得到判断后的动作数据集的的轮廓系数,基于所述轮廓系数得到聚类簇数;所述轮廓系数越大对应的聚类效果越好;

41、可以理解的是,所述判断后的动作数据集为一个或多个聚类簇;所述聚类意义为所述分类后的动作数据集的聚类倾向性,若所述分类后的动作数据集中多个动作数据点属于一个聚类簇,则表示没有聚类意义,若所述分类后的动作数据集中多个动作数据点分属于多个聚类簇,则表示有聚类意义;

42、步骤204、确定k-means聚类算法的优化目标;基于优化目标和聚类簇数对判断后的动作数据集进行聚类,得到k-mean聚类后的动作数据集;

43、步骤将k-mean聚类后的动作数据集进行dbscan聚类,得到dbscan聚类后的动作数据集;

44、步骤205、将k-mean聚类后的动作数据集和dbscan聚类后的动作数据集分别经过t-sne降维进行可视化,获得k-mean聚类可视化动作数据和dbscan可视化动作数据集;

45、步骤206、获取所述k-mean聚类可视化动作数据和dbscan可视化动作数据集对应的聚类簇紧密度,选取聚类簇紧密度高的可视化动作数据对应的聚类后的动作数据集作为筛选后的动作数据集。

46、进一步的,步骤204所述k-means聚类算法的优化目标表达式为:

47、

48、其中,sse为k-means聚类算法的优化目标,ci是第i个聚类簇,μi是第i个聚类簇的中心点,ci,x是第i个聚类簇中的数据点,i=1,2,3…k,k为聚类簇个数。

49、进一步的,所述层次聚类为凝聚式层次聚类;

50、进一步的,得到判断后的动作数据集的的轮廓系数具体步骤包括:

51、步骤a.计算判断后的动作数据集中聚簇类动作数据点ci,b与同簇其他动作数据点的同簇平均距离ai,b;所述判断后的动作数据集中包括多个聚簇类,每个聚类簇包括多个动作数据点;

52、步骤b.分别计算聚簇类动作数据点ci,b与不同簇中所有动作数据点的距离,得到多个不同簇距离,选择多个不同簇距离中的最小值作为不同簇平均距离bi,b;

53、步骤c.基于所述同簇平均距离ai,b和不同簇平均距离bi,b计算聚簇类动作数据点ci,b轮廓系数si;

54、

55、步骤d.遍历判断后的动作数据集中每个聚类簇的每个动作数据点,重复步骤a-c,得到多个聚类簇动作数据点轮廓系数,将多个聚类簇动作数据点轮廓系数取平均值,将所述平均值作为判断后的动作数据集的的轮廓系数。

56、步骤s3、基于所述筛选后的动作数据集构成对应的状态空间;

57、利用所述状态空间结合所述筛选后的动作数据集得到多个原始规则;

58、对所述多个原始规则的贡献度进行评估,排序,得到多个规则;

59、遍历每个规则,进行推理,得到多个更新规则;所述多个更新规则为面向二对二飞行员博弈对抗的规则化策略。优选的,得到面向二对二飞行员博弈对抗的规则化策略的具体步骤包括:

60、步骤31、获取所述筛选后的动作数据集中每个筛选后的动作数据对应的状态向量,得到多个状态向量;所述多个状态向量构成对应的状态空间;

61、步骤32、提取所述状态空间的上下界;将所述状态空间的上下界结合所述筛选后的动作数据集得到多个原始规则;

62、步骤33、获取所述多个原始规则的贡献度及其对应的沙普利shapley值;所述贡献率为对胜率贡献为正;

63、步骤34、基于所述对应的沙普利shapley值对所述多个原始规则的贡献度进行评估,筛选出对胜率贡献为负的有害规则,并去除,将剩余规则按照对应的贡献度进行排序,得到多个规则;

64、步骤35、遍历每个规则,所述每个规则按照沙普利值越高,则优先度越高的规则进行推理,得到多个更新规则;所述多个更新规则为面向二对二飞行员博弈对抗的规则化策略。

65、进一步的,提取所述状态空间的上下界具体步骤包括:

66、获取所述筛选后的动作数据集中数据样本与所述动作数据集中数据样本的占比;依据所述占比对所述状态空间的上下界进行提取;比如说动作数据集中一共有100个样本,筛选后的动作数据集有10个样本,占比就是10/100;

67、进一步的,提取所述状态空间的上下界具体步骤还包括:根据所述占比构成离散的概率分布,基于所述离散的分布对所述状态空间进行随机提取上下界;

68、本发明技术方案中使用沙普利shapley值方法,屏蔽某一条规则并分析胜率变化,进而得到每条规则对整体胜率的贡献度,删去贡献为负的有害规则、降低贡献有限的规则的优先度,形成最终的空战智能体规则化行为策略。

69、优选的,所述多个原始规则对应的沙普利shapley值,表达式为:

70、

71、其中,表示第d条原始规则的胜率的沙普利shapley值,f(·)表示胜率值,表示不包含第d条原始规则的规则集合,g∪{d}表示规则集合中加入第d条原始规则,n表示总原始规则数。

72、本发明技术方案中将深度强化学习智能体行为数据作为领域专家、采用聚类和shapley值的方法将专家行为策略进行规则化的方法,既通过智能算法的手段解决了二对二空战决策专家知识难获取的问题,同时由于聚类算法和shapley值方法均为可解释算法且最终能够生成按if-then格式的行为策略规则,该方法也解决了信任度问题,提供了能够让人类理解和接受的专家策略知识,为深度强化学习算法在二对二空战实际应用中落地提供了有力的技术支撑。

73、与现有技术相比,本发明至少具有现如下有益效果:

74、(1)本发明基于深度强化学习算法生成专家数据,解决了传统专家系统决策方法难以获取专家知识的问题,同时方法全流程可解释,并最终能够形成可读性强、规范化的文本规则,能够被人类理解和接受,为深度强化学习等智能方法在空战领域的后续落地提供了有力的技术支撑;

75、(2)本发明采取了多种聚类方法并进行结合利用,可以有效解决专家数据形状分布不明确导致的聚类算法失效问题,同时免去了基于划分的聚类算法在不预先知道规则条数进行分类的调参困难问题;在进行k-means聚类之前进行层次聚类,通过轮廓系数评估最佳的聚类簇数;采用dbscan算法避免数据为非球状分布导致层次聚类和k-means聚类的算法失效;通过t-sne将聚类结果降维,既能够直观观察聚类结果,也能对聚类的效果进行评估;

76、(3)本发明提出了使用shapley值方法对所构建的规则进行评估,通过实际的仿真循环测试得出每一条规则对于空战对局取胜的贡献程度,不断迭代即可得到排除了有害规则且规则按贡献度排布的最终规则,为规则的评估选取和有效利用提供了新的思路。

本文地址:https://www.jishuxx.com/zhuanli/20240919/299286.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表