三元组网络的多视图特征融合三维模型分类方法

- 国知局

- 2024-10-09 15:44:30

:本发明涉及一种三元组网络的多视图特征融合三维模型分类方法,该方法在三维模型分类领域有着很好的应用。

背景技术

0、背景技术:

1、近年来,随着计算机视觉和三维几何建模工具的快速发展,可获取的三维模型数据呈指数级上升,其多样性与复杂度也不断提升。三维模型可以实现有效的表达物体的形状信息,在自动驾驶、遥感、虚拟现实、机械制造等领域具有广泛的应用,因此如何快速并准确识别三维模型以及实现高效的管理和使用成为了计算机视觉领域的一个重要研究方向。随着计算机的发展和计算能力的提高以及大量三维模型数据的出现推动了基于深度学习的三维模型分类的快速发展,基于人工特征和常见分类器的传统三维模型分类方法具有难以客观并合理地获取模型深层特征的缺点,使得其渐渐被深度学习方法所替代。目前,cnn呈现出爆炸式发展,使得卷积神经网络在图像识别领域取得了重大突破,这也为三维模型的有效分类提供了一个新的途径。

2、目前基于深度学习的三维模型分类方法分为基于点云、基于体素以及基于视图的分类方法,其中基于视图的分类方法是将三维模型投影为二维视图集合,然后利用深度学习的方法提取二维视图的特征,最终完成模型分类。对于二维视图数据维度较低且带标注的图像数据集相当丰富的特点,cnn可以实现更好的拟合,因此基于视图的分类方法具有较好的分类效果,可行性较高。但单视图所包含模型的信息较少,不能很好地表征三维模型。而多视图的三维模型分类方法会忽视多视图之间的互补性和相关性。针对上述问题,本发明首先利用drsn(deep residual shrinkage network)提取三维模型二维视图的视图特征,并将视图特征、边缘纹理特征e-lbp和形状特征描述符进行融合得到二维视图融合特征;然后利用香农熵对视图显著性进行排序;最后通过基于lstm的三元组网络进行多视图特征融合,引入度量学习并提出了一种新颖的中心锚困难三元组损失,并联合交叉熵损失来优化多视图特征融合网络,减小同类样本、增大异类样本在特征空间上的距离,加强网络对三维模型区分性特征的学习,最终完成三维模型分类。

技术实现思路

0、技术实现要素:

1、为了解决三维模型分类领域中存在的问题,本发明提出了一种三元组网络的多视图特征融合三维模型分类方法。

2、为此,本发明提供了以下技术方案。

3、1.一种三元组网络的多视图特征融合三维模型分类方法,其特征在于,该方法包括以下步骤:

4、步骤1:对三维模型数据集进行数据预处理,投影得到一组表征三维模型的二维视图集;

5、步骤2:利用形状特征描述符描述二维视图,利用d1形状特征描述符来描述二维视图中心点到边界随机点的距离,利用d2形状特征描述符来描述二维视图中两个边界点之间的距离,利用d3形状特征描述符来描述二维视图中三个边界点所构成面积的平方根;

6、步骤3:提取二维视图的边缘纹理特征,利用e-lbp特征向量表示二维视图边缘纹理信息,并将e-lbp特征向量与d1、d2、d3形状特征描述符进行拼接得到整体形状特征gsf(global shape features);

7、步骤4:将三维模型集划分为三维模型训练集和三维模型测试集,从三维模型训练集中提取三维模型的二维视图和gsf作为训练数据,从三维模型测试集中提取三维模型的二维视图和gsf作为测试数据;

8、步骤5:设计视图特征提取网络drsn,使用训练数据来优化drsn;

9、步骤6:从三维模型训练集中选取锚定样本、正样本以及负样本构成三元组训练数据;

10、步骤7:设计基于lstm的三元组多视图特征融合网络以及中心锚困难三元组损失lcah,利用三元组训练数据来优化基于lstm的三元组多视图特征融合网络,将测试数据输入到优化后的基于lstm的三元组多视图特征融合网络提取多视图融合特征,并输入到softmax分类器进行分类;

11、2.根据权利要求1所述的一种三元组网络的多视图特征融合三维模型分类方法,其特征在于,所述步骤1中,对三维模型数据集进行数据预处理,具体步骤为:

12、步骤1-1构造三维模型m的渲染背景,设置6个不同角度的点光源;

13、步骤1-2在三维模型m中心斜上方与水平面夹角为30°的圆周上放置虚拟相机,围绕三维模型m旋转一周,每隔60°生成一幅二维视图;

14、步骤1-3利用获取的二维视图集v(m)={vi,1≤i≤n}来表征三维模型m,其中n=6为三维模型投影视图数目,vi代表m的第i个二维视图;

15、3.根据权利要求1所述的一种三元组网络的多视图特征融合三维模型分类方法,其特征在于,所述步骤2中,利用d1、d2、d3形状特征描述符来描述二维视图,具体步骤为:

16、步骤2-1对二维视图边缘进行采样,将所得到的采样点收集到集合pv={(x1,y1),…,(xi,yi),…,(xn,yn)}中,其中(xi,yi)是随机采样点的坐标;

17、步骤2-2从pv中随机选取n个采样点,并收集到pv1={ai1,…,aik,…,ain}中,二维视图的d1形状特征描述符为{d1_1,…d1_i,…,d1_num},d1_i的计算如下所示:

18、d1_i=|{p|dist(p,o)∈(numsize*(i-1),numsize*i),p∈pv1}|

19、其中,numsize=max({dist(p,o)|p∈pv1})/n,dist(·)代表两个采样点之间的欧氏距离,o是二维视图的质心;

20、步骤2-3从pv中随机选取n个采样点对,并收集到pv2={(ai1,bi1),…,(aik,bik),…,(ain,bin)}中,二维视图的d2形状特征描述符为{d2_1,…,d2_i,…,d2_num},d2_i的计算如下所示:

21、d2_i=|{(aik,bik)|dist(aik,bik)∈(numsize*(i-1),numsize*i),(aik,bik)∈pv2}|

22、其中,numsize=max({dist(aik,bik)|(aik,bik)∈pv2})/n;

23、步骤2-4从pv中随机选取n个采样点的三元组,并收集到pv3={(ai1,bi1,ci1),…,(aik,bik,cik),…,(ain,bin,cin)}中,二维视图的d3形状特征描述符为{d3_1,…,d3_i,…,d3_num},d3_i的计算如下所示:

24、d3_i=|{(aik,bik,cik)|heron(aik,bik,cik)∈(numsize*(i-1),numsize*i),(aik,bik,cik)∈pv3}|

25、其中,numsize=max({heron(aik,bik,cik)|(aik,bik,cik)∈pv3})/n,heron(aik,bik,cik)为aik、bik、cik三个采样点所构成的三角形面积,计算如下所示:

26、

27、其中,l1=dist(aik,bik),l2=dist(aik,cik),l3=dist(bik,cik);

28、步骤2-5将d1_i、d2_i、d3_i(i=1,2,…,num)串联形成二维形状特征描述符d;

29、4.根据权利要求1所述的一种三元组网络的多视图特征融合三维模型分类方法,其特征在于,所述步骤3中,提取二维视图的边缘纹理特征e-lbp,将e-lbp和d1、d2、d3形状特征描述符拼接得到整体形状特征gsf,具体步骤为:

30、步骤3-1对二维视图边缘进行采样,将所得到的采样点收集到集合ev={(p1,…,pi,…,pn}中,其中pi是二维视图边缘的随机采样点,n是采样点数;

31、步骤3-2二维视图的边缘纹理特征e-lbp描述符为{e_1,…e_i,…,e_num},e_i的计算如下所示:

32、e_i=|{pc|lbpx,r(pc)∈(numsize*(i-1),numsize*i),pc∈ev}|

33、其中,numsize=max(lbpx,r(pc)|pc∈ev})/n,lbpx,r(pc)表示采样点pc的边缘纹理特征,计算如下所示:

34、

35、其中,x表示以边缘采样点pc为中心,其相邻的像素点总数,r表示相邻像素点与边缘采样点pc的距离,pi表示边缘采样点pc周边的第i个像素点,avg(pi)表示像素点pi及其周围8个像素点的灰度值的均值,μ(avg(pi)-pc)表示一种阈值编码,计算如下所示:

36、

37、步骤3-3将e-lbp特征向量和步骤2-5得到的d拼接得到gsf;

38、5.根据权利要求1所述的一种三元组网络的多视图特征融合三维模型分类方法,其特征在于,所述步骤4中,从三维模型集获取训练数据和测试数据,具体步骤为:

39、步骤4-1将三维模型集划分为三维模型训练集和三维模型测试集;

40、步骤4-2利用步骤1、步骤2、步骤3,从三维模型训练集中提取三维模型的二维视图集和整体形状特征gsf作为训练数据;

41、步骤4-3利用步骤1、步骤2、步骤3,从三维模型测试集中提取三维模型的二维视图集和整体形状特征gsf作为测试数据;

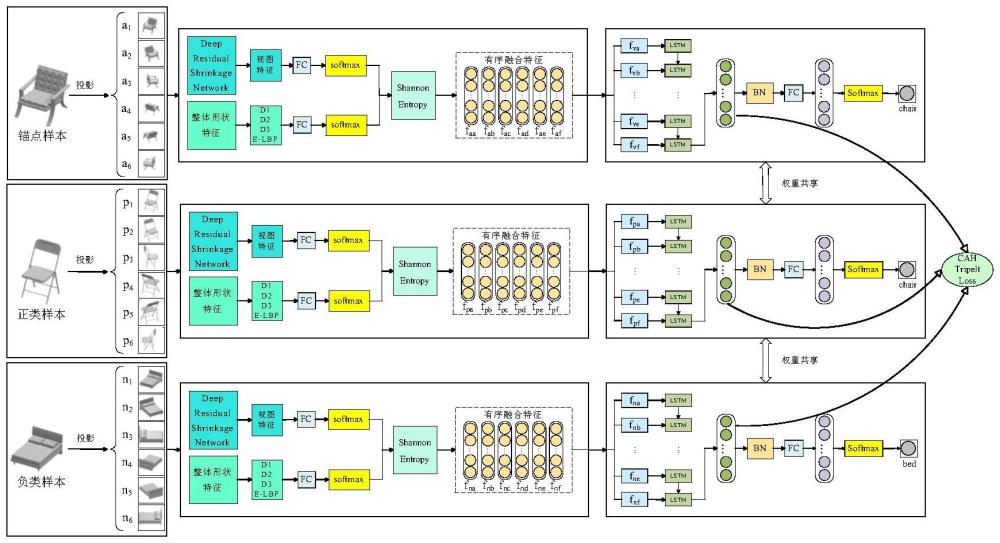

42、6.根据权利要求1所述的一种三元组网络的多视图特征融合三维模型分类方法,其特征在于,所述步骤5中,设计视图特征提取网络drsn,使用训练数据来优化drsn,具体步骤为:

43、步骤5-1视图特征提取网络drsn包括:输入层、8个基本残差收缩模块、批归一化层、全局池化以及全连接层,其中,基本残差收缩模块由2个卷积层、2个批归一化、1个relu激活函数、1个恒等映射以及1个阈值学习子网络组成;

44、步骤5-2将训练数据的二维视图输入到drsn中提取视图特征,并与整体形状特征gsf拼接得到二维视图融合特征f=[fv1,fv2,…,fvi,…,fvn],其中,fvi表示二维视图vi的特征向量;

45、步骤5-3将二维视图融合特征f输入到全连接层,利用交叉熵损失函数来优化drsn网络;

46、7.根据权利要求1所述的一种三元组网络的多视图特征融合三维模型分类方法,其特征在于,所述步骤6中,从三维模型训练集中选取锚定样本、正样本以及负样本构成三元组训练数据,具体步骤为:

47、步骤6-1从三维模型训练集中确定一个三维模型作为锚点样本,从三维模型训练集中选择一个与锚点样本类别相同的三维模型作为正样本;

48、步骤6-2从三维模型训练集中选择一个与锚点样本类别不同的三维模型作为负样本;

49、步骤6-3利用锚点样本、正样本和负样本的6个二维视图及其整体形状特征gsf作为三元组训练数据;

50、8.根据权利要求1所述的一种三元组网络的多视图特征融合三维模型分类方法,其特征在于,所述步骤7中,设计基于lstm的三元组多视图特征融合网络以及中心锚困难三元组损失lcah,利用三元组训练数据来优化基于lstm的三元组多视图特征融合网络,将测试数据输入到优化后的基于lstm的三元组多视图特征融合网络提取多视图融合特征,并输入到softmax分类器进行分类,具体步骤为:

51、步骤7-1以lstm为基础网络构成三路并行的三元组多视图特征融合网络,如图1所示,将三元组训练数据输入到三路并行的drsn中提取视图融合特征,利用香农熵对视图显著性由高到低进行排序,并输入到基于lstm的三元组多视图特征融合网络中完成多视图特征融合;

52、步骤7-2设计中心锚困难三元组损失lcah,将一个训练批次中的三元组训练数据按锚点类别进行分组,得到锚点类别相同的一组三元组训练数据如图2所示,中心锚困难三元组损失lcah计算如下:

53、

54、其中,n为一个训练批次中的三元组训练数据按锚点类别进行分组获得的组数,m为预定义的距离常量,ci+和ci-分别为第i组三元组训练数据中最难正样本与最难负样本到中心锚点的欧式距离,ci+和ci-计算如下所示:

55、

56、ci-=min{d(ni0,cia),...,d(nig,cia),...,d(nih,cia)}

57、其中,cia为第i组三元组训练数据的中心锚点,sij为第i组三元组训练数据中与中心锚点同类的样本,nig为第i组三元组训练数据中与中心锚点异类的样本,k和h分别为第i组三元组训练数据中与中心锚点类别相同和类别不同的样本数量,d(sij,cia)表示两个样本特征向量之间的欧氏距离,计算如下所示:

58、

59、步骤7-3利用中心锚困难三元组损失lcah联合交叉熵损失函数lcel来优化基于lstm的三元组多视图特征融合网络,总损失l计算如下所示:

60、l=λlcah+lcel

61、其中,λ是一个参数,lcel表示交叉熵损失函数,其计算如下所示:

62、

63、其中,n表示样本数,c表示类别数,pij表示第i个样本属于类别j的概率,yij∈{0,1},表示one-hot编码;

64、步骤7-4将三维模型m的二维视图集v(m)输入到优化后的drsn中提取三维模型m的视图特征fm,与整体形状特征gsf拼接得到融合特征f=[fv1,fv2,…,fvi,…,fvn],其中fvi表示二维视图vi的融合特征向量;

65、步骤7-5将三维模型m的视图特征fm与整体形状特征gsf分别输入到全连接层和softmax,计算各个二维视图的视图特征和整体形状特征在三维模型类别下的概率分布pv和pgsf,并加权计算总概率分布p,如下所示:

66、p=αpv+βpgsf

67、其中,pv表示二维视图的视图特征在三维模型类别下的概率分布,pgsf表示二维视图的整体形状特征在三维模型类别下的概率分布,α和β分别为参数,p如下所示:

68、

69、其中,n表示三维模型的二维视图个数,c表示三维模型类别数,pi,j表示二维视图vi属于类别j的概率;

70、步骤7-6三维模型m的二维视图集v(m)的香农熵为h={hi,1≤i≤6},其中hi表示二维视图vi的香农熵,hi计算如下所示:

71、

72、香农熵越小,说明softmax分类器的不确定性越小,模型分类结果越准确,该视图能更好地表征三维模型,即视图显著性越高;

73、步骤7-7根据香农熵计算结果对视图融合特征进行排序,并进行拼接,最终得到三维模型m的融合特征f’=[fva,fvb,fvc,fvd,fve,fvg];

74、步骤7-8将融合特征f’输入到优化后的基于lstm的三元组多视图特征融合网络中得到三维模型多视图融合特征f”;

75、步骤7-9将三维模型多视图融合特征f”输入到全连接层得到代表性特征l={fj,0≤j≤c-1},其中c为三维模型类别数,然后通过softmax分类器得到多分类概率分布s=(p(0|m),p(1|m),...,p(c-1|m)),p(j|m)表示模型m在类别j下出现的概率,计算过程如下所示:

76、

77、选取概率值最大的作为模型m的预测类别,选取过程如下:

78、

79、有益效果:

80、本发明是一种三元组网络的多视图特征融合三维模型分类方法。

81、1.本发明基于drsn设计空间实现三维模型二维视图的特征提取,drsn是resnet的一种改进版本,实际上是resnet、软阈值函数、注意力机制的集成,其优势是通过注意力机制注意到视图重要特征,将他们保留下来,对于不重要的特征通过软阈值函数将其置为零,从而提高深度神经网络在复杂数据上的特征学习效果。

82、2.二维视图只能表示模型的部分信息,难以捕捉三维模型的整体形状信息,本发明提出了形状特征描述符d1、d2、d3和边缘纹理特征e-lbp来弥补视图特征的不足,在分类过程中得到三维模型的更多的全局特征信息。

83、3.本发明采用了三元组网络的多视图特征融合三维模型分类方法,可以更好地利用三维模型投影视图之间的互补信息和相关信息。联合中心锚困难三元组损失和交叉熵损失来优化网络参数,通过中心锚困难三元组损失可以使同类别样本之间的距离尽可能小,不同类别样本之间的距离尽可能大,帮助网络学习到更具区分度的特征表示,从而提高三维模型的分类效果。

84、4.为了更好地利用三维模型的二维投影视图之间的相关信息,本发明提出了基于香农熵的显著性视图排序方法。由于lstm的时序性特点,先输入lstm的视图对多视图特征融合结果具有较大的影响,本发明利用香农熵对投影视图按照显著性由高到低排序,并将排序好的视图输入到基于lstm的三元组多视图特征融合网络中,使得基于lstm的三元组多视图特征融合网络能够更好地挖掘视图之间的上下文信息,提高三维模型分类效果。

85、5.本发明以公开的三维模型数据集modelnet10为基础,验证本发明所提出的方法,结果表明,本发明具有较高的准确性。

本文地址:https://www.jishuxx.com/zhuanli/20240929/309855.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表