一种基于从非完美示例中学习的跳频干扰资源分配方法

- 国知局

- 2024-10-15 09:28:23

本公开涉及无线通信,尤其涉及一种基于从非完美示例中学习的跳频干扰资源分配方法。

背景技术:

1、在无线通信技术领域,无线传感器网络广泛应用于军事通信领域中,随着扩频通信技术的发展,跳频扩频(frequency hopping spread spectrum,fhss)通信成为了提升无线传感器网络抗干扰能力的重要手段。而作为干扰方,通常采用部分频带噪声干扰(partial-band noisejamming,pbnj)的方式来降低跳频通信系统的使用效能,例如,可通过合理地设置多个不重叠的干扰频带来提升干扰资源的利用率,扩大干扰频段,以增加覆盖不同用户信道的可能性,而对于跳频扩频通信的干扰资源分配本质上是组合优化问题。

2、相关技术中,但随着人工智能的快速发展,涌现出了基于深度学习的方法来解决组合优化问题,例如,可将深度强化学习技术应用于干扰功率分配或干扰链路选择的智能优化中等。

3、关于上述技术方案,发明人发现至少存在如下一些技术问题:尽管深度强化学习技术已经被广泛用于解决组合优化问题,但这需要严重依赖于人为设计的精细的奖励函数,即对于不同任务的不同追求目标需要进行针对性地设计奖励特征,这都需要专业的领域知识作为支撑,还需要通过大量的重复实验才能找到合适的奖励函数,极为耗费资源。

技术实现思路

1、本公开实施例的目的在于提供一种基于从非完美示例中学习的跳频干扰资源分配方法,可以引导策略在稀疏奖励环境下正向优化,无需人为设计精细的奖励函数,节省资源耗费。

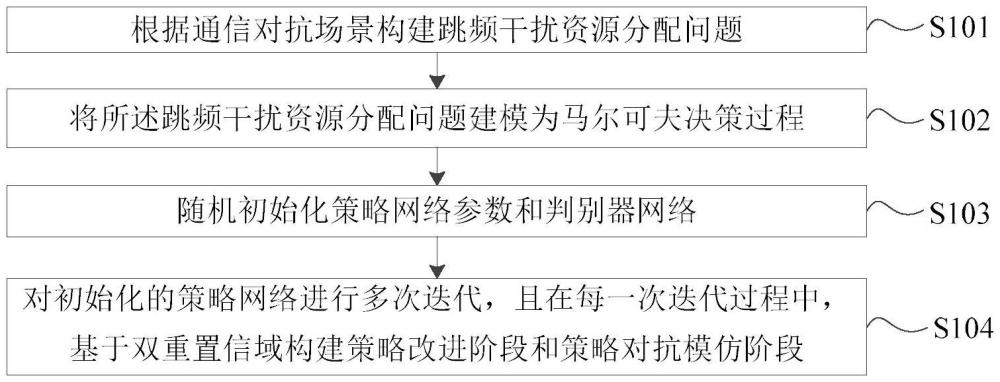

2、根据本公开实施例,提供一种基于从非完美示例中学习的跳频干扰资源分配方法,包括:

3、根据通信对抗场景构建跳频干扰资源分配问题;

4、将所述跳频干扰资源分配问题建模为马尔可夫决策过程;

5、随机初始化策略网络参数和判别器网络;

6、对初始化的策略网络进行多次迭代,且在每一次迭代过程中,基于双重置信域构建策略改进阶段和策略对抗模仿阶段;

7、其中,在所述策略改进阶段,基于trpo算法对当前迭代中的初始分配策略进行优化,得到中间分配策略;

8、在所述策略对抗模仿阶段,利用示例数据和当前迭代中初始分配策略的交互数据训练所述判别器网络以优化所述中间分配策略,得到最终分配策略。

9、本公开提供的技术方案可以包括以下有益效果:

10、本公开的实施例中,通过基于从非完美示例中学习的跳频干扰资源分配方法,一方面,将对抗跳频通信的部分频带噪声干扰中所涉及的干扰资源分配问题建模为马尔科夫决策过程,以让策略神经网络为各个干扰节点按时序决策干扰方案的方式构建了组合优化中的动力学转移过程;另一方面,对初始化的策略网络进行多次迭代,且在每一次策略迭代过程中,基于双重置信域构建策略改进阶段和策略对抗模仿阶段,其中,在策略改进阶段中使用trpo算法对当前迭代中的初始分配策略进行优化,以保证算法的单调稳健优化,得到策略改进阶段优化后的中间分配策略,进一步地,在策略对抗模仿阶段利用示例数据和当前迭代中初始分配策略的交互数据训练判别器网络以对中间分配策略进行优化,让策略在置信域内模仿示例数据的轨迹,引导策略在稀疏奖励环境下正向优化,无需人为设计精细的奖励函数,节省资源耗费。

11、应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开。

技术特征:1.一种基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,包括:

2.根据权利要求1所述的基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,所述基于trpo算法对当前迭代中的初始分配策略进行优化,包括以下步骤:

3.根据权利要求2所述的基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,所述目标函数的计算公式为:

4.根据权利要求1所述的基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,所述利用示例数据和当前迭代中初始分配策略的交互数据训练所述判别器网络以优化所述中间分配策略,包括以下步骤:

5.根据权利要求4所述的基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,在训练所述判别器网络时,采用二进制交叉熵损失计算所述判别器网络的损失函数,将采样得到的数据与所述判别器网络的损失函数相结合训练所述判别器网络。

6.根据权利要求5所述的基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,所述判别器网络的损失函数可表示为:

7.根据权利要求4所述的基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,在所述策略对抗模仿阶段,设定从所述示例策略采样的动作比从初始分配策略中采样的动作具有优势值,所述优势值满足:

8.根据权利要求4所述的基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,在所述策略对抗模仿阶段,将所述判别器网络的输出作为内在奖励函数,对所述中间分配策略进行优化时,优化目标可表示为:

9.根据权利要求8所述的基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,所述策略对抗模仿阶段的所述优化目标中的置信域被设置为随着策略迭代次数的增大呈几何下降。

10.根据权利要求1至9任一项所述的基于从非完美示例中学习的跳频干扰资源分配方法,其特征在于,所述将所述跳频干扰资源分配问题建模为马尔可夫决策过程,包括:

技术总结本公开实施例是关于一种基于从非完美示例中学习的跳频干扰资源分配方法,包括:根据通信对抗场景构建跳频干扰资源分配问题;将跳频干扰资源分配问题建模为马尔可夫决策过程;随机初始化策略网络参数和判别器网络;对初始化的策略网络进行多次迭代,在每一次策略迭代过程中,基于双重置信域构建策略改进阶段和策略对抗模仿阶段;在策略改进阶段,基于TRPO算法对当前迭代中的初始分配策略进行优化,得到中间分配策略;在策略对抗模仿阶段,利用示例数据和当前迭代中初始分配策略的交互数据训练判别器网络优化中间分配策略,得到当前迭代的最终分配策略。本申请可以引导策略在稀疏奖励环境下正向优化,无需人为设计精细的奖励函数,节省资源耗费。技术研发人员:许华,饶宁,齐子森,蒋磊,彭翔受保护的技术使用者:中国人民解放军空军工程大学技术研发日:技术公布日:2024/10/10本文地址:https://www.jishuxx.com/zhuanli/20241015/314238.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表