低照度环境下的目标检测和识别方法

- 国知局

- 2024-11-18 18:25:22

本发明属于计算机视觉,特别是涉及一种低照度环境下的目标检测和识别方法。

背景技术:

1、目标检测和识别一直以来都是计算机视觉领域的研究重点与热点之一,在民用的交通、安防、医学及军用的监控、导航等领域愈发体现出重要的应用价值,目标检测与识别技术的准确度直接决定了自动监控、交通识别等应用的可靠性,其实时性决定了下游任务的适用范围。

2、目前基于深度学习方法的目标检测与识别技术,在光照、拍摄环境等状况良好时,自动化识别与监测性能已经达到甚至超越了人类水平,然而在阴天、夜晚等光照条件欠佳的情况下,普通相机的曝光率不足,获得的图像信噪比低、对比度低、噪声强,难以识别感兴趣的区域,对目前的目标检测与识别方法提出了新的挑战。

3、因此,亟需一种简单有效的目标检测与识别方法,以实现在光照条件欠佳的情况下,提高识别准确率。

技术实现思路

1、本发明实施例的目的在于提供一种低照度环境下的目标检测和识别方法,以解决现有技术在光照条件欠佳的情况下,无法识别图像中目标区域的问题,且能够提高识别准确率和实时性,同时使用范围更广。

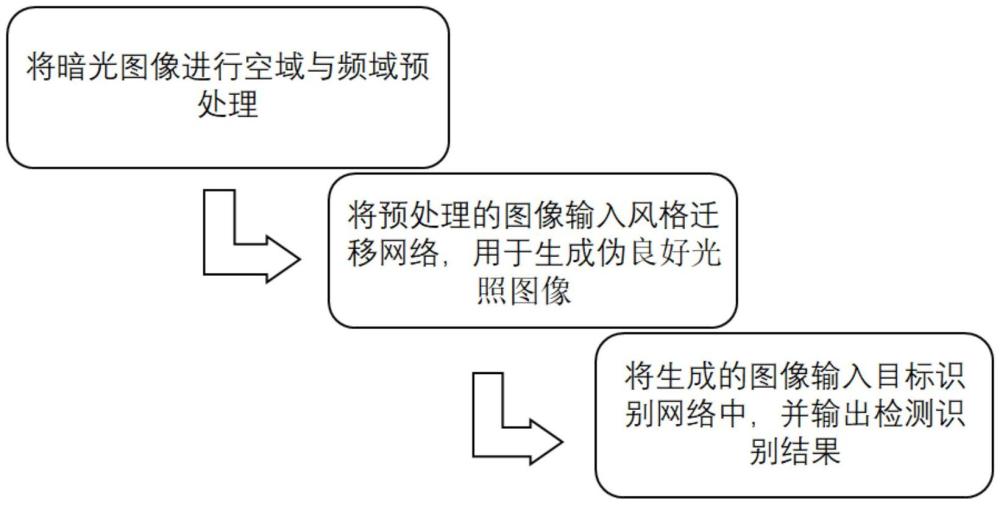

2、为解决上述技术问题,本发明所采用的技术方案是,一种低照度环境下的目标检测和识别方法,包括以下步骤:

3、s1:对暗光图像进行直方图均衡化处理,得到第一图像;

4、s2:对第一图像进行维纳滤波,得到第二图像;

5、s3:构建风格变换网络;将第二图像输入至风格变换网络中,生成伪良好光照图像;

6、s4:将伪良好光照图像输入目标检测网络中,进行检测识别;

7、s5:目标检测网络中的分类层、回归层输出最终检测识别结果。

8、进一步的,所述s1包括:

9、直方图均衡化处理的计算公式如下:

10、

11、其中,sk为直方图均衡化处理后得到的像素值,t(rk)表示对暗光图像中灰度级为rk的像素进行直方图变换操作,l表示图像中灰度级的总数,l-1是灰度级的最大值;j表示灰度级,k表示灰度级索引,nj表示灰度级为j的像素总个数,灰度级j为0-254内整数值,0≤k≤l-1;pr(rj)表示在灰度连续形式下暗光图像的连续概率密度,m、n分别表示暗光图像的高、宽,mn表示暗光图像内像素的数量总和。

12、进一步的,所述s2包括:

13、s21:使用高斯噪音作为噪声信号n(t),模拟实际拍摄中遇到的噪声情况;

14、s22:使用二维离散傅里叶变换dft将s1得到的第一图像从空域变换到频域中;

15、s23:确定退化函数,退化函数的计算公式如下:

16、h(u,v)=exp(-0.0025×((u-m/2)2+(v-n/2)2)56)

17、其中,u、v分别表示第一图像在频域中的横、纵坐标值,m、n分别表示第一图像的高、宽;

18、s24:对s22中经过转换的图像进行维纳滤波操作;维纳滤波操作的计算公式如下:

19、

20、其中,f为输入,即第一图像在频域中的横、纵坐标值u、v,g(f)表示对第一图像进行维纳滤波得到的图像,即第二图像;h(f)表示退化函数即h(u,v),|h(f)|指退化函数的模,s(f)为第一图像x(t)的功率谱;n(f)为噪声信号n(t)的功率谱,snr(f)为信噪比;

21、s25:将第二图像通过二维离散傅里叶逆变换idft转换回空域后保存。

22、进一步的,所述s3包括:

23、s31:构建风格变换网络;使用简化的vgg19网络作为风格变换网络,风格变换网络由五个卷积块组成,前四个卷积块均由两个卷积层和一个最大池化层顺序连接组成;第五个卷积块由两个卷积层连接组成,其中,第二个卷积层的输出作为风格变换网络的最终特征输出;各卷积块的激活函数为relu,各卷积层的卷积核大小均为3×3,卷积步长均为1,五个卷积块的通道数依次为64、128、256、512、512;

24、s32:将良好光照图像输入至风格变换网络中,将第四个卷积块的输出作为风格图像特征图s;

25、s33:将s25中得到的第二图像输入至s31的风格变换网络中,第五个卷积块的第二个卷积层的输出为生成图像特征图g。

26、进一步的,所述s3还包括:

27、s34:使用gram矩阵分别计算生成图像特征图与风格图像特征图中不同特征通道间的相关性,并定义风格损失函数;

28、gram矩阵计算公式为:

29、

30、其中,对于给定的卷积层l,l为第五个卷积块的第二个卷积层;表示第五个卷积块的第二个卷积层中,第c维通道特征和第d维通道特征的内积,i、j分别表示生成图像特征图的高、宽,i、j分别表示生成图像特征图中像素的位置坐标,表示第五个卷积块的第二个卷积层中,第c维通道中位置ij处的特征激活值,表示第五个卷积块的第二个卷积层中,第d维通道中位置ij处的特征激活值;

31、使用gram矩阵分别计算生成图像特征图、风格图像特征图的gram矩阵,分别为gl(g)、gl(s);

32、风格损失函数l(s,g)计算公式如下:

33、

34、其中,ml是生成图像特征图的元素总数,为生成图像特征图的高hl、宽wl的乘积hl×wl;

35、nl是生成图像特征图的通道数;l=l=1,||·||f表示frobenius范数,即矩阵gl(s)-gl(g)的元素平方和的平方根;

36、s35:迭代过程;使用梯度下降算法更新生成图像特征图g的像素值,以最小化风格损失函数,不断迭代,直到达到预定的迭代次数;得到伪良好光照图像。

37、进一步的,所述s4包括:

38、目标检测网络包括主干网络、多尺度网络、预测及分类模块;

39、s41:主干网络包括卷积层b3层、b4层、b5层,多尺度网络包括低级层p3层、p4层、基础层p5层、高级层p6层、p7层;

40、在主干网络中,将s35得到的伪良好光照图像输入b3层得到通道数为8、长×宽为100×128的第一特征图,将第一特征图输入b4层得到通道数为16、长宽为50×64的第二特征图,将第二特征图输入b5层得到通道数为32、长宽为25×32的第三特征图;

41、s42:在多尺度网络中,复制第三特征图,得到p5层特征图,将p5层特征图输入p6层得到通道数为64、长宽为13×16的第四特征图,将第四特征图输入p7层得到通道数为128、长宽为7×8的第五特征图;对p5层特征图进行上采样得到通道数为16、长宽为50×64的第六特征图,将第六特征图与b4层第二特征图相加得到p4层特征图,对p4层特征图进行上采样得到通道数为8、长宽为100×128的第七特征图,第七特征图与b3层第一特征图相加得到p3层特征图;

42、s43:多尺度网络提取的多级特征从上至下依次为:第五特征图,第四特征图,p5层特征图,p4层特征图,p3层特征图,将五个特征图分别输入五个预测分类模块,每个预测分类模块由四个卷积层和两个并行的输出层组成;四个卷积层的卷积核均为3×3,步长为1,通道数为256,两个并行的输出层为分类层、回归层。

43、进一步的,所述s43中分类层、回归层的输出过程为:

44、s431:利用掩码的形式,分类层输出伪良好光照图像内的各目标类别;

45、s432:回归层将输入特征图中每一个像素点作为感兴趣区域的中心点,预测各感兴趣区域的长和宽,并将其作为备选包围框,回归层输出为四维向量,四维向量表示备选包围框的长、宽、左上角点的二维坐标;

46、s433:将所有中心点在真实边界框内的备选包围框作为正样本。

47、进一步的,所述s4还包括:

48、s44:在回归层输出过程中加入中心点检测损失,中心点检测损失计算公式如下:

49、

50、其中,centerness表示中心点检测损失,l、r、t、b分别为回归层输出的各备选包围框中的中心点距离上边缘、下边缘、左边缘、右边缘的距离;

51、目标检测网络的总体损失,由分类损失、回归损失、中心点检测损失三部分组成,具体计算公式如下:

52、

53、其中,lcls为分类损失,lreg为回归损失,npos为感兴趣区域的总个数,px,y、分别为分类层输出的真实类别、预测类别,tx,y、分别为回归层输出的真实位置、预测位置,l(px,y,tx,y)表示目标检测网络的总体损失,x、y分别表示每个中心点的横、纵坐标,表示真实类别和预测类别的分类损失,λ表示平衡系数,表示真实位置和预测位置的回归损失;

54、s45:训练预测分类模块;先进行中心点、冗余备选包围框、真实边界框的数据收集与标注,然后使用训练集对预测分类模块进行训练,更新预测分类模块的模型参数以最小化总体损失函数l(px,y,tx,y),不断迭代,直到达到预定的迭代次数。

55、进一步的,所述s5包括:

56、计算所有正样本的置信度,从分类层获取每个正样本的分类得分,设置置信度阈值,对所有通过阈值筛选的正样本按其置信度从高到低进行排序,选取置信度最高的正样本,对于筛选出的置信度最高的正样本进行验证和确认,同时使用非极大值抑制来去除重叠的边界框;

57、最终输出结果为:分类层的类别输出及回归层输出的置信度最高的正样本的四维位置向量。

58、本发明的有益效果是:

59、1,本发明使用空域与频率结合的方式,对低照度图像进行直方图均衡及维纳滤波,能快速去除图像中的噪声,对图像中的感兴趣区域进行增强,鲁棒性更好。

60、2,本发明使用风格迁移网络有效提取暗光图像中的纹理及语义信息,进而生成伪暗光图像,网络的复杂度低、收敛速度快、可迁移性好。

61、3,本发明对感兴趣区域进行回归,提取图像特征并进行多任务学习,有效减少了冗余的感兴趣区域,降低了正负样本差距,提高了回归的准确率和网络训练速度,使网络收敛过程稳定,实时性良好。相比于传统检测方法,本发明方法的性能不受超参数的影响,且计算速度较快。

本文地址:https://www.jishuxx.com/zhuanli/20241118/328680.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表