基于联邦分裂学习的模型训练方法、装置、电子设备及存储介质

- 国知局

- 2024-11-19 09:41:17

本申请涉及数据处理,尤其涉及一种基于联邦分裂学习的模型训练方法、装置、电子设备及存储介质。

背景技术:

1、随着元宇宙、聊天生成预训练转换器(chat generative pre-trainedtransformer,chatgpt)等人工智能内容生成应用的蓬勃发展,智能业务模型的复杂度指数级提升,对算力和数据的需求也随之增加。联邦分裂学习作为一种新型的协同计算方案,因其能够在保护数据隐私的同时实现模型训练,而受到广泛关注。然而,随着参与者数量的增加,系统的安全问题也日益突出。梯度逆转、数据污染、模型中毒等恶意攻击行为严重威胁训练过程的安全性和效率。

2、当前无法对梯度逆转、数据污染、模型中毒等恶意攻击行为进行防御,导致当前进行基于联邦分裂学习的模型训练时安全性低下。

技术实现思路

1、本申请提供一种基于联邦分裂学习的模型训练方法、装置、电子设备及存储介质,用以解决现有技术中进行基于联邦分裂学习的模型训练时安全性低下的缺陷,实现提高基于联邦分裂学习的模型训练安全性。

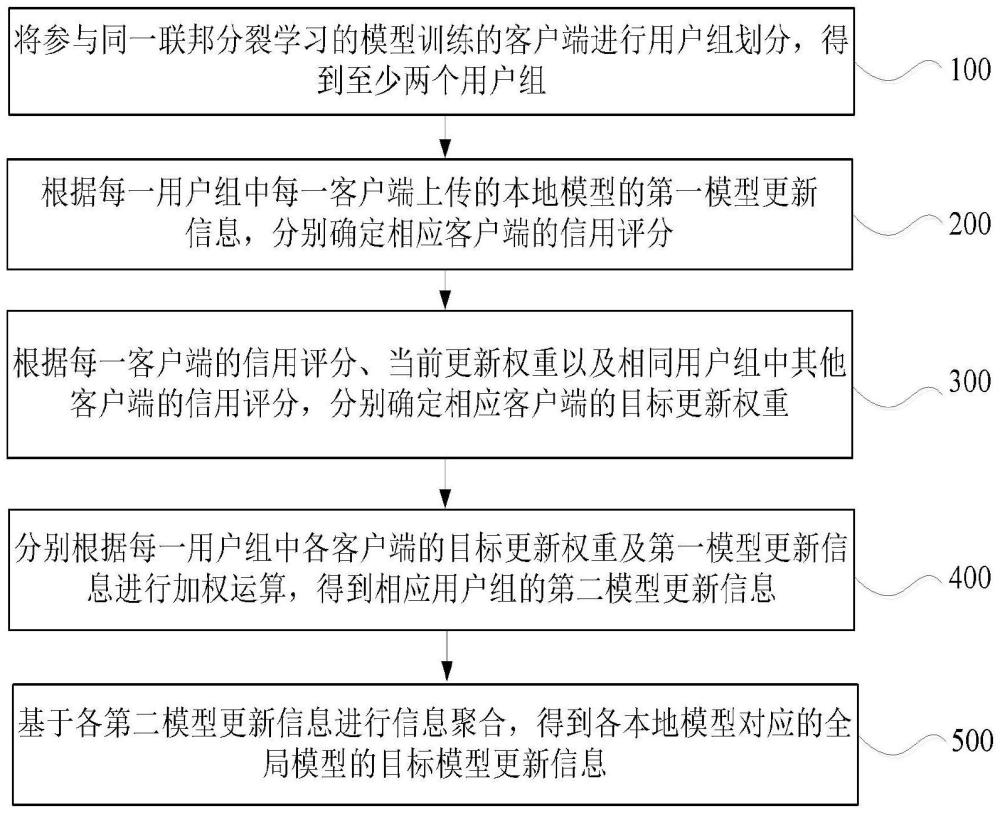

2、本申请提供一种基于联邦分裂学习的模型训练方法,在每一轮联邦分裂学习的模型训练中,包括:将参与同一联邦分裂学习的模型训练的客户端进行用户组划分,得到至少两个用户组;根据每一用户组中每一客户端上传的本地模型的第一模型更新信息,分别确定相应客户端的信用评分;根据每一客户端的信用评分、当前更新权重以及相同用户组中其他客户端的信用评分,分别确定相应客户端的目标更新权重;分别根据每一用户组中各客户端的目标更新权重及第一模型更新信息进行加权运算,得到相应用户组的第二模型更新信息;基于各第二模型更新信息进行信息聚合,得到各本地模型对应的全局模型的目标模型更新信息。

3、根据本申请提供的一种基于联邦分裂学习的模型训练方法,在根据每一客户端的信用评分、当前更新权重以及相同用户组中其他客户端的信用评分,分别确定相应客户端的目标更新权重时,针对每一客户端,分别执行如下操作:根据当前客户端的信用评分与当前客户端对应用户组中其他客户端的信用评分,确定当前客户端的缩放系数;基于当前客户端的缩放系数、当前更新权重与当前更新权重对应的损失信息,确定当前客户端的目标更新权重。

4、根据本申请提供的一种基于联邦分裂学习的模型训练方法,所述根据当前客户端的信用评分与当前客户端对应用户组中其他客户端的信用评分,确定当前客户端的缩放系数,包括:分别确定当前客户端对应用户组中所有客户端的影响系数;针对当前客户端对应用户组中每一客户端,分别将每一客户端的影响系数与其信用评分相乘,得到相应客户端的第一乘积;将当前客户端对应用户组中所有客户端的第一乘积进行加和,得到加和值;将当前客户端的第一乘积与所述加和值进行比值运算,得到第一比值运算值;将第一比值运算值与预设正规化因子相乘,得到当前客户端的缩放系数。

5、根据本申请提供的一种基于联邦分裂学习的模型训练方法,所述基于当前客户端的缩放系数、当前更新权重与当前更新权重对应的损失信息,确定当前客户端的目标更新权重,包括:确定当前客户端的当前更新权重对应的损失信息;将预设学习率与当前客户端的缩放系数进行比值运算,得到第二比值运算值;将第二比值运算值与当前客户端的当前更新权重对应的损失信息相乘,得到第二乘积;将当前客户端的当前更新权重与所述第二乘积相减,得到当前客户端的目标更新权重。

6、根据本申请提供的一种基于联邦分裂学习的模型训练方法,在根据每一用户组中每一客户端上传的本地模型的第一模型更新信息,分别确定相应客户端的信用评分之后,还包括:根据每一用户组中各客户端的信用评分,分别确定每一用户组的动态评分阈值;针对每一用户组中的每一客户端,若任一客户端的信用评分大于相应用户组的动态评分阈值,则将相应客户端剔除。

7、根据本申请提供的一种基于联邦分裂学习的模型训练方法,每一客户端上传的本地模型的第一模型更新信息均为引入扰动后的模型更新信息。

8、根据本申请提供的一种基于联邦分裂学习的模型训练方法,所述本地模型至少为图像识别模型、语音识别模型、自然语言处理模型与信息预测模型中的一种。

9、本申请还提供一种基于联邦分裂学习的模型训练装置,包括:划分模块,用于将参与同一联邦分裂学习的模型训练的客户端进行用户组划分,得到至少两个用户组;第一确定模块,用于根据每一用户组中每一客户端上传的本地模型的第一模型更新信息,分别确定相应客户端的信用评分;第二确定模块,用于根据每一客户端的信用评分、当前更新权重以及相同用户组中其他客户端的信用评分,分别确定相应客户端的目标更新权重;运算模块,用于分别根据每一用户组中各客户端的目标更新权重及第一模型更新信息进行加权运算,得到相应用户组的第二模型更新信息;聚合模块,用于基于各第二模型更新信息进行信息聚合,得到各本地模型对应的全局模型的目标模型更新信息。

10、本申请还提供一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现如上述任一种所述基于联邦分裂学习的模型训练方法。

11、本申请还提供一种存储介质,所述存储介质为非暂态计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现如上述任一种所述基于联邦分裂学习的模型训练方法。

12、本申请提供的基于联邦分裂学习的模型训练方法、装置、电子设备及存储介质,在每一轮联邦分裂学习的模型训练中,通过将参与同一联邦分裂学习的模型训练的客户端进行用户组划分,得到至少两个用户组,可以增强匿名性;进一步地,根据每一用户组中每一客户端上传的本地模型的第一模型更新信息,分别确定相应客户端的信用评分;并根据每一客户端的信用评分、当前更新权重以及相同用户组中其他客户端的信用评分,分别确定相应客户端的目标更新权重;进而可以分别根据每一用户组中各客户端的目标更新权重及第一模型更新信息进行加权运算,得到相应用户组的第二模型更新信息,通过将各客户端的更新权重结合模型更新信息在小组内部进行汇聚,可以隐藏每个客户端的具体贡献,以保护个体隐私;由此可以基于各第二模型更新信息进行信息聚合,得到各本地模型对应的全局模型的目标模型更新信息,由于增强了匿名性并隐藏了各客户端的具体贡献,可以有效对梯度逆转、数据污染、模型中毒等恶意攻击行为进行防御,因此可以提高基于联邦分裂学习的模型训练时的安全性。

技术特征:1.一种基于联邦分裂学习的模型训练方法,其特征在于,在每一轮联邦分裂学习的模型训练中,包括:

2.根据权利要求1所述的基于联邦分裂学习的模型训练方法,其特征在于,在根据每一客户端的信用评分、当前更新权重以及相同用户组中其他客户端的信用评分,分别确定相应客户端的目标更新权重时,针对每一客户端,分别执行如下操作:

3.根据权利要求2所述的基于联邦分裂学习的模型训练方法,其特征在于,所述根据当前客户端的信用评分与当前客户端对应用户组中其他客户端的信用评分,确定当前客户端的缩放系数,包括:

4.根据权利要求2所述的基于联邦分裂学习的模型训练方法,其特征在于,所述基于当前客户端的缩放系数、当前更新权重与当前更新权重对应的损失信息,确定当前客户端的目标更新权重,包括:

5.根据权利要求1所述的基于联邦分裂学习的模型训练方法,其特征在于,在根据每一用户组中每一客户端上传的本地模型的第一模型更新信息,分别确定相应客户端的信用评分之后,还包括:

6.根据权利要求1所述的基于联邦分裂学习的模型训练方法,其特征在于,每一客户端上传的本地模型的第一模型更新信息均为引入扰动后的模型更新信息。

7.根据权利要求1-6任一项所述的基于联邦分裂学习的模型训练方法,其特征在于,所述本地模型至少为图像识别模型、语音识别模型、自然语言处理模型与信息预测模型中的一种。

8.一种基于联邦分裂学习的模型训练装置,其特征在于,包括:

9.一种电子设备,包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的计算机程序,其特征在于,所述处理器执行所述程序时实现如权利要求1至7任一项所述基于联邦分裂学习的模型训练方法。

10.一种非暂态计算机可读存储介质,其上存储有计算机程序,其特征在于,所述计算机程序被处理器执行时实现如权利要求1至7任一项所述基于联邦分裂学习的模型训练方法。

技术总结本申请提供一种基于联邦分裂学习的模型训练方法、装置、电子设备及存储介质,属于数据处理技术领域,方法包括:在联邦分裂学习的模型训练中,将参与同一联邦分裂学习的模型训练的客户端进行用户组划分;根据每一用户组中每一客户端上传的第一模型更新信息,分别确定相应客户端的信用评分;根据每一客户端的信用评分、当前更新权重以及同组中其他客户端的信用评分,分别确定相应客户端的目标更新权重;分别根据每一用户组中各客户端的目标更新权重及第一模型更新信息进行加权运算,得到相应用户组的第二模型更新信息;基于各第二模型更新信息进行信息聚合,得到全局模型的目标模型更新信息。本申请可以提高基于联邦分裂学习的模型训练时的安全性。技术研发人员:周赞,孙溢,许长桥,杨树杰,刘志远,黄思喆受保护的技术使用者:北京邮电大学技术研发日:技术公布日:2024/11/14本文地址:https://www.jishuxx.com/zhuanli/20241118/329797.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。