一种基于自适应位移模块的语音情感识别方法

- 国知局

- 2024-06-21 11:36:16

本发明涉及基于深度学习的语音情感识别领域。特别是涉及一种基于自适应位移模块的语音情感识别方法。

背景技术:

1、尽管在语音情感识别中,各种深度学习模型已经达到了非常出色的效果。但是从预训练表征作为输入的解决方案上看,仍然具有很大的改进空间。与一般的语音情感识别任务相比,使用预训练表征作为输入的方法能够在通用的语音表征空间上提取语音中细微的情感信息,能够使得模型在一开始就具备一定的知识储备并且能够防止模型过拟合。

2、在语音情感识别任务中,公开数据集中的标注数据有限。在这种情况下,由于训练数据较少,使用复杂的模型难以很好的拟合;另一方面,数据有限往往会导致深度学习中模型过拟合,因此在实际应用部署中会导致效果下降。因此许多研究者通过两种方式避免以上问题,一种是设计更通用的表征学习模块,学习到情感的一般性特征;另一种是基于预训练模型进行设计,在通用的预训练表征的基础上训练模型,能够一定程度上避免模型过拟合。

3、另外,在许多基于预训练模型的语音情感识别模型中,很少有研究者针对下游任务设计对预训练表征进一步提取特征的模块。他们往往直接使用已有的模型结构或者直接对预训练表征学习上下文信息。这些方法能够下游任务都有一定的通用性,但是往往没有对下游任务有针对性的特征提取。当我们只想对语音情感识别任务进行精度提升时,就应该设计针对语音情感识别任务的特征提取模块。

4、综上所述,现有的语音情感识别任务存在以下几个问题需要解决:1、在有限的标注数据集上,避免模型过拟合;2、针对语音情感识别任务设计特征提取模块。

5、针对现有技术中存在的缺陷,本发明的目的为达到以上目的,本发明采取的技术方案是:设计一个特征提取模块,通过使用预训练表征作为模型输入,减少模型过拟合的风险;同时设计的模块减少模型参数,进一步减少模型过拟合风险。即设计一个自适应位移模块,在减少模型的参数的情况下保持模型对情感相关信息提取的能力,从而避免模型过拟合。

技术实现思路

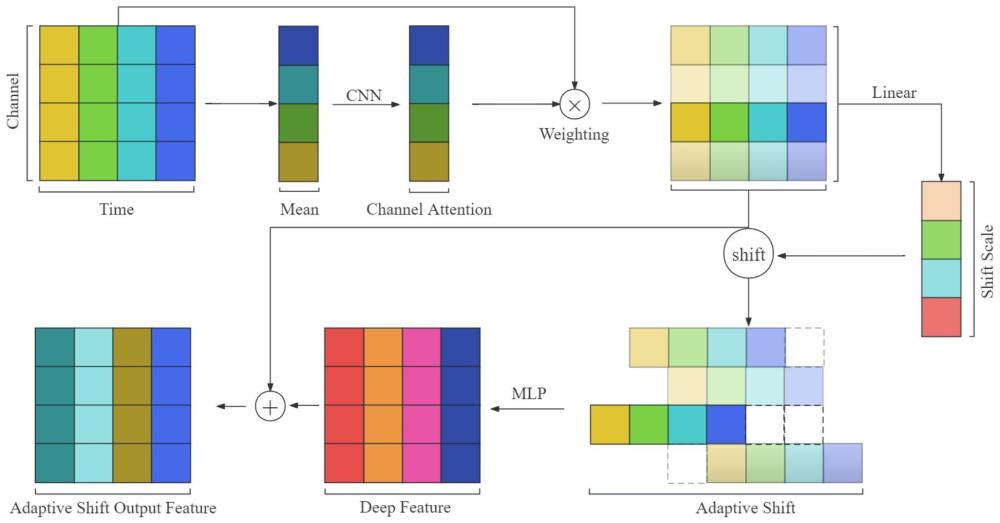

1、本发明针对现有方法存在的容易过拟合、缺少在预训练表征的基础上针对语音情感识别任务的特征提取模块等缺点,提出了一种有效的方法来学习输入特征图中情感相关信息。该发明主要包括两部分:1、通道注意力机制,可以根据全局平均和卷积操作快速计算出通道的重要性;2、自适应位移,可以对不同通道数据进行不同尺度的位移,用于在情感特征混合和数据对齐中进行取舍。具体步骤如下:

2、(1)获得预训练模型的输出。本发明中将语音信号裁剪为7.5秒,以16khz的采样率进行采样。将预处理后的语音数据输入到使用librispeech数据集训练得到的预训练模型wav2vec2模型中,并获取wav2vec2特征提取器最后一层的输出作为预训练表征。

3、(2)通道注意力分数计算。预训练模型输出的二维张量形状为t×c,其中有两种概念:不同通道的异质特征和由c个异质特征组成的特征图。对于所有异质信息来说有一部分利于提取下游任务中情感相关特征,另一部分语音信息为与语音情感识别任务无关的信息。因此对于语音情感识别任务来说,不同通道数据也应该具有不同的贡献比重。本发明同时考虑了这两种概念,先对异质特征求取均值,再根据所有通道的均值向量计算不同异质特征对情感信息提取的重要程度,从而实现了使模型更关注情感相关区域。具体可以进一步分为以下三个步骤:

4、(2.1)全局平均。对二维张量的每个通道执行平均计算,得到由每个通道的平均值组成的均值张量。

5、(2.2)注意力权重计算。使用卷积层对平均值张量进行计算,得到通道注意力权重。

6、(2.3)注意力权重激活。将计算出的通道注意力分数输入sigmoid非线性激活函数,使得注意力分数约束在0到1之间,即为最终的通道注意力权重。

7、(3)使用通道注意力的自适应位移。在二维张量中的不同异质特征中,存在一种概念:情感信息可能分布在不同时间戳上。本发明考虑到这种概念,先使用通道注意力分数对特征图不同通道进行加权,使得与情感相关的通道数据能够以较大的权重进行自适应位移,与情感无关的通道数据以较小的权重进行自适应位移。从而实现让不同异质特征中的情感信息在时间轴上混合,让后续情感分类层更容易关注语音中的情感信息。具体步骤也可以进一步分为以下五个步骤:

8、(3.1)通道注意力加权。经步骤(2.3)获得的注意力分数与预训练表征或上一层自适应位移模块的输出特征进行加权,将每个注意力分数与特征图对应通道数据相乘即可完成加权计算,获得加权后特征图。

9、(3.2)自适应位移尺度计算。将加权后的特征图输入到线性层,线性层的输入维度大小为t,输出维度大小为1,即可得到c个位移尺度数值,以实现不同数据进行不同尺度位移的效果。将位移尺度数值送入tanh激活函数中,将其约束到-1到1之间,并将数值缩放到设置的最大位移超参数范围内。

10、(3.3)通道数据位移。由(3.2)步骤获得的自适应位移尺度是浮点数,但是向量下标的差值为1,即位移的数量应该是整数。因此需要将位移尺度计算出向上取整和向下取整的数值,并计算出两个整数所占的比例。将原始输入特征图的通道数据执行两次位移,即根据向上取整和向下取整的位移尺度进行两次位移,然后将位移后的特征分别乘上对应位移的比例,最后加起来得到自适应位移特征。其中每一次位移的数值的正数或负数分别对应通道数据沿时间轴方向向前或向后位移,并且边缘位置的数值设置为0。

11、(3.4)上下文特征学习。将自适应位移特征图输入mlp(multi-layer perceptron)结构中学习上下文信息,以更好的特征的依赖。其中mlp结构由线性层、gelu激活函数、线性层和dropout层堆叠组成。

12、(3.5)残差连接。将加权前的预训练表征或上一层自适应位移特征图作为残差连接,与学习到上下文信息的深度特征图进行相加,并进行归一化。从而使模型在关注情感信息的同时,保留一定的音频共有特征。

13、(4)情感预测。本发明将不同通道的异质特征进行聚合,获得聚合特征向量。使用分类层对聚合的特征向量进行情感预测。具体可以分为以下两个步骤:

14、(4.1)通道聚合。将最终得到的特征图在通道上进行聚合,将相同时间戳上不同通道数据相加,求和后除以通道数c,得到该时间戳上的聚合值。所有时间上的数据聚合完成后得到一个一维向量。

15、(4.2)情感分类层。将得到的一维向量输入全连接层中,其中全连接层输入维度为t,输出维度为情感类别数量。其中置信度最高的情感类别即为预测出的情感。

技术特征:1.一种基于自适应位移模块的语音情感识别方法,其特征在于实施步骤为:

2.根据权利要求1所述的基于自适应位移模块的语音情感识别方法,其特征在于本方法的语音预处理和特征提取阶段:

3.根据权利要求1所述的基于自适应位移模块的语音情感识别方法,其特征在于本方法的通道注意力机制:

4.根据权利要求1所述的基于自适应位移模块的语音情感识别方法,其特征在于本方法的基于通道注意力权重的自适应位移:

5.根据权利要求1所述的基于自适应位移模块的语音情感识别方法,其特征在于本方法的情感预测:

6.根据权利要求1所述的基于自适应位移模块的语音情感识别方法,其特征在于本方法的语音情感识别方法:

技术总结本发明涉及基于深度学习的语音情感识别领域。本发明公开了一种基于自适应位移模块的语音情感识别方法。本发明的方法包括:音频预处理,将音频的长度设置为7.5秒,采样率使用16kHz;使用预训练模型提取预训练表征;通过通道注意力机制使模型更关注情感相关区域;自适应位移,先根据通道数据计算位移尺度,再根据这个位移尺度对该通道数据进行位移。使得不同通道之间的异质特征在时间轴上混合,提升模型提取情感特征的能力;使用MLP结构捕捉特征之间的依赖;使用全连接层对聚合后的特征进行情感预测。其中自适应位移模块细节图如图1所示。本发明能够以相对较少的参数量,实现情感特征提取,以提高情感识别准确率。技术研发人员:王伟胜,陈金泉,林红利受保护的技术使用者:湖南大学技术研发日:技术公布日:2024/3/12本文地址:https://www.jishuxx.com/zhuanli/20240618/22327.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表