用于数据中心的自耦降压起动风机控制方法及系统与流程

- 国知局

- 2024-07-31 17:55:24

本发明涉及数据中心电网,具体涉及具有自耦降压起动模式的数据中心消防电网,特别涉及用于数据中心的自耦降压起动风机控制方法及系统。

背景技术:

1、数据中心存储着大量的数据,并承载着关键的业务运营,因此其安全性至关重要。消防风机作为数据中心消防系统的重要组成部分,能够在火灾发生时迅速排烟,减少烟雾对设备的损害,从而保障数据中心的安全运营。

2、消防风机的主要电器元件是电机;最初始的传统技术中,数据中心用消防风机的电机采用星三角降压启动模式。启动时,电机先以星形接线运行,此时电流和电压较小。随后,通过转换器将电机的星形连接切换为三角连接,实现电机高转速运行,提高效率。

3、但是,这种传统技术会产生较大的起动电流,会对数据中心的电网系统造成一定程度的冲击,进而容易对数据存储产生影响。因此,又有现有技术进一步引入了自耦降压起动模式,即使用自耦变压器来降低电机起动时的电压,从而减少起动电流对电网的冲击。这种起动方式特别适用于大功率电机,尤其是在电网容量有限或需要频繁起动的数据中心中。

4、但是,引入了自耦降压起动模式又存在相应的技术问题:自耦变压器虽然能够降低起动电压,但由于电机的阻抗特性,起动电流仍然会相对较高。其原因在于:电机的阻抗主要由电阻和电抗组成,而在电机起动时,由于转子尚未旋转或转速很低,转子的电抗值很小,因此电机的整体阻抗相对较低。即使通过自耦变压器降低了加到电机上的电压,由于电机阻抗小,根据欧姆定律换算就可得出电流仍然会相对较大。此外,电机在起动过程中需要较大的转矩和电流,才能从静止状态加速到额定转速。

5、这种情况下,大电流流过电网会导致电压暂降,容易影响数据中心中的其他设备的正常运行。同时电网中的变压器、开关等设备也可能因承受不起过大的电流而过载,甚至损坏。并且大电流会导致电网中的功率损耗增加,降低电网效率。

6、而且,电机本身是一个非线性负载,特别是在起动阶段。当电机的电流波形不是纯正弦波时,就会产生谐波(即虽然电压降低了,但电流仍然很大。大电流流过时导致电网电压的波形发生畸变,进而产生谐波)。当电机起动时,如果与这些设备同时运行会相互干扰,进一步加剧谐波的产生。如果采用的是变频电机,则会加剧谐波污染的情况。因为数据中心内设备众多,各种电气设备之间通过电网相互连接。电机起动时产生的谐波可能通过电网传播到其他设备,会对数据中心其他设备的正常运行造成干扰。

7、为此,本发明提出用于数据中心的自耦降压起动风机控制方法及系统。

技术实现思路

1、有鉴于此,本发明实施例希望提供用于数据中心的自耦降压起动风机控制方法及系统,以解决或缓解现有技术中存在的技术问题,即:

2、(1)如何精确控制自耦变压器的抽头选择以减少电网冲击;

3、(2)如何适配控制降压起动的时间来减少切换时的电流和转矩冲击;

4、(3)在上述两点的基础上,实现对谐波问题进行优化。

5、本发明的技术方案是这样实现的:

6、第一方面,用于数据中心的自耦降压起动风机控制方法:

7、(一)概述:

8、本技术方案旨在实现两点技术要求,一是获取控制自耦变压器的抽头的步进调整区间及调整量的向量,二是控制降压起动的时间,要使得电机达到适当转速后平稳切换到全压运行。这样一来,通过逐步调整的电压可以有效减小起动电流,又可以通过精确控制降压起动的时间,可以在电机达到适当转速后平稳切换到全压运行,二者的协同还可以实现对谐波问题进行优化。

9、考虑到自耦变压器的抽头调整不是一次性的决策,而是需要根据电动机的实时状态和电网的条件进行连续的调整。每一个调整决策都会影响到电动机的启动性能和电网的稳定,并且在调整抽头的过程中,电网和电机的状态会不断变化,这些变化可以看作是环境对智能体动作的反馈。智能体需要根据这些反馈来优化其动作策略,以达到更好的启动性能和电网稳定性。因此,本发明所要解决的技术问题抽象化后,其相当于一种序列决策问题,所以本技术方案选择引入策略梯度算法(policy gradient)以解决该所要解决的技术问题。

10、(二)提取本征模态分量:

11、正常来说,策略梯度算法的输入应当是电网的电压和电流等信号;但是考虑到原始的电压、电流信号可能包含大量的冗余信息和噪声,可能会导致算法在训练过程中受到干扰,降低学习效率,甚至影响最终策略的准确性。并且电压、电流信号是电网状态的基础表征,但它们可能无法充分反映电网的深层特征或动态行为。因此,本发明需要先提取出电网中的本征模态分量以解决这个技术问题。其包括如下几个步骤:

12、2.1信号分割:

13、首先,根据实际电网特性,确定电网信号的频谱分割,即将信号的频谱划分为若干个连续的区间,每个区间对应一个模态。若信号的频谱被划分为n个区间,则第i个区间的频率范围可以表示为:

14、;

15、其中,ωi,min和 ωi,max分别是第i个区间的最小和最大频率。

16、2.2小波滤波器设计:

17、针对每个频谱区间,设计相应的小波滤波器以提取该区间的信号成分。滤波器的频率响应φi(ω)表示为:

18、;

19、2.3信号分解:

20、应用设计好的小波滤波器对原始信号x(t)进行分解,得到一系列的本征模态分量(imf)。第i个本征模态分量imfi(t)可以表示为:

21、;

22、其中,f表示傅里叶变换,f−1表示傅里叶逆变换。

23、2.4对每个imf进行阈值处理以去除噪声:

24、设第i个imf的阈值为τi,则去噪后的imf’i(t)可以表示为:

25、;

26、或者采用软阈值处理:

27、;

28、2.5量化思路:

29、基于上述四大步骤得出的imf’i(t),需要选择能量表达含量较高的本征模态分量,因为它们可能包含更多有关电网状态的信息,可以在本征模态分量的基础上进一步提高数据可行性。

30、能量熵可以用来量化信号中能量的分布情况和复杂性,有助于识别出包含重要信息的imf分量。因此,进一步引入如下步骤:

31、2.5.1计算能量分布:

32、首先计算每个imf分量的能量。可通过计算imf的平方和或积分来完成:

33、;

34、在实际应用中,这个积分可以通过对imf'i(t)进行离散采样并求和来近似计算。

35、2.5.2归一化能量分布:

36、计算得到每个imf的能量后可以将这些能量值归一化,以便更好地比较不同imf之间的能量分布:

37、;

38、其中,分母是对所有imf能量求和。

39、2.5.3计算能量熵:

40、有了归一化的能量分布就可以计算能量熵h:

41、;

42、这个熵值量化了每本征模态分量imfi(t)中能量的分布情况和复杂性。一个较高的熵值意味着能量分布更加均匀,而较低的熵值则表明某些imf分量包含了相对更多的能量。通过这种方法,在每个时间步下的每一系列的本征模态分量imf中选择能量含量最高且能量熵最低的那个本征模态分量imfi(t),以作为后文步骤s100和步骤s2中的本征模态分量imfi(t),因其分量基于能量熵被视为有包含有关电网状态的重要信息。

43、(三)技术方案

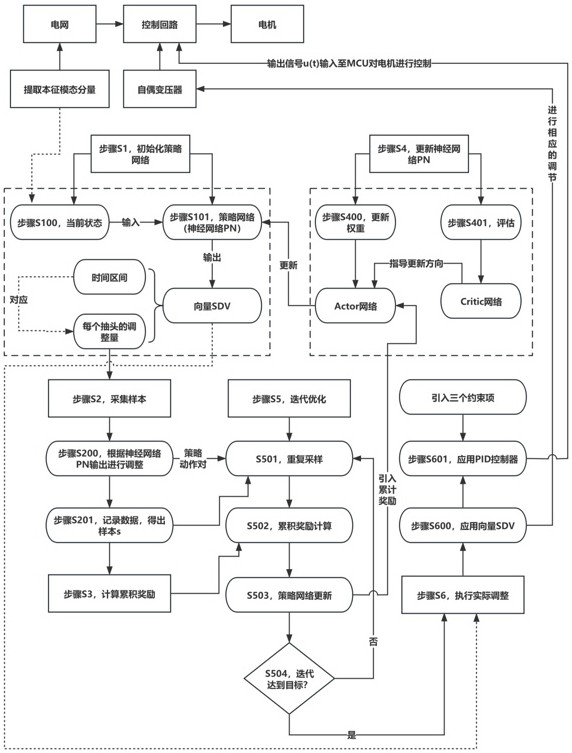

44、本发明的策略梯度算法包括如下的步骤s1~s6。

45、3.1步骤s1,初始化策略网络:

46、设定一个参数化的策略网络,其输入是电网和电动机的当前状态,输出是抽头的步进调整区间及调整量的向量sdv,并初始化网络权重 α。其具体的包括如下的步骤s100~s101。

47、3.1.1步骤s100,当前状态:

48、当前状态st是一种本征模态分量imfi(t)。其可由前文提供的方法提取出来。

49、3.1.2步骤s101,定义策略网络:

50、策略网络是神经网络pn,是一个多层感知机(mlp);定义为:

51、pn = mlp(inputdim, hiddendim, outputdim);

52、其中,mlp表示多层感知机网络,inputdim是输入状态st向量的维度(即imfi(t)的维度),hiddendim是隐藏层的维度(可以根据问题的复杂性进行调整),outputdim是输出向量sdv的维度。

53、神经网络pn的前向传播策略为:给定输入状态向量视为本征模态分量imfi(t),策略网络的输出为向量sdv,向量sdv的获取方法为:

54、sdv = pn(imfi(t); α);

55、其中,pn表示策略网络的前向传播函数,α是网络权重。这个函数会根据当前的权重和网络结构,将输入状态映射到输出向量sdv。

56、向量sdv的组成为:

57、sdv = [δs1, δs2, ..., δsn, i1, i2, ..., in];

58、其中,δs1, δs2, ..., δsn代表每个抽头的调整量。它们的值可以是连续的,表示抽头需要移动的距离或步数,也可以是离散的,表示抽头应该移动到哪个预设位置。调整量可以是正数(向上调整)或负数(向下调整)。i1, i2, ..., in代表需要调整的抽头索引或编号,对应抽头的调整量在一个连续的时间步中的相对区间(在某些实际情况中,可能不是所有的抽头都需要调整,因此这些索引指示了哪些抽头应该根据对应的δs值进行调整)。

59、在训练过程中,策略网络的权重α会根据策略梯度算法进行更新,以最大化某个奖励函数。权重的更新方法表示为:

60、αnew= αold+ η * ∇α j(αold);

61、其中,η是学习率,∇α j(αold)是奖励函数j关于原先的权重αold的梯度,在策略梯度算法中,这个梯度通过采样轨迹来估计。

62、3.2步骤s2,采集样本:

63、在实际环境中,根据当前神经网络pn输出的抽头调整量δsi(t)来采集样本s,记录每个样本s每一步的本征模态分量imfs(t)i、奖励向量a和新本征模态分量imfs(t)i’。其包括如下的步骤s200~s201。

64、3.2.1步骤s200,根据神经网络pn输出进行调整:

65、首先,根据神经网络pn在当前时间步t的输出δs1(t)来调整抽头。这个调整量表示抽头应该移动的距离或步数:

66、δsi(t) = pn(imfi(t);α);

67、然后,神经网络pn输出“状态-动作对”:

68、;

69、其中,πα(atst)是在状态st下采取动作at的概率,由策略网络pn给出。(st, at)为“状态-动作对”。

70、3.2.2步骤s201,记录数据,包括:

71、1)调整前的本征模态分量 imfs(t)i;

72、2)执行的调整量δsi(t);

73、3)调整后的新本征模态分量 imfs(t)i';

74、4)奖励向量 a,它包含了由于执行该调整而获得的奖励信息:

75、其中,奖励向量a是根据执行调整后的系统性能来计算的。包括电网系统的稳定性是否提高。而稳定性取决于电机是否从低压启动平稳过渡到全压运行。奖励函数的设计是策略梯度算法中的关键部分,它应该能够反映出我们期望系统达到的目标:

76、a = r(imfs(t)i, δsi(t), imfs(t)i');

77、其中,r是奖励函数,它根据调整前后的本征模态分量以及调整量来计算奖励,为一个基于系统稳定性和过渡平稳性的奖励函数。

78、以上数据构成了一个样本s,表示为:

79、s = {imfs(t)i, δsi(t), imfs(t)i', a};

80、3.3步骤s3,计算累积奖励:

81、对于每个样本s轨迹,计算从该步开始到轨迹结束的累积奖励序列b:

82、s = {s1, s2, ..., st};

83、其中,t是轨迹的长度;

84、每个状态st对应一个即时奖励rt,累积奖励序列b的获取方式为:

85、;

86、其中,γ是折扣因子(0<γ≤1),用于调节未来奖励的重要性。当γ= 1时,未来奖励与当前奖励具有相同的权重;当γ<1时,未来奖励的权重会逐渐减小。t是当前状态st在轨迹中的时间点索引,k是累加点。

87、3.4步骤s4,更新神经网络pn:

88、使用actor-critic算法根据累积奖励序列b来更新神经网络pn的权重α为权重αnew。目标是增加那些导致高累积奖励的动作的概率,减少导致低累积奖励的动作的概率。其步骤包括如下的步骤s400~s401。

89、3.4.1步骤s400,更新权重:

90、神经网络pn的权重更新方法通过actor网络实现,actor网络表示为:

91、;

92、其中:是在状态st下采取动作at的概率,由actor网络给出。是对数概率关于策略网络权重的梯度。

93、η是学习率,控制权重更新的步长。δ是td误差(temporal difference error),如果δ为正,意味着获得的奖励高于预期,因此我们应该增加这个动作at被选择的概率;如果δ为负,则应该降低这个动作at的概率。

94、actor网络负责对对数概率计算策略网络权重的梯度,这个梯度指示了如何调整策略参数以增加或减少特定的那个动作at被选择的概率。

95、3.4.2步骤s401,critic网络评估:

96、critic网络通过预测函数v(st)和预测函数v(st+1)对状态st和下一时间步的状态st+1的值进行预测。即,用于评估状态或动作状态值,帮助actor网络知道其动作的好坏。critic网络通过计算td误差δ来指导actor网络的更新方向。

97、critic网络,也称为价值网络,用于评估状态或动作状态值。它帮助actor网络知道其动作的好坏,通过计算td误差δ来指导actor网络的更新方向:

98、;

99、其中,rt是在状态st采取动作at后获得的即时奖励,v(st)和v(st+1)分别是critic网络对状态st和st+1的值的预测函数。

100、critic网络的权重通过最小化td误差的平方来进行更新,这样可以使critic网络更准确地预测状态的值。

101、3.5步骤s5,迭代优化:

102、重复步骤s2~s4,直到神经网络pn的表现达到预设标准或迭代次数达到上限。包括如下步骤:

103、s501,重复采样:在每次迭代中,收集新的状态-动作对(st, at)和相应的奖励向量a。

104、s502,累积奖励计算:对于每个采样得到的状态-动作对(st, at),计算其累积奖励:

105、;

106、其中,rt是在时间步t的累积奖励,rt+k是在时间步t+k时获得的奖励。

107、s503,策略网络更新:使用累积奖励rt来更新神经网络pn的权重α,目的是增加导致高累积奖励rt的那个动作at的概率,并减少导致低累积奖励的那个动作at的概率:

108、;

109、其中,累积奖励rt被用作一个缩放因子,来调整梯度更新的步长。如果某个动作导致了高的累积奖励,那么该动作的梯度更新将会被更大程度地加强,从而增加这个动作在未来被选择的概率。相反,如果累积奖励较低,那么梯度更新的幅度将会减小,降低这个动作在未来被选择的概率。

110、或,td误差δ可以看作是一个经过调整的累积奖励,它考虑了当前奖励与预期奖励之间的差异,从而减少了方差并加速了学习过程。因此,在策略网络权重更新的公式中,优选使用td误差隐式地更新策略网络的权重。

111、s504,停止条件:迭代过程会一直进行,直到满足某个停止条件。可为神经网络pn的表现达到一个预设的标准(例如,在测试集上达到一定的胜率或得分),或者是迭代次数达到一个设定的上限。

112、3.6步骤s6,执行实际调整:

113、计算出向量sdv并应用至自耦变压器中;然后设定pid控制器的参数并设定电机的目标转速和允许误差范围,并接受向量sdv;

114、根据抽头调整量向量,动态调整pid控制器的设定点;

115、3.6.1步骤s600,应用向量sdv:

116、获取向量sdv后将其降维,获取抽头的步进调整区间ii及调整量δsi,然后对自耦变压器进行相应的调节:

117、sdv = pn(imfi(t); αnew)

118、sdv = [ii, δsi];

119、3.6.2步骤s601,应用pid控制器:

120、基本形式为:;

121、其中,u(t)是控制器的输出信号。e(t)是设定点与实际测量值之间的偏差(目标转速与实际转速之差)。kp、ki、kd分别是比例、积分、微分控制器的增益。dτ是持续常量。

122、设定点为电机的目标转速或切换时间;策略为如果调整量a是增加抽头电压,pid控制器的设定点则相应提高,以加快电机转速,从而缩短降压起动时间;调整量a反之亦然;然后,pid控制器根据实时转速与目标转速的差距,计算控制量。控制量用于调整电动机的降压起动时间,以确保电机平稳加速到适当转速后切换到全压运行。将上述条件设为约束条件,将pid控制器更新为:

123、;

124、其中,第一个约束项是对误差信号e(t)作出的。动态调整设定点实际上是在每个时间步根据抽头调整量δsi来更新pid控制器的设定点sp(t)。pv(t)是过程变量(电机的实时转速)。

125、其中,第二个约束项是对输出信号u(t)进行限幅而作出的。通过对其引入最大最小值限制,以避免对系统造成过大的冲击;umax和umin分别是控制信号的最大和最小限制值。

126、其中,第一个约束项还可以进一步引入额外的约束项:

127、;

128、其中,u(t)是原始的pid控制器输出。kc是一个调整系数,用于控制约束项的影响程度。sgn(e(t))是误差 e(t) 的符号函数,用于保持约束项与误差方向的一致性。使用调整后的 uc(t) 作为控制信号来驱动系统。

129、如果 ∣e(t)∣>ϵ,则说明误差超出了允许范围,引入上述约束项来调整pid控制器的输出。这个约束项是一个基于误差的函数,用于减小控制信号的幅度或改变其方向,以防止系统失控。

130、(四)技术方案总结:

131、1)本征模态分量及其能量熵的提取:作为算法的预处理步骤,我们从电网中提取出本征模态分量及其能量熵。这一步骤的目的是筛选和评估电网的状态,为后续的控制策略提供基础数据。

132、2)步骤s1:初始化策略网络:在这一步建立一个策略网络,并对其进行初始化。这个策略网络将用于学习如何根据电网状态调整自耦变压器的抽头,以优化电机的起动和运行。

133、3)步骤s2:采集样本:通过与环境的交互采集了一系列的“状态-动作对”样本。这些样本将用于训练策略网络,使其能够学习到更好地控制策略。

134、4)步骤s3:计算累积奖励:对于每个采集到的样本,计算其累积奖励。这个奖励函数反映了控制策略的好坏,是策略网络学习的目标。

135、5)步骤s4:更新策略网络:使用采集到的样本和累积奖励来更新策略网络。通过不断地迭代和优化,策略网络逐渐学习到如何根据电网状态选择最优的控制动作。

136、6)步骤s5:迭代优化:重复步骤s2到s4,进行多次迭代优化,直到策略网络的表现达到一个满意的水平。

137、7)步骤s6:pid控制器执行实际调整:在策略网络训练完成后将其与pid控制器结合,执行实际的调整操作。首先,根据策略网络的输出获取控制自耦变压器的抽头的步进调整区间及调整量的向量(sdv)。然后,应用这个向量来调整自耦变压器的抽头,从而控制降压起动的时间和电机的转速。通过精确控制降压起动的时间,可以在电机达到适当转速后平稳切换到全压运行。这种逐步调整的电压不仅可以有效减小起动电流,还可以通过与pid控制器的协同工作来优化谐波问题。

138、第二方面,用于数据中心的自耦降压起动风机控制系统:

139、包括两个使用定子串自耦变压器降压启动控制线路的风机电机,接线端中具有自耦变压器;每个风机电机的控制回路连接于emc控制器,emc控制器的i2c端口连接有一mcu控制器,mcu控制器连接有一存储有程序指令的存储器;

140、当程序指令被mcu控制器执行时,使emc控制器控制并实现如上述所述的用于数据中心的自耦降压起动风机控制方法。

141、与现有技术相比,本发明的有益效果是:

142、1、智能化调整策略:本发明通过策略梯度算法的迭代优化过程(s1~s5),系统能够自主学习并不断优化控制策略,使得自耦变压器的抽头调整更加精确和高效。这种自我学习和优化的能力,使电机系统能够适应电网环境和负载条件,提高了整个系统的鲁棒性和适应性,避免了数据中心因电机的谐波而受到不利影响。

143、2、能量熵筛选机制:本发明通过从电网中提取本征模态分量及其能量熵作为筛选,该算法能够更精准地评估电网状态,为后续的控制策略提供关键信息,从而确保控制的准确性和有效性。

144、3、自动化调整策略:本发明通过pid控制器执行实际调整(s6),策略梯度算法的输出被转化为具体的控制指令,实现了对自耦变压器抽头的精细控制。这种控制方式不仅可以有效减小电机的起动电流,延长设备使用寿命,还能确保电机在达到适当转速后平稳切换到全压运行,大大降低了对电网的冲击。

145、4、节能并优化风机电力系统:本发明通过逐步调整自耦变压器的抽头,可以使电机从低压启动平稳过渡到全压运行。这种逐步加压的启动方式可以避免电机在启动时产生过大的电流冲击和机械应力,保护电机和电网的稳定运行;并且本发明通过精确控制降压起动的时间,可以在电机达到适当转速后平稳切换到全压运行,这样电机的阻抗已经增加到一定程度,能够承受更大的电流而不会产生过大的冲击。同时,平稳的切换过程也可以避免转矩的突然变化,从而减少机械应力对电机和负载设备的损害。同时,优化电网环境及优化输入电压的形式还形成了节能低碳的效果。同时本发明不依靠任何变频系统,既避免了谐波问题,又绿色低碳。

146、5、优化电网谐波问题:本发明实现的平稳的电流变化有助于减少电网中的电压波动,进而降低因电压波动而可能激发的谐波。所以通过优化启动过程可以间接地对谐波问题产生一定的积极影响。

147、6、互备自投闭式机制:本发明提供的控制系统属于互备自投闭式自耦降压起动系统。当一个风机因故障停止运转后,另一个风机可以自动启动,保证系统的正常运行。

本文地址:https://www.jishuxx.com/zhuanli/20240731/177310.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表