用于深度学习人工神经网络中的模拟神经存储器的输入电路的制作方法

- 国知局

- 2024-07-31 19:44:43

本发明公开了用于深度学习人工神经网络中的模拟神经存储器的输入电路的多个实施方案。

背景技术:

1、人工神经网络模拟生物神经网络(动物的中枢神经系统,特别是大脑),并且用于估计或近似可取决于大量输入并且通常未知的函数。人工神经网络通常包括互相交换消息的互连″神经元″层。

2、图1示出了人工神经网络,其中圆圈表示神经元的输入或层。连接部(称为突触)用箭头表示并且具有可以根据经验进行调整的数值权重。这使得神经网络适应于输入并且能够学习。通常,神经网络包括多个输入的层。通常存在神经元的一个或多个中间层,以及提供神经网络的输出的神经元的输出层。处于每一级别的神经元分别地或共同地根据从突触所接收的数据作出决定。

3、在开发用于高性能信息处理的人工神经网络方面的主要挑战中的一个挑战是缺乏足够的硬件技术。实际上,实际神经网络依赖于大量的突触,从而实现神经元之间的高连通性,即非常高的计算并行性。原则上,此类复杂性可通过数字超级计算机或专用图形处理单元集群来实现。然而,相比于生物网络,这些方法除了高成本之外,能量效率也很普通,生物网络主要由于其执行低精度的模拟计算而消耗更少的能量。cmos模拟电路已被用于人工神经网络,但由于给定大量的神经元和突触,大多数cmos实现的突触都过于庞大。

4、申请人先前在美国专利申请15/594,439号中公开了一种利用一个或多个非易失性存储器阵列作为突触的人工(模拟)神经网络,该专利申请以引用方式并入本文。非易失性存储器阵列作为模拟神经存储器操作。神经网络设备包括被配置成接收第一多个输入并从其生成第一多个输出的第一多个突触,以及被配置成接收第一多个输出的第一多个神经元。第一多个突触包括多个存储器单元,其中存储器单元中的每个存储器单元包括:形成于半导体衬底中的间隔开的源极区和漏极区,其中沟道区在源极区和漏极区之间延伸;设置在沟道区的第一部分上方并且与第一部分绝缘的浮栅;以及设置在沟道区的第二部分上方并且与第二部分绝缘的非浮栅。多个存储器单元中的每个存储器单元被配置成存储与浮栅上的多个电子对应的权重值。多个存储器单元被配置成将第一多个输入乘以所存储的权重值以生成第一多个输出。

5、非易失性存储器单元

6、非易失性存储器是众所周知的。例如,美国专利5,029,130(″130专利″),其以引用方式并入本文,公开了分裂栅非易失性存储器单元的阵列,它是一种闪存存储器单元。此类存储器单元210在图2中示出。每个存储器单元210包括形成于半导体衬底12中的源极区14和漏极区16,其间具有沟道区18。浮栅20形成在沟道区18的第一部分上方并且与其绝缘(并控制其电导率),并且形成在源极区14的一部分上方。字线端子22(其通常被耦接到字线)具有设置在沟道区18的第二部分上方并且与该沟道区的第二部分绝缘(并且控制其电导率)的第一部分,以及向上延伸并且位于浮栅20上方的第二部分。浮栅20和字线端子22通过栅极氧化物与衬底12绝缘。位线24耦接到漏极区16。

7、通过将高的正电压置于字线端子22上来对存储器单元210进行擦除(其中电子从浮栅去除),这导致浮栅20上的电子经由福勒-诺德海姆(fn)隧穿从浮栅20到字线端子22隧穿通过中间绝缘体。

8、通过将正电压置于字线端子22上以及将正电压置于源极区14上来由带有热电子的源极侧注入(ssi)编程存储器单元210(其中电子被置于浮栅上)。电子流将从漏极区16流向源极区14。当电子到达字线端子22和浮栅20之间的间隙时,电子将加速并且变热。由于来自浮栅20的静电引力,一些加热的电子将通过栅极氧化物被注入到浮栅20上。

9、通过将正的读取电压置于漏极区16和字线端子22(其接通沟道区18的在字线端子下方的部分)上来读取存储器单元210。如果浮栅20带正电(即,电子被擦除),则沟道区18的在浮栅20下方的部分也被接通,并且电流将流过沟道区18,该沟道区被感测为擦除状态或″1″状态。如果浮栅20带负电(即,通过电子进行了编程),则沟道区的在浮栅20下方的部分被大部分或完全关断,并且电流将不会(或者有很少的电流)流过沟道区18,该沟道区被感测为编程状态或″0″状态。

10、表1示出可施加到存储器单元110的端子以用于执行读取操作、擦除操作和编程操作的典型电压和电流范围:

11、表1:图3的闪存存储器单元210的操作

12、 wl bl sl 读取 2v-3v 0.6v-2v 0v 擦除 约11v-13v 0v 0v 编程 1v-2v 10.5μa-3μa 9v-10v

13、作为其他类型的闪存存储器单元的其他分裂栅存储器单元配置是已知的。例如,图3示出了四栅极存储器单元310,其包括源极区14、漏极区16、在沟道区18的第一部分上方的浮栅20、在沟道区18的第二部分上方的选择栅22(通常联接到字线wl)、在浮栅20上方的控制栅28、以及在源极区14上方的擦除栅30。这种配置在美国专利6,747,310中有所描述,该专利以引用方式并入本文以用于所有目的。这里,除了浮栅20之外,所有的栅极均为非浮栅,这意味着它们电连接到或能够电连接到电压源。编程由来自沟道区18的将自身注入到浮栅20的加热的电子执行。擦除通过从浮栅20隧穿到擦除栅30的电子来执行。

14、表2示出可施加到存储器单元310的端子以用于执行读取操作、擦除操作和编程操作的典型电压和电流范围:

15、表2:图3的闪存存储器单元310的操作

16、 wl/sg bl cg eg sl 读取 1.0v-2v 0.6v-2v 0v-2.6v 0v-2.6v 0v 擦除 -0.5v/0v 0v 0v/-8v 8v-12v 0v 编程 1v 0.1μa-1μa 8v-11v 4.5v-9v 4.5v-5v

17、图4示出三栅极存储器单元410,其为另一种类型的闪存存储器单元。存储器单元410与图3的存储器单元310相同,不同的是存储器单元410没有单独的控制栅。除了没有施加控制栅偏压,擦除操作(由此通过使用擦除栅进行擦除)和读取操作与图3的操作类似。在没有控制栅偏压的情况下,编程操作也被完成,并且结果,在编程操作期间必须在源极线上施加更高的电压,以补偿控制栅偏压的缺乏。

18、表3示出可施加到存储器单元410的端子以用于执行读取操作、擦除操作和编程操作的典型电压和电流范围:

19、表3:图4的闪存存储器单元410的操作

20、 wl/sg bl eg sl 读取 0.7v-2.2v 0.6v-2v 0v-2.6v 0v 擦除 -0.5v/0v 0v 11.5v 0v 编程 1v 0.2μa-3μa 4.5v 7v-9v

21、图5示出叠栅存储器单元510,其为另一种类型的闪存存储器单元。存储器单元510与图2的存储器单元210类似,不同的是浮栅20在整个沟道区18上方延伸,并且控制栅22(其在这里将耦接到字线)在浮栅20上方延伸,由绝缘层(未示出)分开。通过电子从fg到衬底的fn隧穿来进行擦除,通过在沟道18与漏极区16之间的区域处的沟道热电子(che)注入、通过电子从源极区14朝向漏极区16流动以及类似于带有较高控制栅电压的存储器单元210的读取操作来进行编程。

22、表4示出可以施加到存储器单元510和衬底12的端子以用于执行读取操作、擦除操作和编程操作的典型电压范围:

23、表4:图5的闪存存储器单元510的操作

24、 cg bl sl 衬底 读取 2v-5v 0.6v-2v 0v 0v 擦除 -8v至-10v/0v flt flt 8v-10v/15v-20v 编程 8v-12v 3v-5v 0v 0v

25、本文所述的方法和装置可以应用于其他非易失性存储器技术,诸如但不限于finfet分裂栅闪存或堆叠栅闪存存储器、nand闪存、sonos(硅-氧化物-氮化物-氧化物-硅,电荷捕获在氮化物中)、monos(金属-氧化物-氮化物-氧化物-硅,金属电荷捕获在氮化物中)、reram(电阻式ram)、pcm(相变存储器)、mram(磁性ram)、feram(铁电ram)、ct(电荷捕获)存储器、cn(碳管)存储器、otp(双电平或多电平一次可编程)和ceram(关联电子ram)等。

26、为了在人工神经网络中利用包括上述类型的非易失性存储器单元之一的存储器阵列,进行了两个修改。第一,对线路进行配置,使得每个存储器单元可被单独编程、擦除和读取,而不会不利地影响阵列中的其他存储器单元的存储器状态,如下文进一步解释。第二,提供存储器单元的连续(模拟)编程。

27、具体地,阵列中的每个存储器单元的存储器状态(即,浮栅上的电荷)可在独立地并且对其他存储器单元的干扰最小的情况下连续地从完全擦除状态变为完全编程状态。在另一个实施方案,阵列中的每个存储器单元的存储器状态(即,浮栅上的电荷)可在独立地并且对其他存储器单元的干扰最小的情况下连续地从完全编程状态变为完全擦除状态,反之亦然。这意味着单元存储装置是模拟的,或者至少可存储许多离散值(诸如16或64个不同的值)中的一个离散值,这允许对存储器阵列中的所有单元进行非常精确且单独的调谐,并且这使得存储器阵列对于存储和对神经网络的突触权重进行精细调谐是理想的。

28、采用非易失性存储器单元阵列的神经网络

29、图6概念性地示出本实施方案的利用非易失性存储器阵列的神经网络的非限制性示例。该示例将非易失性存储器阵列神经网络用于面部识别应用,但任何其他适当的应用也可使用基于非易失性存储器阵列的神经网络来实现。

30、对于该示例,s0为输入层,其为具有5位精度的32x32像素rgb图像(即,三个32x32像素阵列,分别用于每个颜色r、g和b,每个像素为5位精度)。从输入层s0到层c1的突触cb1在一些情况下应用不同的权重集,并且在其他情况下应用共享权重,并且用3x3像素重叠滤波器(内核)扫描输入图像,从而将滤波器移位1个像素(或如模型所指示,多于1个像素)。具体地,将图像的3x3部分中的9个像素的值(即,称为滤波器或内核)提供给突触cb1,其中将这9个输入值乘以适当的权重,并且在对该乘法的输出求和之后,由cb1的第一突触确定并提供单个输出值以用于生成层c1的特征图中的一者的像素。然后将3x3滤波器在输入层s0内向右移位一个像素(即,添加右侧的三个像素的列,并释放左侧的三个像素的列),由此将该新定位的滤波器中的9个像素值提供给突触cb1,其中将它们乘以相同的权重并且由相关联的突触确定第二单个输出值。继续该过程,直到3x3滤波器在输入层s0的整个32x32像素图像上扫描所有三种颜色和所有位(精度值)。然后使用不同组的权重重复该过程以生成层c1的不同特征图,直到计算出层c1的所有特征图。

31、在层c1处,在本示例中,存在16个特征图,每个特征图具有30x30像素。每个像素是从输入和内核的乘积中提取的新特征像素,因此每个特征图是二维阵列,因此在该示例中,层c1由16层的二维阵列构成(记住本文所引用的层和阵列是逻辑关系,而不必是物理关系,即阵列不必定向于物理二维阵列)。在层c1中的16个特征图中的每个特征图均由应用于滤波器扫描的十六个不同组的突触权重中的一组生成。c1特征图可全部涉及相同图像特征的不同方面,诸如边界识别。例如,第一图(使用第一权重组生成,针对用于生成该第一图的所有扫描而共享)可识别圆形边缘,第二图(使用与第一权重组不同的第二权重组生成)可识别矩形边缘,或某些特征的纵横比,以此类推。

32、在从层c1转到层s1之前,应用激活函数p1(池化),该激活函数将来自每个特征图中连续的非重叠2x2区域的值进行池化。池化函数p1的目的是对邻近位置求均值(或者也可使用max函数),以例如减少边缘位置的依赖性,并在进入下一阶段之前减小数据大小。在层s1处,存在16个15x15特征图(即,十六个每特征图15x15像素的不同阵列)。从层s1到层c2的突触cb2利用4x4滤波器扫描层s1中的图,其中滤波器移位1个像素。在层c2处,存在22个12x12特征图。在从层c2转到层s2之前,应用激活函数p2(池化),该激活函数将来自每个特征图中连续的非重叠2x2区域的值进行池化。在层s2处,存在22个6x6特征图。将激活函数(池化)应用于从层s2到层c3的突触cb3,其中层c3中的每个神经元经由cb3的相应突触连接至层s2中的每个图。在层c3处,存在64个神经元。从层c3到输出层s3的突触cb4完全将c3连接至s3,即层c3中的每个神经元都连接到层s3中的每个神经元。s3处的输出包括10个神经元,其中最高输出神经元确定类。例如,该输出可指示对原始图像的内容的识别或分类。

33、使用非易失性存储器单元的阵列或阵列的一部分来实现每层的突触。

34、图7为可用于该目的的阵列的框图。矢量-矩阵乘法(vmm)阵列32包括非易失性存储器单元,并且用作一层与下一层之间的突触(诸如图6中的cb1、cb2、cb3和cb4)。具体地,vmm阵列32包括非易失性存储器单元阵列33、擦除栅和字线栅解码器34、控制栅解码器35、位线解码器36和源极线解码器37,这些解码器对非易失性存储器单元阵列33的相应输入进行解码。对vmm阵列32的输入可来自擦除栅和字线栅解码器34或来自控制栅解码器35。在该示例中,源极线解码器37还对非易失性存储器单元阵列33的输出进行解码。另选地,位线解码器36可以解码非易失性存储器单元阵列33的输出。

35、非易失性存储器单元阵列33用于两个目的。首先,它存储将由vmm阵列32使用的权重。其次,非易失性存储器单元阵列33有效地将输入与存储在非易失性存储器单元阵列33中的权重相乘并且每个输出线(源极线或位线)将它们相加以产生输出,该输出将作为下一层的输入或最终层的输入。通过执行乘法和加法函数,非易失性存储器单元阵列33消除了对单独的乘法和加法逻辑电路的需要,并且由于其原位存储器计算其也是高功效的。

36、将非易失性存储器单元阵列33的输出提供至差分求和器(诸如求和运算放大器或求和电流镜)38,该差分求和器对非易失性存储器单元阵列33的输出进行求和,以为该卷积创建单个值。差分求和器38被布置用于执行正权重和负权重的求和。

37、然后将差分求和器38的输出值求和后提供至激活函数块39,该激活函数块对输出进行修正。激活函数块39可提供sigmoid、tanh或relu函数。激活函数块39的经修正的输出值成为作为下一层(例如,图6中的层c1)的特征图的元素,然后被应用于下一个突触以产生下一个特征图层或最终层。因此,在该示例中,非易失性存储器单元阵列33构成多个突触(其从现有神经元层或从输入层诸如图像数据库接收它们的输入),并且求和运算放大器38和激活函数块39构成多个神经元。

38、图7中对vmm阵列32的输入(wlx、egx、cgx以及任选的blx和slx)可为模拟电平、二进制电平或数字位(在这种情况下,提供dac以将数字位转换成适当的输入模拟电平),并且输出可为模拟电平、二进制电平或数字位(在这种情况下,提供输出adc以将输出模拟电平转换成数字位)。

39、图8为示出多层vmm阵列32(此处标记为vmm阵列32a、32b、32c、32d和32e)的使用的框图。如图8所示,通过数模转换器31将输入(表示为inputx)从数字转换成模拟,并且将其提供至输入vmm阵列32a。转换的模拟输入可以是电压或电流。第一层的输入d/a转换可通过使用将输入inputx映射到输入vmm阵列32a的矩阵乘法器的适当模拟电平的函数或lut(查找表)来完成。输入转换也可以由模拟至模拟(a/a)转换器完成,以将外部模拟输入转换成到输入vmm阵列32a的映射模拟输入。

40、由输入vmm阵列32a产生的输出被作为到下一个vmm阵列(隐藏级别1)32b的输入提供,该输入继而生成作为下一vmm阵列(隐藏级别2)32c的输入而提供的输出,以此类推。vmm阵列32的各层用作卷积神经网络(cnn)的突触和神经元的不同层。每个vmm阵列32a、32b、32c、32d和32e可以是独立的物理非易失性存储器阵列、或者多个vmm阵列可以利用相同非易失性存储器阵列的不同部分、或者多个vmm阵列可以利用相同物理非易失性存储器阵列的重叠部分。图8所示的示例包含五个层(32a,32b,32c,32d,32e):一个输入层(32a)、两个隐藏层(32b,32c)和两个全连接层(32d,32e)。本领域的普通技术人员将会知道,这仅仅是示例性的,并且相反,系统可包括两个以上的隐藏层和两个以上的完全连接的层。

41、矢量-矩阵乘法(vmm)阵列

42、图9示出神经元vmm阵列900,该神经元vmm阵列特别适用于图3所示的存储器单元310,并且用作输入层与下一层之间的神经元的突触和部件。vmm阵列900包括非易失性存储器单元的存储器阵列901和非易失性参考存储器单元的参考阵列902(在阵列的顶部)。另选地,可将另一个参考阵列置于底部。

43、在vmm阵列900中,控制栅线(诸如控制栅线903)在竖直方向上延伸(因此参考阵列902在行方向上与控制栅线903正交),并且擦除栅线(诸如擦除栅线904)在水平方向上延伸。此处,到vmm阵列900的输入设置在控制栅线(cg0,cg1,cg2,cg3)上,并且vmm阵列900的输出出现在源极线(sl0,sl1)上。在一个实施方案中,仅使用偶数行,并且在另一个实施方案中,仅使用奇数行。置于各源极线(分别为sl0、sl1)上的电流执行来自连接到该特定源极线的存储器单元的所有电流的求和函数。

44、如本文针对神经网络所述,vmm阵列900的非易失性存储器单元(即vmm阵列900的存储器单元310)优选地被配置为在亚阈值区中操作。

45、在弱反转(亚阈值区)中使本文所述的非易失性参考存储器单元和非易失性存储器单元偏压:

46、ids=io*e(vg-vth)/nvt=w*io*e(vg)/nvt,

47、其中w=e(-vth)/nvt

48、其中ids为漏极到源极电流;vg为存储器单元上的栅极电压;vth是存储器单元的阈值电压;vt是热电压=k*t/q,其中k是玻尔兹曼常数,t是以开尔文为单位的温度,并且q是电子电荷;n是斜率因子=1+(cdep/cox),其中cdep=耗尽层的电容,并且cox是栅极氧化物层的电容;io是等于阈值电压的栅极电压下的存储器单元电流,io与(wt/l)*u*cox*(n-1)*vt2成比例,其中u是载流子迁移率,并且wt和l分别是存储器单元的宽度和长度。

49、对于使用存储器单元(诸如参考存储器单元或外围存储器单元)或晶体管将输入电流转换为输入电压的电流到电压对数转换器:

50、vg=n*vt*log[ids/wp*io]

51、其中,wp为参考存储器单元或外围存储器单元的w。

52、对于用作带有电流输入的矢量矩阵乘法器vmm阵列的存储器阵列,输出电流为:

53、iout=wa*io*e(vg)/nvt,即

54、iout=(wa/wp)*iin=w*iin

55、w=e(vthp-vtha)/nvt

56、此处,wa=存储器阵列中的每个存储器单元的w。

57、vthp是外围存储器单元的有效阈值电压,并且vtha是主要(数据)存储器单元的有效阈值电压。注意,晶体管的阈值电压是衬底主体偏置电压的函数,并且可以对表示为vsb的衬底主体偏置电压进行调制以补偿在此类温度下的各种条件。阈值电压vth可以表示为:

58、vth=vth0+γ(sqrt|vsb-2*φf)-sqrt|2*φf|)

59、其中vth0是具有零衬底偏压的阈值电压,φf是表面电位,并且γ是主体效应参数。

60、字线或控制栅可用作输入电压的存储器单元的输入。

61、另选地,本文所述的vmm阵列的闪存存储器单元可被配置成在线性区域中操作:

62、ids=β*(vgs-vth)*vds;β=u*cox*wt/l

63、w=α(vgs-vth)

64、意指线性区域中的权重w与(vgs-vth)成比例

65、字线或控制栅或位线或源极线可以用作在线性区域中操作的存储器单元的输入。位线或源极线可用作存储器单元的输出。

66、对于i-v线性转换器,在线性区域工作的存储器单元(例如参考存储器单元或外围存储器单元)或晶体管可以用来将输入/输出电流线性转换成输入/输出电压。

67、另选地,本文所述的vmm阵列的存储器单元可被配置成在饱和区域中操作:

68、ids=1/2*β*(vgs-vth)2;β=u*cox*wt/l

69、wα(vgs-vth)2,意指权重w与(vgs-vth)2成比例

70、字线、控制栅或擦除栅可以用作在饱和区域中操作的存储器单元的输入。位线或源极线可用作输出神经元的输出。

71、另选地,本文所述的vmm阵列的存储器单元可用于神经网络的每个层或多个层的所有区域或其组合(亚阈值、线性或饱和区域)。

72、美国专利10,748,630号中描述了图7的vmm阵列32的其他实施方案,该专利以引用方式并入本文。如本文所述,源极线或位线可以用作神经元输出(电流求和输出)。

73、图10示出神经元vmm阵列1000,该神经元vmm阵列特别适用于图2所示的存储器单元210,并且用作输入层与下一层之间的突触。vmm阵列1000包括非易失性存储器单元的存储器阵列1003、第一非易失性参考存储器单元的参考阵列1001和第二非易失性参考存储器单元的参考阵列1002。在阵列的列方向上布置的参考阵列1001和1002用于将流入端子blr0、blr1、blr2和blr3的电流输入转换为电压输入wl0、wl1、wl2和wl3。实际上,第一非易失性参考存储器单元和第二非易失性参考存储器单元通过多路复用器1014(仅部分示出)二极管式连接,其中电流输入流入其中。参考单元被调谐(例如,编程)为目标参考电平。目标参考电平由参考微阵列矩阵(未示出)提供。

74、存储器阵列1003用于两个目的。首先,它将vmm阵列1000将使用的权重存储在其相应的存储器单元上。其次,存储器阵列1003有效地将输入(即,在端子blr0、blr1、blr2和blr3中提供的电流输入,参考阵列1001和1002将这些电流输入转换为输入电压,以供应到字线wl0、wl1、wl2和wl3)乘以存储在存储器阵列1003中的权重,然后将所有结果(存储器单元电流)相加,以在相应位线(bl0-bln)上产生输出,该输出将是下一层的输入或最终层的输入。通过执行乘法和加法函数,存储器阵列1003消除了对单独的乘法逻辑电路和加法逻辑电路的需要,并且也是高功效的。这里,电压输入在字线(wl0、wl1、wl2和wl3)上提供,并且输出在读取(推断)操作期间出现在相应位线(bl0-bln)上。置于位线bl0-bln中的每个位线上的电流执行来自连接到该特定位线的所有非易失性存储器单元的电流的求和函数。

75、表5示出用于vmm阵列1000的操作电压和电流。表中的列指示置于用于所选单元的字线、用于未选单元的字线、用于所选单元的位线、用于未选单元的位线、用于所选单元的源极线和用于未选单元的源极线上的电压。行指示读取、擦除和编程操作。

76、表5:图10的vmm阵列1000的操作:

77、 wl wl-未选 bl bl-未选 sl sl-未选 读取 1v-3.5v -0.5v/0v 0.6v-2v(ineuron) 0.6v-2v/0v 0v 0v 擦除 约5v-13v 0v 0v 0v 0v 0v 编程 1v-2v -0.5v/0v 0.1ua-3ua vinh约2.5v 4v-10v 0v-1v/flt

78、图11示出神经元vmm阵列1100,该神经元vmm阵列特别适用于图2所示的存储器单元210,并且用作输入层与下一层之间的神经元的突触和部件。vmm阵列1100包括非易失性存储器单元的存储器阵列1103、第一非易失性参考存储器单元的参考阵列1101和第二非易失性参考存储器单元的参考阵列1102。参考阵列1101和1102在vmm阵列1100的行方向上延伸。vmm阵列与vmm 1000类似,不同的是在vmm阵列1100中,字线在竖直方向上延伸。这里,输入设置在字线(wla0、wlb0、wla1、wlb2、wla2、wlb2、wla3、wlb3)上,并且输出在读取操作期间出现在源极线(sl0、sl1)上。置于各源极线上的电流执行来自连接到该特定源极线的存储器单元的所有电流的求和函数。

79、表6示出用于vmm阵列1100的操作电压和电流。表中的列指示置于用于所选单元的字线、用于未选单元的字线、用于所选单元的位线、用于未选单元的位线、用于所选单元的源极线和用于未选单元的源极线上的电压。行指示读取、擦除和编程操作。

80、表6:图11的vmm阵列1100的操作

81、

82、图12示出神经元vmm阵列1200,该神经元vmm阵列特别适用于图3所示的存储器单元310,并且用作输入层与下一层之间的神经元的突触和部件。vmm阵列1200包括非易失性存储器单元的存储器阵列1203、第一非易失性参考存储器单元的参考阵列1201和第二非易失性参考存储器单元的参考阵列1202。参考阵列1201和1202用于将流入端子blr0、blr1、blr2和blr3中的电流输入转换为电压输入cg0、cg1、cg2和cg3。实际上,第一非易失性参考存储器单元和第二非易失性参考存储器单元通过多路复用器1212(仅部分示出)二极管式连接,其中电流输入通过blr0、blr1、blr2和blr3流入其中。多路复用器1212各自包括相应的多路复用器1205和共源共栅晶体管1204,以确保在读取操作期间第一非易失性参考存储器单元和第二非易失性参考存储器单元中的每一者的位线(诸如blr0)上的电压恒定。将参考单元调谐至目标参考电平。

83、存储器阵列1203用于两个目的。首先,它存储将由vmm阵列1200使用的权重。第二,存储器阵列1203有效地将输入(提供到端子blr0、blr1、blr2和blr3的电流输入,参考阵列1201和1202将这些电流输入转换成输入电压以提供给控制栅(cg0、cg1、cg2和cg3))乘以存储在存储器阵列中的权重,然后将所有结果(单元电流)相加以产生输出,该输出出现在bl0-bln并且将是下一层的输入或最终层的输入。通过执行乘法和加法函数,存储器阵列消除了对单独的乘法和加法逻辑电路的需要,并且也是高功效的。这里,输入提供在控制栅线(cg0、cg1、cg2和cg3)上,输出在读取操作期间出现在位线(bl0-bln)上。置于各位线上的电流执行来自连接到该特定位线的存储器单元的所有电流的求和函数。

84、vmm阵列1200对存储器阵列1203中的非易失性存储器单元实现单向调谐。也就是说,每个非易失性存储器单元被擦除,然后被部分编程,直到达到浮栅上的所需电荷。如果在浮栅上放置过多电荷(使得错误的值存储在单元中),则单元被擦除,并且部分编程操作的序列重新开始。如图所示,共享同一擦除栅(诸如eg0或eg1)的两行被一起擦除(其被称为页面擦除),并且此后,每个单元被部分编程,直到达到浮栅上的所需电荷。

85、表7示出用于vmm阵列1200的操作电压和电流。表中的列指示置于用于所选单元的字线、用于未选单元的字线、用于所选单元的位线、用于未选单元的位线、用于所选单元的控制栅、用于与所选单元相同扇区中的未选单元的控制栅、用于与所选单元不同扇区中的未选单元的控制栅、用于所选单元的擦除栅、用于未选单元的擦除栅、用于所选单元的源极线、用于未选单元的源极线上的电压。行指示读取、擦除和编程操作。

86、表7:图12的vmm阵列1200的操作

87、

88、图13示出神经元vmm阵列1300,该神经元vmm阵列特别适用于图3所示的存储器单元310,并且用作输入层与下一层之间的神经元的突触和部件。vmm阵列1300包括非易失性存储器单元的存储器阵列1303、第一非易失性参考存储器单元的参考阵列1301和第二非易失性参考存储器单元的参考阵列1302。eg线egr0、eg0、eg1和egr1竖直延伸,而cg线cg0、cg1、cg2和cg3以及sl线wl0、wl1、wl2和wl3水平延伸。vmm阵列1300与vmm阵列1400类似,不同的是vmm阵列1300实现双向调谐,其中每个单独的单元可以根据需要被完全擦除、部分编程和部分擦除,以由于使用单独的eg线而在浮栅上达到期望的电荷量。如图所示,参考阵列1301和1302将端子blr0、blr1、blr2和blr3中的输入电流转换为要在行方向上施加到存储器单元的控制栅电压cg0、cg1、cg2和cg3(通过经由多路复用器1314的二极管式连接的参考单元的动作)。电流输出(神经元)在位线bl0-bln中,其中每个位线对来自连接到该特定位线的非易失性存储器单元的所有电流求和。

89、表8示出用于vmm阵列1300的操作电压和电流。表中的列指示置于用于所选单元的字线、用于未选单元的字线、用于所选单元的位线、用于未选单元的位线、用于所选单元的控制栅、用于与所选单元相同扇区中的未选单元的控制栅、用于与所选单元不同扇区中的未选单元的控制栅、用于所选单元的擦除栅、用于未选单元的擦除栅、用于所选单元的源极线、用于未选单元的源极线上的电压。行指示读取、擦除和编程操作。

90、表8:图13的vmm阵列1300的操作

91、

92、图22示出神经元vmm阵列2200,该神经元vmm阵列特别适用于图2所示的存储器单元210,并且用作输入层与下一层之间的神经元的突触和部件。在vmm阵列2200中,输入input0、......、inputn分别在位线bl0、......bln上被接收,并且输出output1、output2、output3和output4分别在源极线sl0、sl1、sl2和sl3上生成。

93、图23示出神经元vmm阵列2300,该神经元vmm阵列特别适用于图2所示的存储器单元210,并且用作输入层与下一层之间的神经元的突触和部件。在该示例中,输入input0、input1、input2和input3分别在源极线sl0、sl1、sl2和sl3上被接收,并且输出output0、......outputn在位线bl0、......、bln上生成。

94、图24示出神经元vmm阵列2400,该神经元vmm阵列特别适用于图2所示的存储器单元210,并且用作输入层与下一层之间的神经元的突触和部件。在该示例中,输入input0、......、inputm分别在字线wl0、......、wlm上被接收,并且输出output0、......outputn在位线bl0、......、bln上生成。

95、图25示出神经元vmm阵列2500,该神经元vmm阵列特别适用于图3所示的存储器单元310,并且用作输入层与下一层之间的神经元的突触和部件。在该示例中,输入input0、......、inputm分别在字线wl0、......、wlm上被接收,并且输出output0、......outputn在位线bl0、......、bln上生成。

96、图26示出神经元vmm阵列2600,该神经元vmm阵列特别适用于图4所示的存储器单元410,并且用作输入层与下一层之间的神经元的突触和部件。在该示例中,输入input0、......、inputn分别在竖直控制栅线cg0、......、cgn上被接收,并且输出output1和output2在源极线sl0和sl1上生成。

97、图27示出神经元vmm阵列2700,该神经元vmm阵列特别适用于图4所示的存储器单元410,并且用作输入层与下一层之间的神经元的突触和部件。在该示例中,输入input0至inputn分别在位线控制栅极2701-1、2701-2至2701-(n-1)和2701-n的栅极上被接收,这些栅极分别耦接到位线bl0、......、bln。示例性输出output1和output2在源极线sl0和sl1上生成。

98、图28示出神经元vmm阵列2800,该神经元vmm阵列特别适用于图3所示的存储器单元310、图5所示的存储器单元510和图7所示的存储器单元710,并且用作输入层与下一层之间的神经元的突触和部件。在该示例中,输入input0、......、inputm在字线wl0、......、wlm上被接收,并且输出output0、......、outputn分别在位线bl0、......、bln上生成。

99、图29示出神经元vmm阵列2900,该神经元vmm阵列特别适用于图3所示的存储器单元310、图5所示的存储器单元510和图7所示的存储器单元710,并且用作输入层与下一层之间的神经元的突触和部件。在该示例中,输入input0至inputm在控制栅线cg0至cgm上被接收。输出output0、......、outputn分别在竖直源极线sl0、......、sln上生成,其中每个源极线sli耦接到列i中的所有存储器单元的源极线。

100、图30示出神经元vmm阵列3000,该神经元vmm阵列特别适用于图3所示的存储器单元310、图5所示的存储器单元510和图7所示的存储器单元710,并且用作输入层与下一层之间的神经元的突触和部件。在该示例中,输入input0、......、inputm在控制栅线cg0、......、cgm上被接收。输出output0、......、outputn分别在竖直位线bl0、......、bln上生成,其中每个位线bli耦接到列i中的所有存储器单元的位线。

101、长短期记忆

102、现有技术包括被称为长短期记忆(lstm)的概念。lstm单元通常用于神经网络中。lstm允许神经网络在预定的任意时间间隔内记住信息并在后续操作中使用该信息。常规的lstm单元包括单元、输入门、输出门和遗忘门。三个门调控进出单元的信息流以及信息在lstm中被记住的时间间隔。vmm尤其可用于lstm单元中。

103、图14示出示例性lstm 1400。该示例中的lstm 1400包括单元1401、1402、1403和1404。单元1401接收输入矢量x0并生成输出矢量h0和单元状态矢量c0。单元1402接收输入矢量x1、来自单元1401的输出矢量(隐藏状态)h0和来自单元1401的单元状态c0,并生成输出矢量h1和单元状态矢量c1。单元1403接收输入矢量x2、来自单元1402的输出矢量(隐藏状态)h1和来自单元1402的单元状态c1,并生成输出矢量h2和单元状态矢量c2。单元1404接收输入矢量x3、来自单元1403的输出矢量(隐藏状态)h2和来自单元1403的单元状态c2,并生成输出矢量h3。可以使用另外的单元,并且具有四个单元的lstm仅仅是示例。

104、图15示出可用于图14中的单元1401、1402、1403和1404的lstm单元1500的示例性具体实施。lstm单元1500接收输入矢量x(t)、来自前一单元的单元状态矢量c(t-1)和来自前一单元的输出矢量h(t-1),并生成单元状态矢量c(t)和输出矢量h(t)。

105、lstm单元1500包括sigmoid函数设备1501、1502和1503,每个sigmoid函数设备应用0与1之间的一个数字来控制允许输入矢量中的每个分量有多少通过到达输出矢量。lstm单元1500还包括用于将双曲线正切函数应用于输入矢量的tanh设备1504和1505、用于将两个矢量相乘的乘法器设备1506、1507和1508以及用于将两个矢量相加的加法设备1509。输出矢量h(t)可被提供给系统中的下一个lstm单元,或者其可被访问用于其他目的。

106、图16示出lstm单元1600,该lstm单元为lstm单元1500的具体实施的示例。为了方便读者,lstm单元1600中使用与lstm单元1500相同的编号。sigmoid函数设备1501、1502和1503以及tanh设备1504各自包括多个vmm阵列1601和激活函数块1602。因此,可以看出,vmm阵列在某些神经网络系统中使用的lstm单元中特别有用。乘法器设备1506、1507和1508和加法设备1509以数字方式或模拟方式实施。激活函数块1602可以数字方式或模拟方式实施。

107、lstm单元1600的另选形式(以及lstm单元1500的具体实施的另一示例)在图17中示出。在图17中,sigmoid函数设备1501、1502和1503以及tanh设备1504以时分复用方式共享相同的物理硬件(vmm阵列1701和激活函数块1702)。lstm单元1700还包括将两个矢量相乘的乘法器设备1703,将两个矢量相加的加法设备1708,tanh设备1505(其包括激活函数块1702),当从sigmoid函数块1702输出值i(t)时存储该值的寄存器1707,当值f(t)*c(t-1)通过多路复用器1710从乘法器设备1703输出时存储该值的寄存器1704,当值i(t)*u(t)通过多路复用器1710从乘法器设备1703输出时存储该值的寄存器1705,以及当值o(t)*c~(t)通过多路复用器1710从乘法器设备1703输出时存储该值的寄存器1706,以及多路复用器1709。

108、lstm单元1600包含多组vmm阵列1601和相应的激活函数块1602,lstm单元1700仅包含一组vmm阵列1701和激活函数块1702,它们用于表示lstm单元1700的实施方案中的多个层。lstm单元1700将需要比lstm 1600少的空间,因为与lstm单元1600相比,lstm单元1700只需要其1/4的空间用于vmm和激活函数块。

109、还可理解,lstm单元通常将包括多个vmm阵列,每个vmm阵列需要由vmm阵列之外的某些电路区块(诸如求和器和激活电路区块以及高电压生成块)提供的功能。为每个vmm阵列提供单独的电路区块将需要半导体设备内的大量空间,并且将在一定程度上是低效的。因此,下文所述的实施方案减小vmm阵列本身之外所需的电路。

110、门控循环单元

111、模拟vmm具体实施可用于门控循环单元(gru)系统。gru是循环神经网络中的门控机制。gru类似于lstm,不同的是gru单元一般包含比lstm单元更少的部件。

112、图18示出示例性gru 1800。该示例中的gru 1800包括单元1801、1802、1803和1804。单元1801接收输入矢量x0并生成输出矢量h0。单元1802接收输入矢量x1、来自单元1801的输出矢量h0并生成输出矢量h1。单元1803接收输入矢量x2和来自单元1802的输出矢量(隐藏状态)h1并生成输出矢量h2。单元1804接收输入矢量x3和来自单元1803的输出矢量(隐藏状态)h2并生成输出矢量h3。可以使用另外的单元,并且具有四个单元的gru仅仅是示例。

113、图19示出可用于图18的单元1801、1802、1803和1804的gru单元1900的示例性具体实施。gru单元1900接收输入矢量x(t)和来自前一个gru单元的输出矢量h(t-1),并生成输出矢量h(t)。gru单元1900包括sigmoid函数设备1901和1902,每个sigmoid函数设备将0与1之间的数字应用于来自输出矢量h(t-1)和输入矢量x(t)的分量。gru单元1900还包括用于将双曲线正切函数应用于输入矢量的tanh设备1903,用于将两个矢量相相乘的多个乘法器设备1904、1905和1906,用于将两个矢量相相加的加法设备1907,以及用于从1中减去输入以生成输出的互补设备1908。

114、图20示出gru单元2000,该gru单元为gru单元1900的具体实施的示例。为了方便读者,gru单元2000中使用与gru单元1900相同的编号。如图20所示,sigmoid函数设备1901和1902以及tanh设备1903各自包括多个vmm阵列2001和激活函数块2002。因此,可以看出,vmm阵列在某些神经网络系统中使用的gru单元中特别有用。乘法器设备1904、1905和1906、加法设备1907以及互补设备1908以数字方式或模拟方式实施。激活函数块2002可以数字方式或模拟方式实施。

115、gru单元2000的另选形式(以及gru单元1900的具体实施的另一示例)在图21中示出。在图21中,gru单元2100利用vmm阵列2101和激活函数块2102,该激活函数块在被配置为sigmoid函数时应用0与1之间的数字来控制允许输入矢量中的每个分量有多少通过到达输出矢量。在图21中,sigmoid函数设备1901和1902以及tanh设备1903以时分复用方式共享相同的物理硬件(vmm阵列2101和激活函数块2102)。gru单元2100还包括将两个矢量相乘的乘法器设备2103,将两个矢量相加的加法设备2105,从1减去输入以生成输出的互补设备2109,多路复用器2104,当值h(t-1)*r(t)通过多路复用器2104从乘法器设备2103输出时保持该值的寄存器2106,当值h(t-1)*z(t)通过多路复用器2104从乘法器设备2103输出时保持该值的寄存器2107,以及当值h^(t)*(1-z(t))通过多路复用器2104从乘法器设备2103输出时保持该值的寄存器2108。

116、gru单元2000包含多组vmm阵列2001和激活函数块2002,gru单元2100仅包含一组vmm阵列2101和激活函数块2102,它们用于表示gru单元2100的实施方案中的多个层。gru单元2100将需要比gru单元2000更少的空间,因为与gru单元2000相比,gru单元2100只需要其1/3的空间用于vmm和激活函数块。

117、还可以理解的是,gru系统通常将包括多个vmm阵列,每个vmm阵列需要由vmm阵列之外的某些电路区块(诸如求和器和激活函数块以及高电压生成块)提供的功能。为每个vmm阵列提供单独的电路区块将需要半导体设备内的大量空间,并且将在一定程度上是低效的。因此,下文所述的实施方案减小vmm阵列本身之外所需的电路。

118、vmm阵列的输入可为模拟电平、二进制电平、脉冲、时间调制脉冲或数字位(在这种情况下,需要dac来将数字位转换成适当的输入模拟电平),并且输出可为模拟电平、二进制电平、定时脉冲、脉冲或数字位(在这种情况下,需要输出adc来将输出模拟电平转换成数字位)。

119、一般来讲,对于vmm阵列中的每个存储器单元,每个权重w可由单个存储器单元或由差分单元或由两个混合存储器单元(2个单元的平均值)来实现。在差分单元的情况下,需要两个存储器单元来实现权重w作为差分权重(w=w+-w-)。在两个混合存储器单元中,需要两个存储器单元来实现权重w作为两个单元的平均值。

120、图31示出vmm系统3100。在一些实施方案中,存储在vmm阵列中的权重w被存储为差分对w+(正权重)和w-(负权重),其中w=(w+)-(w-)。在vmm系统3100中,位线的一半被指定为w+线,即连接到将存储正权重w+的存储器单元的位线,并且位线的另一半被指定为w-线,即连接到实现负权重w-的存储器单元的位线。w-线以交替方式散布在w+线之间。减法操作由求和电路(诸如求和电路3101和3102)执行,该求和电路从w+线和w-线接收电流。w+线的输出和w-的输出组合在一起,以对于所有(w+、w-)线对的每个(w+、w-)单元对有效地给出w=w+-w-。虽然上文已关于以交替方式散布于w+线之间的w-线进行描述,但在其它实施方案中,w+线和w-线可任意位于阵列中的任何地方。

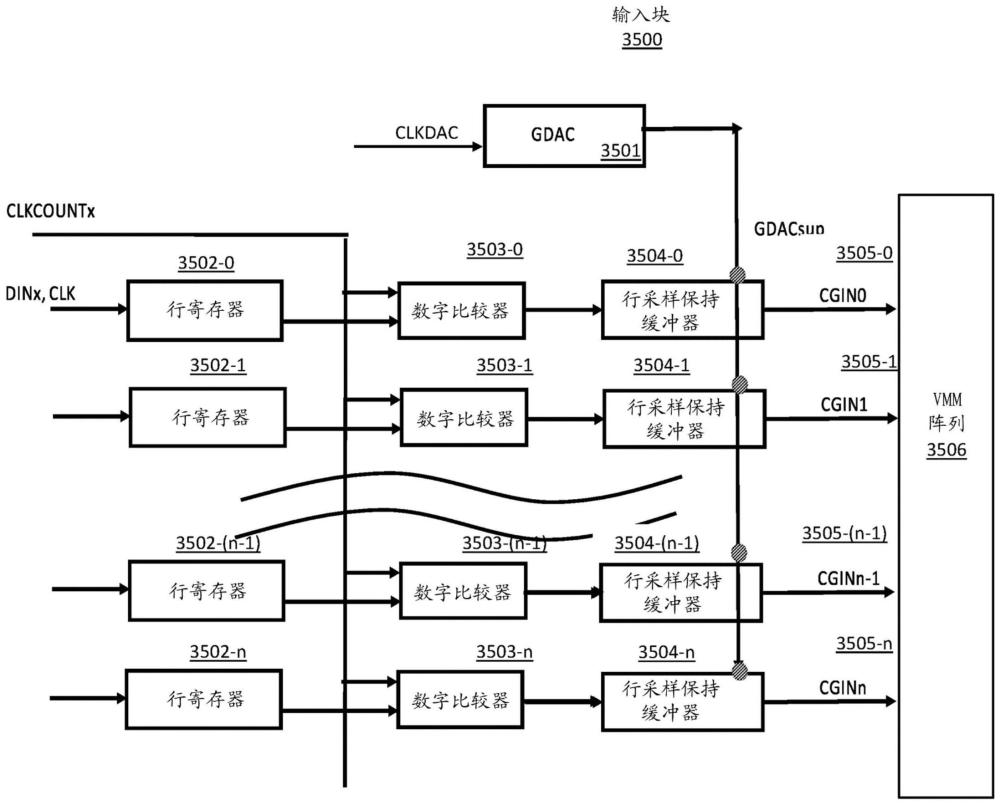

121、图32示出另一实施方案。在vmm系统3210中,在第一阵列3211中实现正权重w+,并且在第二阵列3212中实现负权重w-,第二阵列3212与第一阵列分开,并且所得权重通过求和电路3213适当地组合在一起。

122、图33示出了vmm系统3300,存储在vmm中的权重w被存储为差分对w+(正权重)和w-(负权重),其中w=(w+)-(w-)。vmm系统3300包括阵列3301和阵列3302。阵列3301和阵列3302中的每个阵列中的位线的一半被指定为w+线,即连接到将存储正权重w+的存储器单元的位线,并且阵列3301和阵列3302中的每个阵列中的位线的另一半被指定为w-线,即连接到实现负权重w-的存储器单元的位线。w-线以交替方式散布在w+线之间。减法操作由求和电路(诸如求和电路3303、3304、3305和3306)执行,该求和电路从w+线和w-线接收电流。来自每个阵列3301、3302的w+线的输出和w-的输出分别组合在一起,以对于所有(w+、w-)线对的每个(w+、w-)单元对有效地给出w=w+-w-。另外,来自每个阵列3301和3302的w值可以通过求和电路3307和3308进一步组合,使得每个w值是来自阵列3301的w值减去来自阵列3302的w值的结果,这意味着来自求和电路3307和3308的最终结果是两个差值中的一个差值。

123、要擦除和编程在模拟神经存储器系统中使用的每个非易失性存储器单元,以在浮栅中保持非常特定且精确的电荷量(即电子数量)。例如,每个浮栅应当保持n个不同值中的一个,其中n是可由每个单元指示的不同权重的数量。n的示例包括16、32、64、128和256。

124、类似地,读取操作应当能够准确地辨别n个不同的电平。

125、在vmm系统中需要改善的输入块,其可用于快速且准确地将电流或电压施加到待编程、读取或擦除的单元行的一条或多条线。

技术实现思路

1、本发明公开了用于深度学习人工神经网络中的模拟神经存储器的输入电路的多个实施方案。

本文地址:https://www.jishuxx.com/zhuanli/20240731/183809.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。