一种基于自监督和多任务学习的多模态情感识别方法

- 国知局

- 2024-08-22 14:56:29

本发明涉及情感识别领域,具体涉及一种基于自监督和多任务学习的多模态情感识别方法。

背景技术:

1、随着人工智能技术的高速发展,人们的日常生活已经逐步迈向智能化,但距离真正的智能化时代仍需时间和进一步的技术发展,从人机交互方面来说,目前的智能系统是一个“冷冰冰”的系统,没有人类的情感感知能力。研究如何使机器具备情感理解能力,识别并响应人类的情绪,进一步优化人机交互,是未来研究的重要方向。情感识别作为让机器感知人类情感的核心技术,已经在医疗康复、远程教育、智能驾驶等多个领域成为研究焦点。

2、人类在表达情感时,语音语调、面部表情和文字表达都是很重要的载体,因此多模态情感识别受到越来越多的关注。如今,多模态情感识别研究取得了很大的进步,但仍然面临着诸多挑战:从常用的多模态情感数据集中可以看出,大多数现有的多模态情感数据集主要提供视频层面的的综合情感标签,缺少每个模态独立的情感标签。为了有效地表示各个模态的情感,理想的数据集应当同时包含模态特征的一致性和差异性。但是,由于现有的多模态标注不够细致,在捕捉模态间的差异性方面遇到了困难。想要获得单模态的情感标签,就需要进行人工标注,这不仅会耗费巨大的人力成本,而且效率低下,情感标注的准确性也无法得到保障。

技术实现思路

1、针对上述多模态情感数据集缺少单模态情感标签的问题,本发明提供一种基于自监督和多任务学习的多模态情感识别方法,基于自监督和多任务学习的多模态情感识别模型(self-supervised and multi-task multi-modal emotion recognition,smt-mer)通过引入自监督学习的标签生成模块,以解决单模态情感标注缺失问题,显著降低了人工标注的需求和成本。并使用多任务学习,使模型更好地捕获模态间差异性,有效提高了情感识别的准确性。

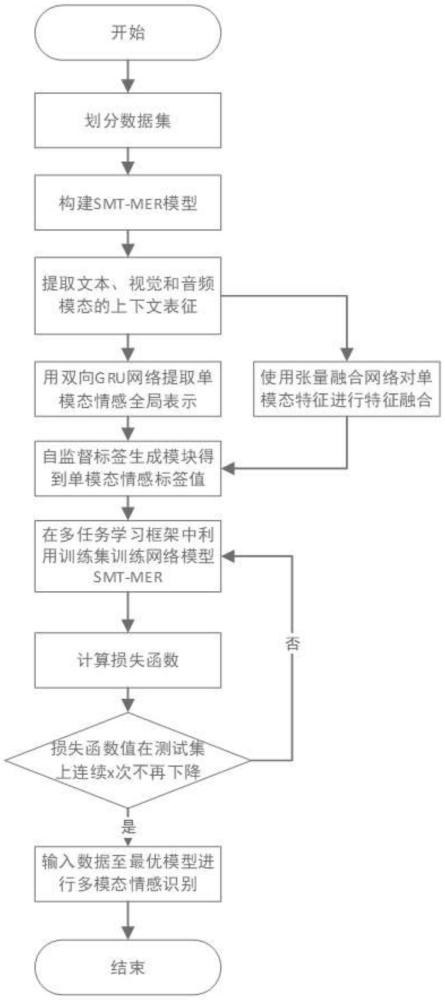

2、为了实现上述目的,本发明采用的技术方案为:一种基于自监督和多任务学习的多模态情感识别方法,包括以下步骤:

3、1)选择数据集d,将数据集d划分为训练集dtrain和测试集dtest;其中,所述数据集d记为数据集d中的每一个元素di对应一个视频片段,由三元组(iti,iai,ivi)组成,iti,iai,ivi分别表示第i个视频片段的文本数据、音频数据和视觉数据;

4、2)构建基于自监督和多任务学习的多模态情感识别模型smt-mer,所述smt-mer模型包括单模态数据预处理模块、多模态张量融合模块、双向gru单模态特征提取模块和自监督标签生成模块;其中,所述单模态数据预处理模块由bert模型、lstm模型组成,bert模型用于对文本数据进行特征提取,lstm模型用于对音频数据和视觉数据进行特征提取;所述多模态张量融合模块用于融合三个单模态的数据特征;所述双向gru单模态特征提取模块包括前向gru网络gruf和后向gru网络grub,用于进一步提取单模态的全局特征表示;所述自监督标签生成模块用于生成单模态数据标签;

5、3)对数据集d中每一个元组进行数据预处理,提取每个元组的单模态特征,所述单模态特征包括文本模态的上下文表征ft、音频模态的上下文表征fa和视觉模态的上下文表征fv;

6、4)利用多模态张量融合模块对数据集d中每一个元组di的文本模态的上下文表征fti、音频模态的上下文表征fai和视觉模态的上下文表征fvi进行特征融合,得到di融合后的多模态向量fmi;

7、5)将数据集d中所有元组的文本模态的上下文表征fti、音频模态的上下文表征fai和视觉模态的上下文表征fvi输入到双向gru单模态特征提取模块中,计算文本模态的全局表示音频模态的全局表示和视觉模态的全局表示

8、6)利用自监督标签生成模块生成单模态标签值ys;

9、7)利用训练集dtrain训练多模态情感识别模型smt-mer;所述训练方法为:利用多任务学习框架,采用硬参数共享策略,同时训练上述步骤4)的多模态情感融合任务和上述步骤5)的单模态情感识别任务;

10、8)计算损失函数值ltotal,计算公式如下:

11、

12、式中:n是训练集中的样本数量,{m,s}分别代表多模态任务和单模态任务,表示预测值,y代表真实值,是指单模态任务s的第i个样本的训练权重;

13、9)用测试集dtest测试训练后smt-mer模型的性能,当损失函数值ltotal在测试集上连续x次不再下降时,停止训练,输出训练好的最优模型权重文件best.pt,转步骤10),否则,转步骤7)重新训练;

14、10)输入待识别的多模态数据,利用最优模型权重文件best.pt进行多模态情感识别,输出情感分析结果,具体公式如下:

15、result=wkyk+bk

16、式中:w是各模态参数权重,b是偏置,y是预测值,k分别表示多模态、文本模态、音频模态和视觉模态。

17、进一步的,上述步骤3)中第i个元组di的单模态特征提取方法如下:

18、文本模态的上下文表征fti提取公式为:式中:iti表示第i个文本信息,表示预训练bert模型的参数;音频模态的上下文表征fai提取公式为:式中:iai表示i个音频信号,表示预训练lstm模型的参数;视觉模态的上下文表征fvi提取公式为:式中:ivi表示i个视觉信号,表示预训练lstm模型的参数。

19、进一步的,上述步骤5)中第i个元组的文本模态、音频模态和视觉模态的全局表示的计算公式如下:

20、

21、

22、

23、式中:gruf表示前向gru网络,grub表示后向gru网络,表示向量拼接操作。

24、进一步的,上述步骤6)中生成单模态标签值包括以下步骤:

25、6.1)计算文本、音频、视觉以及多模态情感正中心和负中心的值,具体公式如下:

26、

27、

28、式中:k=t时表示文本模态,k=a时表示音频模态,k=v时表示视觉模态,k=m时表示多模态,n表示训练样本数量,i表示指数函数,表示模态k中第i个样本的全局表示;

29、6.2)计算文本、音频、视觉以及多模态表示到情感正中心和负中心的余弦相似度,计算公式如下:

30、

31、

32、式中:xk·c表示向量xk与c的点积,||xk‖和||c||分别是xk和c的欧几里得范数;

33、6.3)分别计算文本、音频、视觉以及多模态表示到情感正中心和负中心的计算相对距离值,具体公式如下:

34、

35、式中:ε是一个趋于0的无限小数,用来应对分母为0时的特殊情况;

36、6.4)计算单模态情感标签初值y's,计算公式如下:

37、

38、式中:s∈{t,a,v},m表示多模态;

39、6.5)计算单模态的情感标签值ys,计算公式如下:

40、

41、本发明提供了一种用于多模态情感识别的方法,提出了一种基于自监督和多任务学习的多模态情感识别模型smt-mer,使用自监督学习方法解决了单模态情感标注缺失的问题,节省了人工标注的成本并提高了情感标签的标注质量,同时,通过多任务学习,加强了模态间信息的交互共享,有效提高了多模态情感识别的准确性。

本文地址:https://www.jishuxx.com/zhuanli/20240822/280499.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表