一种基于光照感知的无人机多模态图像融合方法

- 国知局

- 2024-08-30 14:28:12

本发明涉及计算机视觉,具体为一种基于光照感知的无人机多模态图像融合方法。

背景技术:

1、随着传感器技术的蓬勃发展和其制造成本的下降,多传感器被大范围应用到民用与国防的产业中;

2、多传感器的应用使得各设备的信息源不再单一,信息量增加,无人机飞行过程中利用多源信息的互补优势能使无人系统更准确地跟踪识别目标,目标跟踪是计算机视觉领域的重要研究方向;

3、在无人机侦查过程中,存在目标遮挡、光照不足、气象条件恶劣等情况,传统基于单模态rgb的跟踪算法精度较差,主要原因是可见光的光谱成像范围相比其他模态较小,在光照条件不充足、跟踪目标出现严重遮挡的情况下,可见光成像效果较差,其中包含的有用信息较少,会增加后续目标跟踪等视觉任务的难度,因此,单个传感器捕获的图像不能有效且全面地描述成像场景;

4、目前改善这一不足的一种有效措施是通过融合不同模态图像中的互补信息以生成单个图像,其中包含更丰富的信息,可以对成像场景或目标进行更全面的描述,并且更有利于进行后续的目标跟踪等视觉任务,可见光图像和红外图像可以形成很好的互补信息,因此,可见光模态与红外模态的图像融合是多模态图像融合的主要研究领域,但在不同的光照条件下,可见光与红外两种模态融合时,两种模态的成像效果有很大差异,在光照不充足的情况下,可见光成像效果较差,难以用于后续的目标跟踪等视觉任务;

5、针对上述问题,发明人提出一种基于光照感知的无人机多模态图像融合方法用于解决上述问题。

技术实现思路

1、为了解决在不同的光照条件下,可见光与红外两种模态融合时,两种模态的成像效果有很大差异,在光照不充足的情况下,可见光成像效果较差,难以用于后续的目标跟踪等视觉任务的问题,引入光照感知模块来改善可见光与红外图像融合过程中由光照强烈变化引起的成像效果问题;本发明的目的在于提供一种基于光照感知的无人机多模态图像融合方法。

2、为解决上述技术问题,本发明采用如下技术方案:一种基于光照感知的无人机多模态图像融合方法,包括两部分,第一部分为针对可见光图像中包含的光照信息设计的光照感知网络,第二部分为对已配准的可见光模态和红外模态图像对的融合图像网络,光照感知网络和融合图像网络以卷积神经网络作为骨干网络,在卷积神经网络中,通过卷积操作在预先设计好的融合规则和损失函数的指导下完成模型的特征提取和特征融合,由以下步骤组成:

3、s1、损失函数

4、损失函数是用来衡量模型预测结果与真实标签之间差异的函数,用于评估模型的性能以及指导参数的优化调整方向。因此,在训练过程中损失函数通过计算模型的预测值与真实标签之间的差异,并利用损失函数的梯度指导参数的更新,神经网络能够逐渐调整权重和偏置,使得模型对输入数据的预测更加准确;

5、s2、激活函数

6、激活函数是神经网络中的一种非线性函数,给神经元的输出加入了非线性变换,从而使神经网络可以学习和拟合更复杂的函数关系,光照感知网络和融合图像网络均采用leaky relu激活函数,leaky relu激活函数是一种修正线性单元的变体,它在非负数部分保持线性,而在负数部分引入一个小的斜率,这个斜率通常是一个小的正数,以防止梯度消失问题;

7、s3、卷积核

8、在卷积神经网络中,卷积核是一个小矩阵,用于特征提取和特征映射,它通过卷积操作在输入数据上滑动进行特征提取,从而帮助网络学习具有平移不变性的特征,不同的卷积核可以提取不同的特征,如边缘、纹理,卷积核的参数在整个输入数据上是共享的,这样减少了需要训练的参数数量,降低了过拟合的风险。

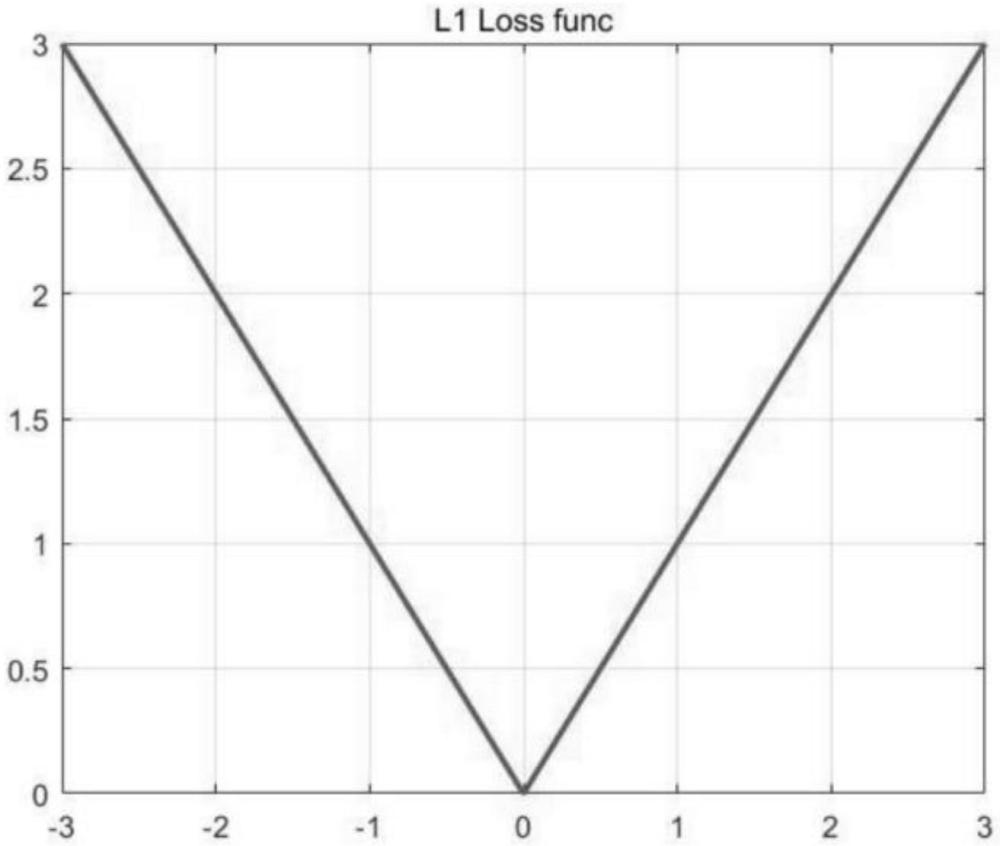

9、优选地,在s1中,可见光模态和红外模态图像的融合图像网络采用l1范数损失函数,l1范数损失函数常用于回归模型,衡量模型预测值与真实值之间的差异,它的计算方式是将每个预测值和真实值的差的绝对值相加,它能够促使模型的预测值与真实值接近,并且相比于l2范数损失函数,更注重数据中的极端值,更加鲁棒,l1范数损失函数对于包含n个样本的batch数据d(x,y),x为神经网络的输出,y是真实的得分,x与y同维度,第n个样本的损失值ln计算如下式:

10、ln=|xn-yn|

11、优选地,在s2中,leaky relu激活函数的数学表达式如下:

12、

13、其中negat i ve_s l ope是x为负数时需要的一个系数,用来控制负斜率的角度,默认值为1e-2。

14、优选地,在s3中,光照感知网络采用vgg16骨干网络,用两个3*3卷积核代替一个5*5卷积核,在保证有相同感受野的前提下,提升了网络深度,并且多层非线性层可以增加网络深度来学习更复杂的模式,而且参数更少。

15、与现有技术相比,本发明的有益效果在于:

16、1、基于光照感知的多模态融合方法,使融合结果的细节信息更加丰富,显著信息更明显;

17、2、采用vgg16骨干网络,通过使用两个3*3卷积核代替一个5*5卷积核,加深了网络的非线性层,减少了参数量,增加了网络深度,增强了网络的特征提取能力和表示能力,降低过拟合风险,从而提升模型性能;

18、3、该基于光照感知的多模态图像融合方法生成的融合图像包含更丰富的细节信息,具有较高的清晰度和对比度,整个模型更有利于后续的目标跟踪等计算机视觉任务。

技术特征:1.一种基于光照感知的无人机多模态图像融合方法,包括两部分,第一部分为针对可见光图像中包含的光照信息设计的光照感知网络,第二部分为对已配准的可见光模态和红外模态图像对的融合图像网络,光照感知网络和融合图像网络以卷积神经网络作为骨干网络,在卷积神经网络中,通过卷积操作在预先设计好的融合规则和损失函数的指导下完成模型的特征提取和特征融合,其特征在于,由以下步骤组成:

2.如权利要求1所述的一种基于光照感知的无人机多模态图像融合方法,其特征在于,在s1中,可见光模态和红外模态图像的融合图像网络采用l1范数损失函数,l1范数损失函数常用于回归模型,衡量模型预测值与真实值之间的差异,它的计算方式是将每个预测值和真实值的差的绝对值相加,它能够促使模型的预测值与真实值接近,并且相比于l2范数损失函数,更注重数据中的极端值,更加鲁棒,l1范数损失函数对于包含n个样本的batch数据d(x,y),x为神经网络的输出,y是真实的得分,x与y同维度,第n个样本的损失值ln计算如下式:

3.如权利要求1所述的一种基于光照感知的无人机多模态图像融合方法,其特征在于,在s2中,leaky relu激活函数的数学表达式如下:

4.如权利要求1所述的一种基于光照感知的无人机多模态图像融合方法,其特征在于,在s3中,光照感知网络采用vgg16骨干网络,用两个3*3卷积核代替一个5*5卷积核,在保证有相同感受野的前提下,提升了网络深度,并且多层非线性层可以增加网络深度来学习更复杂的模式,而且参数更少。

技术总结本发明公开一种基于光照感知的无人机多模态图像融合方法,涉及计算机视觉技术领域;并且本发明包括两部分,第一部分为针对可见光图像中包含的光照信息设计的光照感知网络,第二部分为对已配准的可见光模态和红外模态图像对的融合图像网络;本发明使融合结果的细节信息更加丰富,显著信息更明显,采用VGG16骨干网络,通过使用两个3*3卷积核代替一个5*5卷积核,加深了网络的非线性层,减少了参数量,增加了网络深度,增强了网络的特征提取能力和表示能力,降低过拟合风险,从而提升模型性能,同时生成的融合图像包含更丰富的细节信息,具有较高的清晰度和对比度,整个模型更有利于后续的目标跟踪等计算机视觉任务。技术研发人员:沈博,高帆,姚远,田心宇,杨刚,贾伟受保护的技术使用者:西北工业大学技术研发日:技术公布日:2024/8/27本文地址:https://www.jishuxx.com/zhuanli/20240830/282214.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。