第一节点、第三节点、第五节点以及由其执行的、用于处置正在进行的分布式机器学习或联邦学习过程的方法与流程

- 国知局

- 2024-09-11 14:14:12

本公开一般涉及第一节点以及由其执行的、用于处置正在进行的分布式机器学习或联邦学习过程的方法。本公开一般也涉及第三节点,以及由其执行的、用于处置正在进行的分布式机器学习或联邦学习过程的方法。本公开一般还涉及第五节点,以及由其执行的方法,以用于处置正在进行的分布式机器学习或联邦学习过程。

背景技术:

1、通信系统或通信网络中的计算机系统可以包括一个或多个网络节点。节点可以包括一个或多个处理器(其与计算机程序代码一起可以执行不同功能和动作)、存储器、接收端口以及发送端口。节点可以是例如服务器。节点可以完全在云上执行它们的功能。

2、通信系统可以覆盖地理区域,其可以划分成小区区域,每个小区区域由以下类型的节点服务:无线电接入网络(ran)中的网络节点、无线电网络节点或传送点(tp)、例如,接入节点、诸如基站(bs)、例如无线电基站(rbs),其有时可以被称为例如gnb、演进型节点b(“enb”)、“e节点b”、“节点b”、“b节点”或基站收发信台(bts)(取决于所使用的术语和技术)。基于传送功率以及由此还有小区大小,基站可以是不同分类的,诸如,例如广域基站、中程基站、局域基站和家庭基站。小区可以被理解为是如下地理区域,其中无线电覆盖可以由基站站点处的基站提供。位于基站站点的一个基站可以服务一个或若干小区。进一步地,每个基站可以支持一种或若干通信技术。电信网络也可以包括网络节点,其可以通过服务波束来服务接收节点,诸如用户设备。

3、标准化组织第三代合作伙伴计划(3gpp)当前正在指定被称为下一代无线电或新空口(nr)或5g通用陆地无线电接入(utra)的新的无线电接口以及第五代(5g)分组核心网络(其可以被称为5g核心网络(5gc),缩写为5gc)的过程中。

4、分布式机器学习和联邦学习

5、分布式机器学习

6、在分布式机器学习(dml)中,可以使用分布式资源来执行训练过程,这可以显著地加速训练速度并且降低训练时间[1]。dml可以通过向用于训练任务的中央服务器发送数量受限的数据来减轻无线网络中的拥塞,同时保护敏感信息以及保护无线网络中装置的数据隐私。

7、参数服务器(ps)框架可以被理解为中央辅助dml的底层架构。图1是描绘参数服务器架构的图示的示意图。如图1中显示的,在ps框架中可以存在两种节点:服务器以及客户端或工作者(worker)。可以存在一个或多个服务器。在图1的非限制性示例中,存在四个服务器节点。客户端节点可以划分成组。在图1的非限制性示例中,存在划分成三组的十二个客户端节点。服务器可以被理解为用于保存所有参数的全部或部分,并且聚合来自每个客户端组的权重[1]。客户端节点可以基于它们对训练数据的访问来进行学习算法的初始步骤,并且可以使用来自服务器节点的同步全局梯度来执行反向传播和权重刷新。例如,客户端可以从服务器节点接收ml模型的不同特征的权重w,并且作为δw来回送相应权重刷新。服务器然后可以将权重更新为w'=w-ηδw。客户端可以仅与服务器共享参数,并且从不与彼此通信。ps架构已经被广泛应用于有线平台上分散的ml任务。

8、对dml的现存研究已经着重聚焦于联邦学习(fl)(一种dml的流行架构,以用于分散生成通用ml模型)、其有关的技术和协议以及若干应用场景[2]。

9、联邦学习

10、联邦学习(fl)可以被理解为一种分布式机器学习方式。如[3]中介绍的,fl可以被理解为能够实现在隐私限制下在不同组织之间进行机器学习模型的协作训练。fl的主要理念可以被理解为要基于可能跨多个装置分布的数据集合来构建机器学习模型,同时防止数据泄露[4]。在联邦学习系统中,多方可以在不交换它们的原始数据的情况下协作训练机器学习模型。系统的输出可以是用于各方的机器学习模型,其可以是相同或不同的[3]。

11、在联邦学习系统中,可以理解为存在三个主要的组件,即,各方(例如,客户端)、管理者(例如服务器)、以及通信计算框架,以训练机器学习模型[3]。各方可以被理解为是fl的受益方和数据所有者。管理者可以是强大的中央服务器或可以在不同设置下主导fl过程的组织之一。计算可以在各方和管理者上发生,并且通信可以在各方和管理者之间发生。经常,计算的目的是为了模型训练,并且通信的目的可以是为了交换模型参数。

12、如图2的示意图中显示的[3],联邦学习中的一种基础并且广泛使用的框架是联邦平均(fedavg)[5](h.mcmahan,e.moore,d.ramage,s.hampson等人的“communication-efficient learning of deep networks from decentralized data”,arxiv预印本arxiv:1602.05629,2016)。在每次迭代中,fl的过程可以如下。首先,如由图中数字1描绘的,服务器可以向所选择方发送当前全局模型。然后,如由图中数字2描绘的,所选择方可以通过它们的本地数据来更新全局模型。接下来,如由图中数字3描绘的,所更新的模型可以被回送到服务器。最后,如由图中数字4描绘的,服务器可以将所有所接收的本地模型进行平均,以得到新的全局模型。

13、fedavg可以被理解为重复以上过程,直到达到指定数量的迭代或者损失函数的结果可以低于阈值为止。服务器的全局模型可以被理解为是最终的输出[3][4]。

14、在多个nwdaf实例之中的联邦学习

15、在tr23.700-91v.17.0.0条款6.24中,给出了一种基于联邦学习(fl)的解决方案,以用于关键问题#2:多个网络数据分析功能(nwdaf)实例以及关键问题#19:在多个nwdaf实例之间的训练数据模型共享。如图3的示意图中显示的(其对应于tr 23.700-91v.17.0.0的图6.24.1.1-1,并且其描绘了plmn中的层级nwdaf部署),多个nwdaf可以被部署在大型公共陆地移动网络(plmn)中。因此,nwdaf可能难以将可能在不同区域中分布的所有原始数据集中。然而,对于在一区域中分布的nwdaf,可能期望或合理的是:与其他nwdaf共享其模型或数据分析。

16、联邦学习(也被称为联邦机器学习)可以是用于处置诸如数据隐私和安全、模型训练效率等问题的可能解决方案,在其中可以被理解为不需要存在原始数据传输(例如被集中到单个nwdaf中),而仅需要模型共享。例如,对于多级别nwdaf架构,nwdaf可以与例如用户平面功能(upf)或会话管理功能(smf)的5gc网络功能(nf)共置,并且由于隐私顾虑和性能原因导致原始数据不能被暴露。在此类情况下,联邦学习可以被理解为是用于允许服务器nwdaf与多个本地化nwdaf协调以完成机器学习的良好方式。

17、联邦学习的主要理念可以被理解为基于可能在不同网络功能中分布的数据集合来构建机器学习模型。(例如,在域或网络功能中部署的)客户端nwdaf可以通过其自身数据在本地训练本地ml模型,并且将其共享到服务器nwdaf。对于来自不同客户端nwdaf的本地ml模型,服务器nwdaf可以将它们聚合到全局或最优ml模型或ml模型参数中,并且将它们回送到客户端nwdaf,以用于推断。

18、这个解决方案(即,在tr 23.700-91v.17.0.0条款6.24中给出的解决方案#24)试图将联邦学习的理念引入到基于nwdaf的架构中,其旨在研究以下方面:a)支持联邦学习的多个nwdaf实例的发现和注册;以及b)如何在联邦学习训练过程期间在多个nwdaf实例之中共享ml模型或ml模型参数。

19、图4是与tr 23.700-91v.17.0.0的图6.24.1.2-1对应的信令图,并且描绘了用于在多个nwdaf实例之中的联邦学习的一般过程。在步骤1-3中,客户端nwdaf可以将它们的相应nf简档(例如客户端nwdaf类型(参见ts23.502v.17.3.0[11]条款5.2.7.2.2)、客户端nwdaf的地址、联邦学习能力信息的支持、以及(一个或多个)分析id)单独注册到网络存储库功能(nrf)中。在步骤4-6中,服务器nwdaf可以经由nrf发现一个或多个客户端nwdaf实例(其可以用于联邦学习),以通过调用带有分析id和联邦学习能力信息的支持的nnrf_nfdiscovery_request服务操作来得到客户端nwdaf实例的因特网协议(ip)地址。

20、在图4中,假设针对联邦学习的类型预配置了分析id。因此,nrf可以意识到服务器nwdaf正在请求执行基于预配置的联邦学习。并且nrf可以向中央nwdaf响应可以支持该分析id的多个nwdaf实例的ip地址。支持联邦学习的(一个或多个)分析id可以由运营商来配置。在步骤7a中,每个客户端nwdaf可以传递对于其数据的许可条件和训练基础设施以参与联邦学习任务。这些条件可以基于策略设置(基于数据可以是多么敏感、可能预计需要多少计算来执行本地训练、谁可以得到训练模型的使用权等)。在步骤7b中,基于来自nrf的响应,服务器nwdaf可以选择哪些nwdaf客户端可以参与(基于其期望的许可模型)。在步骤7c中,服务器nwdaf可以根据步骤7a和7b向所选择的客户端nwdaf(其可以参与联邦学习)发送请求,其包含一些参数,例如,诸如初始ml模型、数据类型列表、最大响应时间窗口等,以帮助对于联邦学习的本地模型训练。在步骤8中,每个客户端nwdaf可以通过使用ts23.288v.17.3.0[8]条款6.2中的当前机制来收集其本地数据。在步骤9中,在联邦学习训练过程期间,每个客户端nwdaf可以基于其自身的数据进一步训练从服务器nwdaf检索的ml模型,并且向服务器nwdaf报告ml模型训练的结果,例如梯度。服务器nwdaf可以与客户端nwdaf交互以递送以及更新ml模型。如何传输ml模型和本地ml模型训练结果取决于tr23.700-91v.17.0.0中的ki#19的结论。在步骤10中,服务器nwdaf可以聚合在步骤9被检索的所有本地ml模型训练结果(诸如梯度)以更新全局ml模型。在步骤11中,服务器nwdaf可以将所聚合的ml模型信息、更新的ml模型发送到每个客户端nwdaf,以用于下一轮模型训练。在步骤12中,每个客户端nwdaf可以基于在步骤11由服务器nwdaf分发的所聚合模型信息、更新的ml模型来更新其自身的ml模型。步骤8-12可以被重复,直到达到训练终止条件,例如最大数量的迭代,或损失函数的结果低于阈值。在完成训练过程之后,全局最优ml模型或ml模型参数可以被分发到客户端nwdaf,以用于推断。

21、来自多个nwdaf的分析聚合

22、在ts23.288v.17.3.0条款6.1a中,描述了来自多个nwdaf的分析聚合。在多nwdaf部署场景中,nwdaf实例可以为一个或多个分析id专门提供分析。nwdaf实例中的每个可以服务某个感兴趣区域,或(一个或多个)跟踪区域标识((一个或多个)tai)。多个nwdaf可以共同服务特定分析id。nwdaf可以具有支持可能带有由其本身生成的分析的、从其他nwdaf接收的(例如每分析id的)分析聚合的能力。对于来自多个nwdaf的分析聚合的过程可以如在ts23.288v.17.3.0的条款6.1a.3中被定义的,被复制在下文在子标题“用于分析聚合的过程”之下。

23、分析聚合

24、来自多个nwdaf的分析聚合可以被用于针对nwdaf服务消费者可以请求(一个或多个)分析id的情况,其可以要求多个nwdaf,所述多个nwdaf可以共同服务该请求。聚合器nwdaf或聚合点可以被理解为带有用于聚合由其他nwdaf提供的输出分析的附加能力的nwdaf实例。这可以被理解为是除了常规nwdaf行为之外,诸如从其他数据源收集数据以能够生成其自身的输出分析。聚合器nwdaf可以被理解为能够基于要被请求用于数据分析的每个nwdaf的服务区域将从消费者接收的感兴趣区域划分到感兴趣的子区域中,并且然后将作为分析过滤器的、包含感兴趣的子区域的数据分析请求发送到对应的nwdaf。聚合器nwdaf可以保存关于所发现的nwdaf、它们支持的分析id以及nwdaf服务区域的信息。聚合器nwdaf可以具有在nrf内其nf简档中注册的“分析聚合能力”。当被要求用于输出分析的聚合时,聚合器nwdaf可以支持nwdaf之间“分析元数据信息”的交换和请求。“分析元数据信息”可以被理解为与(一个或多个)所请求的分析id关联的附加信息(如在ts23.288v.17.3.0的条款6.1.3中定义的)。聚合器nwdaf也可以支持每类分析(例如分析id)的数据时间窗口参数、输出策略以及数据集统计属性(如在ts23.288v.17.3.0的条款6.1.3中定义的)。

25、nrf可以存储nwdaf实例的nf简档,包含(聚合器nwdaf的)“分析聚合能力”以及当由nwdaf支持时的“分析元数据预配置(provision)能力”。如在ts23.502v.17.3.0[11]的条款5.2.7.3中指定的,nrf可以返回与nnrf_nfdiscovery_request中提供的属性匹配的(一个或多个)nwdaf。

26、nwdaf服务消费者可以针对给定的感兴趣区域中的一个或多个分析id来请求或预订接收分析(如在ts23.288v.17.3.0的条款6.1中指定的)。nwdaf服务消费者可以使用如在ts23.501v.17.3.0[10]的条款6.3.13中指定的、来自nrf的发现机制来识别带有某些能力(例如分析聚合、覆盖某个感兴趣区域(例如为(一个或多个)特定tai提供数据/分析))的nwdaf。

27、nwdaf服务消费者可在可能返回多个nwdaf的情况下能够基于其内部选择准则(可能考虑到nrf中注册的能力和信息)来区分并且选择优选的nwdaf。

28、用于预配置了感兴趣区域的分析聚合的过程

29、图5的信令图中描绘的用于分析聚合的过程(其对应于ts 23.288v.17.3.0的图6.1a.3-1)可以被用于针对nwdaf服务消费者可以对于感兴趣区域来请求(一个或多个)分析id的情况,所述(一个或多个)分析id可以要求可共同服务该请求的多个nwdaf。在步骤1a-b中,nwdaf服务消费者可以经由nrf来发现nwdaf。nwdaf可以向nrf发送nnrf_nfdiscovery_request_request消息,从而请求nwdaf实例,其可以共同覆盖在该请求中指示的感兴趣区域,例如分析id 1、tai-1、tai-2、tai-n。nrf可以在带有候选nwdaf的nnrf_nfdiscovery_request_response消息中返回与所请求的能力、感兴趣区域和(一个或多个)支持的分析id匹配的多个nwdaf候选。nwdaf服务消费者可以基于其内部选择准则(可能考虑到nrf中注册的nwdaf能力和信息)来选择带有分析聚合能力的nwdaf(例如,nwdaf 1),例如,聚合器nwdaf。在步骤2中,nwdaf服务消费者可以调用来自所选择的聚合器nwdaf(例如nwdaf 1)的nnwdaf_analyticsinfo_request或nnwdaf_analyticssubscription_subscribe服务操作。在请求中,nwdaf服务消费者可以提供(一个或多个)所请求的分析id(例如分析id 1)连同所要求的感兴趣区域,例如tai-1、tai-2,tai-n(如果对nwdaf服务消费者而言是已知的)。在步骤3中,在接收步骤2中的请求时,聚合器nwdaf(例如nwdaf1)基于例如对nrf的查询或配置,并且考虑到来自nwdaf服务消费者的请求(例如分析过滤器信息),可以确定可共同覆盖该请求中指示的感兴趣区域(例如tai-1、tai-2、tai-n)的其他nwdaf实例。在发送到nrf的发现请求中,聚合器nwdaf可以指示“分析元数据预配置能力”(例如,作为查询参数),因此,请求nrf通过那一个或多个nwdaf实例(如果可用的话)进行回复,所述(一个或多个)nwdaf实例可能也支持“分析元数据预配置能力”功能性(如在特定nwdaf实例注册过程期间指示的)。在步骤4-5中,聚合器nwdaf(例如nwdaf 1)可以调用来自步骤3中所发现/确定的nwdaf(例如nwdaf 2和nwdaf 3)中的每个nwdaf的nnwdaf_analyticsinfo_request或nnwdaf_analyticssubscription_subscribe服务操作。该请求可以可选地向所确定的nwdaf(例如nwdaf 2和/或nwdaf 3)指示“分析元数据请求”参数(当分析元数据可以由这些nwdaf支持时)。向所确定的nwdaf(例如nwdaf 2和/或nwdaf 3)的请求或预订可以还包含数据集统计属性、输出策略以及数据时间窗口。这可以向所确定的nwdaf指示:当被请求时,分析id输出可能需要基于此类参数来生成。在步骤6-7a-b中,所确定的nwdaf(例如,nwdaf 2和/或nwdaf 3)可以通过发送nnwdaf_analyticsinfo_request响应或nnwdaf_analyticssubscription_notify消息以所请求的输出分析来回复或通知。如果“分析元数据请求”包含在由此类nwdaf接收的请求中,则在步骤4-5中,nwdaf可以附加地返回用于生成分析输出的“分析元数据信息”(如在ts23.288v.17.3.0的条款6.1.3中定义的)。在步骤8中,聚合器nwdaf(例如nwdaf 1)可以聚合接收的分析信息,即,它可以基于多个分析输出以及(可选地)从所确定的nwdaf(例如nwdaf 2和nwdaf 3)接收的“分析元数据信息”来生成单个输出分析。聚合器nwdaf(例如nwdaf 1)也可以将其自身对于tai-n的分析纳入考虑,以用于分析聚合。在步骤9a-b中,聚合器nwdaf(例如nwdaf 1)可以通过发送nnwdaf_analyticsinfo_request响应或nnwdaf_analyticssubscription_notify消息来发送响应或通知nwdaf服务消费者。

30、一旦被训练,并且在某些时间段之后,通信系统中通过用于分布式机器学习或联邦学习的现存方法训练的机器学习模型可能失去精度或者可能需要被丢弃并且以新的模型替换,这可能涉及计算和时间资源的浪费。

技术实现思路

1、作为本文中实施例开发的部分,将首先识别和讨论对于现存技术的一个或多个挑战。

2、在联邦网络的操作进程(course)中,改变可能动态地发生。例如,由于所述动态的改变,用于正在进行的分布式机器学习或联邦学习过程的当前客户端nwdaf在使用一段时间后可能无法提供充分的计算资源,或者可能无法访问进一步的训练数据集,这可以被理解为导致训练速度的降低以及导致训练模型或分析的性能退化。同时,掉队者、即能力较差或较弱的客户端nwdaf可能使学习/训练过程提前终止。在这些情况下,nwdaf可能无法向nwdaf服务消费者提供稳定且高质量的服务。

3、为了使fl ml模型适应于动态网络变化,可能需要从头开始新的fl ml训练过程,使得可能能够预测感兴趣的网络特征的新模型可以被精确地预测(在给出已改变的环境的情况下)。

4、根据前述内容,本文中实施例的目的是改进分布式机器学习或联邦学习过程的处置。具体地,针对下述内容描绘了本文中的实施例:在5gc中将(一个或多个)新客户端nwdaf动态添加到dml/fl多轮学习/训练过程(当可能需要它们时)。在多个nwdaf实例之中,对于fl的tr 23.700-91v.17.0.0中的解决方案(例如解决方案#24)没有考虑dml/fl过程期间(一个或多个)新nwdaf的动态添加。用于在5gc中在多轮学习/训练过程期间将(一个或多个)新客户端nwdaf动态添加到dml/fl的过程在ts23.288v.17.3.0中也是空白的。

5、根据本文中实施例的第一方面,该目的通过一种由第一节点执行的、计算机实现的方法来实现。所述方法用于处置正在进行的分布式机器学习或联邦学习过程,对于所述过程,第一节点充当来自第一组第二节点的数据或分析的聚合器。第一节点在通信系统中操作。第一节点获得一个或多个第一指示。所述一个或多个第一指示与在通信系统中操作的一个或多个第三节点有关。所述一个或多个第一指示包括与所述一个或多个第三节点有关的相应信息。相应信息指示所述一个或多个第三节点适于(eligible)被选择参与正在进行的分布式机器学习或联邦学习过程。在正在进行的分布式机器学习或联邦学习过程期间获得所述一个或多个第一指示。第一节点还向在通信系统中操作的第四节点提供正在进行的分布式机器学习或联邦学习过程的输出。该输出基于所获得的一个或多个第一指示。

6、根据本文中实施例的第二方面,该目的通过一种由第三节点执行的、计算机实现的方法来实现。所述方法用于处置正在进行的分布式机器学习或联邦学习过程。第三节点在通信系统中操作。第三节点向在通信系统中操作的第一节点和第五节点之一提供与第三节点有关的第一指示。第一节点在正在进行的分布式机器学习或联邦学习过程中充当来自第一组第二节点的数据或分析的聚合器。第一指示包括与第三节点有关的相应信息。相应信息指示第三节点适于被选择参与正在进行的分布式机器学习或联邦学习过程。第一指示在正在进行的分布式机器学习或联邦学习过程期间被提供。

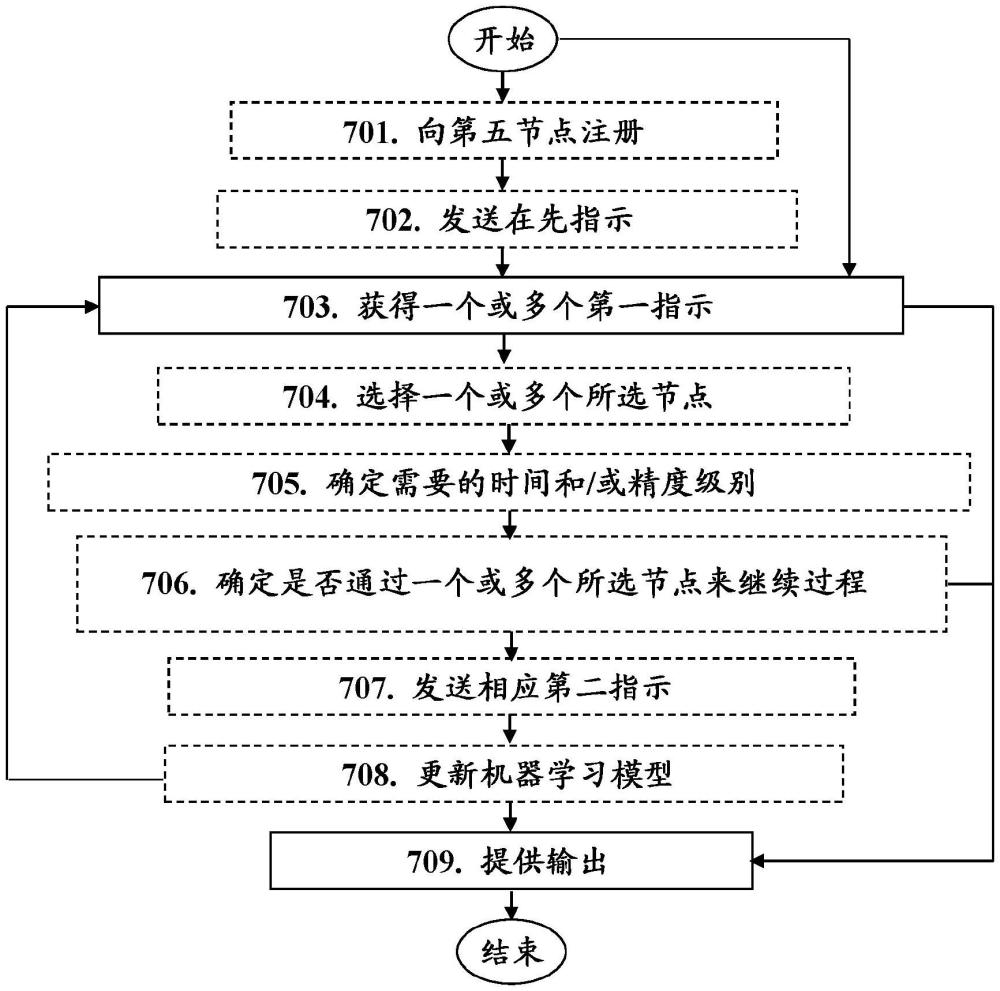

7、根据本文中实施例的第三方面,该目的通过一种由第五节点执行的、计算机实现的方法来实现。所述方法用于处置正在进行的分布式机器学习或联邦学习过程。第五节点在通信系统中操作。第五节点从在通信系统中操作的所述一个或多个第三节点获得所述一个或多个第一指示。所述一个或多个第一指示包括指示所述一个或多个第三节点适于被选择参与正在进行的分布式机器学习或联邦学习过程的相应信息。所述一个或多个第一指示在正在进行的分布式机器学习或联邦学习过程期间被获得。第五节点还向在通信系统中操作的第一节点提供所述一个或多个第一指示。对于正在进行的分布式机器学习或联邦学习过程,第一节点充当来自第一组第二节点的数据或分析的聚合器。在正在进行的分布式机器学习或联邦学习过程期间提供所述一个或多个第一指示。

8、根据本文中实施例的第四方面,该目的通过第一节点来实现,以用于处置配置成正在进行的分布式机器学习或联邦学习过程,对于所述过程,第一节点配置成充当来自第一组第二节点的数据或分析的聚合器。第一节点配置成在通信系统中操作。第一节点还配置成获得与配置成在通信系统中操作的所述一个或多个第三节点有关的所述一个或多个第一指示。所述一个或多个第一指示配置成包括与所述一个或多个第三节点有关的相应信息。相应信息配置成指示所述一个或多个第三节点适于被选择参与配置成正在进行的分布式机器学习或联邦学习过程。所述一个或多个第一指示配置成在配置成正在进行的分布式机器学习或联邦学习过程期间被获得。第一节点还配置成向配置成在通信系统中操作的第四节点提供配置成正在进行的分布式机器学习或联邦学习过程的输出。该输出配置成基于配置成被获得的所述一个或多个第一指示。

9、根据本文中实施例的第五方面,该目的通过第三节点来实现,以用于处置配置成正在进行的分布式机器学习或联邦学习过程。第三节点配置成在通信系统中操作。第三节点还配置成向配置成在通信系统中操作的第一节点和第五节点之一提供与第三节点有关的第一指示。第一节点配置成在配置成正在进行的分布式机器学习或联邦学习过程中充当来自第一组第二节点的数据或分析的聚合器。第一指示配置成包括与第三节点有关的相应信息。相应信息配置成指示第三节点适于被选择参与配置成正在进行的分布式机器学习或联邦学习过程。第一指示配置成在配置成正在进行的分布式机器学习或联邦学习过程期间被提供。

10、根据本文中实施例的第六方面,该目的通过第五节点来实现,以用于处置配置成正在进行的分布式机器学习或联邦学习过程。第五节点配置成在通信系统中操作。第五节点还配置成从配置成在通信系统中操作的所述一个或多个第三节点获得所述一个或多个第一指示。所述一个或多个第一指示可以配置成包括配置成指示所述一个或多个第三节点适于被选择参与配置成正在进行的分布式机器学习或联邦学习过程的相应信息。所述一个或多个第一指示配置成在配置成正在进行的分布式机器学习或联邦学习过程期间被获得。第五节点还配置成向配置成在通信系统中操作的第一节点提供所述一个或多个第一指示。对于配置成正在进行的分布式机器学习或联邦学习过程,第一节点配置成充当来自第一组第二节点的数据或分析的聚合器。所述一个或多个第一指示配置成在配置成正在进行的分布式机器学习或联邦学习过程期间被提供。

11、通过第一节点获得所述一个或多个第一指示,可以使第一节点能够动态考虑是否选择所述一个或多个第三节点中的任一个以便继续正在进行的分布式机器学习或联邦学习过程。这然后可以使第一节点能够加快正在进行的分布式机器学习或联邦学习过程的训练和/或增加任何作为结果的机器学习模型的精度和/或避免学习/训练可能由于掉队者而终止。然后,可以进而使第一节点能够向第四节点(例如,由第一节点提供的服务的消费者)提供正在进行的分布式机器学习或联邦学习过程的输出。

12、通过在该动作中向第四节点提供正在进行的分布式机器学习或联邦学习过程的输出,第一节点可以使第四节点能够以加快的方式和/或以增加的精度来获得机器学习模型或基于该模型的分析。

13、通过第三节点在正在进行的分布式机器学习或联邦学习过程期间提供与第三节点有关的第一指示,可以使第一节点能够考虑第三节点是否可以被动态选择成用于继续正在进行的分布式机器学习或联邦学习过程,从而能够实现上文描述的优势。

14、通过第五节点在正在进行的分布式机器学习或联邦学习过程期间从在通信系统中操作的一个或多个第三节点获得所述一个或多个第一指示,并且然后将所述一个或多个第一指示提供给第一节点,可以使第一节点能够考虑所述一个或多个第三节点是否可以被动态选择成用于继续正在进行的分布式机器学习或联邦学习过程,从而实现上文描述的优势。

本文地址:https://www.jishuxx.com/zhuanli/20240911/289700.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表