一种模块性脑网络估计与分类的端到端学习方法

- 国知局

- 2024-09-14 14:41:13

本发明涉及一种模块性脑网络估计与分类的端到端学习方法,利用静息态功能磁共振数据,构建模块化功能脑图并且将模块化信息整合到边和节点中,从而求得包含多种交互信息的功能脑图,最终进行被试的脑障碍识别。

背景技术:

1、脑障碍疾病会导致认知、情绪、感知和运动等方面出现异常。

2、对脑障碍疾病进行诊断、治疗和研究中,计算机断层扫描(ct)、正电子发射断层扫描(pet)、磁共振成像(mri)等现代成像技术可以提供更准确、客观的测量方法,协助医生诊断脑部疾病。鉴于ct涉及x射线辐射,pet需要使用放射性示踪剂,两者都有辐射暴露的风险。相比之下,基于磁场和无害无线电波的核磁共振成像具有更高的安全性,深度学习方法在脑成像分析研究中得到了越来越广泛的应用。

3、从数学角度而言,深度学习方法在识别某些大脑疾病方面很有效,但它的特点是复杂的网络结构,不能充分利用大脑功能的先验知识,不利于理解输入特征和预测结果之间的推断过程。

技术实现思路

1、本发明目的在于根据大脑功能的先验知识,提出一种模块性脑网络估计与分类的端到端学习方法,增强本方法输入特征和预测结果之间推断过程的可解释性,提高特征学习能力,使本方法根据优化目标自动学习最适合任务的特征表示,并以最优更新次数的指标,完成脑障碍的诊断任务。

2、为了规避背景技术所存在的问题,本发明采用以下技术方案:

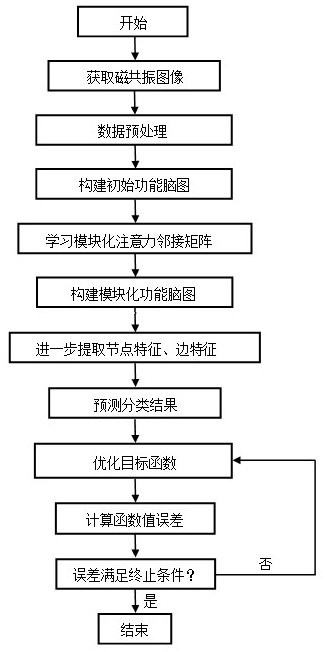

3、一种模块性脑网络估计与分类的端到端学习方法,包括以下步骤:

4、(1)数据预处理:对于功能磁共振设备采集到的大脑功能图像去除磁共振图像的前个时间点;对图像进行头动和时间层矫正;对图像进行空间光滑和时间带通滤波,排除初始扫描时的潜在不稳定性;去除脑脊液信号和白质信号的影响,减少这些源自生理和仪器方面的干扰,得到处理后的大脑功能图像;

5、本实验选择了两种公开数据库的静息态磁共振扫描数据,包括abide i(autismbrain imaging data exchange i)和mdd(major depressive disorder)。abide i数据集由国际神经成像数据共享倡议发起,由17个国际成像中心共同组成。实验使用840个经过质量评估的样本进行多站点实验。并在abide i数据集中,选择样本量最大的三个站点nyu、um和ucla分别进行单站点实验,其中nyu包含172个样本,um包含120个样本,ucla包含85个样本。mdd数据集包含282名重度抑郁症患者和251名典型发展对照者神经影像学数据;

6、(2)构建初始功能脑图:针对步骤(1)得到的处理后的大脑功能图像,使用三种不同的脑图谱aal,dos160和cc200来划分大脑的感兴趣区域并构建初始功能脑图作为输入特征,每个被试的初始功能脑图描述为,其中,表示节点特征矩阵,表示一个被试,表示节点的个数,表示特征的维度,,表示使用皮尔逊相关计算的两个脑区之间线性关系强度的边特征矩阵,如下所示;

7、

8、其中,表示第和第个节点的时间序列,是的平均值;

9、(3)学习模块化注意力邻接矩阵:

10、为了解决深度学习方法具有复杂的网络结构,对于解输入特征和预测结果之间的推断过程可解释性较差的问题,设计了一个模块化的注意力层:将奇异值分解加入到注意力层中,使注意力层更关注与目标任务更相关的模块,并学习大脑中的模块性特征,增强输入特征和预测结果之间推断过程的可解释性;

11、第一,利用步骤(2)构建出的初始功能脑图,对节点特征矩阵和边特征矩阵进行1x1卷积运算,通过1x1卷积运算对节点特征矩阵和边特征矩阵进行映射,得到查询矩阵、键矩阵和值矩阵;

12、第二,将查询矩阵与键矩阵相乘来计算节点之间的相似性,通过函数得到注意力矩阵,然后将注意力矩阵与值矩阵相乘进行加权求和,相当于对每个节点的邻居节点的信息进行加权聚合,得到注意力邻接矩阵;

13、

14、第三,根据认知神经科学,大脑的结构和功能分为多个相对独立的模块;为了更好地提取大脑潜在的模块化信息,对注意力邻接矩阵进行奇异值分解,得到模块化注意力邻接矩阵;

15、

16、注意力邻接矩阵通过奇异值分解得到三部分:左奇异矩阵、奇异值矩阵和右奇异矩阵,其中是的转置,取奇异值矩阵中前个奇异值得到矩阵,相乘后得到模块化注意力邻接矩阵;

17、(4)构建模块化功能脑图:将步骤(3)学习到的模块化信息整合到边特征矩阵和节点特征矩阵中;

18、首先,更新步骤(2)节点特征矩阵,将模块化注意力邻接矩阵与节点特征矩阵相乘,并通过可学习参数矩阵进行特征映射;然后,引入非线性激活函数增强特征表达能力;最后,加入残差连接,方便网络层间信息传播,缓解梯度消失问题;

19、

20、其中表示图注意力层的层数,时,作为输入,表示函数,表示模块化注意力邻接矩阵,时,,表示节点特征矩阵的可学习参数矩阵,表示更新后的节点特征矩阵;

21、接着,更新边特征矩阵,对边特征矩阵进行与节点特征矩阵相同的操作;其中,时,作为输入,作为边特征矩阵的可学习参数矩阵;

22、

23、经过层图注意力层,最终得到节点特征矩阵记为,边特征矩阵记为,模块化功能脑图记为,利用脑功能的先验知识构建模块化功能脑图,增强输入特征和预测结果之间推断过程的可解释性;

24、(5)进一步提取节点特征、边特征:将步骤(4)得到的模块化功能脑图中的节点特征矩阵和边特征矩阵分别输入到下述公式(6)和(7);

25、

26、

27、其中,表示拼接操作,和表示可学习参数矩阵,首先对和分别进行线性变换,然后引入非线性激活函数增强特征表达能力;随后,执行规范化,将规范化的节点和边特征与初始节点和边特征进行拼接;得到表示节点特征,表示边特征,进一步对模块化功能脑图中的节点特征和边特征进行特征提取,提高特征学习能力;

28、(6)预测分类结果:利用步骤(5)得到的,,预测分类结果如下;

29、

30、其中,和都是可学习参数矩阵,首先对和进行拼接和线性变换,然后通过函数来缓解过拟合,并添加一个非线性激活函数,其中表示函数,然后进行特征映射,使用函数进行归一化,得到预测的分类结果;

31、(7)优化目标函数:利用步骤(6)得到的预测分类结果,代表真实分类结果,使用交叉熵损失函数来优化参数,考虑到使用奇异值分解得到的作为的近似矩阵在反向传播时的稳定传播问题,将与的重构误差作为正则化项,定义如下;

32、

33、其中,代表最小化总损失函数,是一个用于平衡损失函数两部分重要性的超参数,总损失函数既考虑了本方法的预测性能,又考虑了近似矩阵在反向传播过程中的稳定性,从步骤(2)到步骤(7)是一个端到端的模块性脑网络估计与分类的过程,利用大脑功能的先验知识,增强输入特征和预测结果之间推断过程的可解释性,提高特征学习能力,使本方法根据优化目标自动学习最适合任务的特征表示,并以最优更新次数的指标,输出最终的分类结果。

34、本方法根据认知神经科学,大脑的结构和功能分为多个相对独立的模块;在自注意层中引入奇异值分解,建立模块化注意力层,使其更多地关注与目标任务更相关的模块;此外,为了更全面地捕捉大脑的功能活动和连接模式,从节点和边两个角度进行了特征学习,将模块化信息整合到边和节点中,从而使本方法具有更好的可解释性和特征学习的能力,有助于脑障碍识别。

35、作为对本技术方案的进一步改进:

36、所述的步骤(2)中,使用皮尔逊相关计算的两个脑区之间线性关系强度的边特征矩阵,通过选择格兰因果关系或者动态因果关系的数学模型来描述大脑区域之间的有效连接性,作为两个脑区之间线性关系强度的边特征矩阵,有利于揭示大脑功能区域之间的因果关系或者动态变化;

37、所述的步骤(3),第一:利用步骤(2)构建出的初始功能脑图,将节点特征矩阵分成个注意力头;然后,对每个注意力头进行1x1卷积运算,每个注意力头经过特征映射得到对应的查询矩阵、键矩阵;接着,通过函数计算每个注意力头的注意力矩阵;最后,每个注意力头计算出的结果被合并或拼接以产生最终的注意力矩阵。这样有助于增强本方法对不同特征的关注能力、学习多样化的特征信息,提高特征的表达能力,使用的特征能够更好地表达数据的特征和特征之间的关系。表达能力强的特征能更好地捕捉到数据的本质特征,从而有助于提高模型的性能,更准确地进行预测分类;

38、所述的步骤(4)或(5)引入非线性激活函数,选择非线性激活函数,引入一个小的正斜率,允许在输入值小于零时有一个非零的输出。这样可以避免输入值小于零时梯度完全消失的问题,使得本方法的训练更加稳定。

本文地址:https://www.jishuxx.com/zhuanli/20240914/295521.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表