基于多智能体强化学习的多能耦合型微电网优化调度方法与流程

- 国知局

- 2024-09-14 14:55:41

本发明属于电网调度,尤其是基于多智能体强化学习的多能耦合型微电网优化调度方法。

背景技术:

1、大规模分布式电源接入多能耦合型微电网,可以提高清洁能源的比重,但同时对配电网的运行与调度提出新的挑战。多能耦合型微电网的建设旨在确保系统安全稳定运行的前提下,通过对系统内多类型分布式电源的调控,提升系统对大量间歇式可再生能源的消纳能力。在这一过程中,分布式电源优化调度策略显得尤为重要,它是实施主动管理、实现网络安全经济运行的核心技术和重要手段。分布式电源优化调度分为集中式和分布式两种方式,它们都旨在有效协调各种分布式电源的输出,以满足电网运行的需求。现有技术多采用传统随机优化方法,应对源荷不确定性的能力弱,导致电网的调度能力差及应对不确定性的能力差。

技术实现思路

1、本发明的目的是解决现有技术中的微电网优化方法应对源荷不确定性的能力较差的问题,提供基于多智能体强化学习的多能耦合型微电网优化调度方法,通过将历史状态量作为训练样本,使用近端策略优化算法进行模型训练,得到的多智能体强化学习模型可以根据历史状态和环境反馈进行学习从而适应不同的源荷情况,根据训练得到的多智能体强化学习模型结合当前状态量获取对应的动作空间,使得智能体能够根据当前情况做出适当的调度决策,解决了源荷不确定性的问题,显著提高了多能耦合型微电网调度能力及应对不确定性的能力。

2、为了实现上述目的,本发明采用以下技术方案:

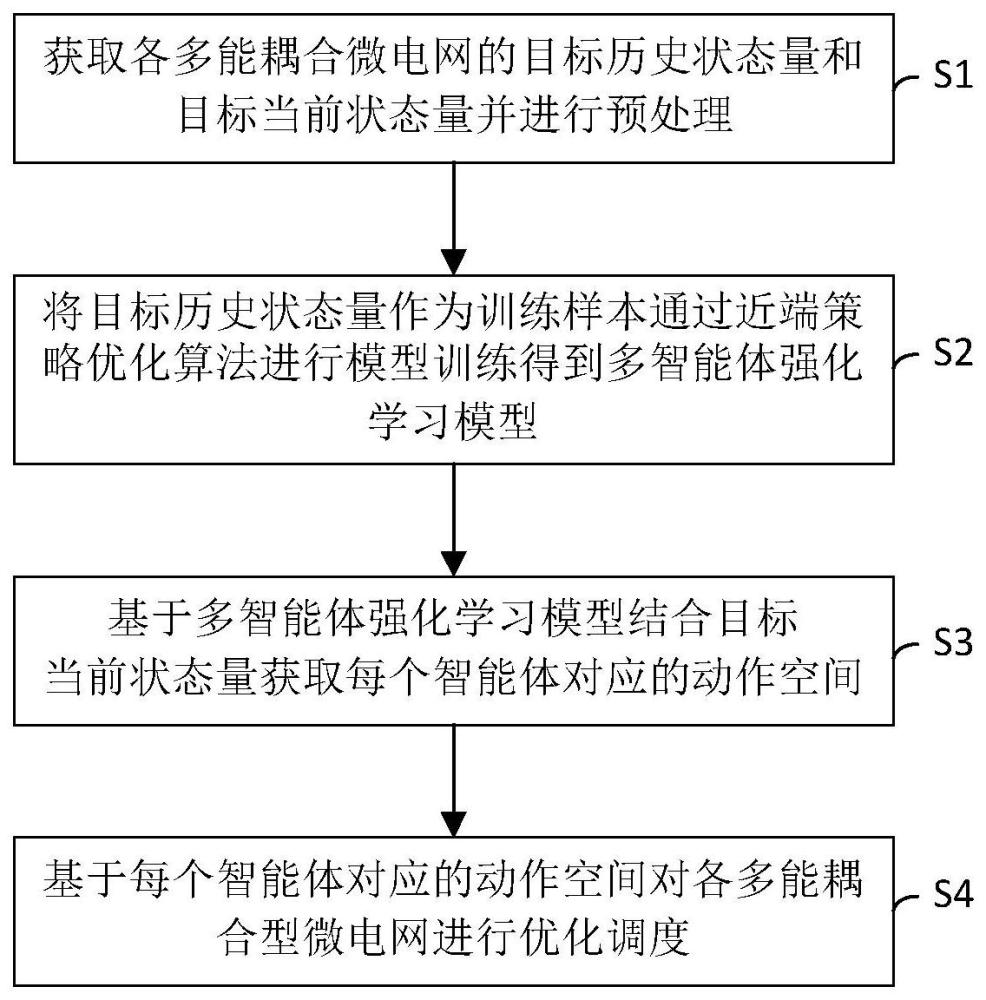

3、基于多智能体强化学习的多能耦合型微电网优化调度方法,包括如下步骤:

4、s1、获取各多能耦合微电网的目标历史状态量和目标当前状态量并进行预处理;

5、s2、将所述目标历史状态量作为训练样本通过近端策略优化算法进行模型训练得到多智能体强化学习模型;

6、s3、基于所述多智能体强化学习模型结合所述目标当前状态量获取每个智能体对应的动作空间;

7、s4、基于所述每个智能体对应的动作空间对各多能耦合型微电网进行优化调度。

8、上述技术方案中,通过获取微电网的目标历史状态量和目标当前状态量,并进行预处理,能够实时反映微电网的运行状态,结合多智能体强化学习模型,可以快速响应微电网的动态变化,实现高效的优化调度;利用近端策略优化算法进行模型训练,使得多智能体强化学习模型能够学习到微电网运行的规律和特性,为每个智能体生成对应的动作空间,从而实现智能化的优化调度决策,能够处理源荷不确定性的问题,提高了多能耦合型微电网的适应能力和鲁棒性;通过采用强化学习方法,当微电网的运行环境或条件发生变化时,模型可以通过不断学习和调整来适应新的情况,保持优化调度的有效性;通过各个智能体之间的交互实现电网的协同调度,能够有效解决分布式优化调度问题。

9、优选的,所述s1包括如下步骤:

10、s11、采集各多能耦合型微电网的初始历史状态量和初始当前状态量;

11、s12、分别对各多能耦合型微电网的所述初始历史状态量和所述初始当前状态量进行数据清洗得到各多能耦合型微电网的第一历史状态量和第一当前状态量;

12、s13、分别对各多能耦合微电网的所述第一历史状态量和所述第一当前状态量进行标准化得到各多能耦合微电网的第二历史状态量和第二当前状态量;

13、s14、分别对各多能耦合微电网的所述第二历史状态量和所述第二当前状态量进行数据编码及时间序列处理得到各多能耦合微电网的目标历史状态量和目标当前状态量。

14、上述技术方案中,通过数据清洗可以有效去除各多能耦合型微电网初始历史状态量和初始当前状态量中的异常值、重复值或缺失值,从而确保数据的准确性和可靠性;通过对各多能耦合微电网的状态量进行标准化处理,可以消除不同状态量之间的量纲差异,使得不同微电网的数据在同一尺度上进行比较和分析;通过数据编码和时间序列处理将各多能耦合微电网的历史状态量和当前状态量被转换为适合模型训练的格式,还可以提高模型的训练效果,同时时间序列处理能够捕捉状态量随时间的变化趋势,有助于模型更好地学习微电网的动态特性。

15、优选的,所述s2包括如下步骤:

16、s21、设定调度周期总时段数和区域智能体神经网络的最大训练轮数,并对去区域智能体对应的策略网络参数和价值网络参数进行随机初始化;

17、s22、设置日起始点作为各多能耦合型微电网的初始调度时刻,对所述初始调度时刻之前的设备状态进行初始化;

18、s23、将预处理后的目标历史状态量对应的历史状态空间作为区域智能体神经网络的输入获取动作空间,基于所述动作空间对多能耦合型微电网进行调度并基于调度结果计算全局奖励,确定采样经验并存储至经验池中;

19、s24、调度周期采样结束后基于经验池中各时段采样经验通过梯度下降法更新各智能体的策略网络和价值网络,以最大化调度周期的累计全局奖励为目标对区域智能体神经网络进行训练得到多智能体强化学习模型。

20、上述技术方案中,通过设定调度周期总时段数和区域智能体神经网络的最大训练轮数,以及对区域智能体对应的策略网络参数和价值网络参数进行随机初始化,可以确保模型训练的有序进行,并避免陷入局部最优解,有助于提升模型的训练效率和效果,使其更好地适应多能耦合型微电网的复杂环境;通过设置日起始点作为初始调度时刻,并对初始调度时刻之前的设备状态进行初始化,可以确保模型在训练开始时处于合理状态,使模型更准确地捕捉微电网的运行规律,从而生成更合理的优化调度策略;通过将预处理后的目标历史状态量作为区域智能体神经网络的输入,并基于其生成的动作空间对多能耦合型微电网进行调度,可以实现全局的优化调度;同时基于调度结果计算全局奖励并利用梯度下降法更新智能体的策略网络和价值网络,可以确保模型在训练过程中不断向最大化累计全局奖励的目标逼近,从而实现智能决策;通过多智能体强化学习模型不断地与环境进行交互、试错和学习,能够逐步适应多能耦合型微电网的动态变化,使得模型在面对新的调度场景或条件时能够做出快速的响应和调整,保持优化调度的有效性。

21、优选的,所述s23包括如下步骤:

22、s231、基于各多能耦合型微电网预处理后的目标历史状态量进行编码得到各多能耦合型微电网的历史状态空间;

23、s232、将所述各多能耦合型微电网的历史状态空间作为区域智能体神经网络的输入得到每个智能体的动作空间;

24、s233、从所述每个智能体的动作空间中随机选择动作并执行对各多能耦合型微电网进行调度;s234、在当前时段调度结束后根据多能耦合型微电网的调度结果计算全局奖励值;

25、s235、将当前时段的状态空间、执行的动作、全局奖励值及下一时段的状态空间作为采样经验存储至经验池中。

26、上述技术方案中,通过对历史状态量进行编码将其转化为模型更易理解和处理的历史状态空间,有助于模型更准确地捕捉微电网的运行特征和规律,能够充分反映微电网的历史运行状态;通过区域智能体神经网络处理各多能耦合型微电网的历史状态空间,生成每个智能体的动作空间,充分考虑了各微电网之间的耦合关系和相互影响,实现了智能体之间的协同优化,可以获得更加合理、高效的调度方案;随机选择动作策略使得模型在训练初期能够进行充分的探索,避免陷入局部最优解,通过随机探索,模型能够发现更多可能的调度方案,为后续的优化过程提供更多选择。同时基于全局奖励值的计算,模型能够逐步学习到如何生成能够最大化全局利益的调度方案,实现全局优化。

27、优选的,所述s24包括如下步骤:

28、s241、在调度周期采样结束后从经验池中随机抽取各个时段对应的预设数量的采样样本;

29、s242、分别计算抽取的所述采样样本的策略网络和价值网络对应的损失函数;

30、s243、通过反向传播算法计算所述损失函数的网络参数梯度值;

31、s244、根据所述网络参数梯度值通过梯度下降法更新策略网络和价值网络的参数,最大化调度周期的累计全局奖励值对区域智能体神经网络进行训练;

32、s245、判断是否达到最大训练轮数,若是,则结束训练得到多智能体强化学习模型;若否,则返回s22进行下一轮网络参数更新。

33、上述技术方案中,通过从经验池中随机抽取各个时段对应的预设数量的采样样本进行训练,可以有效利用历史数据,避免模型在训练过程中重复探索相同的状态和动作空间,这种经验回放机制能够加速模型的收敛速度,提高训练效率;通过计算采样样本的策略网络和价值网络对应的损失函数,并利用反向传播算法计算损失函数的网络参数梯度值,可以精确地调整模型的参数,以最小化损失函数并最大化调度周期的累计全局奖励值,有助于提升模型的决策准确性和优化效果;通过梯度下降法更新策略网络和价值网络的参数,可以使模型在训练过程中不断适应多能耦合型微电网的动态变化;通过判断是否达到最大训练轮数来决定是否结束训练,可以确保模型得到充分训练,避免过早收敛或训练不足导致的性能不佳,只有当模型达到预设的最大训练轮数时,才会得到最终的多智能体强化学习模型,从而确保模型的稳定性和可靠性。

34、优选的,所述多智能体强化学习模型对应的数学表达式如下:

35、qi(s,a1,a2,...,an)←qi(s,a1,a2,...,an)+α[ri+γmaxa'qi(s',a'1,a'2,...,a'n)-qi(s,a1,a2,...,an)];式中:qi表示第i个智能体的q值函数,q值表示执行对应动作的预期价值;a1,a2,...,an表示当前状态s下所有智能体的动作空间;a'1,a'2,...,a'n表示下一状态s'下所有智能体的动作空间;α表示学习率用于控制更新幅度的大小;γ表示折扣因子用于表示未来奖励的重要性,且0≤γ≤1;ri表示第i个智能体在状态s执行动作a1,a2,...,an后获取的即时奖励。

36、上述技术方案中,通过不断更新q值函数,智能体能够逐步优化其策略,选择能够最大化长期累积奖励的动作;智能体能够根据环境的变化和自身的经验,灵活地调整策略,适应不同的环境和任务;通过与环境的交互,智能体能够从经验中学习,提高其在复杂环境中的表现能力。

37、优选的,所述s3包括如下步骤:

38、s31、将预处理后的目标当前状态量输入至多智能体强化学习模型进行解析,确定多能耦合型微电网的运行状态;

39、s32、多智能体强化学习模型基于解析得到的所述多能耦合型微电网的运行状态查询对应的动作空间。

40、上述技术方案中,通过将预处理后的目标当前状态量输入至多智能体强化学习模型进行解析,基于解析得到的微电网运行状态,能够实时感知多能耦合型微电网的运行状态,使得模型能够迅速捕捉到微电网的当前状态,为后续的优化调度提供准确的信息基础;通过实时感知微电网状态并精准查询动作空间,能够显著提升优化调度决策的实时性和准确性,使得微电网在面对实时变化的运行环境和需求时,能够迅速做出响应,实现更加高效、灵活的能源调度。

41、优选的,所述s4包括如下步骤:

42、s41、根据各智能体的动作空间结合决策机制选择各智能体在当前状态下的待执行动作;

43、s42、基于所述每个智能体在当前状态下的待执行动作确定对应的优化调度策略;

44、s43、基于每个智能体对应的所述优化调度策略确定协同调度策略;

45、s44、基于所述协同调度策略生成并执行协同调度指令,基于所述协同调度指令对各多能耦合型微电网进行优化调度。

46、上述技术方案中,通过结合决策机制能够根据各智能体的动作空间选择在当前状态下的待执行动作,能够充分考虑微电网的实际运行情况和优化目标,从而选择出最合适的动作,提升调度的准确性和效率;基于每个智能体在当前状态下的待执行动作,能够确定对应的优化调度策略,实现了能源的高效利用和微电网的稳定运行,提高了微电网的运行效率和能源利用效率;通过综合考虑各智能体的优化调度策略,确定协同调度策略,能够实现各微电网之间的协同运行和优化,避免局部优化导致的全局性能下降,从而进一步提升微电网的运行效果和全局利益;基于协同调度策略生成并执行协同调度指令,对各多能耦合型微电网进行优化调度,能够实时响应微电网的运行变化和优化需求,确保调度指令的及时性和有效性,实现实时优化调度的目标。

47、优选的,s41所述决策机制采用ε贪婪策略机制,所述s41包括如下步骤:

48、s411、设定用于表示智能体在决策过程中选择随机动作的概率的ε值,所述ε值位于0-1之间;

49、s412、生成每个智能体在当前状态下对应的探索概率随机数,所述探索概率随机数位于0-1之间;

50、s413、根据所述探索概率随机数与ε值的大小关系确定每个智能体在当前状态下的待执行动作。

51、上述技术方案中,通过设定ε值在智能体的决策过程中引入了权衡机制,智能体以概率ε选择随机动作进行探索,或以(1-ε)的概率选择当前已知的最佳动作进行利用,既保证了智能体不会一直停留在可能的局部最优解,也确保了它能充分利用已学到的知识;随着训练的进行逐渐减小ε值,使智能体在初期更多地探索以寻找可能的更优策略,而在后期则更多地利用已学到的最优策略,从而实现策略的动态调整和优化;通过ε-贪婪策略使得智能体能够在不同环境下进行自适应调整,当环境发生变化时,智能体仍能通过探索来寻找新的最优策略,同时保留利用已知最优策略的能力,从而增强了系统的鲁棒性。

52、优选的,所述s413包括:

53、若所述探索概率随机数小于ε值,则从各智能体对应的动作空间中选择随机动作作为当前状态下的待执行动作;

54、若所述概率随机数大于或等于ε值,通过多智能体强化学习模型确定所述动作空间中各动作的预期奖励,选取动作空间中预期奖励最大的动作作为当前状态下的待执行动作。

55、上述技术方案中,通过比较探索概率随机数与ε值的大小关系,智能地平衡了智能体在决策过程中的探索与利用行为;当探索概率随机数小于ε值时,智能体倾向于选择随机动作进行探索,以发现可能的更优解或避免陷入局部最优;当探索概率随机数大于或等于ε值时,智能体则选择当前已知的预期奖励值最大的动作进行利用,以最大化当前状态下的即时回报;通过决策机制使得智能体能够根据不同的环境和状态动态调整其决策行为,当环境发生变化或新的信息出现时,智能体能够通过探索来适应这些变化,并找到新的最优策略,使得智能体在面对不确定性时能够保持鲁棒性,确保调度策略的稳定性和可靠性。

56、本发明的有益效果:通过预处理微电网的目标历史状态量与目标当前状态量,结合多智能体强化学习模型,能够实现高效的优化调度。多智能体强化学习模型利用近端策略优化算法学习微电网运行规律,为每个智能体生成动作空间,智能化地处理源荷不确定性,提升微电网的适应性和鲁棒性。多智能体强化学习模型能够适应环境变化,保持调度有效性。通过对历史状态数据和当前状态数据进行数据清洗、标准化、编码和时间序列处理确保数据准确性和模型训练效果。通过设定调度周期、训练轮数及初始化网络参数,能够显著提升模型训练效率。通过预处理目标状态量输入模型,全局优化调度并更新网络参数,能够实现智能决策。通过多智能体强化学习模型实时感知微电网状态,能够精准查询动作空间,提升了调度决策的实时性和准确性。通过结合决策机制选择待执行动作,确定优化调度策略,实现了能源高效利用和稳定运行。综合考虑各智能体策略,确定协同调度策略,避免局部优化问题,提升全局性能。基于协同调度策略生成并执行指令,实时响应微电网变化,实现实时优化调度的目标。

57、上述技术实现要素:仅是本发明技术方案的概述,为了能够更清楚了解本发明的技术手段,而可依照说明书的内容予以实施,并且为了让本发明的上述和其它目的、特征和优点能够更明显易懂,以下特举本发明的具体实施方式。

本文地址:https://www.jishuxx.com/zhuanli/20240914/296405.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表