开放词汇目标检测中的背景提示学习方法

- 国知局

- 2024-09-14 14:57:22

本发明属于开放词汇目标检测的,具体涉及一种开放词汇目标检测中的背景提示学习方法。

背景技术:

1、近年来,针对目标检测的研究取得了显著的进展。然而,在推理过程中仅仅检测和分类已知类别(基础类别)显著降低了其在实际应用中的泛化能力。因此,提出了开放词汇目标检测(ovd)这种新任务,目的是使检测器在推理阶段能够检测在训练中没有提供标注的未知类别(新类别)。为了克服这一限制,研究人员提出了各种方法,比如利用大规模预训练的视觉与语言模型pvlms(如多模态预训练神经网络模型clip、文本与图像对齐的深度学习模型align)等来扩展目标检测的能力;这些方法主要分为两种:第一种方法通过微调pvlms将其适应到下游的检测任务中,但这种方法往往需要重新训练大语言模型,需要耗费大量的计算资源和数据资源;另一种方法是利用知识蒸馏将pvlms学习的知识转移到目标检测任务中,从而将其强大的能力推广到更多未知物体类别的检测中。然而,这些方法在背景类解释方面存在着缺陷。具体来说,这些方法倾向于将背景候选框表示为一个单一的“背景类”,这个背景类包含所有前景基础类别之外的所有类别。由于这些方法仅使用一个可学习的嵌入来解释这个背景类别,训练模型可能无法捕获背景候选框中具有多样性的隐含知识,这导致了关键背景信息的丢失,并使模型学习到的未知类别表示不完整且不明确;因此模型无法使用这些类别表示来区分来自这些未知类别的物体。

2、为解决这一问题,研究人员尝试了各种背景解释策略,如二元交叉熵损失或软背景损失等;然而,这些策略的基本假设是背景候选框与任何前景类别均匀不相似,忽视了前景和背景类别之间存在的类相似关系;此外,在训练过程中这些方法往往会使模型过拟合到多数类上,这使得检测器的预测偏向于这些类别。最近的一些研究进展提出从背景候选框中挖掘隐含的新类别物体,并采用伪标签方法增强它们的解释能力;然而,这些方法通常依赖于如新类别的名称这样的额外的先验知识或弱监督数据,但这些数据在实际的应用场景中往往难以收集,因此限制了该方法的应用。

技术实现思路

1、本发明的主要目的在于克服现有技术的缺点与不足,提供一种开放词汇目标检测中的背景提示学习方法,在没有利用任何先验知识的情况下,通过学习背景提示来利用探索到的隐含背景知识,从而增强对基础和新类别的检测性能。

2、为了达到上述目的,本发明采用以下技术方案:

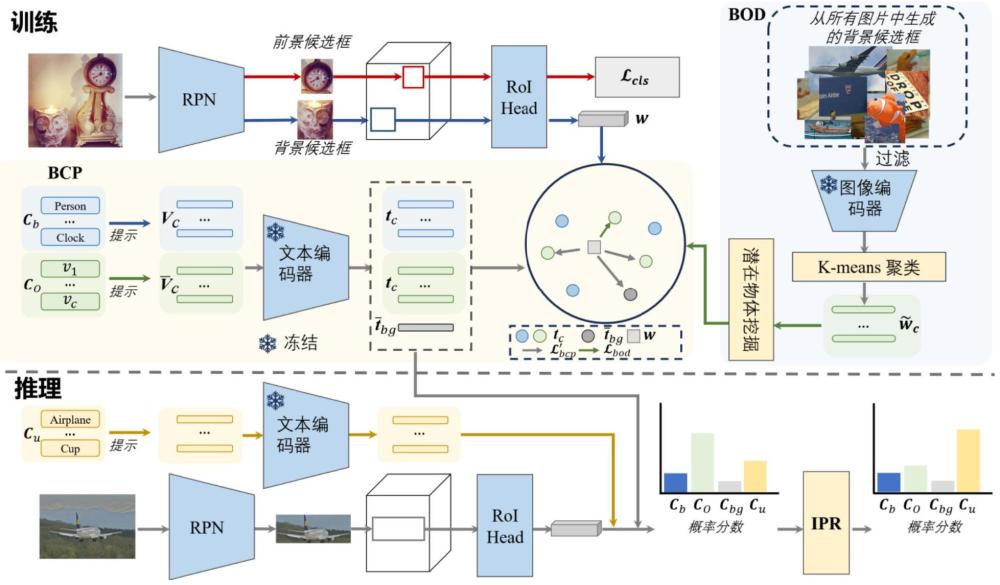

3、开放词汇目标检测中的背景提示学习方法,包括下述步骤:

4、生成训练图片数据集中各图片的背景候选框,并通过特征提取得到背景候选框中潜在类别的最终最优数量,同时聚类得到聚类中心的嵌入;

5、将训练图片数据集中的训练图片输入背景类别特定提示模块中生成训练图片的图像候选框,提取图像候选框的特征并获取类别嵌入;再使用背景物体发掘模块基于图像候选框的特征及聚类中心的嵌入对图像候选框赋予伪标签并调整;最后构建损失函数对背景类别特定提示模块和背景物体发掘模块进行迭代训练,直至损失函数收敛或达到最大迭代次数;

6、把推理图片输入训练好的背景类别特定提示模块和背景物体发掘模块中进行预测,并使用推理概率校正模块进行修改正得到推理图片的预测类别。

7、作为优选的技术方案,所述得到背景候选框中潜在类别的最终最优数量,同时聚类得到聚类中心的嵌入,具体为:

8、使用预训练后的区域候选网络对训练图片数据集中每张图片生成候选框;所述区域候选网络使用标注有基础类别的训练数据集预训练得到;所述图像数据集标注有基础类别cb;所述候选框包括前景候选框和背景候选框;

9、根据rpn分数和极大值抑制对候选框进行筛选;

10、将筛选后的候选框及其对应的图像输入clip模型的图像编码器中得到筛选后的候选框特征;

11、参考深度迁移聚类对筛选后的候选框特征进行k-means聚类计算获得背景候选框中潜在类别的最优数量n0,同时引入一个预定义的超参数na对潜在类别的最优数量进行扩展,得到背景候选框中潜在类别的最终最优数量n0+na,则潜在类别表示为分解为和ci为第i个潜在类别;

12、得到聚类中心的嵌入其中,为类别c对应的聚类中心嵌入。

13、作为优选的技术方案,所述生成训练图片的图像候选框,提取图像候选框的特征并获取类别嵌入,具体为:

14、把训练图片送入faster r-cnn检测器中编码成全局图像特征,并通过区域候选网络生成前景候选框p和背景候选框n;所述前景候选框p包含训练图片的基础类别cb;所述背景候选框n被分类为潜在类别co和超类

15、将前景候选框p、背景候选框n和训练图片输入进clip模型的图像编码器中获得对应的clip特征i(x)并使用现有的知识蒸馏方法进行对齐;

16、将基础类别cb及其上下文提示、可学习的潜在类别及其上下文提示输入clip模型的文本编码器中获得对应的上下文嵌入;

17、使用全局图像特征和对应的上下文嵌入进行概率计算,并构建背景类别特定提示模块的损失函数。

18、作为优选的技术方案,所述使用现有的知识蒸馏方法进行对齐是指基于前景候选框、背景候选框的特征w(x)及对应的clip特征i(x)通过最小化mean square loss或其他损失函数来对齐。

19、作为优选的技术方案,所述获得对应的类别嵌入,具体为:

20、对于基础类别cb,将其对应的上下文提示定义为vc,c∈cb;

21、对于潜在类别co,将其对应的上下文提示使用可学习的连续向量表示记为

22、引入一个子类类别代表背景候选框中的超类,也将其对应的上下文提示使用可学习的连续向量表示记为

23、将vc、分别输入clip模型的文本编码器中,得到对应的上下文嵌入tc、

24、作为优选的技术方案,得到对应的上下文嵌入后,训练图片的类别集合定义为

25、所述概率计算的公式为:

26、

27、其中,为候选框x被预测为类别c的概率,exp()为以自然常数e为底的指数函数,cos()为余弦相似度函数,w(x)为候选框x的候选框特征,tc为类别c的上下文嵌入,tc′为类别c′的上下文嵌入,τ为用于缩放的温度参数;

28、所述背景类别特定提示模块的损失函数采用交叉熵损失函数实现,表示为:

29、

30、其中,lcls为前景分类损失函数,表示为:

31、

32、lbcp为背景分类损失函数,表示为:

33、

34、lrlx为软背景分类损失函数,表示为:

35、

36、为所有背景类别的概率分数之和;γ为阈值,p为前景候选框,n为背景候选框,c(x)为候选框x的真实类别标注,noa=no+na+1为的类别数量,no为背景候选框中潜在类别的最优数量,na为预定义的超参数。

37、作为优选的技术方案,所述使用背景物体发掘模块基于图像候选框的特征及聚类中心的嵌入对图像候选框赋予伪标签并调整,具体为:

38、计算所有候选框被分为类别c∈c′o的概率分数公式为:

39、

40、其中,c′o为潜在类别co中的聚类中心嵌入集合,i(x)为clip模型的图像编码器输入候选框x输出的clip特征,为类别c对应的聚类中心嵌入,τ为用于缩放的温度参数,为类别c′对应的聚类中心嵌入;

41、选择具有最高概率分数的预测类别标签作为该候选框的伪标签,表示为:

42、

43、其中,yo(x)为候选框x的伪标签;

44、使用阈值θ对伪标签的概率分数进行提议筛选,并基于每个类别的非最大抑制使用roi head优化边界框预测,生成最终伪标签;

45、使用最终伪标签为每个训练批次中的所有背景候选框分配c′o中的类别标签;

46、构建背景物体发掘模块的损失函数。

47、作为优选的技术方案,所述背景物体发掘模块的损失函数lbod表示为:

48、

49、其中,表示从c′o赋予类标签的正背景候选框集合,剩余的背景候选框表示为表示候选框x类别c为伪标签的概率分数。

50、作为优选的技术方案,训练过程中,clip模型的图像编码器和文本编码器的权重参数是被冻结的。

51、作为优选的技术方案,将推理图片和推理图片对应的基础类别cb、可学习的背景类别、新推理类别及其对应的上下文提示输入背景类别特定提示模块和背景物体发掘模块进行类别预测,并使用推理概率校正模块进行修改正得到推理图片的预测类别;所述推理图片的所有类别表示为其中,cb为推理图片的基础类别,co为推理图片的潜在类别,cu为新推理类别,为推理图片的超类;

52、所述预测类别修正后的概率公式为:

53、

54、其中,为推理图片x被预测为类别c的概率分数,w(x)为推理图片x的全局图像特征,tc为类别c的上下文嵌入,τ为用于缩放的温度参数,

55、∑b,u表示为:

56、

57、表示为:

58、

59、∑bg表示为:

60、

61、tc′为类别c′对应的上下文嵌入,

62、p(c″|c′,x)为类别c′∈co和类别c″∈cu的概率,表示为:

63、

64、s(a,b)为余弦指数得分,表示为:

65、s(a,b)=exp(cos(a,b)/τ)

66、a、b为输入参数。

67、本发明与现有技术相比,具有如下优点和有益效果:

68、1、本发明通过使用多个背景类别嵌入,相比于以往蒸馏方法中的使用的单一类别嵌入,增强了背景类别的表达能力,并缓解了蒸馏损失和分类损失的冲突。

69、2、本发明通过挖掘背景候选框中的隐藏物体,有效利用了背景中的隐含类别信息。

70、3、本发明在训练时不需要利用推理时新类别的先验知识,如新类别名称或新类别弱监督标注,相比于部分利用了这些先验知识的技术,具有更广的应用场景。

本文地址:https://www.jishuxx.com/zhuanli/20240914/296502.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。