一种视频目标融合激光雷达目标的路侧感知方法及系统与流程

- 国知局

- 2024-10-15 10:04:36

本发明涉及智慧交通检测领域,更具体地说,它涉及一种视频目标融合激光雷达目标的路侧感知方法及系统。

背景技术:

1、随着经济的发展,交通场景下的机动车、非机动车和行人目标越来越多,依赖人工统计和计算交通参数发现交通目标违法事件已成为过去时。智能交通系统能够实时感知监测任何路口冲突点,为管控人员提供路口视角,还能实时显示路口信号控制方案和当前相位,实现路口与干线的信控优化,对实现智慧城市建设的发展和经济发展起着至关重要的作用。

2、当前的智能交通系统实时感知监测,主要是基于多个相机进行独立感知任务,然后再将这些传感器的目标融合到一起,由于单个传感器的视野有限,传感器在相互融合的过程中,容易出现由于目标被截断导致的目标分裂现象(即多台传感器的交界处只有一个目标,但融合后感知到两个目标)。且图像检测易受到环境,光照,遮挡等因素的影响,会出现漏检或误检现象。因此,出现传感器融合激光雷达的方法,现有的传感器融合激光雷达包含前融合和后融合方法。其中前融合需要获取相机与激光雷达外参,再将点云三维坐标系下的点投影到相机三维坐标系下,当激光雷达和相机同时工作时,它们获取的数据可以在同一坐标系下进行比较和融合,从而产生更准确、一致的感知结果。后融合则是将雷达点云检测得到的目标数据与相机检测得到的目标数据进行比较,从而实现融合。

3、在现有的后融合技术中,主要是先基于激光雷达数据检测出所有雷达目标,再依次遍历每台相机目标,若认为相机目标与雷达目标是同一目标,则将相机目标对应的目标类型赋给对应的雷达目标。上述过程,适用于激光雷达、相机较少的情况,对于多激光雷达、多相机的情况存在运算量过大、效率较低的问题。

4、有鉴于此,本技术提供一种视频目标融合激光雷达目标的路侧感知方法及系统,解决上述问题。

技术实现思路

1、本技术的目的是提供一种视频目标融合激光雷达目标的路侧感知方法及系统,解决现有路侧感知融合技术针对多激光雷达、多相机场景存在运算量过大、效率较低的问题,通过独立融合识别多雷达数据,独立识别融合多相机数据,最后将两种融合结果在鸟瞰(bev)层面进行最终融合,实现多雷达、多相机数据的高效融合,充分利用激光雷达、相机在路侧感知方面的优势,构建用于路侧感知的路口bev图像。

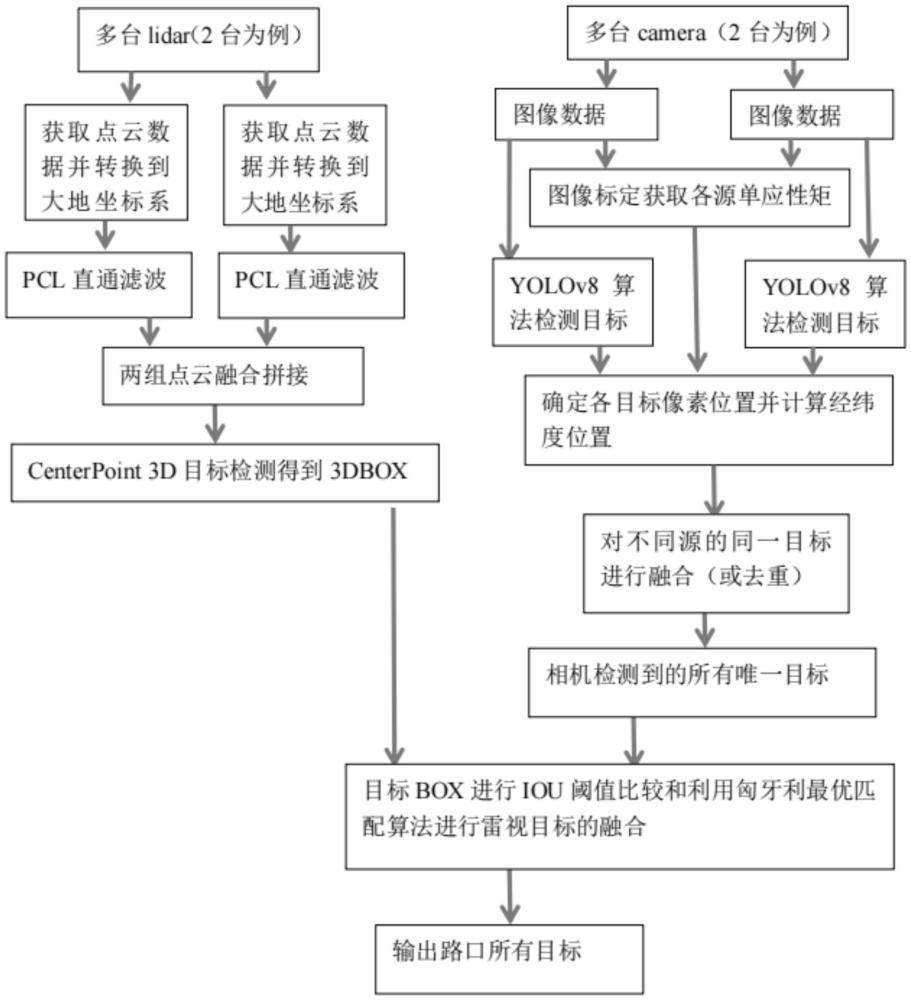

2、本技术首先提供一种视频目标融合激光雷达目标的路侧感知方法,包括:s1、获取路口至少两台激光雷达的点云数据,获取路口至少两台相机的图像数据;s2、对不同激光雷达的点云数据进行融合,得到融合点云数据,对所述融合点云数据进行centerpoint3d目标检测,得到雷达目标;s3、对不同相机的图像数据同步进行目标检测,将不同相机的目标检测结果进行融合,得到相机目标;s4、从鸟瞰角度进行雷达目标和相机目标融合,得到路口bev图像。

3、采用上述技术方案,通过独立进行激光雷达点云数据的融合识别,独立进行相机数据的识别融合,最后将两种传感器的融合结果在鸟瞰(bev)层面进行最终融合,得到当前路口视野范围内的所有目标及目标位置,可用于构建路口bev图像;通过上述步骤实现多激光雷达、多相机数据融合,可以有效避免盲区漏检的情况,提高数据准确性;同时结合激光雷达、相机以及bev层面的各自优势,实现高效、精准、直观的路侧感知。

4、在一种可能的实施方式中,s2包括:s21、对不同激光雷达的点云数据进行坐标转换,得到大地坐标系下的点云数据;s22、对坐标转换后的点云数据进行预处理,得到滤除非道路运动目标后的点云数据;s23、对预处理后的点云数据进行拼接,得到融合点云数据;s24、对融合点云数据进行centerpoint 3d目标检测,得到雷达目标。

5、在一种可能的实施方式中,所述预处理为pcl直通滤波。

6、在一种可能的实施方式中,s3包括:s31、计算不同相机像素平面到84坐标平面的单应性矩阵;s32、对不同相机的图像数据进行目标检测,得到相机目标的像素位置和类型;s33、基于单应性矩阵对相机目标的像素位置进行转换,得到相机目标的84坐标系坐标;s34、通过各相机图像对应的84坐标系坐标配合匈牙利最优匹配算法,并结合目标类型和车牌参数进行目标融合,得到路口所有相机目标的位置及类型。

7、在一种可能的实施方式中,s31包括:从相机的图像数据中选取n个不共线的特征点,获取特征点的像素坐标和84坐标系坐标,将特征点的像素坐标和84坐标系坐标作为特征点对,从特征点对的数据集中每次随机抽取4个特征点对组成样本集合;基于样本集合进行单应性矩阵计算,通过最小二乘法估计求解得到单应性矩阵;基于单应性矩阵求解数据集中所有特征点对的标定误差并提取标定误差中值;循环上述步骤k次,k为正整数,取标定误差中值最小的单应性矩阵作为相机像素平面到84坐标平面的单应性矩阵。

8、在一种可能的实施方式中,s34包括:对不同相机视野重叠区域的机动车类相机目标进行车牌检测,得到车牌图片;对车牌图片进行变换处理,对变换处理后的车牌图片进行识别,将识别置信度高于阈值的车牌号码与相机目标的跟踪id进行绑定;将不同相机图像数据中车牌号码相同的相机目标视作同一相机目标。

9、在一种可能的实施方式中,s34还包括:对不同相机视野重叠区域的相机目标,根据相机目标的类型和相机目标的84坐标系坐标设置相机目标的位置区间;对不同相机图像上84坐标系坐标距离小于阈值的同类型相机目标进行标记;计算不同相机图像中标记相机目标在84坐标系下占地面面积的iou值,将iou值大于阈值thred0的相机目标视作同一相机目标。

10、在一种可能的实施方式中,s34还包括:对不同相机视野重叠区域的相机目标,计算相机目标在84坐标系的距离,将距离小于阈值thred1的相机目标视作同一目标,对距离大于thred1小于thred2的相机目标,则对比相机目标的类型和/或车牌颜色,若相机目标的类型和/或车牌颜色相同,则认为是同一目标。

11、在一种可能的实施方式中,s4包括:在bev下绘制雷达目标3dbox和相机目标图像box,将大地坐标iou值大于阈值thred3的目标视作同一目标;结合匈牙利最优匹配算法进行雷视融合,得到路口bev图像。

12、本技术还提供一种视频目标融合激光雷达目标的路侧感知系统,用于实现如上述的一种视频目标融合激光雷达目标的路侧感知方法,包括:数据获取模块,用于获取路口至少两台激光雷达的点云数据,获取路口至少两台相机的图像数据;激光雷达数据处理模块,用于对不同激光雷达的点云数据进行融合,得到融合点云数据,对所述融合点云数据进行centerpoint3d目标检测,得到雷达目标;相机数据处理模块,用于对不同相机的图像数据同步进行目标检测,将不同相机的目标检测结果进行融合,得到相机目标;数据融合模块,用于从鸟瞰角度进行雷达目标和相机目标融合,得到路口bev图像。

13、与现有技术相比,本技术具有以下有益效果:通过独立进行激光雷达数据的融合,独立进行摄像头数据的融合,然后将两种传感器的融合结果在鸟瞰(bev)层面进行最终融合;通过联合使用激光雷达和相机,充分利用两种传感器的优点,综合利用激光雷达的距离信息和相机的视觉信息,减少各自的盲区和局限性,增强对物体的检测、跟踪和识别能力,提高三维重建效果;利用多个摄像头图像信息进行目标检测和跟踪的方法,针对车路协同场景下十字路口中间多台相机同时拍摄路口中间,可以有效避免大流量交通目标场景下由于车辆相互遮挡带来的目标漏检现象。

本文地址:https://www.jishuxx.com/zhuanli/20241015/316353.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表