用于长文本大语言模型的无偏增量式优化方法、电子设备和存储介质

- 国知局

- 2024-11-06 14:22:34

本发明涉及深度学习的大语言模型长文本外推领域,特别是指一种用于长文本大语言模型的无偏增量式优化方法、电子设备和存储介质,可高效地拓展现有开源大语言模型可处理的最大文本长度。

背景技术:

1、近年来,随着大语言模型的逐渐落地,使用大语言模型处理长文本的需求日益增长。然而,由于大语言模型的自注意力机制的平方复杂度,不论是在长文本上进行训练还是进行推理,开销都非常大。

2、现有技术中,主流的改进方案绝大部分致力于减少在长文本上进行训练的开销,而并没有解决推理开销大的问题,因此在实际部署中仍有阻碍。虽然将循环神经网络与自注意机制结合的方法,可以有效缓解长文本训练和推理的开销,但对于十万词元级别的过长文本而言,其训练开销依然无法负担,从而阻碍了该类方法的进一步发展。

技术实现思路

1、本发明的目的在于提供一种用于长文本大语言模型的无偏增量式优化方法、电子设备和存储介质,解决现有技术中存在的问题,实现对循环神经网络与自注意机制结合的方法进行优化,降低其训练开销,使得可以使用有限的计算资源来适配十万词元级别的文本的训练。

2、为了达成上述目的,本发明的解决方案是:

3、一种用于长文本大语言模型的无偏增量式优化方法,包括以下步骤:

4、步骤1、采用lora方法对大语言模型进行微调;将大语言模型的原始输入文本进行片段切割,得到若干个文本片段;

5、步骤2、对于每个文本片段:

6、步骤2-1、首先进行前向传播,保留该文本片段中的记忆词元所对应的激活值,并将前向传播过程的最后一层输出与其输入右移一个token所得的标签进行计算交叉熵损失,在前向传播的同时保留其计算图不销毁;

7、步骤2-2、对语言建模损失进行反向传播算法,得到该文本片段的交叉熵损失对于在每一层中留下的记忆词元激活值的梯度,以及该交叉熵损失对于所有lora微调参数的梯度;

8、步骤3、设置固定大小的截断窗口,对所有文本片段应用淘汰机制;对于即将被淘汰出截断窗口的文本片段,将其产生的记忆词元激活值进行反向传播,并销毁其计算图,得到这些记忆词元激活值对于记忆词元本身以及lora微调参数的梯度;

9、步骤4、在所有文本片段依次处理完成之后,对截断窗口内剩余的文本片段产生的记忆词元进行反向传播,并销毁其计算图。

10、所述步骤3中,淘汰机制选择的是蓄水池抽样算法。

11、一种电子设备,包括处理器、存储器和应用程序;所述应用程序被存储在所述存储器中,并被配置为由所述处理器执行所述的用于长文本大语言模型的无偏增量式优化方法。

12、一种计算机可读存储介质,所述存储介质存储有计算机程序;所述计算机程序在所述计算机中执行时,使所述计算机执行所述的用于长文本大语言模型的无偏增量式优化方法。

13、采用上述技术方案后,本发明具有以下技术效果:

14、①本发明针对循环神经网络与自注意机制结合的方法进行优化——透过时间的反向传播入手,首先通过设置固定大小的截断窗口,使得训练开销降为常数级别,然后提出一种增量式的优化手段,避免了很多重复计算,大大降低训练的时间开销,此外还提出将有限的截断窗口均等地分配给以往所有的文本片段,从而实现对梯度的无偏估计;

15、②在使用本技术之后,相比于原始的透过时间的反向传播优化算法而言,在十万次元上训练的时间和空间开销可以下降数十倍,极大地拓展了该类方法在过长文本处理上的性能上限。

技术特征:1.一种用于长文本大语言模型的无偏增量式优化方法,其特征在于包括以下步骤:

2.如权利要求1所述的用于长文本大语言模型的无偏增量式优化方法,其特征在于:

3.一种电子设备,其特征在于:

4.一种计算机可读存储介质,其特征在于:

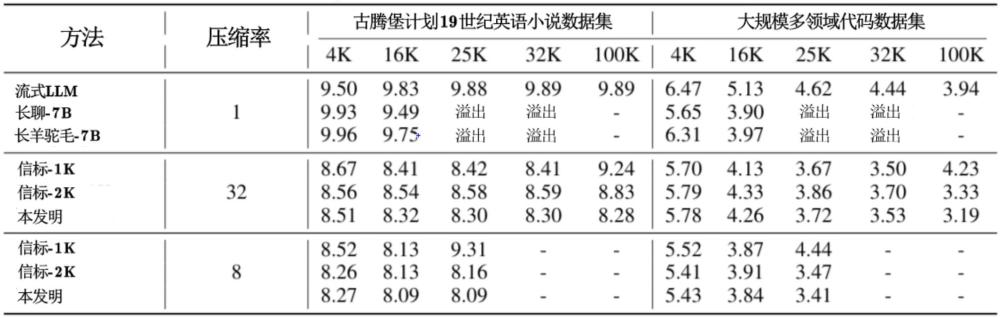

技术总结本发明公开一种用于长文本大语言模型的无偏增量式优化方法、电子设备和存储介质,实现对循环神经网络与自注意机制结合的方法进行优化,降低其训练开销,使得可以使用有限的计算资源来适配十万词元级别的文本的训练。本发明在现有的大语言模型的基础上,采用Lora方法进行微调,并添加一个对于输入文本的切片机制:对于每个所得的文本片段,在其后面添加少数可训练的记忆词元,通过训练这些记忆词元以及对模型本身的微调,让每个文本片段的内容迁移到对应的记忆词元中,最后将所有片段产生的记忆词元汇总到一起,作为上下文提供给大语言模型解码使用。技术研发人员:纪荣嵘,李文昊,林明宝受保护的技术使用者:厦门大学技术研发日:技术公布日:2024/11/4本文地址:https://www.jishuxx.com/zhuanli/20241106/321678.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表