结合大语言模型的深度合成音频检测方法、系统和产品

- 国知局

- 2024-06-21 11:29:50

本技术涉及音频检测,特别是一种结合大语言模型的深度合成音频检测方法、系统和产品。

背景技术:

1、现有音频检测技术主要分为人工主观评价和传统机器学习两种方式:其中,人工主观评价的方法是直接依赖听众的主观判断,然后计算平均意见分数(mean opinionscore,mos)来评估音频的真实性和相似性,这种方法过于依赖人为主观判断,可能存在主观性和不一致性的问题。另一种传统机器学习的方法,通常依赖于手工提取的特征,从而根据提取到的特征检测伪造音频,该方法的检测性能受到特征选择和模型泛化的限制,难以应对不断演进的伪造技术。

2、综上,现有的音频检测技术在处理能够模仿真实音频的声纹特征和声音特点的深度伪造音频时,检测准确率较低,无法达到理想的检测效果。因此,有必要开发一种结合大语言模型的深度合成音频检测方法、系统和产品,以提高对深度伪造音频的检测性能。

技术实现思路

1、鉴于上述问题,本技术实施例提供了一种结合大语言模型的深度合成音频检测方法、系统和产品,以便克服上述问题或者至少部分地解决上述问题。

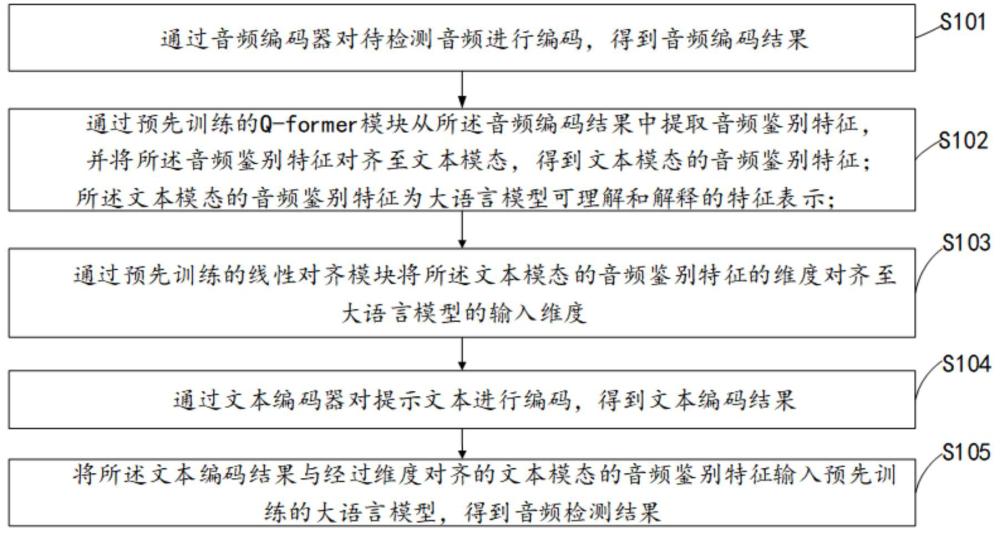

2、本技术实施例的第一方面,提供了一种结合大语言模型的深度合成音频检测方法,包括:

3、通过音频编码器对待检测音频进行编码,得到音频编码结果;

4、通过预先训练的q-former模块从所述音频编码结果中提取音频鉴别特征,并将所述音频鉴别特征对齐至文本模态,得到文本模态的音频鉴别特征;所述文本模态的音频鉴别特征为大语言模型可理解和解释的特征表示;

5、通过预先训练的线性对齐模块将所述文本模态的音频鉴别特征的维度对齐至大语言模型的输入维度;

6、通过文本编码器对提示文本进行编码,得到文本编码结果;

7、将所述文本编码结果与经过维度对齐的文本模态的音频鉴别特征输入预先训练的大语言模型,得到音频检测结果。

8、在一种可能的实施方式中,所述q-former模块的训练过程包括:

9、获取包含真实样本音频和合成样本音频的训练数据集,和每个样本音频对应的文本信息,所述文本信息为表示该样本音频为真实音频或合成音频的音频真伪标签信息;

10、利用所述训练数据集和所述文本信息,通过对比学习,训练q-former模块,在所述q-former模块能够查询出音频特征中的鉴别特征,并将所述鉴别特征对齐至文本模态时,结束训练。

11、在一种可能的实施方式中,将可学习的query embeddings作为所述q-former模块的输入,所述q-former模块的训练过程具体包括:

12、通过音频编码器对所述样本音频进行编码,得到样本音频编码结果;

13、通过文本编码器对所述样本音频对应的文本信息进行编码,得到样本文本编码结果;

14、将所述样本音频编码结果和所述样本文本编码结果输入待训练的q-former模块,得到预测音频鉴别特征;

15、以使同一对的样本音频和文本信息在编码空间中更加接近,不属于同一对的样本音频和文本信息在编码空间中更加远离为目标,根据所述预测音频鉴别特征计算对比损失值;

16、根据计算得到的对比损失值,更新所述query embeddings的参数;

17、重复上述过程,直至对比损失值收敛,结束训练。

18、在一种可能的实施方式中,所述q-former模块为基于双向编码表示(bidirectional encoder representations from transformers,bert)模型的编码器,所述q-former模块中的偶数层中包括一个ca层,所述ca层用于处理输入的音频和所述queryembeddings之间的交互;其中,所述偶数层的结构为:顺次连接的输入端、sa层、ca层、前馈层和输出端。

19、在一种可能的实施方式中,所述线性对齐模块和所述大语言模型的训练过程包括:

20、获取包含真实样本音频和合成样本音频的训练数据集,和每个样本音频对应的文本信息,所述文本信息为表示该样本音频为真实音频或合成音频的音频真伪标签信息;

21、通过音频编码器对所述样本音频进行编码,得到样本音频编码结果;

22、通过文本编码器对提示文本进行编码,得到样本文本编码结果;所述提示文本为提示检测该音频为合成音频或真实音频的问句文本信息;

23、通过所述预先训练的q-former模块从所述样本音频编码结果中提取音频鉴别特征,并将所述音频鉴别特征对齐至文本模态,得到文本模态的音频鉴别特征;

24、通过待训练的线性对齐模块,将文本模态的音频鉴别特征的维度对齐至大语言模型的输入维度;

25、将所述样本文本编码结果与经过维度对齐的文本模态的音频鉴别特征输入待训练的大语言模型,得到音频预测结果;

26、根据所述音频预测结果和所述样本音频对应的文本信息,计算损失函数值,根据所述损失函数值,更新所述线性对齐模块和所述大语言模型的参数;

27、重复上述步骤,在所述损失函数值收敛的情况下,结束训练。

28、在一种可能的实施方式中,所述音频编码器为wav2vec2模型,用于对音频数据进行特征提取,将提取得到的音频特征映射为向量表示,所述向量表示包括:音频的频率分布特征和/或语音合成模型的痕迹特征。

29、在一种可能的实施方式中,所述文本编码器由bert模型构成,所述bert模型用于捕获文本数据中的上下文信息和语义关系;所述bert模型的架构包括多层transformer编码器,具有双向的注意力机制。

30、本技术实施例第二方面还提供了一种结合大语言模型的深度合成音频检测系统,所述系统包括:

31、音频编码器,用于对待检测音频进行编码,得到音频编码结果;

32、q-former模块,用于从所述音频编码结果中提取音频鉴别特征,并将所述音频鉴别特征对齐至文本模态,得到文本模态的音频鉴别特征;所述文本模态的音频鉴别特征为大语言模型可理解和解释的特征表示;

33、线性对齐模块,用于将所述文本模态的音频鉴别特征的维度对齐至大语言模型的输入维度;

34、文本编码器,用于对提示文本进行编码,得到文本编码结果;

35、大语言模型,用于根据所述文本编码结果与经过维度对齐的文本模态的音频鉴别特征,得到音频检测结果。

36、在一种可能的实施方式中,所述q-former模块的训练过程包括:

37、获取包含真实样本音频和合成样本音频的训练数据集,和每个样本音频对应的文本信息,所述文本信息为表示该样本音频为真实音频或合成音频的音频真伪标签信息;

38、利用所述训练数据集和所述文本信息,通过对比学习,训练q-former模块,在所述q-former模块能够查询出音频特征中的鉴别特征,并将所述鉴别特征对齐至文本模态时,结束训练。

39、在一种可能的实施方式中,将可学习的query embeddings作为所述q-former模块的输入,所述q-former模块的训练过程具体包括:

40、通过音频编码器对所述样本音频进行编码,得到样本音频编码结果;

41、通过文本编码器对所述样本音频对应的文本信息进行编码,得到样本文本编码结果;

42、将所述样本音频编码结果和所述样本文本编码结果输入待训练的q-former模块,得到预测音频鉴别特征;

43、以使同一对的样本音频和文本信息在编码空间中更加接近,不属于同一对的样本音频和文本信息在编码空间中更加远离为目标,根据所述预测音频鉴别特征计算对比损失值;

44、根据计算得到的对比损失值,更新所述query embeddings的参数;

45、重复上述过程,直至对比损失值收敛,结束训练。

46、在一种可能的实施方式中,所述q-former模块为基于bert模型的编码器,所述q-former模块中的偶数层中包括一个ca层,所述ca层用于处理输入的音频和所述queryembeddings之间的交互;其中,所述偶数层的结构为:顺次连接的输入端、sa层、ca层、前馈层和输出端。

47、在一种可能的实施方式中,所述线性对齐模块和所述大语言模型的训练过程包括:

48、获取包含真实样本音频和合成样本音频的训练数据集,和每个样本音频对应的文本信息,所述文本信息为表示该样本音频为真实音频或合成音频的音频真伪标签信息;

49、通过音频编码器对所述样本音频进行编码,得到样本音频编码结果;

50、通过文本编码器对提示文本进行编码,得到样本文本编码结果;所述提示文本为提示检测该音频为合成音频或真实音频的问句文本信息;

51、通过所述预先训练的q-former模块从所述样本音频编码结果中提取音频鉴别特征,并将所述音频鉴别特征对齐至文本模态,得到文本模态的音频鉴别特征;

52、通过待训练的线性对齐模块,将文本模态的音频鉴别特征的维度对齐至大语言模型的输入维度;

53、将所述样本文本编码结果与经过维度对齐的文本模态的音频鉴别特征输入待训练的大语言模型,得到音频预测结果;

54、根据所述音频预测结果和所述样本音频对应的文本信息,计算损失函数值,根据所述损失函数值,更新所述线性对齐模块和所述大语言模型的参数;

55、重复上述步骤,在所述损失函数值收敛的情况下,结束训练。

56、在一种可能的实施方式中,所述音频编码器为wav2vec2模型,用于对音频数据进行特征提取,将提取得到的音频特征映射为向量表示,所述向量表示包括:音频的频率分布特征和/或语音合成模型的痕迹特征。

57、在一种可能的实施方式中,所述文本编码器由bert模型构成,所述bert模型用于捕获文本数据中的上下文信息和语义关系;所述bert模型的架构包括多层transformer编码器,具有双向的注意力机制。

58、本技术实施例第三方面还提供了一种电子设备,包括存储器、处理器及存储在所述存储器上的计算机程序,所述处理器执行所述计算机程序以实现本技术实施例第一方面所述的结合大语言模型的深度合成音频检测方法中的步骤。

59、本技术实施例第四方面还提供了一种计算机可读存储介质,其上存储有计算机程序/指令,该计算机程序/指令被处理器执行时实现本技术实施例第一方面所述的结合大语言模型的深度合成音频检测方法中的步骤。

60、本技术实施例第五方面还提供了一种计算机程序产品,所述计算机程序产品在电子设备上运行时,使处理器执行时实现如本技术实施例第一方面所述的结合大语言模型的深度合成音频检测方法中的步骤。

61、本技术实施例提供了一种结合大语言模型的深度合成音频检测方法、系统和产品,该方法包括:通过音频编码器对待检测音频进行编码,得到音频编码结果;通过预先训练的q-former模块从所述音频编码结果中提取音频鉴别特征,并将所述音频鉴别特征对齐至文本模态,得到文本模态的音频鉴别特征;所述文本模态的音频鉴别特征为大语言模型可理解和解释的特征表示;通过预先训练的线性对齐模块将所述文本模态的音频鉴别特征的维度对齐至大语言模型的输入维度;通过文本编码器对提示文本进行编码,得到文本编码结果;将所述文本编码结果与经过维度对齐的文本模态的音频鉴别特征输入预先训练的大语言模型,得到音频检测结果。

62、具体有益效果在于:

63、一方面,本技术实施例通过预先训练的q-former模块从音频编码结果中提取得到音频鉴别特征,并将该音频鉴别特征对齐至文本模态,在音频模态和文本模态之间建立有意义的联系,帮助大语言模型理解音频鉴别特征,使得系统更能够理解和区分真实音频和合成音频,为深度合成音频的准确检测提供了关键支持。

64、另一方面,本技术实施例利用大语言模型的理解能力,使系统对提示文本的语境和含义有更深层次的理解,充分利用了音频数据的多模态信息,实现了语义信息和音频特征的整合分析,使得鉴伪分析更为精准,能够更好地辨别合成音频。此外,大语言模型的自适应性能力使系统更具灵活性,能够及时适应新的伪造模式和技术,进一步提高了音频鉴伪的准确性,为用户提供更可靠的检测结果。

本文地址:https://www.jishuxx.com/zhuanli/20240618/21849.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。