语音合成方法、装置、可读介质及电子设备与流程

- 国知局

- 2024-06-21 11:36:18

本公开涉及计算机,具体地,涉及一种语音合成方法、装置、可读介质及电子设备。

背景技术:

1、在一些语音合成的场景(例如,虚拟角色的配音、有声阅读的分角色朗读等)中,为了实现角色的区分,需要为不同的角色生成具有不同特点的声音。相关技术中,通常先为不同的角色寻找不同的发音人,再利用发音人的授权的录音数据,使用语音合成的技术还原出发音人的声音作为对应角色的配音。但是,这样的方式既需要寻找特定的发音人,还需要花费较长的周期进行发音人的声音采集、声音学习与声音合成,成本极高,且只能生成已有发音人的声音,语音合成的结果比较单一。

技术实现思路

1、提供该部分内容以便以简要的形式介绍构思,这些构思将在后面的具体实施方式部分被详细描述。该部分内容并不旨在标识要求保护的技术方案的关键特征或必要特征,也不旨在用于限制所要求的保护的技术方案的范围。

2、第一方面,本公开提供一种语音合成方法,所述方法包括:

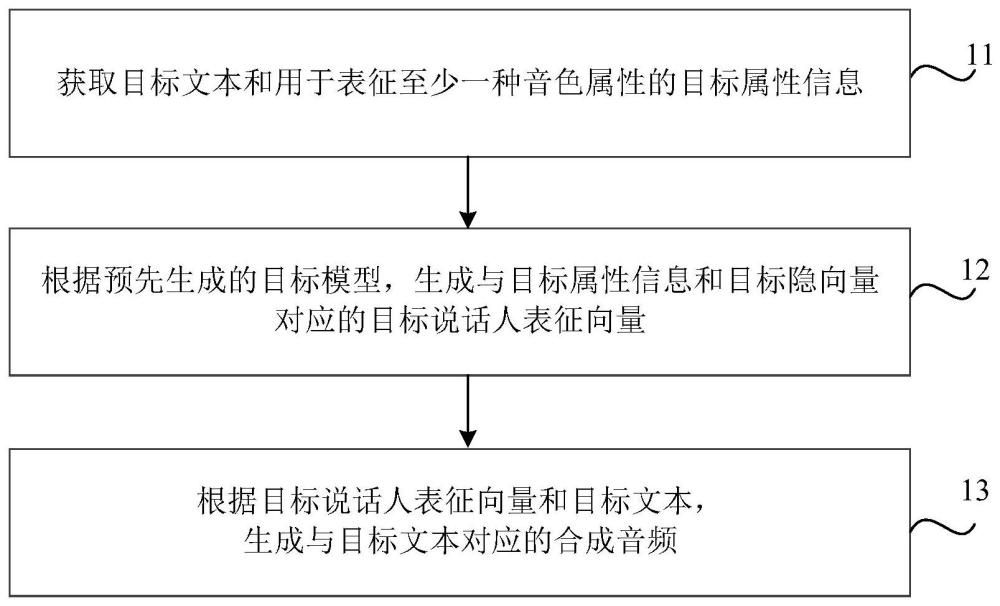

3、获取目标文本和用于表征至少一种音色属性的目标属性信息;

4、根据预先生成的目标模型,生成与所述目标属性信息和目标隐向量对应的目标说话人表征向量,其中,所述目标模型基于流模型生成,所述目标隐向量从高斯分布中采样得到;

5、根据所述目标说话人表征向量和所述目标文本,生成与所述目标文本对应的合成音频。

6、第二方面,本公开提供一种语音合成装置,所述装置包括:

7、第一获取模块,用于获取目标文本和用于表征至少一种音色属性的目标属性信息;

8、第一生成模块,用于根据预先生成的目标模型,生成与所述目标属性信息和目标隐向量对应的目标说话人表征向量,其中,所述目标模型基于流模型生成,所述目标隐向量从高斯分布中采样得到;

9、第二生成模块,用于根据所述目标说话人表征向量和所述目标文本,生成与所述目标文本对应的合成音频。

10、第三方面,本公开提供一种计算机可读介质,其上存储有计算机程序,该程序被处理装置执行时实现本公开第一方面所述方法的步骤。

11、第四方面,本公开提供一种电子设备,包括:

12、存储装置,其上存储有至少一个计算机程序;

13、至少一个处理装置,用于执行所述存储装置中的所述至少一个计算机程序,以实现本公开第一方面所述方法的步骤。

14、通过上述技术方案,获取目标文本和用于表征至少一种音色属性的目标属性信息,再根据基于流模型生成的目标模型,生成与目标属性信息和从高斯分布中采样得到的目标隐向量对应的目标说话人表征向量,并根据目标说话人表征向量和目标文本,生成与目标文本对应的合成音频。由此,通过引入目标属性信息,可以生成符合该目标属性信息所表征的音色属性的合成音频,有效提高了语音合成时对音色属性的可控性,从而,可以根据不同虚拟角色的特点为其设置音色属性进而合成符合该音色属性的音频。基于此,在为虚拟角色生成声音时,无需再花费成本寻找特定的发音人,也无需花费较长周期学习发音人的声音特性用以合成虚拟角色对应的合成音频,有利于节省成本。

15、本公开的其他特征和优点将在随后的具体实施方式部分予以详细说明。

技术特征:1.一种语音合成方法,其特征在于,所述方法包括:

2.根据权利要求1所述的方法,其特征在于,所述根据预先生成的目标模型,生成与所述目标属性信息和目标隐向量对应的目标说话人表征向量,包括:

3.根据权利要求1所述的方法,其特征在于,所述根据预先生成的目标模型,生成与所述目标属性信息和目标隐向量对应的目标说话人表征向量,包括:

4.根据权利要求1所述的方法,其特征在于,所述目标模型通过以下方式生成:

5.根据权利要求4所述的方法,其特征在于,所述说话人表征向量样本是通过句子级别的音频样本确定的。

6.根据权利要求1所述的方法,其特征在于,所述根据所述目标说话人表征向量和所述目标文本,生成与所述目标文本对应的合成音频,包括:

7.根据权利要求6所述的方法,其特征在于,所述声学模型中设置有条件归一化层,并且,通过将所述目标说话人表征向量输入至所述条件归一化层以将所述目标说话人表征向量输入至所述声学模型中。

8.一种语音合成装置,其特征在于,所述装置包括:

9.一种计算机可读介质,其上存储有计算机程序,其特征在于,该程序被处理装置执行时实现权利要求1-7中任一项所述方法的步骤。

10.一种电子设备,其特征在于,包括:

技术总结本公开涉及一种语音合成方法、装置、可读介质及电子设备。所述方法包括:获取目标文本和用于表征至少一种音色属性的目标属性信息;根据预先生成的目标模型,生成与所述目标属性信息和目标隐向量对应的目标说话人表征向量,其中,所述目标模型基于流模型生成,所述目标隐向量从高斯分布中采样得到;根据所述目标说话人表征向量和所述目标文本,生成与所述目标文本对应的合成音频。由此,可以根据不同虚拟角色的特点为其设置音色属性进而合成符合该音色属性的音频。基于此,在为虚拟角色生成声音时,无需再花费成本寻找特定的发音人,也无需花费较长周期学习发音人的声音特性用以合成虚拟角色对应的合成音频,有利于节省成本。技术研发人员:邹雨巷,马泽君受保护的技术使用者:北京有竹居网络技术有限公司技术研发日:技术公布日:2024/3/12本文地址:https://www.jishuxx.com/zhuanli/20240618/22333.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表