面向语音关键词识别的二值化深度神经网络硬件加速系统

- 国知局

- 2024-06-21 11:55:29

本发明涉及语音关键词识别领域,具体涉及一种面向语音关键词识别的二值化深度神经网络硬件加速系统。

背景技术:

1、一般情况下,人工智能助手会在无人使用的情况下休眠以延长待机时间。关键词识别(keword spotting, kws)模块作为声音识别的轻量化接口,对环境中的唤醒关键词进行实时检测从而在必要的时候激活人工智能助手。

2、语音关键词识别的现有技术,如专利申请cn117373435a -基于噪声抑制残差网络的语音关键词识别方法,该发明在原有的模型框架上进行改进,提出了噪声抑制层和频带加权归一化方法,以实现高鲁棒性、低参数占用的目标,但是其计算复杂度依旧不满足移动设备对于低功耗的需求。专利申请cn116434742a-基于无监督学习和迁移学习的低资源语音关键词检测方法,该发明结合了无监督学习和迁移学习,充分利用了无标注数据和有标注数据,提高了在低资源条件下语音关键词检测性能,改善语音关键词检测领域数据不足的情况,但该方法对于语音关键词的识别精度不足,容易发生误识别和漏识别问题。

3、而目前许多人工智能助手工作在移动环境下,只能依靠自身存储的电能工作。因此,一直处于运行状态的kws模块功耗很大程度上决定了人工智能助手的待机时间。除了待机时间,人工智能助手的误唤醒和漏唤醒次数也影响着用户的体验,这取决于kws模块的识别准确率。因此,研究人员在kws领域持续追求的两个主要目标是降低功耗和提高识别准确率。

4、在之前的研究工作中,研究人员主要利用二值量化网络、模型简化、近似计算等方法来优化kws的功耗。在这些方法中,bnn表现出独特的优势,其特点是将权重值量化为单bit,从而大幅度减少计算量,实现低功耗识别。

技术实现思路

1、本发明的目的在于针对传统二值神经网络在语音关键词分类问题中识别精度差的问题,提供一种面向语音关键词识别的二值化深度神经网络硬件加速系统,与传统bnn相比,本发明对语音识别的结果处理过程进行增强;同时本发明通过利用连续语音帧之间的时间相关性,对神经网络的初步预测概率输出进行平滑等处理,有效提高了关键词识别的准确率。

2、为实现上述目的,本发明的技术方案是:一种面向语音关键词识别的二值化深度神经网络硬件加速系统,包括:

3、mfcc模块,用于提取输入语音特征,并进行预处理;

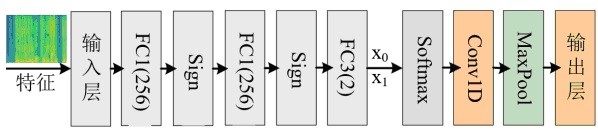

4、二值化深度神经网络模块,对mfcc模块预处理的语音特征进行识别以区分关键词和非关键词;所述二值化深度神经网络模块包括依次连接的输入层、全连接层fc1、全连接层fc2、全连接层fc3、归一化层、一维卷积层conv1d、最大池化层maxpool、输出层。

5、在本发明一实施例中,所述全连接层fc1、全连接层fc2均为神经元数量为256的二值全连接层,二值全连接层的计算公式如下式所示:

6、

7、其中, x j是二值全连接层第 j个神经元的单比特输入数据, w j为相应的单比特权重, b代表偏置项, z为二值全连接层的输出。

8、在本发明一实施例中,所述全连接层fc1、全连接层fc2之间引入sign函数作为激活函数,全连接层fc2、全连接层fc3之间引入sign函数作为激活函数;sign函数对全连接层fc1、全连接层fc2的输出进行二值化,具体计算公式如下:

9、

10、其中, z binary表示二值化结果;

11、由此,二值全连接层的计算及激活过程简化为下式所示:

12、。

13、在本发明一实施例中,所述全连接层fc3为神经元数量为2的全连接层,全连接层fc3的2个神经元别输出关键词类别和非关键词类别的初步预测概率。

14、在本发明一实施例中,所述归一化层采用优化的softmax对全连接层fc3输出的初步预测概率进行归一化处理,优化的softmax即利用relu函数替代指数函数,具体计算公式如下:

15、

16、其中, x i为初步预测概率, i为初步预测概率的时间索引, p i为归一化处理后的初步预测概率。

17、在本发明一实施例中,所述一维卷积层conv1d对归一化处理后的初步预测概率进行调整,以消除孤立噪声点的影响,所述一维卷积层conv1d的卷积核尺寸为8,滑动步长为1,具体计算公式如下:

18、

19、其中, p k为归一化处理后的初步预测概率, w k为经过训练得到的一维卷积层conv1d滤波器系数, j为一维卷积层conv1d卷积核窗口内的中心位置, k为一维卷积层conv1d卷积核窗口内的位置索引, p k ’为滤波后的概率, k为滤波后的概率的帧索引,用于标识连续的概率值。

20、在本发明一实施例中,所述最大池化层maxpool尺寸为4,滑动步长为1,计算公式如下:

21、

22、其中, c o为类别置信度得分, o为置信度得分在时间上的索引,max函数为取最大值函数。

23、在本发明一实施例中,所述二值化深度神经网络模块的硬件电路组成包括推理单元、归一化单元、平滑滤波单元和结果生成单元;其中,

24、推理单元,用于实现输入层、全连接层fc1、全连接层fc2、全连接层fc3的功能;

25、归一化单元,用于实现归一化层的功能;

26、平滑滤波单元,用于实现一维卷积层conv1d的功能;

27、结果生成单元,用于实现最大池化层maxpool、输出层的功能。

28、在本发明一实施例中,所述推理单元包括:

29、缓存模块,包括三组fifo缓存器和三个二选一mux,三组fifo缓存器分别用于保存输入层输入数据、全连接层fc1的中间层数据、全连接层fc2的中间层数据;三组fifo缓存器的数据输入分别通过相应的二选一mux进行数据选择,以实现缓存的数据循环读出写入模式与写入新数据模式自由切换;

30、fsm模块,用于控制缓存模块与处理单元pe之间的数据交互以及处理单元pe的数据运算过程;

31、处理单元pe,用于实现缓存模块输出数据的运算与激活操作,处理单元pe的输入为三组fifo缓存器的输出及fsm模块的输出,处理单元pe的输出作为推理单元的输出。

32、相较于现有技术,本发明具有以下有益效果:

33、1、本发明系统相比于传统二值化神经网络,对初步判断结果进行了平滑处理,降低了识别错误率。

34、2、本发明使用的模型对于输入噪声有明显的抑制效果,即本发明系统有更强的鲁棒性,判断精度更高。

35、3、本发明系统的硬件电路结构简单,对硬件资源要求不高,在电路设计过程中采用了近似计算、电路复用等设计思想,具有电路面积小,功耗低等优点,非常适用于移动设备。

本文地址:https://www.jishuxx.com/zhuanli/20240618/24496.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。