基于视觉和语音增强的隐式情感分析方法与流程

- 国知局

- 2024-07-31 22:43:11

本发明涉及人工智能应用领域,具体涉及一种基于视觉和语音增强的隐式情感分析方法。

背景技术:

1、近年来,互联网媒体的迅猛发展,产生了大量蕴含情感倾向的评论信息。由于新媒体具有实时性、传播速度快等特点,在热点事件发生时及时控制好网络舆情的走势迫在眉睫。情感分析(social media sentiment analysis),又称意见挖掘,旨在挖掘文本中的情感信息,是网络舆情分析的重要组成部分。有学者根据主观性和客观性将情感分为显式情感和隐式情感,其中隐式情感表达中不包含明确的情感词。如以事实描述、隐喻、反问及反讽等方式来表达情感。具体示例如表1所示,e1通过乌龟形容跑的慢,句中不包含明显的情感词,但表达了一种负面情绪。e2通过事实描述表达了积极的情感。e3通过反讽的语气暗示了烹饪技能或食物口感不佳,传达了一种嘲讽或调侃的负面情绪。

2、表1隐式情感句示例

3、

4、对于隐式情感表达,由于句中所提供的信息不足,很难捕捉到明确的情感特征,进而难以确定句子的情感倾向。为此,许多研究者通过引入外部知识来补充句子中的显式情感线索。最初的研究只是融合外部文本知识,如有学者通过提取conceptnet4知识库中相关的知识丰富句子的表征辅助隐式情感分析。然而,文本往往会受到噪声词的干扰,并且这类方法会过多依赖于文本语言特征和词汇资源,在跨领域和跨语言中的效果不是很理想。

5、为此,越来越多的研究者尝试融合视觉或语音特征提升隐式情感分析性能,然而,现有的仅融合语音或视觉的方法只是在融合过程中对模态进行了简单的映射,并没有考虑模态对隐式情感分析的贡献以及在融合过程中模态间存在的冗余信息问题。

技术实现思路

1、以下给出一个或多个方面的简要概述以提供对这些方面的基本理解。此概述不是所有构想到的方面的详尽综览,并且既非旨在指认出所有方面的关键性或决定性要素亦非试图界定任何或所有方面的范围。其唯一的目的是要以简化形式给出一个或多个方面的一些概念以为稍后给出的更加详细的描述之序。

2、本发明的目的在于解决上述问题,提供了基于视觉和语音增强的隐式情感分析方法,利用语音、视觉信息辅助隐式文本以增强其蕴含的情感表达,提升隐式情感分析性能,能够更全面地理解和处理隐式情感表达,为情感分析领域的进一步发展提供有力支持。

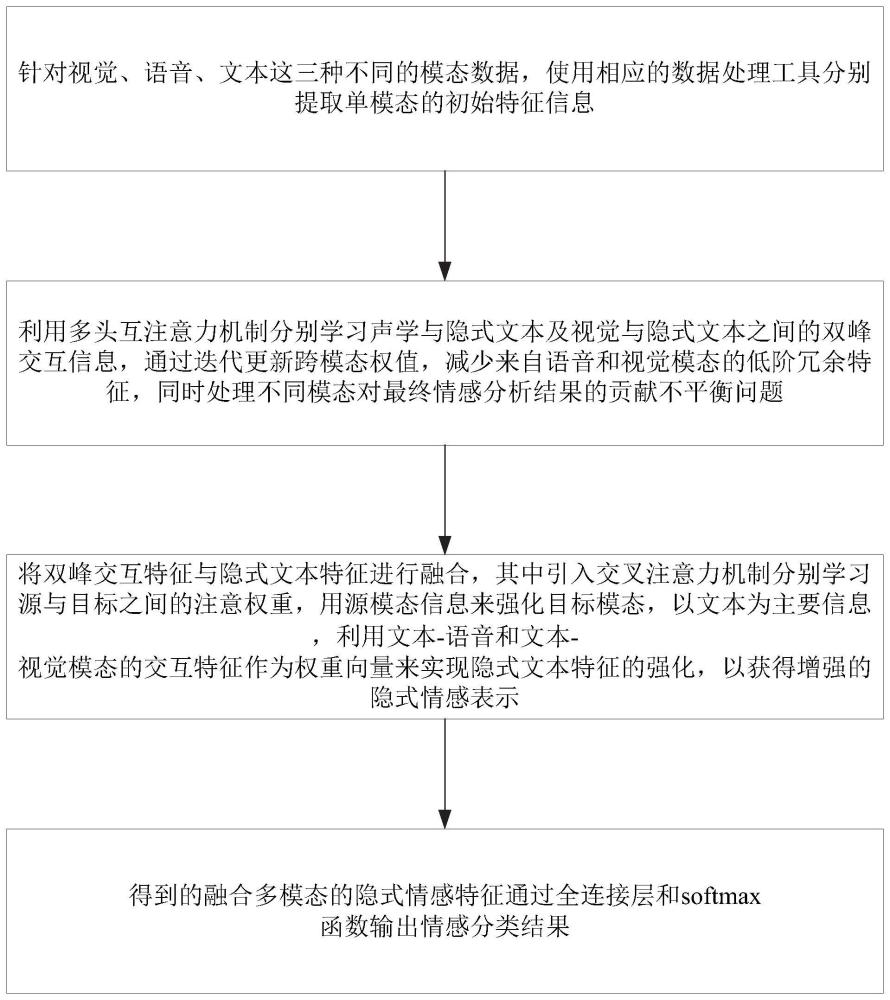

3、本发明的技术方案为:本发明揭示了一种基于视觉和语音增强的隐式情感分析方法,方法包括:

4、步骤1:针对视觉、语音、文本这三种不同的模态数据,使用相应的数据处理工具分别提取单模态的初始特征信息,包括隐式文本特征提取、语音特征提取、视觉特征提取;

5、步骤2:利用多头互注意力机制分别学习声学与隐式文本及视觉与隐式文本之间的双峰交互信息,通过迭代更新跨模态权值,减少来自语音和视觉模态的低阶冗余特征,同时处理不同模态对最终情感分析结果的贡献不平衡问题;

6、步骤3:将双峰交互特征与隐式文本特征进行融合,其中引入交叉注意力机制分别学习源与目标之间的注意权重,用源模态信息来强化目标模态,以文本为主要信息,利用文本-语音和文本-视觉模态的交互特征作为权重向量来实现隐式文本特征的强化,以获得增强的隐式情感表示,其中源模态是指视觉和语音,目标模态是指隐式文本;

7、步骤4:得到的融合多模态的隐式情感特征通过全连接层和softmax函数输出情感分类结果。

8、根据本发明的基于视觉和语音增强的隐式情感分析方法的一实施例,步骤1中的隐式文本提取中,使用bert模型将文本中的每个词抽象为一个词向量表示,该词向量表示能够捕捉该词的上下文信息,并对文本进行填充和截断操作。

9、根据本发明的基于视觉和语音增强的隐式情感分析方法的一实施例,步骤1中的语音特征提取,进一步包括:

10、首先,使用librosa语音工具包提取帧级语音特征:对语音信号进行分帧处理,以便对每个音频帧进行特征提取;

11、然后,默认参数特征进行语音信号的采样:在提取特征时使用默认参数为设定的语音信号采样率;

12、再者,进行特征提取:提取包括1维过零率、20维mel频率倒谱系数和12维constant-q色谱(cqt)在内的帧级语音特征;

13、之后,进行文本和语音对齐:使用p2fa进行文本和语音的对齐,确保文本信息与相应的语音特征序列对齐;

14、最后,进行零向量填充:采用零向量对语音序列进行填充,确保语音特征的序列长度与文本特征的序列长度相匹配。

15、根据本发明的基于视觉和语音增强的隐式情感分析方法的一实施例,步骤1中的视觉特征提取,进一步包括:

16、首先,进行视频采样和人脸检测:视频以设定的采样率获得连续的视频帧,使用mtcnn人脸检测算法提取视频帧中的人脸区域和特征点;

17、然后,进行面部表情特征提取:通过openface2.0工具包提取面部表情特征,包括人脸标记点、面部动作单元、头部姿势和眼睛注视方向;

18、之后,进行视觉特征提取:在整个视频序列中提取帧级视觉特征,这些视觉特征包含从人脸检测和openface2.0获取的关键面部表情特征;

19、最后,进行视频帧数据处理:对于视频帧长度不足的视频帧序列,在末尾进行填充操作,使其达到固定的长度,对于视频帧长度过长的视频序列,选择截取其前面部分帧向量,以使所有视频帧的长度保持一致。

20、根据本发明的基于视觉和语音增强的隐式情感分析方法的一实施例,步骤1还包括上下文特征表示,对于语音和视觉模态特征,通过bilstm网络进行编码获取各模态上下文信息;对于文本模态,使用中文bert预训练模型得到句子的向量表示作为文本特征;使用1d时间卷积将提取的三个不同的单模态特征转换成相同的维度。

21、根据本发明的基于视觉和语音增强的隐式情感分析方法的一实施例,在步骤2中,通过多次线性变换从不同的子空间学习不同的特征,以隐式文本为中心自适应地为不同模态分配不同的权重,实现跨模态特征交互及融合,进一步包括:

22、首先将文本、视觉/语音特征向量通过线性层进行转换;

23、然后通过多头互注意力机制将每个时间步的文本特征与视觉/语音特征进行匹配,利用多头互注意力机制学习视觉/语音和隐式文本之间的相关性,从视觉/语音特征中提取有效信息来丰富隐式文本;

24、经过不同的线性变换投影,使模型关注来自不同子空间的特征信息;

25、最后,将不同的注意力结果拼接在一起,利用线性变换来获得视觉/语音和文本的交互特征的最终表示。

26、根据本发明的基于视觉和语音增强的隐式情感分析方法的一实施例,步骤3进一步包括:

27、以文本的目标句作为查询向量来查找文本-视觉交互特征/文本-语音交互特征中与之匹配的特征部分,获得包含交互特征的文本嵌入表示;

28、将文本嵌入表示作为查询向量与文本特征/语音特征进行深度融合计算权重,获得增强后的文本特征输出;

29、最后将得到的两个增强的文本特征输出进行拼接,并通过线性映射得到降维特征;

30、引入tanh激活函数和softmax得到文本-视觉交互信息/文本-语音交互信息与文本信息的融合特征,获得最终的注意力得分,从而达到文本语义特征的强化。

31、根据本发明的基于视觉和语音增强的隐式情感分析方法的一实施例,步骤4中使用交叉熵损失函数来计算预测标签与真实标签之间的损失,并借助均方误差函数来度量融合后的特征与真实标签之间的差异。

32、本发明对比现有技术有如下的有益效果:从原理上说,现有的仅融合语音或视觉的方法只是在融合过程中对模态进行了简单的映射,并没有考虑模态对隐式情感分析的贡献以及在融合过程中模态间存在的冗余信息问题。而语音模态信息和视觉模态信息既能互相关联又能互相补充,在减弱噪声干扰的同时最小化冗余信息,可以为隐式文本的情感判断提供更加准确可靠的信息。

33、本发明的方法和系统相对于上述的现有技术方案来说,具有如下特点:

34、(1)针对现有的隐式情感分析方法主要以分析文本内容为主,未能充分关注语音及视觉信息的情感信息,本发明设计了一种基于语音和视觉感知的隐式情感分析(audioand visual aware implicit sentiment analysis,avaisa)模型。该模型是一种整合了语音和视觉信息的情感分析模型,不仅考虑了文本中明显表达的情感内容,还利用语音和图像数据中暗示的情感线索,从而更全面地分析和理解情感。通过结合多种数据源,avaisa模型能够更准确地识别和推断人们的情感状态,有助于实现更精准的情感识别和情感分析应用。

35、(2)本发明提出了一种以隐式文本为中心的交叉注意融合策略,该策略以隐式文本为关键,有效利用了每种模态的特定情感信息,以增强隐式情感分析性能。

36、(3)在三个公共数据集上的大量实验表明,本发明的模型可以有效地利用多模态信息来提高模型性能,验证了本发明的模型优于其他基线模型。

本文地址:https://www.jishuxx.com/zhuanli/20240730/194270.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表