一种面向全景图像的人眼扫视轨迹预测方法

- 国知局

- 2024-07-31 22:53:24

本发明涉及遗传算法领域,主要涉及一种面向全景图像的人眼扫视轨迹预测方法。

背景技术:

1、近年来,虚拟现实(virtural reality,vr)和增强现实(augmented reality,ar)技术取得了重大进展,为用户提供了沉浸式体验。同时,理解和模仿人类探索虚拟环境360°图像的方式变得越来越重要,因为它可以帮助实现更实用和快速的渲染,从而提高沉浸式环境中的用户交互性。全景图像扫视轨迹预测是指在全景图像探索过程中,预测人类的视线移动轨迹。

2、全景图像和二维平面图象有着较大的区别。全景图像提供了一种沉浸式的交互环境,用户可以通过物理移动头部来改变他们的视角,从而导致更广泛的注视分布。全景图像包含了更丰富的视觉信息,用户需要更多的时间来处理和吸收。此外,全景图像的数据结构不同于二维图像,对数据处理和分析提出了新的要求。因此,现有的二维平面图像扫视轨迹预测方法不能直接应用于全景图像的扫视轨迹预测。

3、早期用于预测全景图像扫视轨迹的方法涉及基于显著性信息的注视点采样,以获得整个扫视轨迹。随后,随着生成对抗网络的发展,一些研究人员利用生成网络直接从全景图像中生成整个轨迹。这些方法获得了初步的结果,但它们忽略了对注视点之间时间依赖性的建模,而这早已被证明是人类视觉注意机制的一个非常重要的特征,因此它们往往导致预测结果不稳定。最近,一些研究工作已经认识到需要对观看行为中的时间依赖性进行综合处理,并通过循环神经网络或马尔可夫链对其进行建模。然而,这些方法将所有历史注视点信息集成到单个隐藏单元中,仅从该隐藏单元生成当前注视点。在这种情况下,注视点之间的时间依赖关系只能被间接建模,历史注视点的影响将大大削弱。

技术实现思路

1、发明目的:针对上述挑战,本研究的主要目的是提出了一种面向全景图像的人眼扫视轨迹预测方法,以解决上述问题。

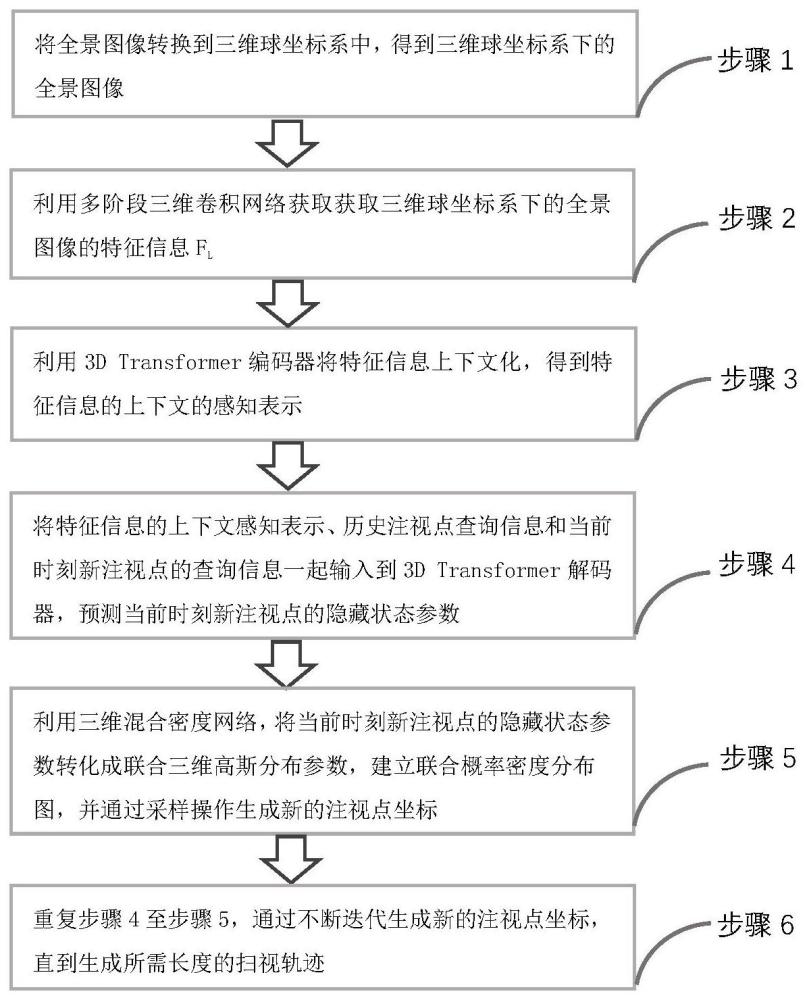

2、技术方案:本发明实例提供了一种面向全景图像的人眼扫视轨迹预测方法,所属方法包括如下步骤:

3、步骤s1、将全景图像转换到三维球坐标系中,得到三维球坐标系下的全景图像;

4、步骤s2、利用多阶段三维卷积网络获取获取三维球坐标系下的全景图像的特征信息fl;

5、步骤s3、利用3d transformer编码器将特征信息fl上下文化,得到特征信息fl的上下文的感知表示;

6、步骤s4、将特征信息fl的上下文的感知表示、历史注视点查询信息和当前时刻新注视点的查询信息一起输入到3d transformer解码器,预测当前时刻新注视点的隐藏状态参数;

7、步骤s5、利用三维混合密度网络,将当前时刻新注视点的隐藏状态参数转化成多个三维高斯分布参数,建立联合概率密度分布图,并通过采样操作生成新的注视点坐标;

8、步骤s6、重复步骤4至步骤5,通过不断迭代生成新的注视点坐标,直到生成所需长度的预测扫视轨迹。

9、优选的,步骤s1的实现过程为:

10、s101、将全景图像上所有二维坐标点p=[y,x](y,x∈[0,1])转化为二维坐标点的经纬度表示形式转化的公式为:

11、φ=(y-0.5)π;λ=(x-0.5)2π

12、其中y,x分别为二维坐标点在二维平面坐标表示方式下的y轴和x轴下的坐标值,φ,λ分别为二维坐标点在经纬度表示方式下的纬度和经度坐标值;

13、s102、将二维坐标点的经纬度表示形式转化为三维球坐标系中的三维空间坐标点p=(x,y,z)(x,y,z∈[-1,1]),转化的公式为:

14、x=cos(φ)cos(λ);y=cos(φ)sin(λ);z=sin(φ)。

15、其中x,y,z分别为在三维球坐标系中三维空间坐标点在x轴,y轴,z轴下的坐标值,从而得到三维球坐标系下的全景图像。

16、优选的,步骤s2的实现过程为:

17、s201、利用多阶段三维卷积网络spherenet提取三维球坐标系下的全景图像三个不同维度的二维平面特征图,并对三个不同维度的二维平面特征图进行上采样操作,得到特征图f1,f2,f3,表达式为:

18、f1,f2,f3=upsample(spherenet(i,θ))

19、其中,i代表三维球坐标系下的全景图像,θ代表多阶段三维卷积网络spherenet的参数;

20、s202、对特征图f1,f2,f3在通道维度上进行拼接,得到一个包含不同尺度信息的全局特征图f,表达式为:

21、f=concat(f1,f2,f3)

22、其中concat表示拼接操作;

23、s203、对全局特征图f进行包括平均池化、展平在内的操作,将全局特征图f变为一个长度为l的特征向量fl,表达式为:

24、fl=flatten(avgpool(f))

25、其中,flatten表示展平操作,avgpool表示平均池化。

26、优选的,在所述步骤3中,特征向量fl通过如下步骤通过3d transformer编码器:

27、s301、特征向量fl通过一个线性嵌入将维度转变为3d transformer编码器的内部维度;

28、s302、然后对特征向量fl添加一个可学习的位置编码;

29、s303、将特征向量fl依次通过3d transformer编码器中4个标准的transformer编码层,得到了特征信息fl的上下文的感知表示。

30、优选的,在所述步骤4中,3d transformer解码器采用自回归的方式迭代生成当前时刻新注视点的隐藏状态参数。

31、优选的,步骤s4的实现过程为:

32、s401、将当前时刻注视点坐标经过线性嵌入,得到当前时刻注视点坐标的查询向量;

33、s402、将当前时刻注视点坐标的查询向量和由历史注视点坐标得到的查询向量进行拼接,得到联合查询向量;

34、s403、给联合查询向量添加上注视点序列的一维绝对位置编码信息;

35、s404、将添加了一维绝对位置编码信息的联合查询向量通过3d transformer解码器4个标准的解码层,得到当前时刻新注视点的隐藏状态参数zt。

36、优选的,在所述步骤5中,通过三维混合密度网络的方式来计算当前时刻t新注视点pt第i个高斯分布图的权重系数协方差均值计算公式表述为:

37、

38、其中,fmdn代表三维混合密度网络,所述的三维混合密度网络包括多个独立的二层线性全连接网络,zt代表当前时刻t新注视点的状态,θmdn代表三维混合密度网络的参数,代表当前时刻t第i个高斯分布的均值,代表当前时刻t第i个高斯分布的协方差,代表当前时刻t第i个高斯分布的概率。

39、优选的,在所述步骤5中,当前时刻t新注视点pt的单个高斯分布函数的计算公式表达为:

40、

41、当前时刻t新注视点pt的联合高斯分布函数的计算公式表达为:

42、

43、其中,k代表组成联合概率密度分布图的三维高斯分布的个数,具体为联合概率密度分布图由多少个独立的三维高斯分布组成;

44、根据当前时刻t新注视点pt的联合高斯分布函数p(pt)绘制联合高斯概率分布概率图。

45、优选的,在所述步骤5中,从联合高斯概率分布概率图中通过采样操作生成新的注视点坐标的步骤中,存在如下关系式:

46、

47、其中,~代表采样操作,表示从联合高斯概率分布图中生成新的注视点坐标。

48、优选的,在模型的训练过程中所使用的损失函数为负对数损失,所述的模型包括依次串接的多阶段三维卷积网络、3d transformer编码器、3d transformer解码器和三维混合密度网络,满足公式:

49、

50、其中,代表时刻t的真实人类注视点,t代表扫视轨迹的长度。

51、有益效果:

52、本发明通过多阶段三维卷积网络来提取全景图像信息,考虑到了不同层级的图像特征,可以同时关注到大目标和小目标;

53、本发明通过transformer结构来解决序列生成这一问题,可以考虑到更加全局的图像信息和历史注视点信息;

54、本发明通过混合密度网络来建立注视点的概率分布图,可以更好的体现注视点预测时充满不确定性这一特性,能建立更加真实合理的注视点概率分布图。

55、本发明首次提出在三维球坐标系中进行人眼扫视轨迹预测并且通过自回归的方式来生成新的注视点,可以更好的模拟视觉工作记忆的机制,生成更加真实可靠的全景图像扫视轨迹;

本文地址:https://www.jishuxx.com/zhuanli/20240730/195198.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。