一种用于机器人控制的非线性状态表征学习方法及装置

- 国知局

- 2024-07-31 23:43:02

本发明涉及机器人控制,特别是指一种用于机器人控制的非线性状态表征学习方法及装置。

背景技术:

1、在智能机器人的强化学习、模仿学习等研究领域中,马尔可夫决策过程是一个常用的数学框架,用于对机器人所处的顺序随机环境以及机器人所面临的决策问题进行建模。在马尔可夫决策过程中,状态反映了机器人的智能决策系统对于环境和任务的认知,是机器人做出决策、决定下一步行动的必要依据,状态能否良好地反映环境特点、任务进度,将影响智能体决策的质量。

2、对于智能机器人而言,由传感器输入的原始数据是高维、未经筛选的,计算复杂度较高且不能良好地反映与决策任务相关的环境因素,不适合直接用作马尔可夫过程中的状态量,因此状态一般是根据具体任务特点,对传感器输入数据进行降维、提炼等分析处理操作而获得。

3、在传统方法中,原始数据的分析处理过程是由人工预先分析任务、环境以及传感器的特点,进而设计出某种从原始输入到状态量的映射来完成,这一设计工作称为“状态空间设计”。这种方法的效果依赖于负责设计状态量的工程师的个人工作经验,且工作量较大、难以迁移泛化到不同任务情境中,智能化程度较低。

4、相比于传统的人工设计方法,状态表征学习(state representation learning,srl)旨在让智能系统自主从原始、高维的传感器数据中学习有利于认识环境、完成任务的从原始输入到状态的映射,从而降低人工劳动负担、减少人工因素对智能系统决策效果的影响,提高决策算法的泛化迁移能力。状态表征学习的研究旨在解决与特征提取、降维、表征学习和可解释性相关的问题,因此它是跨越多个领域和学科的,包括机器学习、人工智能、机器人、强化学习、计算机视觉和自然语言处理等。目前,关于状态表征学习的研究主要集中在深度表征学习、无监督学习、迁移学习与领域适应、分层与组合表示、语义角色标注(semantic role labeling,srl)可解释性、srl评估基准与测试方法几大领域。在深度表征学习和无监督学习领域,研究人员使用深度神经网络来学习状态表征,包括用于图像表示的卷积神经网络(convolutional neural network,cnn)、用于序列数据的循环神经网络(recurrent neural network,rnn)和用于无监督表示学习的变分自编码器(variationalautoencoders,vaes)等技术。该领域的研究重点是开发架构、训练算法和正则化技术,以学习有效和鲁棒的表示;在迁移学习与领域适应方向,研究重点是开发能够将智能决策系统在一个环境中学习到的表征转移到其他类似环境的方法,从而实现更快的学习和更好的泛化;分层表示学习旨在捕获状态空间中的多层抽象和结构,通过学习不同尺度和层次的状态表征,以期实现更有效和灵活的决策。组合表示学习侧重于将复杂状态分解为有意义的子状态,从而更好地解释和理解环境中的潜在影响因素;srl可解释性方面的研究包括开发方法来理解srl算法所学习到的表征、可视化显著特征,并提供人类可以理解的决策过程的解释;评估基准与测试方法方面的研究包括开发评估指标和基准数据集、设计决策任务与环境以评估srl算法学习的状态表征的质量和有效性,进而评价srl算法的性能、泛化和迁移能力。

5、主成分分析(principal component analysis,pca)是一种广泛应用于降维和数据挖掘的统计技术。它通过识别数据变化最大的方向(称为主成分),将高维数据集转换至低维空间。在智能机器人强化训练领域,基于pca原理的srl算法是一种能够有效提取环境中与机器人任务相关的状态信息的方法,在结构化环境中性能表现良好。但由于pca方法假设待提取特征之间存在线性关系,如果数据表现出复杂的非线性关系,将使得pca无法较好地捕获环境中的关键信息,进而影响srl算法乃至后续的智能体强化训练的表现。不同于工厂流水线、生产车间、仓库、科研实验室等严格规范、各类物品与设备设施有序排布的结构化环境,在居家、办公区域、营业场所、户外等管理松散、物品与装置杂乱的非结构化环境中,智能机器人需要面对更加无序和混乱的环境因素,传感器的输入,和隐藏在环境中与任务相关的环境特性,都呈现出明显的非线性性质,pca难以捕捉此类环境中的非线性关系和复杂模式。

6、在现有技术中,缺乏一种基于主成分分析的有效克服机器人控制的非线性状态表征学习方法。

技术实现思路

1、为了解决现有技术存在的机器人非线性状态表征学习效果不佳的技术问题,本发明实施例提供了一种用于机器人控制的非线性状态表征学习方法及装置。所述技术方案如下:

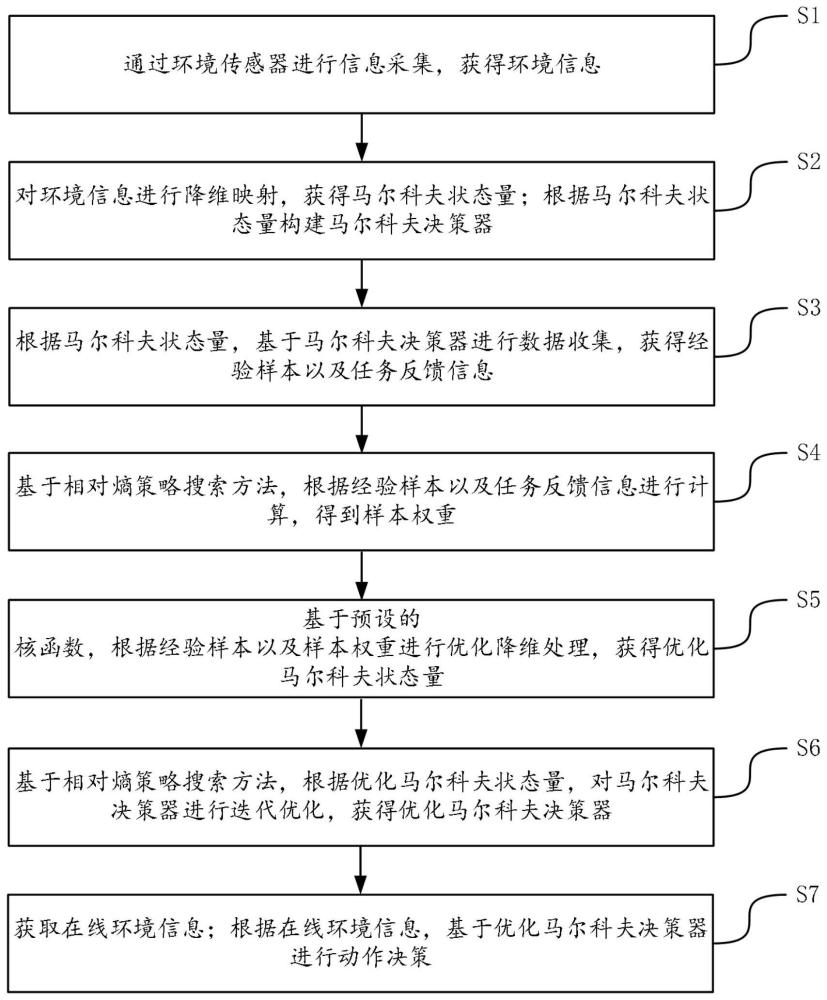

2、一方面,提供了一种用于机器人控制的非线性状态表征学习方法,该方法由非线性状态表征学习设备实现,该方法包括:

3、通过环境传感器进行信息采集,获得环境信息;

4、对所述环境信息进行降维映射,获得马尔科夫状态量;根据所述马尔科夫状态量构建马尔科夫决策器;

5、根据所述马尔科夫状态量,基于所述马尔科夫决策器进行数据收集,获得经验样本以及任务反馈信息;

6、基于相对熵策略搜索方法,根据所述经验样本以及任务反馈信息进行计算,得到样本权重;

7、基于预设的核函数,根据所述经验样本以及所述样本权重进行优化降维处理,获得优化马尔科夫状态量;

8、基于相对熵策略搜索方法,根据所述优化马尔科夫状态量,对所述马尔科夫决策器进行迭代优化,获得优化马尔科夫决策器;

9、获取在线环境信息;根据在线环境信息,基于所述优化马尔科夫决策器进行动作决策。

10、其中,所述环境信息为机器人处理的非线性状态表征信息。

11、可选地,所述根据所述马尔科夫状态量,基于所述马尔科夫决策器进行数据收集,获得经验样本以及任务反馈信息,包括:

12、根据所述马尔科夫状态量,通过所述马尔科夫决策器进行行动决策,获得机器人动作以及任务反馈信息;

13、对所述环境信息以及所述机器人动作进行配对,获得环境-动作数据对;将所述环境-动作数据对保存到数据对集;

14、所述数据对集中环境-动作数据对的数量达到预设阈值时,将所述数据对集确定为经验样本。

15、可选地,所述基于相对熵策略搜索方法,根据所述经验样本以及任务反馈信息进行计算,得到样本权重,包括:

16、基于相对熵策略搜索方法,根据所述经验样本建立相对熵策略搜索问题;

17、将所述相对熵策略搜索问题进行数学变换,获得拉格朗日算子形式搜索问题;

18、对所述拉格朗日算子形式搜索问题进行求解,得到拉格朗日算子;

19、根据所述任务反馈信息进行计算,得到贝尔曼误差;

20、根据所述贝尔曼误差以及所述拉尔朗日算子进行计算,得到样本权重。

21、可选地,所述基于预设的核函数,根据所述经验样本以及所述样本权重进行优化降维处理,获得优化马尔科夫状态量,包括:

22、基于预设的核函数,根据所述经验样本以及所述样本权重进行计算,得到加权核矩阵;

23、对所述加权核矩阵进行特征值分解,获得特征值以及特征向量;

24、基于预设的特征值阈值,对所述特征值进行筛选,获得主成分特征值;根据所述主成分特征值确定对应的主成分特征向量;

25、根据所述主成分特征向量,对所述核矩阵进行主成分方向上的降维处理,获得优化马尔科夫状态量。

26、可选地,所述基于预设的核函数,根据所述经验样本以及所述样本权重进行计算,得到加权核矩阵,包括:

27、基于预设的核函数,根据所述经验样本构建核矩阵;

28、对所述核矩阵进行中心化处理,获得处理后核矩阵;

29、根据所述处理后核矩阵以及所述样本权重进行计算,得到加权核矩阵。

30、另一方面,提供了一种用于机器人控制的非线性状态表征学习方法装置,该装置应用于用于机器人控制的非线性状态表征学习方法,该装置包括:

31、环境信息获取模块,用于通过环境传感器进行信息采集,获得环境信息;

32、决策器构建模块,用于对所述环境信息进行降维映射,获得马尔科夫状态量;根据所述马尔科夫状态量构建马尔科夫决策器;

33、信息收集模块,用于根据所述马尔科夫状态量,基于所述马尔科夫决策器进行数据收集,获得经验样本以及任务反馈信息;

34、样本权重计算模块,用于基于相对熵策略搜索方法,根据所述经验样本以及任务反馈信息进行计算,得到样本权重;

35、状态量优化模块,用于基于预设的核函数,根据所述经验样本以及所述样本权重进行优化降维处理,获得优化马尔科夫状态量;

36、决策器优化模块,用于基于相对熵策略搜索方法,根据所述优化马尔科夫状态量,对所述马尔科夫决策器进行迭代优化,获得优化马尔科夫决策器;

37、动作决策模块,用于获取在线环境信息;根据在线环境信息,基于所述优化马尔科夫决策器进行动作决策。

38、其中,所述环境信息为机器人处理的非线性状态表征信息。

39、可选地,所述信息收集模块,进一步用于:

40、根据所述马尔科夫状态量,通过所述马尔科夫决策器进行行动决策,获得机器人动作以及任务反馈信息;

41、对所述环境信息以及所述机器人动作进行配对,获得环境-动作数据对;将所述环境-动作数据对保存到数据对集;

42、所述数据对集中环境-动作数据对的数量达到预设阈值时,将所述数据对集确定为经验样本。

43、可选地,所述样本权重计算模块,进一步用于:

44、基于相对熵策略搜索方法,根据所述经验样本建立相对熵策略搜索问题;

45、将所述相对熵策略搜索问题进行数学变换,获得拉格朗日算子形式搜索问题;

46、对所述拉格朗日算子形式搜索问题进行求解,得到拉格朗日算子;

47、根据所述任务反馈信息进行计算,得到贝尔曼误差;

48、根据所述贝尔曼误差以及所述拉尔朗日算子进行计算,得到样本权重。

49、可选地,所述状态量优化模块,进一步用于:

50、基于预设的核函数,根据所述经验样本以及所述样本权重进行计算,得到加权核矩阵;

51、对所述加权核矩阵进行特征值分解,获得特征值以及特征向量;

52、基于预设的特征值阈值,对所述特征值进行筛选,获得主成分特征值;根据所述主成分特征值确定对应的主成分特征向量;

53、根据所述主成分特征向量,对所述核矩阵进行主成分方向上的降维处理,获得优化马尔科夫状态量。

54、可选地,所述状态量优化模块,进一步用于:

55、基于预设的核函数,根据所述经验样本构建核矩阵;

56、对所述核矩阵进行中心化处理,获得处理后核矩阵;

57、根据所述处理后核矩阵以及所述样本权重进行计算,得到加权核矩阵。

58、另一方面,提供一种非线性状态表征学习设备,所述非线性状态表征学习设备包括:处理器;存储器,所述存储器上存储有计算机可读指令,所述计算机可读指令被所述处理器执行时,实现如上述用于机器人控制的非线性状态表征学习方法中的任一项方法。

59、另一方面,提供了一种计算机可读存储介质,所述存储介质中存储有至少一条指令,所述至少一条指令由处理器加载并执行以实现上述用于机器人控制的非线性状态表征学习方法中的任一项方法。

60、本发明实施例提供的技术方案带来的有益效果至少包括:

61、本发明提出一种用于机器人控制的非线性状态表征学习方法,通过核主成分分析技术对传感器输入的原始数据进行降维处理,能够帮助处于非结构化环境(区别于工厂、流水线等线性结构化环境)中的家用、办公区域、户外机器人更好地理解环境特性,做出行动决策。根据任务反馈来逐步降低状态表征向量的维度及对数据点进行加权,获得最优状态表征。通过将提取的状态表征作为马尔可夫决策过程的状态输入,进行强化学习、模仿学习等。本发明更适合处理家用机器人、办公营业场所机器人、户外小型机器人等在非结构化环境下作业的机器人控制器,提升机器人决策系统的学习与决策效果。本发明是一种基于主成分分析的有效克服机器人控制的非线性状态表征学习方法。

本文地址:https://www.jishuxx.com/zhuanli/20240730/198240.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表