一种适用于矿区大曲率路径的强化学习横向控制方法

- 国知局

- 2024-08-01 00:06:33

本发明涉及基于强化学习的自动驾驶车辆控制领域,具体涉及一种适用于矿区大曲率路径的强化学习横向控制方法。

背景技术:

1、如何平稳、稳定、准确地沿着规划路线行驶,对于涉及到自动驾驶技术的情境中的车辆控制而言是一项至关重要的任务。自动驾驶车辆的行驶质量直接关系到乘客的舒适感和安全性。而对于无人矿卡这样在矿业生产中发挥关键作用的自动驾驶工具,这一挑战更为突出。矿卡作为矿业生产的重要工具,其路径跟踪控制技术直接关系到整个运输系统的效率和安全性。在复杂多变的矿区环境中,矿区路径通常会因地质构造、矿体位置等原因而呈现曲折多变的特点,可能涉及到大曲率、急转弯或连续的变化,对路径跟踪提出了更高的挑战。路径跟踪的稳定性和准确性对于提高运输效率、确保矿区安全性具有不可忽视的作用。

2、传统路径跟踪控制算法依赖于准确的系统模型和手工设计的控制策略,但矿区这样复杂的地形、变化多端的天气因素以及无明确边界、参考线的环境为传统路径跟踪算法带来了巨大的挑战,精确建模和特征设计变得异常困难,导致传统控制算法性能的下降。

3、然而,深度强化学习通过端到端学习、非线性建模和自主学习的特性,克服了传统算法在非结构化道路路径跟踪上的局限性。它能够直接从传感器数据中学习路径规划与控制策略,无需精确系统模型;具备强大的非线性建模能力,适应复杂的矿区车辆动力学;并通过与环境的交互,实现自主学习、适应新环境的能力,提高鲁棒性,有效地克服了传统控制算法在路径跟踪控制领域的困难。

4、此外,深度强化学习方法可以使车辆智能地适应矿区大曲率路径的地形特点,从而实现更加灵活、智能的路径规划。目前将强化学习路径跟踪算法应用在矿区大曲率路径进行测试的实验尚未发展。

5、申请号为cn202110517912.6的中国发明专利申请提供了一种基于强化学习和视线法的无人艇路径跟踪方法。该发明公开了一种基于强化学习和视线法的无人艇路径跟踪方法,采用强化学习的方法对可视距离进行合理的预测,让无人艇“学会”根据当前状态动态地调整可视距离,从而使得船舶在航行过程中获得更高精度、更快速的航迹跟踪。

6、申请号为cn202010554244.x的中国发明专利申请提供了一种基于强化学习的激光agv的路径跟踪控制方法。该发明提供了一种基于强化学习的激光agv路径跟踪控制方法,旨在找到一种合适的控制方法能够避免人工过多干预,并且能够自动地适应不同参数的激光agv实现精确的路径跟踪,从而克服现有控制算法针对大量的人工试验工作以及对具体的运动学模型难以精确建模的问题。

技术实现思路

1、鉴于上述问题,本发明提供了一种适用于矿区大曲率路径的强化学习横向控制方法,通过解决传统算法在矿区大曲率路径中执行跟踪任务时出现的横向偏差过大的问题,以提高路径跟踪性能。

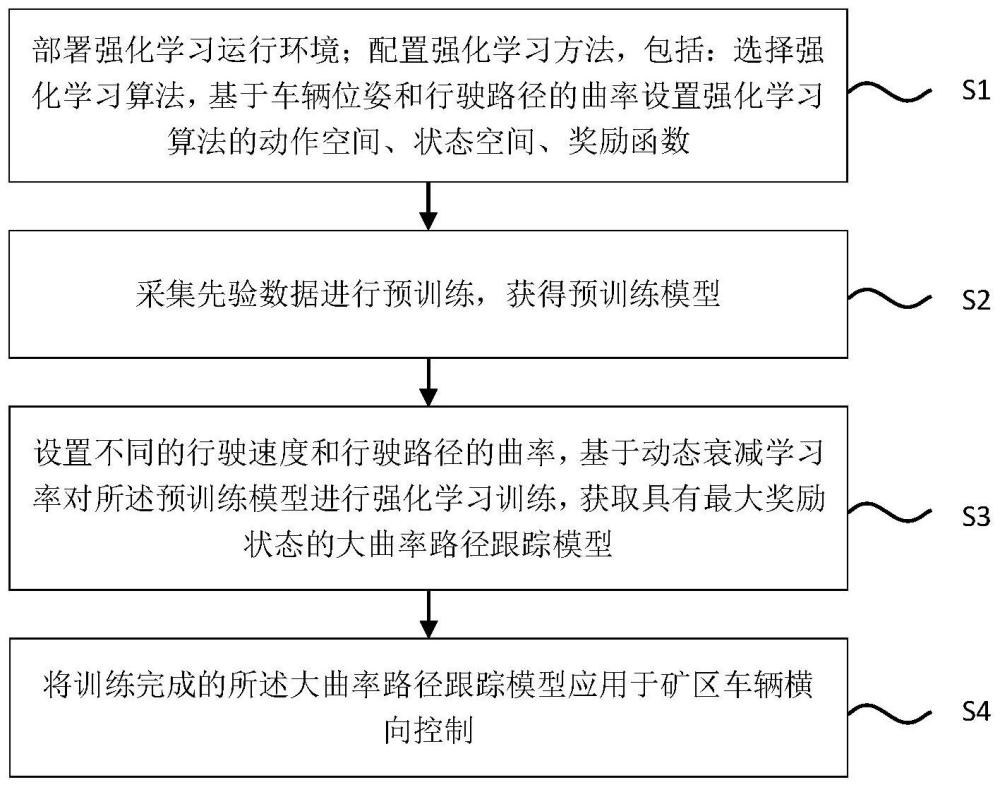

2、本发明提供了一种适用于矿区大曲率路径的强化学习横向控制方法,包括以下步骤:

3、步骤s1、部署强化学习运行环境;配置强化学习方法,包括:选择强化学习算法,基于车辆位姿和行驶路径的曲率设置强化学习算法的动作空间、状态空间、奖励函数;

4、步骤s2、采集先验数据进行预训练,获得预训练模型;

5、步骤s3、设置不同的行驶速度和行驶路径的曲率,基于动态衰减学习率对所述预训练模型进行强化学习训练,获取具有最大奖励状态的大曲率路径跟踪模型;

6、步骤s4、将训练完成的所述大曲率路径跟踪模型应用于矿区车辆横向控制。

7、优选地,步骤s2中所述选择强化学习算法,基于车辆位姿和行驶路径的曲率设置强化学习算法的动作空间、状态空间、奖励函数具体包括:

8、采用ppo算法作为所述强化学习算法,执行路径跟踪任务;

9、所述动作空间包括:车辆的转角;

10、所述状态空间包括:方位角偏差、横向偏差、横摆角、车辆速度、当前路径点曲率和预瞄点曲率;

11、所述奖励函数为:

12、cos(θ)-λsin(|θ|)-d/dmax

13、其中,θ为方位角偏差,d为横向偏差,dmax为最大横向偏差,λ为奖励函数的超参数。

14、优选地,ppo算法的神经网络参数按照如下方式更新:

15、

16、其中,lclip(α)是ppo算法的目标函数,α是当前策略的参数,是对时间步骤t的期望值的估计,rt(α)是策略比率;是优势函数的估计,clip(rt(α),1-∈,1+∈))是剪辑函数,用于将策略比率rt(α)限制在[1-∈,1+∈]的范围内,∈是ppo算法目标函数的超参数。

17、优选地,步骤s2中:所述采集先验数据进行预训练包括:将mpc采集的数据输入到强化学习的经验池中,进行预训练;

18、步骤s3中:所述设置不同的行驶速度和行驶路径的曲率包括:设置不同的行驶速度和曲率的学习课程;

19、所述动态衰减学习率包括:随时间逐步降低的学习率;

20、所述获取具有最大奖励状态的大曲率路径跟踪模型包括:基于训练过程中的当前回合和上一回合的奖励的大小进行训练。

21、优选地,所述将mpc采集的数据输入到强化学习的经验池中,进行预训练包括:

22、按照ppo算法的经验池格式采集路径数据,所述路径数据包括s_mpc、a_mpc、a_p_mpc、s_v_mpc、r_mpc、d_mpc,分别对应基于mpc算法采集的状态、动作、动作概率分布、状态值、奖励和当前回合是否完成标志,其中,基于使用mpc算法采集的状态s_mpc,根据所述奖励函数进行计算,获取奖励r_mpc;根据计算获取当前回合是否完成标志d_mpc;

23、将所述采集的路径数据输入强化学习的经验池中,进行预训练

24、优选地,所述设置不同的行驶速度和曲率的学习课程包括:

25、在强化学习训练过程中,设置多个课程,所述多个课程针对行驶速度和曲率进行难度设计,逐渐加大训练难度,所述逐渐加大训练难度包括:速度设置为10km/h、15km/h、20km/h,曲率设置为直道、弯道。

26、优选地,所述随时间逐步降低的学习率具体包括:

27、在强化学习训练过程中,先设置一个初始学习率,然后在训练过程中按照一定的步长降低学习率。

28、优选地,所述基于训练过程中的当前回合和上一回合的奖励进行训练包括:

29、在强化学习训练过程中,从第二个回合开始,记录上一个回合的奖励,每次训练回合过后,将与当前回合的奖励r_now与上一个回合r_last的奖励进行比对,若当前回合的奖励较大,则沿用当前回合的参数;若上一个回合的奖励较大,则将网络参数复原至上一个回合。

30、优选地,所述部署强化学习运行环境具体包括:

31、在windows操作系统中的prescan软件中搭建车辆动力学模型,在windows操作系统中的simulink中搭建与ubuntu/ros操作系统的udp通信机制以及传输车辆状态的消息模块,在ubuntu操作系统搭建强化学习算法。

32、优选地,还包括:步骤s5、获取用于仿真验证的矿区路径,对训练完成的所述大曲率路径跟踪模型进行仿真验证;

33、所述获取用于仿真验证的矿区路径包括:

34、(1)生成初始路径,包括:在矿区路径上将车辆平稳地从起点驾驶到终点,获取行驶gps数据,作为所述初始路径;

35、(2)采用数值优化的方式对初始路径进行曲率平滑;

36、(3)对所述矿区路径进行纵向速度规划,通过优化速度规划模型获取行驶路径上的纵向速度规划值,其中速度规划模型目标函数jto为:

37、jto=wuju+wcomjcom+wrefjref

38、

39、其中,ju为控制输入项,wu为控制输入项权重,s为行驶位置,s0为起始位置,sn为终点,a为纵向加速度;jcom为控制输入导数项,wcom为控制输入导数项权重,为车辆纵向加速度的导数;jref为期望偏差项,wref为期望偏差项权重,v为实际规划速度,vd为期望速度。

40、与现有技术相比,本发明至少具有如下有益效果:

41、(1)本发明考虑预瞄点曲率的多维信息状态输入设计,本发明参考了传统控制方式,将当前预瞄距离对应的路径曲率添加至输入状态,使得智能体了解的当前路况的同时,也对未来道路情况进行预知。

42、(2)本发明提供了迭代最优学习方法,在模拟过程中存储在训练过程中获得最高奖励的神经网络参数,经过短期模拟后,恢复到之前最大奖励的状态继续训练。这种方法使得每一系列训练都在一个相对较高的奖励点开始,避免了训练失败导致跟踪性能的恶化甚至崩溃,提高了获得更高分数的机会。

43、(3)本发明提供了课程学习方法与动态学习率方式进行加速训练,先在低速小曲率路径进行训练,然后逐渐加大难度训练,并且设置一个初始学习率,然后在训练过程中按照一定的步长降低学习率,通过该方式能够提高训练收敛速度。

44、(4)使用mpc算法采集路径数据,能够减弱初始阶段的训练难度,提高训练收敛速度。

本文地址:https://www.jishuxx.com/zhuanli/20240730/199711.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表