路径规划方法、两栖无人平台、存储介质和程序产品

- 国知局

- 2024-08-01 00:19:33

本发明涉及路径规划,尤其涉及路径规划方法、两栖无人平台、存储介质和程序产品。

背景技术:

1、两栖无人平台的路径规划可借鉴传统的无人机的路径规划。路径规划算法主要可分为经典算法和智能算法两个大类。经典算法针对其应用环节不同又可以分为全局路径规划和局部路径规划。

2、经典算法中,全局路径规划需要预先知道环境的准确信息,因此无法应对环境发生变化的情况,例如出现未知障碍物。尽管这是一种事前规划,对机器人系统的实时计算能力要求不高,但对环境模型的错误及噪声鲁棒性差。局部路径规划要求计算模块具有高效的信息处理和计算能力,同时要求整体算法对环境误差和噪声具有较高的鲁棒性。局部规划在单独解决路径规划问题时常常陷入局部最优,甚至无法找到合理路径导致规划失败。

3、智能算法存在诸如运算效率较低、运动规则难以确定、控制变量多、训练成本较高、收敛速度慢、需要搭建仿真环境等问题。其中,传统的强化学习算法同样存在弊端,容易导致内存溢出的现象发生,使得计算失败,由于其受限于状态空间的维度限制,因此并不能很好的解决复杂情况下的实时路径规划问题。

4、在此基础上,两栖无人平台的路径规划难度更大,在水上和水下的环境中,地形往往更加复杂,比如海浪、水流、岩石等因素都会对路径规划产生影响。因此两栖无人平台的路径规划仍需要克服更多的挑战和技术难题。

技术实现思路

1、本发明提供路径规划方法、两栖无人平台、存储介质和程序产品,用以解决现有技术中两栖无人平台的路径规划难度大、规划效率低的技术问题。

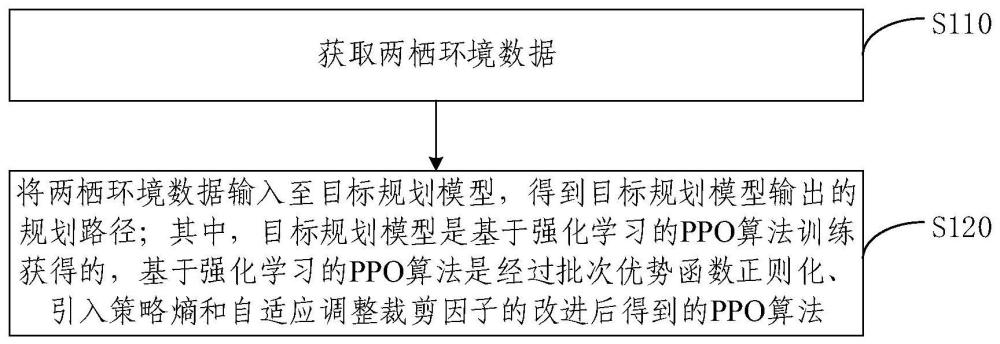

2、本发明提供一种基于两栖无人平台的路径规划方法,包括:获取两栖环境数据;将两栖环境数据输入至目标规划模型,得到目标规划模型输出的规划路径;其中,目标规划模型是基于强化学习的ppo算法训练获得的,基于强化学习的ppo算法是经过批次优势函数正则化、引入策略熵和自适应调整裁剪因子的改进后得到的ppo算法。

3、根据本发明提供的一种基于两栖无人平台的路径规划方法,将两栖环境数据输入至目标规划模型之前,还包括:确定两栖无人平台的状态空间和动作空间;确定基于强化学习的ppo算法的奖励函数;奖励函数包括静态奖励函数和速度强化奖励函数;根据状态空间、动作空间和奖励函数对基于强化学习的ppo算法进行训练,得到目标规划模型。

4、根据本发明提供的一种基于两栖无人平台的路径规划方法,将两栖环境数据输入至目标规划模型之前,还包括:

5、确定基于强化学习的ppo算法中的优势函数,优势函数是综合定量化评价动作价值函数,表达式为:aπ(s,a)=waqπ(s,a)-vπ(s);其中,aπ(s,a)是优势函数;qπ(s,a)是动作价值函数;vπ(s)是状态价值函数;wa是用于调整动作价值和状态价值的比重参数;将同一训练批次中所有优势值做z-score标准化,标准化公式如下:其中,为标准化后的优势值,x为标准化前的优势值;μ是批次数据优势值的均值,σ是批次数据优势值的标准差。

6、根据本发明提供的一种基于两栖无人平台的路径规划方法,将两栖环境数据输入至目标规划模型之前,还包括:在动作行为网络的损失函数中增加策略熵,以调整探索动作和保持原最优动作的比例;策略熵的表达式为:

7、

8、其中,表示t时刻采用策略π情况下选取动作a的期望;st表t时刻环境;at表示t时刻动作。

9、根据本发明提供的一种基于两栖无人平台的路径规划方法,将两栖环境数据输入至目标规划模型之前,还包括:采用了自适应的裁剪因子调整方法,使用裁剪函数限制策略函数的更新幅度,其中执行网络损失函数的表达式为:

10、

11、其中,si是从t=0到t=最终时刻,求和公式里的状态s;ai是从t=0到t=最终时刻,求和公式中的动作a;at是t时刻动作;st是t时刻环境;ps(at|st)是某一状态下选动作的概率;ps′(at|st)是某一状态下选动作的概率;是优势函数。

12、根据本发明提供的一种基于两栖无人平台的路径规划方法,静态奖励函数rt的表达式为:rt=rt(wp)+rt(o)+rt(g);速度强化奖励函数rt,2的表达式为:rt,2=rt(wp)+rt,2(o)+rt(g)+rt(vel);其中,rt(wp)和rt(g)分别是最近全局路径点参数和最终目标参数;rt(vel)是速度奖励函数;rt,2(o)是动态障碍物的奖励函数,rt(o)是静态障碍物的奖励函数。

13、本发明还提供一种基于两栖无人平台的路径规划装置,包括:数据获取模块,用于获取两栖环境数据;路径规划模块,用于将两栖环境数据输入至目标规划模型,得到目标规划模型输出的规划路径;其中,目标规划模型是基于强化学习的ppo算法训练获得的,基于强化学习的ppo算法是经过批次优势函数正则化、引入策略熵和自适应调整裁剪因子的改进后得到的ppo算法。

14、本发明还提供一种两栖无人平台,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,处理器执行程序时实现如上述任一种基于两栖无人平台的路径规划方法。

15、本发明还提供一种非暂态计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现如上述任一种基于两栖无人平台的路径规划方法。

16、本发明还提供一种计算机程序产品,包括计算机程序,计算机程序被处理器执行时实现如上述任一种基于两栖无人平台的路径规划方法。

17、本发明提供的路径规划方法、两栖无人平台、存储介质和程序产品,基于两栖无人平台的路径规划方法包括:获取两栖环境数据;将两栖环境数据输入至目标规划模型,得到目标规划模型输出的规划路径;其中,目标规划模型是基于强化学习的ppo算法训练获得的,基于强化学习的ppo算法是经过批次优势函数正则化、引入策略熵和自适应调整裁剪因子的改进后得到的ppo算法。通过上述方式,本发明采用了基于强化学习的ppo算法为两栖无人平台提供路径规划,并且在算法和策略上进行了批次优势函数正则化、引入策略熵和自适应调整裁剪因子的改进,提高了两栖环境下的避障能力,提高了安全性。

技术特征:1.一种基于两栖无人平台的路径规划方法,其特征在于,包括:

2.根据权利要求1所述的基于两栖无人平台的路径规划方法,其特征在于,所述将所述两栖环境数据输入至目标规划模型之前,还包括:

3.根据权利要求1所述的基于两栖无人平台的路径规划方法,其特征在于,所述将所述两栖环境数据输入至目标规划模型之前,还包括:

4.根据权利要求1所述的基于两栖无人平台的路径规划方法,其特征在于,所述将所述两栖环境数据输入至目标规划模型之前,还包括:

5.根据权利要求1所述的基于两栖无人平台的路径规划方法,其特征在于,所述将所述两栖环境数据输入至目标规划模型之前,还包括:

6.根据权利要求2所述的基于两栖无人平台的路径规划方法,其特征在于,

7.一种基于两栖无人平台的路径规划装置,其特征在于,包括:

8.一种两栖无人平台,包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的计算机程序,其特征在于,所述处理器执行所述计算机程序时实现如权利要求1至6任一项所述基于两栖无人平台的路径规划方法。

9.一种非暂态计算机可读存储介质,其上存储有计算机程序,其特征在于,所述计算机程序被处理器执行时实现如权利要求1至6任一项所述基于两栖无人平台的路径规划方法。

10.一种计算机程序产品,包括计算机程序,其特征在于,所述计算机程序被处理器执行时实现如权利要求1至6任一项所述基于两栖无人平台的路径规划方法。

技术总结本发明提供路径规划方法、两栖无人平台、存储介质和程序产品,涉及路径规划技术领域,基于两栖无人平台的路径规划方法包括:获取两栖环境数据;将两栖环境数据输入至目标规划模型,得到目标规划模型输出的规划路径;其中,目标规划模型是基于强化学习的PPO算法训练获得的,基于强化学习的PPO算法是经过批次优势函数正则化、引入策略熵和自适应调整裁剪因子的改进后得到的PPO算法。通过上述方式,本发明采用了基于强化学习的PPO算法为两栖无人平台提供路径规划,并且在算法和策略上进行了批次优势函数正则化、引入策略熵和自适应调整裁剪因子的改进,提高了两栖环境下的避障能力,提高了安全性。技术研发人员:鲁怡,徐梓洋,韩小磊,左哲,李忠新受保护的技术使用者:北京理工大学技术研发日:技术公布日:2024/7/18本文地址:https://www.jishuxx.com/zhuanli/20240730/200600.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。