一种基于误差叠加的形变误差补偿方法、装置和电子设备

- 国知局

- 2024-11-06 14:52:18

本发明涉及机器人领域,特别是涉及一种基于误差叠加的形变误差补偿方法、装置和电子设备。

背景技术:

1、随着制造成本的降低和精度的提高,机器人已经广泛应用于社会各个领域。机器人凭借其高灵活性,多功能性等优点,已在一些工业加工领域取代了数控机床。

2、在机器人携带了重物负载的情况下,机器人的结构会因为受力而产生形变。如果机器人运动控制算法还是将机器人结构视为刚体,而不提前考虑到该形变误差,那么机器人的运动轨迹势必会偏移预期的路线,其运行的精度和稳定性都会受到影响。形变误差在一些弱刚度、开链式串联结构的机器人中影响尤其巨大。因此,如何进行形变误差补偿,是机器人领域需要解决的问题。

3、现有的机器人形变误差补偿方法主要包括:1、通过优化机器人本身结构来减少形变误差;2、实时在线测量并补偿形变误差;3、通过数学模型离线预测并补偿形变误差。前两种解决方法均成本高昂且不易实施。第三种通过数学模型离线预测并补偿形变误差的方法,则能够通过参数预先设定完成的数学模型,提前预测机器人形变误差,并在机器人运动控制算法中考虑该形变误差并给予对应的反向补偿,从而提高机器人的运动精度和稳定性。其计算量相对于实时在线测量而言大大减小,性价比较高、可行性强。

4、现有技术中存在一种基于刚度模型的离线形变误差预测方法。刚度模型将连杆视为刚体,将机器人形变误差视为完全由关节的受力扭转导致。现有的基于刚度模型的离线形变误差预测方法,通过实验收集大量与外力对应的形变误差数据,将这些形变误差数据代入至刚度模型至计算出关节刚度系数;使用时,将外力向量代入至根据设定好关节刚度系数的刚度模型中,计算出预测形变误差。

5、这种现有的基于刚度模型的离线形变误差预测方法,忽略了连杆刚度的影响,仅仅适用于连杆刚度较强的机器人,因此存在预测精度较低、预测稳定性较差、不能广泛适用于大多数机器人的缺陷;并且需要收集大量样本数据计算关节刚度参数,训练成本较高。

技术实现思路

1、基于此,本发明的目的在于,提供一种基于误差叠加的形变误差补偿方法、装置和电子设备,其具有预测精度高、预测稳定性好、能广泛适用于大多数机器人、训练成本低的优点。

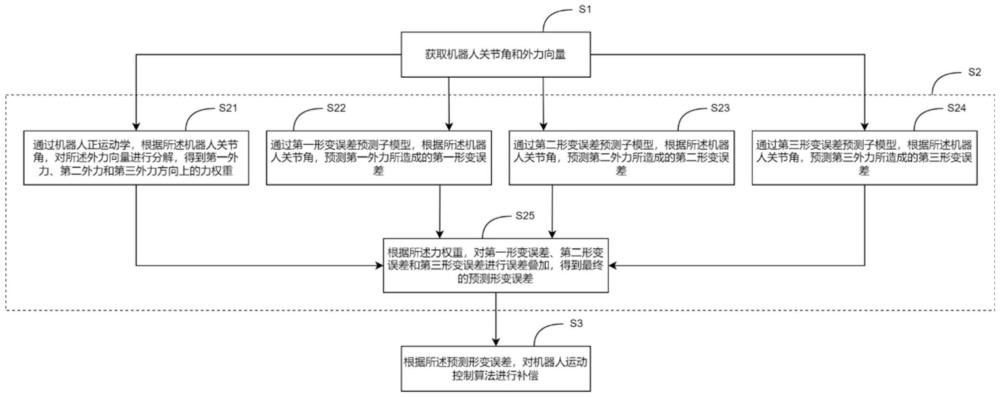

2、一种基于误差叠加的形变误差补偿方法,包括步骤:根据机器人关节角和外力向量进行形变误差预测,得到预测形变误差;根据所述预测形变误差,对机器人运动控制算法进行补偿;根据机器人关节角和外力向量进行形变误差预测,得到预测形变误差,具体包括:通过机器人正运动学,根据所述机器人关节角,对所述外力向量进行分解,得到第一外力、第二外力和第三外力方向上的力权重;通过第一形变误差预测子模型,根据所述机器人关节角,预测第一外力所造成的第一形变误差;通过第二形变误差预测子模型,根据所述机器人关节角,预测第二外力所造成的第二形变误差;通过第三形变误差预测子模型,根据所述机器人关节角,预测第三外力所造成的第三形变误差;根据所述力权重,对第一形变误差、第二形变误差和第三形变误差进行误差叠加,得到最终的预测形变误差;所述第一外力、第二外力和第三外力的方向取决于机器人关节角和训练所述第一形变误差预测子模型、第二形变误差预测子模型和第三形变误差预测子模型所采用的特殊受力情况;所述特殊受力情况为机器人所受外力被机器人关节角所确定的受力情况;所述第一外力、第二外力和第三外力线性无关。

3、本发明的形变误差预测融合模型的平均预测偏差为30μm,预测精度达93.7%,对比传统刚度模型其预测偏差减少63.8%。本发明的形变误差预测融合模型简单实用,并广泛适用于大部分工业机器人。形变误差预测融合模型的建立无需考虑机器人构型和连杆刚度,也不需要如传统刚度模型般进行复杂的演算。形变误差数据的收集过程简单,无需复杂昂贵的力测量设备。

4、进一步地,所述第一形变误差预测子模型的训练方法,包括:sta1,获取预设的第一特殊受力情况下的机器人关节角,并测量该机器人关节角对应的第一真实形变误差;所述第一特殊受力情况为:机器人受到被机器人关节角所确定的第一外力;sta2,将机器人关节角输入至待训练的第一形变误差预测子模型;所述第一形变误差预测子模型输出预测的第一形变误差;sta3,通过比较所述第一形变误差和所述第一真实形变误差的差异,更新当前机器人关节角所对应的所述第一形变误差预测子模型的参数;sta4,改变所述机器人关节角,保持第一特殊受力情况不变,重复步骤sta1-sta3,从而更新新的机器人关节角所对应的所述第一形变误差预测子模型的参数,直到遍历预设范围内的所有机器人关节角,获得训练完成的第一形变误差预测子模型。

5、进一步地,所述第二形变误差预测子模型的训练方法,包括:stb1,获取预设的第二特殊受力情况下的机器人关节角,并测量该机器人关节角对应的第二真实形变误差;所述第二特殊受力情况为:机器人受到被机器人关节角所确定的第二外力;stb2,将机器人关节角输入至待训练的第二形变误差预测子模型;所述第二形变误差预测子模型输出预测的第二形变误差;stb3,通过比较所述第二形变误差和所述第二真实形变误差的差异,更新当前机器人关节角所对应的所述第二形变误差预测子模型的参数;stb4,改变所述机器人关节角,保持第二特殊受力情况不变,重复步骤stb1-stb3,从而更新新的机器人关节角所对应的所述第二形变误差预测子模型的参数,直到遍历设定范围内的所有机器人关节角,获得训练完成的第二形变误差预测子模型。

6、进一步地,所述第三形变误差预测子模型的训练方法,包括:stc1,获取预设的第三特殊受力情况下的机器人关节角,并测量该机器人关节角对应的第三真实形变误差;所述第三特殊受力情况为:机器人受到被机器人关节角所确定的第三外力;stc2,将机器人关节角输入至待训练的第三形变误差预测子模型;所述第三形变误差预测子模型输出预测的第三形变误差;stc3,通过比较所述第三形变误差和所述第三真实形变误差的差异,更新当前机器人关节角所对应的所述第三形变误差预测子模型的参数;stc4,改变所述机器人关节角,保持第三特殊受力情况不变,重复步骤stc1-stc3,从而更新新的机器人关节角所对应的所述第三形变误差预测子模型的参数,直到遍历设定范围内的所有机器人关节角,获得训练完成的第三形变误差预测子模型。

7、进一步地,所述第一特殊受力情况、第二特殊受力情况和第三特殊受力情况,为机器人的受力点与机器人的末端点重合或相对静止,且外力大小恒定,且外力总指向一个固定点或固定方向中的任意一种受力情况。

8、进一步地,所述第一特殊受力情况,具体为:机器人的受力点与机器人的末端点重合,且第一外力大小恒定,且第一外力总指向预设的第一固定点;所述第二特殊受力情况,具体为:机器人的受力点与机器人的末端点重合,且第二外力大小恒定,且第二外力总指向预设的第二固定点;所述第三特殊受力情况,具体为:机器人的受力点与机器人的末端点重合,且第三外力大小恒定,且第三外力总指向预设的固定方向。

9、进一步地,所述第一真实形变误差、第二真实形变误差和第三真实形变误差的测量方法,均包括:测量机器人在没有外力负载的情况下的末端点的第一位置;测量机器人在特殊受力情况下的末端点的第二位置;根据所述第一位置和第二位置,计算真实形变误差;所述真实形变误差为以所述第一位置为起点、以所述第二位置为终点的向量。

10、基于同一发明构思,本发明还提供一种基于误差叠加的形变误差补偿装置,包括:数据采集模块,用于获取机器人关节角和外力向量;形变误差预测融合模型,用于根据机器人关节角和外力向量进行形变误差预测,得到预测形变误差;补偿模块,用于根据所述预测形变误差,对机器人运动控制算法进行补偿;其中,所述形变误差预测融合模型,包括:外力向量分解单元,用于通过机器人正运动学,根据所述机器人关节角,对所述外力向量进行分解,得到第一外力、第二外力和第三外力方向上的力权重;第一形变误差预测子模型,用于根据所述机器人关节角,预测第一外力所造成的第一形变误差;第二形变误差预测子模型,用于根据所述机器人关节角,预测第二外力所造成的第二形变误差;第三形变误差预测子模型,用于根据所述机器人关节角,预测第三外力所造成的第三形变误差;误差叠加单元,用于根据所述力权重,对第一形变误差、第二形变误差和第三形变误差进行误差叠加,得到最终的预测形变误差;所述第一外力、第二外力和第三外力的方向取决于机器人关节角和训练所述第一形变误差预测子模型、第二形变误差预测子模型和第三形变误差预测子模型所采用的特殊受力情况;所述特殊受力情况为机器人所受外力被机器人关节角所确定的受力情况;所述第一外力、第二外力和第三外力线性无关。

11、进一步地,所述第一形变误差预测子模型的训练方法,包括:sta1,获取预设的第一特殊受力情况下的机器人关节角,并测量该机器人关节角对应的第一真实形变误差;所述第一特殊受力情况为:机器人受到被机器人关节角所确定的第一外力;sta2,将机器人关节角输入至待训练的第一形变误差预测子模型;所述第一形变误差预测子模型输出预测的第一形变误差;sta3,通过比较所述第一形变误差和所述第一真实形变误差的差异,更新当前机器人关节角所对应的所述第一形变误差预测子模型的参数;sta4,改变所述机器人关节角,保持第一特殊受力情况不变,重复步骤sta1-sta3,从而更新新的机器人关节角所对应的所述第一形变误差预测子模型的参数,直到遍历预设范围内的所有机器人关节角,获得训练完成的第一形变误差预测子模型。

12、基于同一发明构思,本发明还提供一种电子设备,包括:处理器;存储器,用于存储由所述处理器执行的计算机程序;其中,所述处理器执行所述计算机程序时实现权利要求1-7所述的任一基于误差叠加的形变误差补偿方法。

13、为了更好地理解和实施,下面结合附图详细说明本发明。

本文地址:https://www.jishuxx.com/zhuanli/20241106/324530.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表