钛合金连接孔激光冲击强化工艺的优化方法

- 国知局

- 2024-11-21 12:05:45

本发明涉及一种钛合金激光冲击强化。

背景技术:

1、在直升机旋翼系统、自倾仪和桨叶等部分均存在钛合金连接孔。据统计,飞机的70%疲劳断裂源于连接孔表层。采用激光冲击强化技术处理的钛合金连接孔,能够显著提升连接孔的抗疲劳性能,具有残余应力分布深、表层质量高、抑制裂纹扩展等优点,是飞行器表层强化的重要途径。但是,激光冲击强化试验昂贵、周期长,同时由于高应变速率下复杂的材料、几何和工艺非线性问题,这使得如何准确描述并预测钛合金孔冲击强化效果较为困难。

2、专利公布号为“cn107217133b”的国家发明专利公开了一种“激光冲击强化的有限元模拟方法”。该方法采用有限元数值模拟,预测了2050-t8铝合金靶材的多光斑激光冲击强化的残余应力-应变场,并对2050-t8铝合金的多光斑激光冲击强化工艺进行了参数优化。但是,采用该方法在数值模拟过程中,无法预测激光冲击强化中的冲击角度、脉冲能量、覆盖率对钛合金连接孔激光冲击强化后残余应力的影响规律,亦无法对材料在激光冲击强化过程中高速变形时的应变硬化、应变进行预测,使得最终得到的优化后的工艺参数仍然不够准确,加工出的钛合金连接孔质量也不会很高。

技术实现思路

1、本发明的目的在于避免现有技术的不足,提供一种考虑材料高速变形对应变硬化、应变速率硬化效应的影响,建立了描述钛合金室温下真应力-应变动态变化映射关系的本构模型,结合钛合金连接孔三维有限元数值模拟系统,进而预测了冲击角度、脉冲能量、覆盖率对钛合金连接孔激光冲击强化后残余应力的影响,最终实现了激光冲击强化工艺参数优化的钛合金连接孔激光冲击强化工艺的优化方法。

2、为实现上述目的,本发明采取的技术方案为:一种钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,包括如下步骤:

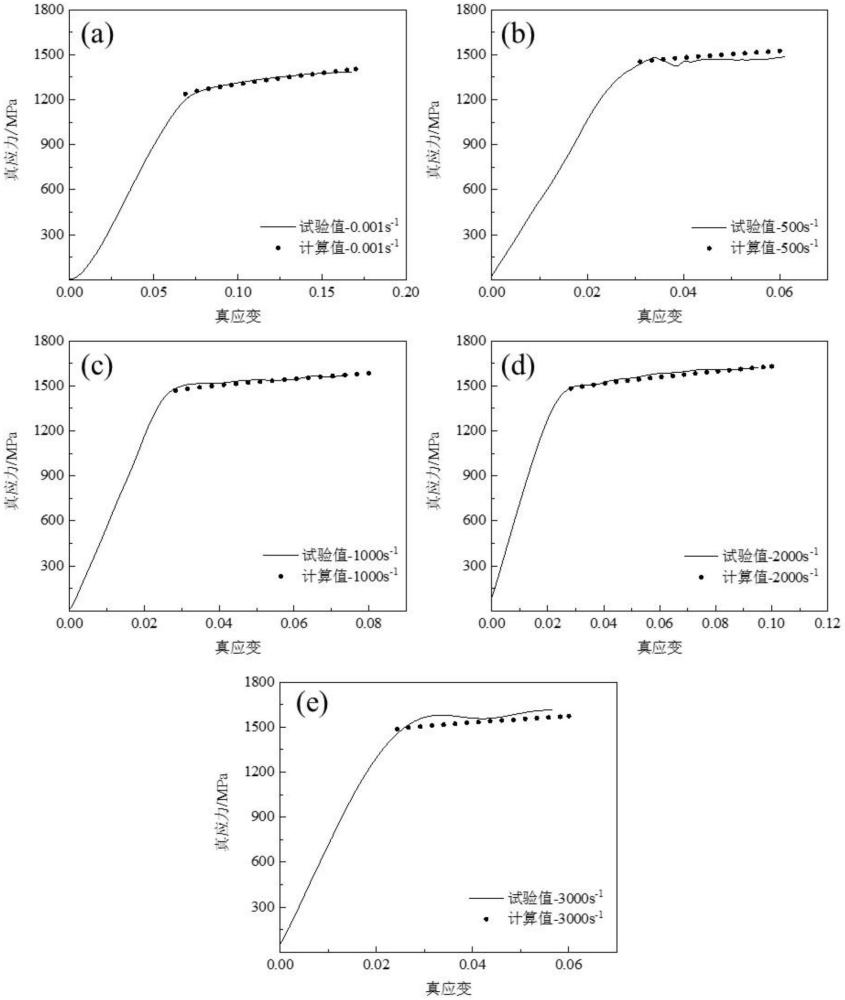

3、步骤一、通过钛合金室温准静态压缩和霍普金森冲击试验,获得不同应变速率对应的流动应力以及塑性应变及塑性应变速率的试验值,从而建立钛合金在冲击过程中受应变硬化、应变速率硬化效应影响的本构模型,以所述流动应力试验值与本构模型的流动应力计算值的误差平方和作为目标函数,得到钛合金的优化材料参数;

4、步骤二、通过钛合金连接孔的几何参数,建立连接孔三维几何模型,在连接孔三维几何模型的轴向切取连接孔内表面中的至少一条激光冲击强化路径宽度对应的扇形模型试样,对扇形模型试样中连接孔内表面激光强化影响厚度方向上进行网格划分,结合给定的不同激光冲击强化工艺参数,建立连接孔的激光冲击强化有限元模拟系统;

5、步骤三、将所述的钛合金的优化材料参数及钛合金属性参数耦合到激光冲击强化有限元模拟系统中,进行三维有限元数值模拟,从而实现动态预测钛合金孔激光冲击强化过程,得到不同激光冲击强化工艺参数下,钛合金连接孔的残余应力和等效塑性应变场的预测值;

6、步骤四:根据激光冲击强化有限元模拟系统,以激光冲击强化使得连接孔内表面厚度方向上的平均残余压应力值最高、最小残余压应力值最大、最大残余拉应力值最小为优化目标,得到钛合金连接孔优化后的激光冲击强化工艺参数。

7、进一步的,所述的本构模型为:

8、

9、式中,σ为流动应力,单位为mpa,a为材料的初始屈服应力,单位为mpa,b为材料的应变强化参数,单位为mpa,εp为材料的塑性应变,n为材料的应变硬化指数,c为材料的应变速率强化系数,为材料的塑性应变速率,单位为s-1,为材料的参考应变速率,设定值为0.001s-1。

10、进一步的,步骤一中所述准静态压缩试验的应变速率取0.001s-1作为本构模型中的参考应变速率,霍普金森冲击试验的应变速率分别为500s-1,1000s-1,1500s-1,2000s-1,2500s-1,3000s-1,并得到各个应变速率下的真应力-真应变曲线,曲线上的值即为所述流动应力试验值,其中,取应变速率为500s-1,1000s-1,2000s-1,3000s-1的真应力-真应变的流动应力试验值作为样本数据计算本构模型的材料参数。

11、进一步的,还包括使用应变速率为1500s-1,2500s-1的流动应力试验值作为非样本数据对所述的本构模型进行可靠性验证。

12、进一步的,步骤一中所述的目标函数为:

13、

14、式中,f(x)为流动应力的残差,和分别为在p时刻、应变速率为q时的流动应力的计算值和试验值,流动应力的计算值是通过本构模型计算得到,m为流动应力的组数,n为应变速率的组数。

15、进一步的,步骤二中所述连接孔的几何参数包括:孔内径为φ1,孔外径为φ2,孔深,内孔倒角,以及激光束与孔深度方向的夹角

16、在所述连接孔三维几何模型上,是将连接孔沿轴向切分为1/5~1/3扇形模型试样,然后在连接孔内表面激光强化影响厚度的方向上进行梯度变化尺寸的网格划分,网格尺寸为80-500μm;

17、所述的不同激光冲击强化工艺参数包括冲击角度、脉冲能量、覆盖率;

18、即是将所述不同激光冲击强化工艺参数作为有限元模拟的输入载荷,选择扇形模型试样的两个端面为对称约束,连接孔上端面不进行约束,下端面完全约束作为有限元模拟边界条件,从而建立的激光冲击强化有限元模拟系统。

19、进一步的,所述步骤二中设定的所述连接孔激光冲击强化三维几何模型中的参数为:孔内径至少为10mm,孔外径至少为30mm,孔深至少为10mm,任意内孔倒角;以及激光束与孔深度方向的夹角

20、进一步的,所述网格划分的网格类型为c3d8r的六面体网格。

21、进一步的,所述步骤三中:

22、所述的钛合金属性参数包括:杨氏模量为104~115gpa、泊松比为0.26~0.38、密度为4500~4840kg·m-3,tb6合金孔的质量阻尼系数为8.6×105;

23、即是将钛合金的优化材料参数和属性参数以材料属性的方式输入激光冲击强化有限元模拟系统中,得到三维有限元数值模拟云图,在云图中取平行于连接孔内表面的应力和应变场即为钛合金连接孔的残余应力和等效塑性应变场的预测值。

24、本发明的有益效果是:通过建立描述材料高速变形时的应变硬化、应变速率硬化效应影响的钛合金本构模型,反映了不同应变速率、尤其高应变速率、不同应变对钛合金常温下的流动应力的影响规律,可用于钛合金连接孔激光冲击强化后残余应力的准确预测,计算精度高,在此基础上,结合钛合金连接孔三维有限元数值模拟系统,并在此基础上,优化设计获得合理的激光冲击强化工艺参数,为进一步发展激光冲击强化残余应力精准调控技术奠定了理论基础,且有望发展成为激光冲击强化残余应力的精准调控技术。

技术特征:1.一种钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,包括如下步骤:

2.如权利要求1所述的钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,所述的本构模型为:

3.如权利要求1所述的钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,步骤一中所述准静态压缩试验的应变速率取0.001s-1作为本构模型中的参考应变速率,霍普金森冲击试验的应变速率分别为500s-1,1000s-1,1500s-1,2000s-1,2500s-1,3000s-1,并得到各个应变速率下的真应力-真应变曲线,曲线上的值即为所述流动应力试验值,其中,取应变速率为500s-1,1000s-1,2000s-1,3000s-1的真应力-真应变的流动应力试验值作为样本数据计算本构模型的材料参数。

4.如权利要求1所述的钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,还包括使用应变速率为1500s-1,2500s-1的流动应力试验值作为非样本数据对所述的本构模型进行可靠性验证。

5.如权利要求1所述的钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,步骤一中所述的目标函数为:

6.如权利要求1所述的钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,步骤二中所述连接孔的几何参数包括:孔内径为φ1,孔外径为φ2,孔深,内孔倒角,以及激光束与孔深度方向的夹角

7.如权利要求6所述的钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,所述步骤二中设定的所述连接孔激光冲击强化三维几何模型中的参数为:孔内径至少为10mm,孔外径至少为30mm,孔深至少为10mm,任意内孔倒角;以及激光束与孔深度方向的夹角

8.如权利要求6所述的钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,所述网格划分的网格类型为c3d8r的六面体网格。

9.如权利要求1-8任一项所述的钛合金连接孔激光冲击强化工艺的优化方法,其特征在于,所述步骤三中:

技术总结本发明涉及一种钛合金连接孔激光冲击强化工艺的优化方法,包括通过钛合金室温准静态压缩和霍普金森冲击试验,以所述流动应力试验值与钛合金在冲击过程中受应变硬化、应变速率硬化效应影响的本构模型的流动应力计算值的误差平方和作为目标函数,得到钛合金的优化材料参数,然后,建立连接孔三维几何模型并结合给定的不同激光冲击强化工艺参数,建立连接孔的激光冲击强化有限元模拟系统,得到钛合金连接孔优化后的激光冲击强化工艺参数。本发明使用连接孔三维几何模型结合钛合金连接孔三维有限元数值模拟系统,对钛合金连接孔激光冲击强化后残余应力的准确预测及工艺优选。技术研发人员:罗皎,罗晨阳,马哲受保护的技术使用者:西北工业大学技术研发日:技术公布日:2024/11/18本文地址:https://www.jishuxx.com/zhuanli/20241120/334267.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表