基于强化学习的游戏引擎优化方法及装置与流程

- 国知局

- 2024-07-11 16:04:33

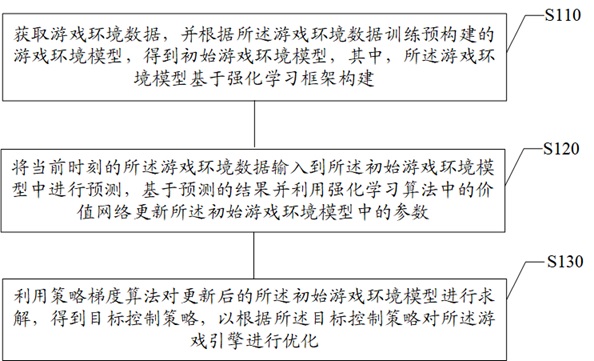

所属的技术人员能够理解,本发明的各个方面可以实现为装置、方法或程序产品。因此,本发明的各个方面可以具体实现为以下形式,即:完全的硬件实施例、完全的软件实施例(包括固件、微代码等),或硬件和软件方面结合的实施例,这里可以统称为“电路”、“模块”或“系统”。下面参照图5来描述根据本发明的这种实施例的电子设备500。图5所示的电子设备500仅仅是一个示例,不应对本发明实施例的功能和使用范围带来任何限制。如图5所示,电子设备500以通用计算设备的形式表现。电子设备500的组件可以包括但不限于:上述至少一个处理单元510、上述至少一个存储单元520、连接不同系统组件(包括存储单元520和处理单元510)的总线530、显示单元540。其中,存储单元存储有程序代码,程序代码可以被处理单元510执行,使得处理单元510执行本发明上述“示例性方法”部分中描述的根据本发明各种示例性实施例的步骤。例如,处理单元510可以执行如图1中所示的步骤s110,获取游戏环境数据,并根据游戏环境数据训练预构建的游戏环境模型,得到初始游戏环境模型,其中,游戏环境模型基于强化学习框架构建;步骤s120,将当前时刻的游戏环境数据输入到初始游戏环境模型中进行预测,基于预测的结果并利用强化学习算法中的价值网络更新初始游戏环境模型中的参数;步骤s130,利用策略梯度算法对更新后的初始游戏环境模型进行求解,得到目标控制策略,以根据目标控制策略对游戏引擎进行优化。存储单元520可以包括易失性存储单元形式的可读介质,例如随机存取存储单元(ram)521和/或高速缓存存储单元522,还可以进一步包括只读存储单元(rom)523。存储单元520还可以包括具有一组(至少一个)程序模块525的程序/实用工具524,这样的程序模块525包括但不限于:操作系统、一个或者多个应用程序、其它程序模块以及程序数据,这些示例中的每一个或某种组合中可能包括网络环境的实现。总线530可以为表示几类总线结构中的一种或多种,包括存储单元总线或者存储单元控制器、外围总线、图形加速端口、处理单元或者使用多种总线结构中的任意总线结构的局域总线。电子设备500也可以与一个或多个外部设备570(例如键盘、指向设备、蓝牙设备等)通信,还可与一个或者多个使得用户能与该电子设备500交互的设备通信,和/或与使得该电子设备500能与一个或多个其它计算设备进行通信的任何设备(例如路由器、调制解调器等等)通信。这种通信可以通过输入/输出(i/o)接口550进行。并且,电子设备500还可以通过网络适配器560与一个或者多个网络(例如局域网(lan),广域网(wan)和/或公共网络,例如因特网)通信。如图所示,网络适配器560通过总线530与电子设备500的其它模块通信。应当明白,尽管图中未示出,可以结合电子设备500使用其它硬件和/或软件模块,包括但不限于:微代码、设备驱动器、冗余处理单元、外部磁盘驱动阵列、raid系统、磁带驱动器以及数据备份存储系统等。通过以上的实施例的描述,本领域的技术人员易于理解,这里描述的示例实施例可以通过软件实现,也可以通过软件结合必要的硬件的方式来实现。因此,根据本发明实施例的技术方案可以以软件产品的形式体现出来,该软件产品可以存储在一个非易失性存储介质(可以是cd-rom,u盘,移动硬盘等)中或网络上,包括若干指令以使得一台计算设备(可以是个人计算机、服务器、终端装置、或者网络设备等)执行根据本发明实施例的方法。在本发明的示例性实施例中,还提供了一种计算机可读存储介质,其上存储有能够实现本发明上述方法的程序产品。在一些可能的实施例中,本发明的各个方面还可以实现为一种程序产品的形式,其包括程序代码,当程序产品在终端设备上运行时,程序代码用于使终端设备执行本发明上述“示例性方法”部分中描述的根据本发明各种示例性实施例的步骤。参考图6所示,描述了根据本发明的实施例的用于实现基于强化学习的游戏引擎优化方法的程序产品600,其可以采用便携式紧凑盘只读存储器(cd-rom)并包括程序代码,并可以在终端设备,例如个人电脑上运行。然而,本发明的程序产品不限于此,在本文件中,可读存储介质可以是任何包含或存储程序的有形介质,该程序可以被指令执行系统、装置或者器件使用或者与其结合使用。程序产品可以采用一个或多个可读介质的任意组合。可读介质可以是可读信号介质或者可读存储介质。可读存储介质例如可以为但不限于电、磁、光、电磁、红外线、或半导体的系统、装置或器件,或者任意以上的组合。可读存储介质的更具体的例子(非穷举的列表)包括:具有一个或多个导线的电连接、便携式盘、硬盘、随机存取存储器(ram)、只读存储器(rom)、可擦式可编程只读存储器(eprom或闪存)、光纤、便携式紧凑盘只读存储器(cd-rom)、光存储器件、磁存储器件、或者上述的任意合适的组合。计算机可读信号介质可以包括在基带中或者作为载波一部分传播的数据信号,其中承载了可读程序代码。这种传播的数据信号可以采用多种形式,包括但不限于电磁信号、光信号或上述的任意合适的组合。可读信号介质还可以是可读存储介质以外的任何可读介质,该可读介质可以发送、传播或者传输用于由指令执行系统、装置或者器件使用或者与其结合使用的程序。可读介质上包含的程序代码可以用任何适当的介质传输,包括但不限于无线、有线、光缆、rf等等,或者上述的任意合适的组合。可以以一种或多种程序设计语言的任意组合来编写用于执行本发明操作的程序代码,程序设计语言包括面向对象的程序设计语言—诸如java、c++等,还包括常规的过程式程序设计语言—诸如“c”语言或类似的程序设计语言。程序代码可以完全地在用户计算设备上执行、部分地在用户设备上执行、作为一个独立的软件包执行、部分在用户计算设备上部分在远程计算设备上执行、或者完全在远程计算设备或服务器上执行。在涉及远程计算设备的情形中,远程计算设备可以通过任意种类的网络,包括局域网(lan)或广域网(wan),连接到用户计算设备,或者,可以连接到外部计算设备(例如利用因特网服务提供商来通过因特网连接)。此外,上述附图仅是根据本发明示例性实施例的方法所包括的处理的示意性说明,而不是限制目的。易于理解,上述附图所示的处理并不表明或限制这些处理的时间顺序。另外,也易于理解,这些处理可以是例如在多个模块中同步或异步执行的。通过以上的实施例的描述,本领域的技术人员易于理解,这里描述的示例实施例可以通过软件实现,也可以通过软件结合必要的硬件的方式来实现。因此,根据本发明实施例的技术方案可以以软件产品的形式体现出来,该软件产品可以存储在一个非易失性存储介质(可以是cd-rom,u盘,移动硬盘等)中或网络上,包括若干指令以使得一台计算设备(可以是个人计算机、服务器、触控终端、或者网络设备等)执行根据本发明实施例的方法。本领域技术人员在考虑说明书及实践这里发明的发明后,将容易想到本发明的其它实施例。本技术旨在涵盖本发明的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本发明的一般性原理并包括本发明未发明的本中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本发明的真正范围和精神由权利要求指出。应当理解的是,本发明并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本发明的范围仅由所附的权利要求来限制。

背景技术:

1、本部分旨在为权利要求书中陈述的本发明的实施方式提供背景或上下文。此处的描述不因为包括在本部分中就承认是现有技术。

2、游戏引擎是复杂的软件系统,其性能优化需要经验丰富的开发人员进行手动调整和优化,游戏引擎中存在许多参数需要优化,这些参数相互之间存在复杂的关联和依赖关系,游戏引擎在不同的硬件设备、操作系统和配置环境下运行,游戏引擎需要在实时场景中做出决策,如物理模拟、碰撞检测等,为了使游戏引擎能够更好的适应不同的环境和需求,从而提供更好的性能和用户体验,需要对游戏引擎进行优化,以此实现游戏引擎的自动优化,复杂性处理、自适应性及实时决策的能力。

3、目前,相关的利用强化学习对游戏引擎进行优化的方法中,通过对获取到的数据进行特征提取,并通过数学表示的方法对模型进行训练,训练数据较少使得模型的学习能力较低,从而不能准确的反应游戏环境和用户行为。

技术实现思路

1、为克服相关技术中存在的问题,本发明提供一种基于强化学习的游戏引擎优化方法及装置,进而至少在一定程度上解决相关技术中模型学习能力较低的问题。

2、根据本发明实施例的第一方面,提供了一种基于强化学习的游戏引擎优化方法,包括:

3、获取游戏环境数据,并根据所述游戏环境数据训练预构建的游戏环境模型,得到初始游戏环境模型,其中,所述游戏环境模型基于强化学习框架构建;

4、将当前时刻的所述游戏环境数据输入到所述初始游戏环境模型中进行预测,基于预测的结果并利用强化学习算法中的价值网络更新所述初始游戏环境模型中的参数;

5、利用策略梯度算法对更新后的所述初始游戏环境模型进行求解,得到目标控制策略,以根据所述目标控制策略对所述游戏引擎进行优化。

6、根据本发明实施例的第二方面,提供了一种基于强化学习的游戏引擎优化装置,包括:

7、数据获取模块,用于获取游戏环境数 据,并根据所述游戏环境数据训练预构建的游戏环境模型,得到初始游戏环境模型,其中,所述游戏环境模型基于强化学习框架构建;

8、模型参数更新模块,用于将当前时刻的所述游戏环境数据输入到所述初始游戏环境模型中进行预测,基于预测的结果并利用强化学习算法中的价值网络更新所述初始游戏环境模型中的参数;

9、目标控制策略确定模块,用于利用策略梯度算法对更新后的所述初始游戏环境模型进行求解,得到目标控制策略,以根据所述目标控制策略对所述游戏引擎进行优化。

10、本发明利用预训练的游戏环境模型对游戏环境数据进行预测,并基于预测的结果利用强化学习算法中的价值网络更新游戏环境模型中的参数,然后通过策略梯度算法对更新后的游戏环境模型进行求解,得到目标控制策略,以根据目标控制策略对游戏引擎进行优化。一方面,通过游戏环境模型的预测结果更新模型中的参数,可以通过预测的方式来替代真实环境的交互,减少对真实游戏环境的依赖性;另一方面,通过价值网络及策略梯度算法对游戏环境模型的参数进行迭代更新确定控制策略,可以使得模型具备更强的学习能力和灵活性,从而能够实时的反馈信息进行实时的调整和优化。

11、应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本发明。

本文地址:https://www.jishuxx.com/zhuanli/20240615/77312.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表