复杂场景下的基于自适应多模型融合的声纹识别算法的制作方法

- 国知局

- 2024-06-21 10:41:08

本发明涉及音频识别领域,尤其涉及复杂场景下的基于自适应多模型融合的声纹识别算法。

背景技术:

1、现今声纹识别技术发展迅速,出现了包括resnet模型、tdnn模型等基于深度学习的模型。

2、resnet通过引入残差模块来解决深度神经网络中的梯度消失、梯度爆炸以及网络退化等问题,使得网络可以更深,从而提高了模型的准确率。与传统的卷积神经网络不同,resnet采用了跨层连接(shortcutconnection),即将前面层的输出直接与后面层的输入相加,从而保留了原始信息,有利于信息的传递和梯度的反向传播。

3、ecapa_tdnn模型是一种基于时间深度神经网络(tdnn)的声纹识别模型。它采用了res2net结构,可以通过在内部构造层次化的类残差连接来处理多尺度特征,在挺高模型性能的同时显著减少了模型参数。并且ecapa_tdnn通过引入se(squeeze-excitation)模块以及通道注意机制有效建模全局通道的相关性。

4、但在复杂场景下,例如开放场景下(即测试音频可能并未在系统中注册)、噪声叠加的场景下等,声纹识别技术的准确率较低。

5、为此,本发明提出复杂场景下的基于自适应多模型融合的声纹识别算法

技术实现思路

1、本发明的目的是为了解决现有技术中存在的缺点,而提出的复杂场景下的基于自适应多模型融合的声纹识别算法。

2、为了实现上述目的,本发明采用了如下技术方案:

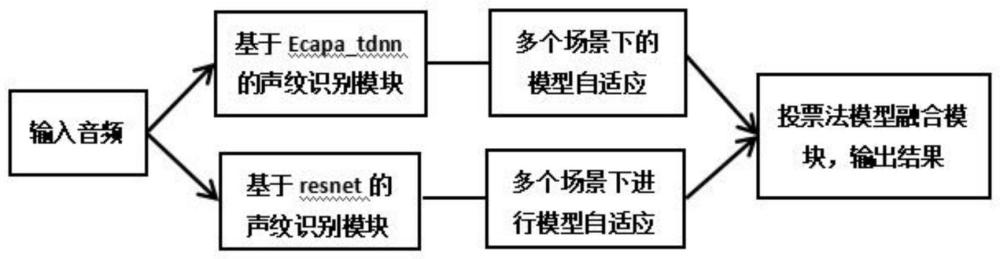

3、复杂场景下的基于自适应多模型融合的声纹识别算法,其通过resnet声纹识别模块、ecapa_tdnn声纹识别模块、多场景下的模型自适应模块和投票法模型融合模块实现,包括以下步骤:

4、s1:将采集的音频信息提取梅尔频谱,并输入resnet声纹识别模块和ecapa_tdnn声纹识别模块中;

5、s2:resnet声纹识别模块和ecapa_tdnn声纹识别模块提取说话人表征;

6、s3:多场景下的模型自适应模块分别对resnet声纹识别模块和ecapa_tdnn声纹识别模块提取的特征自适应并分别输出结果;

7、s4:若输出的两个结果一直,则直接输出识别结果,若结果不一致,则判定音频为未注册音频。

8、优选地:所述s2步骤中,resnet声纹识别模块和ecapa_tdnn声纹识别模块提取表征的方法包括以下步骤:

9、s21:数据预处理:将声音信号分帧,提取每个帧的梅尔频率倒谱系数(mfcc),并进行归一化处理;

10、s22:特征提取:提取mfcc特征的高层表示;

11、s23:降维:将高维特征降低到更低的维度;

12、s24:对齐:对不同说话人的特征进行对齐;

13、s25:建模:对每个说话人的特征进行建模,生成对应的声学模型;

14、s26:识别:在识别阶段,使用已建好的声学模型对新的说话人进行识别,计算其与每个模型的相似度得分,从而确定其身份。

15、优选地:所述s22步骤中,使用模型为resnet模型和ecapa_tdnn模型分别提取。

16、优选地:所述s23步骤中,降维算法采用主成分分析算法或者线性判别分析算法。

17、优选地:所述s24步骤中,对齐算法采用动态时间规整算法或者基于最大似然线性回归算法。

18、优选地:所述s25步骤中,建模算法采用高斯混合模型或者深度神经网络或者支持向量机。

19、优选地:所述s3步骤中,多场景下的模型自适应模块利用不同场景的数据集,采用增量学习的方法进行模型自适应,获取不同场景下的声纹模型。

20、优选地:所述s3步骤中,对于每个场景的评分结果对每个模型分配不同的权重。

21、本发明的有益效果为:

22、1.本发明分别对两个模型在多个场景下进行自适应,采用投票法对两个声纹模型自适应后的结果进行融合,对于两个模型出现不同结果的音频认为是集外音频,两个模型相同结果的音频则结合阈值进行判断。投票法不仅可以有效提高模型对于未注册音频和集外数据的识别准确率,同时,投票法还可以降低模型的方差,减少过拟合的风险。

技术特征:1.复杂场景下的基于自适应多模型融合的声纹识别算法,其通过resnet声纹识别模块、ecapa_tdnn声纹识别模块、多场景下的模型自适应模块和投票法模型融合模块实现,其特征在于,包括以下步骤:

2.根据权利要求1所述的复杂场景下的基于自适应多模型融合的声纹识别算法,其特征在于,所述s2步骤中,resnet声纹识别模块和ecapa_tdnn声纹识别模块提取表征的方法包括以下步骤:

3.根据权利要求2所述的复杂场景下的基于自适应多模型融合的声纹识别算法,其特征在于,所述s22步骤中,使用模型为resnet模型和ecapa_tdnn模型分别提取。

4.根据权利要求2所述的复杂场景下的基于自适应多模型融合的声纹识别算法,其特征在于,所述s23步骤中,降维算法采用主成分分析算法或者线性判别分析算法。

5.根据权利要求2所述的复杂场景下的基于自适应多模型融合的声纹识别算法,其特征在于,所述s24步骤中,对齐算法采用动态时间规整算法或者基于最大似然线性回归算法。

6.根据权利要求2所述的复杂场景下的基于自适应多模型融合的声纹识别算法,其特征在于,所述s25步骤中,建模算法采用高斯混合模型或者深度神经网络或者支持向量机。

7.根据权利要求1所述的复杂场景下的基于自适应多模型融合的声纹识别算法,其特征在于,所述s3步骤中,多场景下的模型自适应模块利用不同场景的数据集,采用增量学习的方法进行模型自适应,获取不同场景下的声纹模型。

8.根据权利要求1所述的复杂场景下的基于自适应多模型融合的声纹识别算法,其特征在于,所述s3步骤中,对于每个场景的评分结果对每个模型分配不同的权重。

技术总结本发明公开了复杂场景下的基于自适应多模型融合的声纹识别算法,涉及音频识别领域;包括以下步骤:将采集的音频信息提取梅尔频谱,并输入resnet声纹识别模块和ecapa_tdnn声纹识别模块中;resnet声纹识别模块和ecapa_tdnn声纹识别模块提取说话人表征。本发明分别对两个模型在多个场景下进行自适应,采用投票法对两个声纹模型自适应后的结果进行融合,对于两个模型出现不同结果的音频认为是集外音频,两个模型相同结果的音频则结合阈值进行判断。投票法不仅可以有效提高模型对于未注册音频和集外数据的识别准确率,同时,投票法还可以降低模型的方差,减少过拟合的风险。技术研发人员:温正棋,雷娣受保护的技术使用者:北京中科智极科技有限公司技术研发日:技术公布日:2024/1/25本文地址:https://www.jishuxx.com/zhuanli/20240618/21196.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表