一种基于多传感器融合的建筑机器人及其定位方法与流程

- 国知局

- 2024-09-11 14:23:15

本发明属于建筑机器人,特别是涉及一种基于多传感器融合的建筑机器人及其定位方法。

背景技术:

1、随着建筑行业的高质量快速发展和自动化水平的提高,建筑机器人已经成为现代建筑工程中不可或缺的重要工具,而精确和可靠的建筑机器人定位系统成为提高施工效率与安全性的关键技术。在目前的建筑机器人定位技术中,已有一些基于多传感器融合的方法,如利用gps、惯性测量单元(imu)、激光雷达等传感器结合使用,但这些方法存在不足之处。传统的gps定位在室内环境下精度不高,并且容易受到建筑物遮挡的影响,导致定位不准确。单一传感器的使用往往无法满足复杂环境下的定位需求,例如在高楼大厦或密集建筑群内,传感器的信号易受到干扰或阻塞,导致定位精度下降。imu虽然可以提供机器人的姿态信息,但长时间使用容易积累误差,导致定位漂移问题。基于激光雷达的视觉定位方法虽然具有一定的精度和灵活性,但在复杂建筑环境中往往受到光照、遮挡和纹理等因素的影响,容易出现定位失效或误差较大的情况。现有技术在定位过程中往往无法充分考虑建筑物的结构和布局信息,缺乏对建筑环境的全面认知,导致定位不够精确和可靠。

技术实现思路

1、本发明旨在提供了一种基于多传感器融合的建筑机器人及其定位方法,解决了现有的建筑机器人定位技术存在定位不够精确和不可靠的问题。

2、为了达到上述发明目的,本发明采用的技术方案如下:

3、提供了一种基于多传感器融合的建筑机器人,其包括机器人本体,所述机器人本体上设置有激光雷达、双目相机、惯性测量单元和无迹卡尔曼滤波器;激光雷达用于获取周围环境的三维点云数据;双目相机用于获取周围环境的图像数据;惯性测量单元用于获取机器人本体的动态数据;无迹卡尔曼滤波器用于将三维点云数据、图像数据和动态数据转化到相同的坐标系,实时生产机器人本体的定位结果。

4、进一步地,所述双目相机安装在机器人本体的前部或顶部,图像数据包括机器人本体行进路径和作业面的图像;

5、所述惯性测量单元安装在机器人本体的中心质心位置;动态数据包括机器人本体的姿态、加速度和角速度数据。

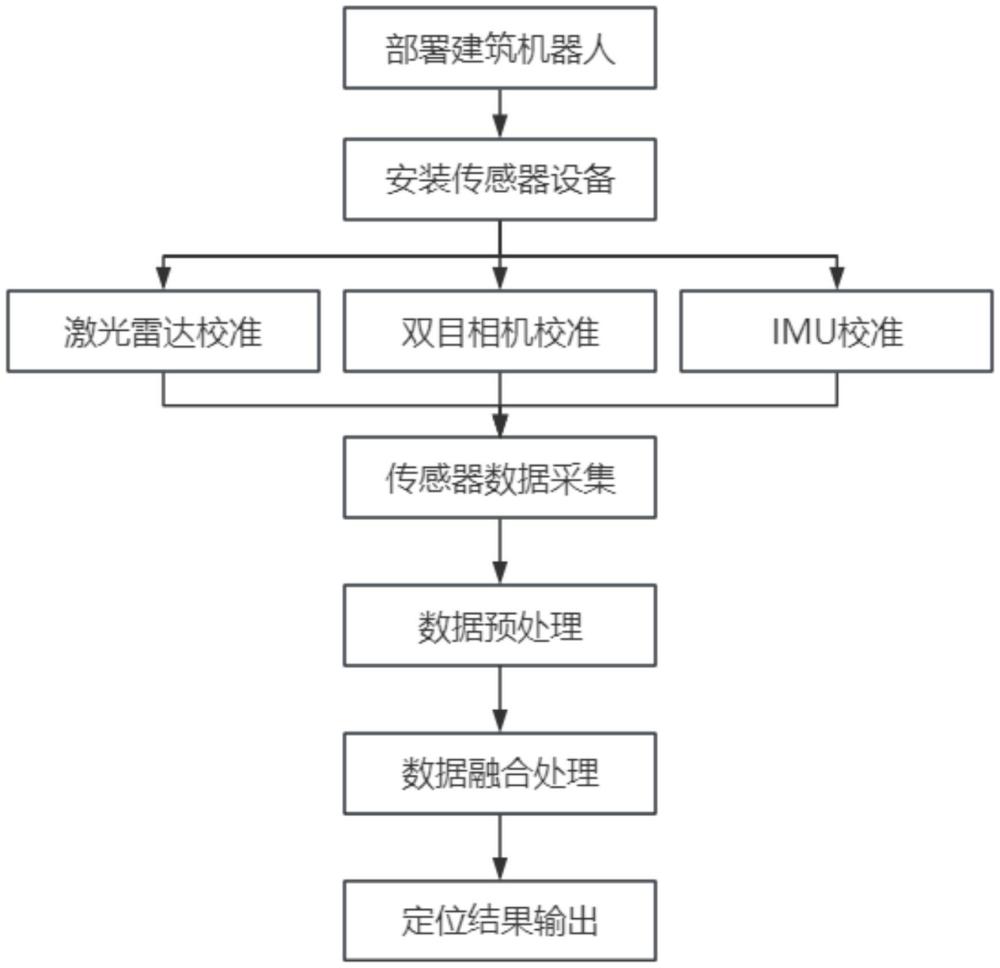

6、本发明还提供一种基于多传感器融合的建筑机器人的定位方法,其包括:

7、步骤1、部署建筑机器人;

8、步骤2、将激光雷达、双目相机、惯性测量单元和无迹卡尔曼滤波器安装在机器人本体上;

9、步骤3、校准激光雷达、双目相机和惯性测量单元;

10、步骤4、激光雷达获取周围环境的三维点云数据、双目相机获取周围环境的图像数据、惯性测量单元获取机器人本体的动态数据;

11、步骤5、对步骤4中的三维点云数据、图像数据和动态数据进行数据预处理;

12、步骤6、无迹卡尔曼滤波器将预处理后的三维点云数据、图像数据和动态数据转化到相同的坐标系并进行数据融合,实时生产机器人的定位结果;

13、步骤7、输出定位结果。

14、具体地,在步骤3中,激光雷达与双目相机之间通过转换矩阵t进行空间配准,转换矩阵t的计算公式为:

15、t=[rcl tcl 0 1] 1)

16、

17、其中,rcl是3×3的旋转矩阵,tcl是3×1的平移向量;是双目相机坐标系中的点,是激光雷达坐标系中的点;

18、将n对对应点带入计算公式2)中,得到n个方程组,使用最小二乘法求解n个方程组,可以得到rcl、tcl和转换矩阵t。

19、进一步地,在步骤3中,对惯性测量单元进行零偏校准和比例因子校准;

20、所述零偏校准用于消除性测量单元在静止状态下输出的非零值;

21、所述比例因子校准用于确保惯性测量单元的输出值与实际物理量之间的比例关系正确。

22、进一步地,,在步骤4中,所述激光雷达通过发射激光脉冲并测量反射回来的时间差来获取环境中物体的距离信息,距离信息的计算公式为:

23、

24、其中,d为距离信息;c为光速;δt为时间差;激光雷达会扫描周围环境,生成三维点云数据,其中每个点都包含了其在三维空间中的坐标信息(x,y,z);

25、所述双目相机采集的图像数据需要进行立体匹配和深度计算,从而得到图像中每个像素点的深度值;

26、通过在一个相机采集的图像中选取一个点pl,在另一个相机采集的图像中搜索与点pl对应的点pr,并让点pl和点pl之间的像素距离最小实现立体匹配;

27、每个像素点深度值的计算公式为:

28、

29、其中,z为每个像素点深度值;m为双目相机的焦距;b为双目相机的基线距离;h为双目相机的像素距离;

30、所述惯性测量单元包括陀螺仪和加速度计,实时测量建筑机器人的括机器人本体的姿态、加速度和角速度数据。

31、进一步地,在步骤6中无迹卡尔曼滤波器进行数据融合包括:

32、步骤6.1、建立状态方程描述机器人状态随时间的变化,状态方程为:

33、xk=f(xk-1,uk)+wk

34、其中,xk为机器人的状态向量,f为状态转移函数机器人的状态向量,uk为惯性测量单元的控制输入,wk是过程噪声,通常假设为高斯噪声;

35、步骤6.2、建立测量方程描述激光雷达和双目相机与机器人状态之间的关系;测量方程为:

36、zk=h(xk)+vk

37、其中,zk为机器人的测量向量,h(xk)为测量函数;vk为测量噪声;

38、步骤6.3、无迹卡尔曼滤波器根据当前机器人的状态向量的平均值和协方差矩阵,通过无迹变换生成sigma点集,并将sigma点集带入状态方程计算得到预测状态的sigma点集;

39、当前机器人的状态向量的平均值的计算公式为:

40、

41、协方差矩阵的计算公式为:

42、

43、其中,为当前机器人的状态向量的平均值,ξi是sigma点集,和是sigma点对应的权重,qk是过程噪声协方差矩阵;

44、步骤6.4、将预测状态的sigma点集代入测量方程,计算得到预测观测量的sigma点集;

45、步骤6.5、根据预测观测量的sigma点集和实际观测值,计算卡尔曼增益,并利用卡尔曼增益更新状态估计的均值和协方差矩阵;

46、卡尔曼增益的计算公式为:

47、

48、更新状态估均值的计算公式为:

49、

50、更新状态协方差矩阵的计算公式为:

51、

52、其中,rk是测量噪声协方差矩阵,hk是测量方程的雅可比矩阵,zk是在时刻k的测量值,是通过测量函数h得到的预测测量值。

53、进一步地,在步骤6中,机器人的定位结果为无迹卡尔曼滤波器进行数据融后输出的更新状态估均值,该更新状态估均值是一个向量,包含了机器人在三维空间中的位置(x,y,z)、速度和姿态;

54、更新状态估均值的表达式为:

55、

56、其中,(xk,yk,zk)表示机器人在第(k)个时间步的三维位置;为表示机器人在在第(k)个时间步的三维速度。

57、进一步地,在步骤7中,对定位结果进行坐标变化并通过显示屏可视化展示;定位结果进行坐标变化的计算公式为:

58、[xk yk zk]=rm[xk yk zk]+tk

59、其中,[xk,yk,zk]为地图坐标系下的位置;[xk,yk,zk]为机器人坐标系下的位置;rm为机器人坐标系到地图坐标系的旋转矩阵;tk为平移向量。

60、本发明的有益效果为:1、提高定位精度与稳定性:多传感器融合技术能够集成来自不同传感器的数据,如激光雷达、视觉相机、imu(惯性测量单元)等。每种传感器都有其特定的优势和适用场景,通过融合不同传感器的数据,可以相互补充,从而显著提高定位精度。例如,激光雷达可以提供高精度的距离信息,视觉相机可以提供丰富的纹理和颜色信息,而imu则可以提供加速度和角速度等动态信息。

61、2、通过融合技术的方法,本发明极大地增强了机器人对于外部干扰因素的鲁棒性。例如,在视线被遮挡或光线条件恶劣时,激光雷达和imu数据的权重会可进行调整,确保定位系统的可靠性。相反,若雷达探测受到限制,双目相机和imu的数据则可填补空白,保障连续的定位效果。

62、3、多传感器融合技术可以实现实时更新和动态调整。通过不断融合来自不同传感器的数据,机器人可以实时更新其位置估计,并根据环境的变化动态调整其运动方向,确保其在复杂环境中高效、安全地完成任务。

63、综上所述,本发明可使建筑机器人无论在室内还是室外复杂环境中完成高精度的自主定位。全方位的传感器数据覆盖与智能的融合处理方法使其减少误差积累,提高当机器人在复杂环境如大面积遮挡或传感器暂时失效等状况的操作灵活性。此系统相对于传统的单一传感器定位方法在精度、稳定性、鲁棒性方面都有较高的提升,为建筑机器人的自动化施工提供了技术支持。

本文地址:https://www.jishuxx.com/zhuanli/20240911/290522.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。