全景视觉与激光雷达融合的语义SLAM优化方法与流程

- 国知局

- 2024-11-21 11:40:38

本发明涉及环境感知,尤其涉及全景视觉与激光雷达融合的语义slam优化方法。

背景技术:

1、随着机器人技术和自动驾驶技术的快速发展,slam(同步定位与地图构建)技术在机器人导航、环境感知和自动驾驶等领域得到了广泛应用。slam技术通过传感器采集环境数据,实时构建环境地图,并实现自身在环境中的定位,成为机器人实现自主导航和环境交互的关键技术。全景视觉和激光雷达作为两种主要的环境感知手段,分别具有广阔的视野和高精度的距离测量能力,能够为slam系统提供丰富的环境信息。

2、现有技术中,全景视觉slam和激光雷达slam在实际应用中存在以下技术问题,首先,全景视觉slam虽然能够提供广阔的视野,但在复杂环境中容易受到光照变化、动态障碍物等因素的影响,导致图像数据存在盲区和误差;激光雷达slam虽然具备高精度的距离测量能力,但在高反射或吸收材料表面容易产生测量误差,单一使用全景视觉或激光雷达都无法完全克服这些问题,其次,现有slam技术大多依赖于传统的几何特征提取和匹配方法,缺乏对环境中对象和结构的语义理解,导致生成的地图信息有限,无法满足机器人在复杂环境中的高精度导航和决策需求,最后,现有slam系统在动态环境中的适应性较差,难以实时更新和优化地图,导致系统在环境变化时出现定位误差和地图失效的情况,影响机器人的自主运行能力。

技术实现思路

1、基于上述目的,本发明提供了全景视觉与激光雷达融合的语义slam优化方法。

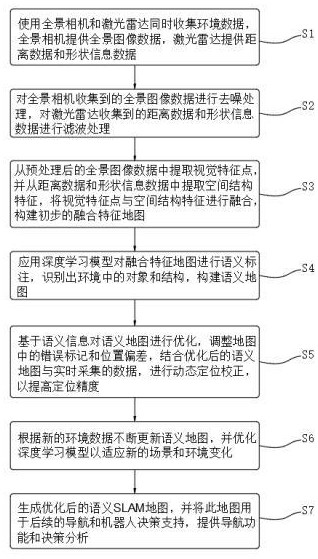

2、全景视觉与激光雷达融合的语义slam优化方法,包括以下步骤:

3、s1,数据采集:使用全景相机和激光雷达同时收集环境数据,其中,全景相机提供全景图像数据,激光雷达提供距离数据和形状信息数据,

4、s2,数据预处理:对全景相机收集到的全景图像数据进行去噪处理,对激光雷达收集到的距离数据和形状信息数据进行滤波处理;

5、s3,特征提取与融合:从预处理后的全景图像数据中提取视觉特征点,并从距离数据和形状信息数据中提取空间结构特征,将视觉特征点与空间结构特征进行融合,构建初步的融合特征地图;

6、s4,语义解析与地图构建:应用深度学习模型对融合特征地图进行语义标注,识别出环境中的对象和结构,构建语义地图;

7、s5,地图优化与定位校正:基于语义信息对语义地图进行优化,调整地图中的错误标记和位置偏差,结合优化后的语义地图与实时采集的数据,进行动态定位校正,以提高定位精度;

8、s6,学习更新:根据新的环境数据不断更新语义地图,并优化深度学习模型以适应新的场景和环境变化;

9、s7,输出与应用:生成优化后的语义slam地图,并将此地图用于后续的导航和机器人决策支持,提供高精度的导航功能和决策分析。

10、可选的,所述s1具体包括:

11、s11,硬件配置:采用提供360度全景图像的相机,选择一个或多个激光雷达,根据需要的精度和范围进行配置,激光雷达通过发射激光脉冲并测量其反射时间来获取物体的距离和形状信息,生成高精度的三维点云图;

12、s12,安装与定位:将全景相机和激光雷达安装在背包式扫描设备上,有助于减少由于传感器之间的物理分离而造成的数据不一致性,确保全景相机和激光雷达之间的相对位置固定且已知;

13、s13,时间同步:对全景相机和激光雷达进行时间同步,确保两者收集的数据在时间上对齐,通过使用精确的时钟源如gps时钟来实现,以确保数据准确匹配;

14、s14,数据采集:同时操作全景相机和激光雷达进行数据采集,全景相机持续拍摄环境的全景图像,激光雷达扫描周围环境,收集距离和形状信息数据,对于移动平台(如自动驾驶车辆或移动机器人),确保两种传感器能够适应不同的移动速度和环境条件。

15、可选的,所述s2具体包括:

16、s21,图像数据去噪:采用双边滤波算法,对全景相机收集到的全景图像数据进行去噪处理;

17、s22,距离数据滤波:采用高斯滤波算法,对距离数据进行滤波处理;

18、s23,形状信息数据滤波:采用移动最小二乘法,对形状信息数据进行滤波处理。

19、可选的,所述s3具体包括:

20、s31,视觉特征提取:采用sift(尺度不变特征变换)算法,从预处理后的全景图像数据中提取视觉特征点;

21、s32,空间结构特征提取:采用主成分分析法,从距离数据和形状信息数据中提取空间结构特征;

22、s33,特征融合:使用icp(迭代最近点)算法进行特征点的融合和对齐;

23、s34,融合特征地图构建:将融合后的特征点构建成融合特征地图。

24、可选的,所述s4具体包括:

25、s41,数据准备:对融合特征地图进行语义标签标注,语义标签包括道路、建筑物、行人和车辆,构建一个已标注的融合特征地图数据集,并进行标准化和归一化处理;

26、s42,模型选择:选择3d u-net模型作为深度学习模型;

27、s43,模型训练:将融合特征地图数据集分为训练集和验证集,使用训练集数据训练3d u-net模型;

28、s44,模型应用:在融合特征地图上进行语义标注,识别环境中的关键对象和结构;

29、s45,构建详细的语义化地图:将经过语义标注的融合特征地图集成到一个全局语义地图中。

30、可选的,所述s5中基于语义信息对语义地图进行优化,调整地图中的错误标记和位置偏差,具体包括:

31、s51,错误标记识别:基于已知的语义信息,对当前语义地图上的标记进行验证;

32、s52,位置偏差检测:通过比较连续帧或全景相机和激光雷达收集的环境数据中的同一地标位置,检测位置偏差,若同一地标在连续帧中或与全景相机或激光雷达采集的数据比较时显示空间差异,则存在位置偏差;

33、s53,图优化技术:使用图优化技术调整和优化地图的结构。

34、可选的,所述s5中结合优化后的语义地图与实时采集的数据,进行动态定位校正,以提高定位精度,具体包括:

35、s54,实时数据与地图对齐:使用实时采集的数据进行初步对齐,可以通过gps、imu等传感器提供初始位姿,使用icp算法将实时采集的数据与优化后的语义地图进行精细配准;

36、s55,动态定位校正:将实时采集的数据与优化后的语义地图进行融合,生成最新的特征点集合,使用扩展卡尔曼滤波器对融合后的特征点进行动态定位校正。

37、可选的,所述s6具体包括:

38、s61,数据更新:通过全景相机和激光雷达实时采集新的环境数据,并将数据输入到深度学习模型中进行更新;

39、s62,模型优化:基于新的环境数据,对深度学习模型进行再训练和优化,使用梯度下降算法更新模型参数;

40、s63,语义地图更新:根据新的数据和优化后的模型,对语义地图进行实时更新,确保地图信息的准确性和及时性。

41、可选的,所述s7具体包括:

42、s71,语义slam地图生成:结合实时数据和优化后的模型,生成优化后的语义slam地图

43、s72,导航与决策支持:将语义slam地图用于机器人导航和决策支持,提供路径规划、障碍物避让和目标定位功能;

44、s73,用户接口:通过预设的用户接口展示优化后的语义slam地图,允许用户进行交互和控制,提供地图的可视化展示和数据导出。

45、本发明的有益效果:

46、本发明,通过融合全景视觉与激光雷达数据,结合深度学习模型和优化技术,显著提升了slam系统的定位精度和地图构建的准确性。全景相机提供的全景图像数据和激光雷达提供的距离数据和形状信息数据相互补充,能够在复杂多变的环境中稳定运行,减少了单一传感器带来的数据盲区和误差,提升了整体的可靠性。

47、本发明,采用深度学习模型对融合特征地图进行语义解析与标注,能够智能识别环境中的对象和结构,生成高精度的语义地图。同时,结合实时数据对语义地图进行动态优化和定位校正,系统能够持续学习更新,适应新的环境变化,实现高效的语义slam优化。这不仅提高了地图构建的精度,还增强了系统对环境变化的适应能力。

48、本发明,优化后的语义slam地图为机器人导航和决策提供了精确的基础数据,能够实时生成高精度的导航路径,避让障碍物并进行目标定位,显著提高了机器人在复杂环境中的自主运行能力。此外,通过用户接口展示优化后的语义slam地图,用户可以进行交互和控制,获得直观的可视化展示和详细的地图数据,为机器人决策提供有效的支持,提升了实用性和用户体验。

本文地址:https://www.jishuxx.com/zhuanli/20241120/332347.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。