一种基于航点感知世界模型的机器人操作方法和系统

- 国知局

- 2025-01-10 13:16:28

本发明涉及机器人的操作和深度学习的模型算法设计领域,更具体地,涉及一种基于航点感知世界模型的机器人操作方法和系统。

背景技术:

1、语言引导的机器人操控这是一个在体现人工智能领域中长期存在的研究领域。近年来,由于其在促进人机交互方面的灵活性和实用性,语言引导的机器人操控获得了广泛的研究关注。为此建立了许多基准测试,如rlbench、calvin和vlmbench等。早期方法通过引入强大的表示、精心设计的网络架构或有效的训练机制来提高操控性能。随着视觉-语言模型(vlms)的快速发展,近期研究尝试引入vlms来提高操控准确性和对未见场景/对象的泛化能力。然而,大多数先前的方法倾向于从多模态输入直接学习到低级动作的映射,忽略了环境动态的显式建模,这可能导致在复杂环境中执行动作或计划失败,泛化能力不强。

2、世界模型旨在生成其周围环境的预测模型,考虑不确定性和动态变化。它们已在视频生成、导航和自动驾驶等领域得到广泛研究。例如,genie引入了时空视频分词器和动态模型以自回归方式预测下一视频帧;drivedreamer构建了来自真实驾驶场景的世界模型,以实现合理的驾驶策略生成。一些研究还引入了世界模型用于机器人操控任务,如daydreamer和swim。然而,这些模型通常交替执行世界建模和决策制定,这给模型训练带来了巨大困难,效率也不高。

技术实现思路

1、本发明为克服上述现有技术所述的至少一种缺陷,提供一种基于航点感知世界模型的机器人操作方法和系统。

2、本发明旨在至少在一定程度上解决上述技术问题。

3、为解决上述技术问题,本发明的技术方案如下:

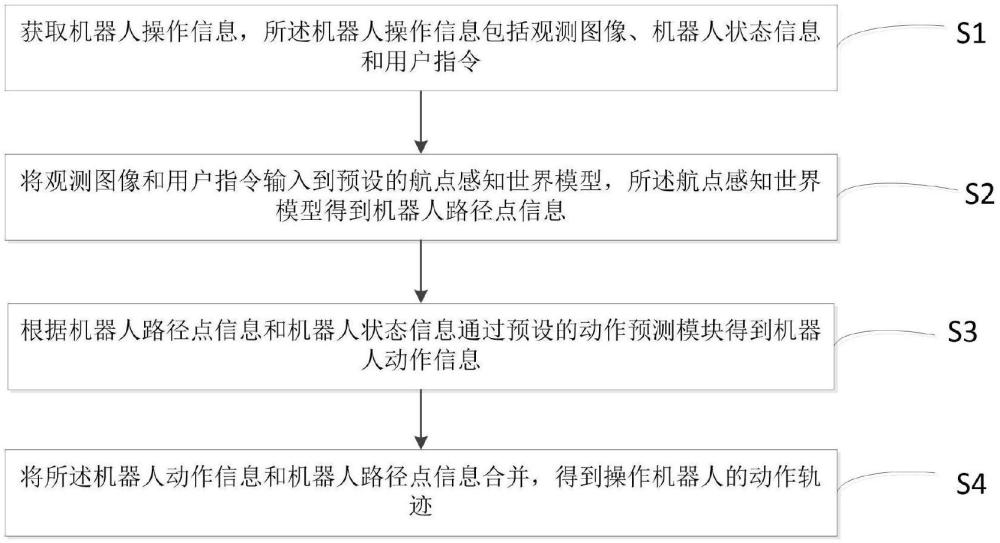

4、一种基于航点感知世界模型的机器人操作方法,包括以下步骤:

5、s1:获取机器人操作信息,所述机器人操作信息包括观测图像、机器人状态信息和用户指令;

6、s2:将观测图像和用户指令输入到预设的航点感知世界模型,所述航点感知世界模型得到机器人路径点信息;

7、s3:根据机器人路径点信息和机器人状态信息通过预设的动作预测模块得到机器人动作信息;

8、s4:将所述机器人动作信息和机器人路径点信息合并,得到操作机器人的动作轨迹。

9、进一步,所述航点感知世界模型包括预训练的视觉语言模型和场景预测模块,所述预训练的视觉语言模型和场景预测模块连接。

10、进一步,步骤s2,所述将观测图像和用户指令输入到预设的航点感知世界模型,所述航点感知世界模型得到机器人路径点信息,包括;

11、s2.1:将机器人当前的观测图像和用户指令合并作为第一输入,将第一输入输入到预训练的视觉语言模型,得到机器人的路径点提示;

12、s2.2:对所述机器人的路径点提示进行文本编码,得到编码后的路径点提示;

13、s2.3:将机器人的历史观测图像经过图像编码作为第二输入;

14、s2.4:将编码后的路径点提示和第二输入输入至场景预测模块,得到机器人路径点信息。

15、进一步,步骤s3中,根据机器人路径点信息和机器人状态信息通过预设的动作预测模块得到机器人的动作信息,包括:

16、将机器人状态信息输入至预设的多层感知机,得到输出结果,所述输出结果与所述第二输入合并作为第三输入并输入到预设的动作预测模块,通过动作预测模块得到机器人的动作信息。

17、进一步,所述第一输入和第二输入输入航点感知世界模型或动作预测模块前,还经过所述异步分层执行器。

18、进一步,所述场景预测模块包括第一自注意力模块、第一交叉注意力模块和第一前馈网络,所述第一自注意力模块、第一交叉注意力模块和第一前馈网络依次相连,所述历史观测图像的路径点特征输入到第一自注意力模块中,得到第一自注意力模块的输出,将路径点提示和第一自注意力模块的输出输入到第一交叉注意力模块,得到第一交叉注意力模块的输出,将第一交叉注意力模块的输出输入第一前馈网络,得到所述机器人路径点信息。

19、进一步,所述动作预测模块包括第二自注意力模块、第二交叉注意力模块和第二前馈网络,所述第二自注意力模块、第二交叉注意力模块和第二前馈网络依次相连,将多层感知机处理后的机器人操作信息和历史观测图像的路径点特征输入第二自注意力模块,得到第二自注意力模块的输出,将第二自注意力模块的输出和路径点特征输入第二交叉注意力模块,得到第二交叉注意力模块的输出,将第二交叉注意力模块的输出输入到第二前馈网络,得到操作机器人的动作轨迹。

20、进一步,所述异步分层执行器分别执行视觉语言模型、场景预测模块、动作预测模块的输入信息和用户指令解析,在执行过程中,所述异步分层执行器返回上一轮的用户指令解析、场景预测模块和动作预测模块的执行结果,在执行结束后,所述异步分层执行器返回当前的用户指令解析、场景预测模块和动作预测模块的执行结果。

21、进一步,步骤s4中,所述操作机器人的动作轨迹包括:

22、tra={l,[o1,s1,a1,m1],...,[ot,st,at,mt]}

23、式中,tra为操作机器人的动作轨迹,l为用户指令,o1,...,ot为历史观测图像,s1,...,st为机器人状态信息,a1,...,at为机器人的动作信息,m1,...,mt为机器人路径点信息,t为时间步长度。

24、一种基于航点感知世界模型的机器人操作系统,应用于所述的机器人操作方法,包括:

25、机器人操作信息获取模块,用于获取机器人操作信息,所述机器人操作信息包括观测图像、机器人状态信息和用户指令;

26、机器人路径点信息获取模块,用于将观测图像和用户指令输入到预设的航点感知世界模型,所述航点感知世界模型得到机器人路径点信息;

27、机器人动作信息获得模块,用于根据机器人路径点信息和机器人状态信息通过预设的动作预测模块得到机器人动作信息;

28、机器人的动作轨迹获取模块,用于将所述机器人动作信息和机器人路径点信息合并,得到操作机器人的动作轨迹。

29、与现有技术相比,本发明技术方案的有益效果是:

30、本发明首先收集机器人的操作信息,包括观测到的图像、机器人的当前状态信息以及用户给出的指令,操作信息被输入到一个预设的航点感知世界模型中,得到机器人的路径点信息,路径点信息和机器人的状态信息通过一个预设的动作预测模块计算出机器人应采取的动作信息。最后,将计算得到的机器人动作信息与路径点信息合并,生成并输出操作机器人的完整动作轨迹。本发明基于航点感知世界模型显著提升机器人的操控能力,能够更好地理解和预测动态环境。

技术特征:1.一种基于航点感知世界模型的机器人操作方法,其特征在于,包括以下步骤:

2.根据权利要求1所述的基于航点感知世界模型的机器人操作方法,其特征在于,所述航点感知世界模型包括预训练的视觉语言模型和场景预测模块,所述预训练的视觉语言模型和场景预测模块连接。

3.根据权利要求2所述的基于航点感知世界模型的机器人操作方法,其特征在于,步骤s2,所述将观测图像和用户指令输入到预设的航点感知世界模型,所述航点感知世界模型得到机器人路径点信息,包括;

4.根据权利要求3所述的基于航点感知世界模型的机器人操作方法,其特征在于,步骤s3中,根据机器人路径点信息和机器人状态信息通过预设的动作预测模块得到机器人的动作信息,包括:

5.根据权利要求4所述的基于航点感知世界模型的机器人操作方法,其特征在于,所述第一输入和第二输入输入航点感知世界模型或动作预测模块前,还经过所述异步分层执行器。

6.根据权利要求3所述的基于航点感知世界模型的机器人操作方法,其特征在于,所述场景预测模块包括第一自注意力模块、第一交叉注意力模块和第一前馈网络,所述第一自注意力模块、第一交叉注意力模块和第一前馈网络依次相连,所述历史观测图像的路径点特征输入到第一自注意力模块中,得到第一自注意力模块的输出,将路径点提示和第一自注意力模块的输出输入到第一交叉注意力模块,得到第一交叉注意力模块的输出,将第一交叉注意力模块的输出输入第一前馈网络,得到所述机器人路径点信息。

7.根据权利要求6所述的基于航点感知世界模型的机器人操作方法,其特征在于,所述动作预测模块包括第二自注意力模块、第二交叉注意力模块和第二前馈网络,所述第二自注意力模块、第二交叉注意力模块和第二前馈网络依次相连,将多层感知机处理后的机器人操作信息和历史观测图像的路径点特征输入第二自注意力模块,得到第二自注意力模块的输出,将第二自注意力模块的输出和路径点特征输入第二交叉注意力模块,得到第二交叉注意力模块的输出,将第二交叉注意力模块的输出输入到第二前馈网络,得到操作机器人的动作轨迹。

8.根据权利要求5所述的基于航点感知世界模型的机器人操作方法,其特征在于,所述异步分层执行器分别执行视觉语言模型、场景预测模块、动作预测模块的输入信息和用户指令解析,在执行过程中,所述异步分层执行器返回上一轮的用户指令解析、场景预测模块和动作预测模块的执行结果,在执行结束后,所述异步分层执行器返回当前的用户指令解析、场景预测模块和动作预测模块的执行结果。

9.根据权利要求7所述的基于航点感知世界模型的机器人操作方法,其特征在于,步骤s4中,所述操作机器人的动作轨迹包括:

10.一种基于航点感知世界模型的机器人操作系统,其特征在于,应用于如权利要求1至9任一项所述的机器人操作方法,包括:

技术总结本发明涉及机器人的操作和深度学习的模型算法设计领域,具体地,涉及一种基于航点感知世界模型的机器人操作方法和系统,本发明首先收集机器人的操作信息,包括观测图像、机器人的当前状态信息以及用户给出的指令,操作信息输入到预设的航点感知世界模型中,该模型基于输入生成机器人的路径点信息,将路径点信息和机器人的状态信息通过预设的动作预测模块计算出机器人的动作信息,将计算得到的机器人动作信息与路径点信息合并,生成并输出操作机器人的完整动作轨迹,本发明中的航点感知世界模型捕获关键信息,并在变化的场景中保持了良好的泛化能力。技术研发人员:梁小丹,张凯东,任鹏真受保护的技术使用者:中山大学技术研发日:技术公布日:2025/1/6本文地址:https://www.jishuxx.com/zhuanli/20250110/352064.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。