融合自监督语义学习的行人检测方法

- 国知局

- 2024-10-09 15:49:37

本发明涉及行人检测,具体涉及一种融合自监督语义学习的行人检测方法。

背景技术:

1、在现代智能车辆中,行人检测系统是不可或缺的一部分,它对于确保行车安全、降低事故风险具有至关重要的作用。由于行人在道路环境中的多样性和复杂性,以及对其安全的严格标准,行人检测比其他类型的目标检测更为复杂和关键。

2、深度学习技术的飞速进步和大规模数据集的不断涌现,使得行人检测技术已经进入了一个新的发展阶段,并在性能上取得了显著的提高。尽管行人检测技术取得了一定的进展,其性能仍然难以与人类的感知能力相媲美,现实世界中的复杂环境对行人检测提出了诸多挑战,这些挑战主要体现在行人密集、空间尺度、复杂环境和实时性方面。现实场景中严重遮挡与尺度问题的存在仍然是检测的难点。场景中的严重遮挡会减少特征的判别信息,严重影响模型精度。此外,复杂背景、特征模糊等问题也会影响模型的检测性能。因此,进一步提升行人检测技术的性能,对于推动智能驾驶技术的发展具有重要意义。

技术实现思路

1、为了解决上述问题,本发明提供一种融合自监督语义学习的行人检测方法,通过融合视觉特征和跨模态文本信息,显式建模行人复杂特征,以提高模型在复杂场景下的检测性能。

2、为达到上述目的,本发明采用的技术方案如下:

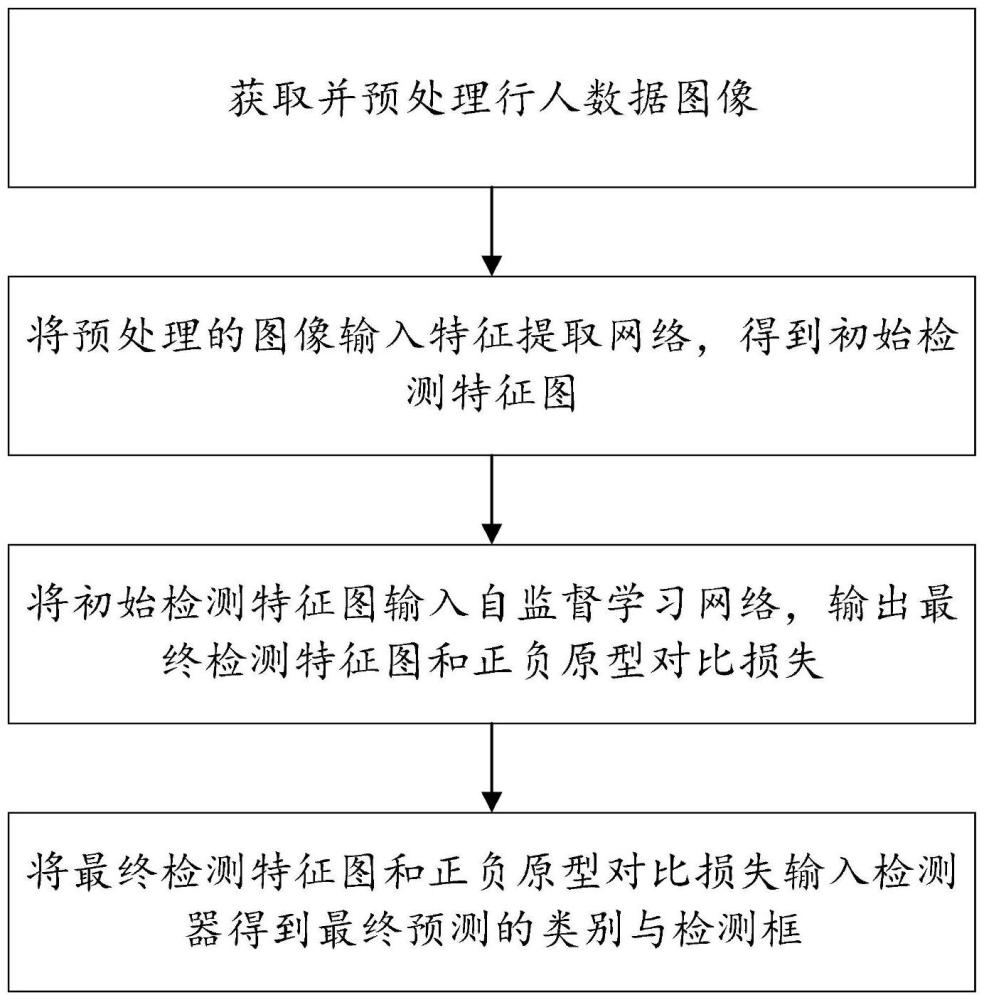

3、一种融合自监督语义学习的行人检测方法,具体包括以下步骤:

4、获取并预处理行人数据图像;

5、将预处理的图像输入特征提取网络,得到初始检测特征图;

6、将初始检测特征图输入自监督学习网络,输出最终检测特征图和正负原型对比损失;

7、将最终检测特征图和正负原型对比损失输入检测器得到最终预测的类别与检测框。

8、进一步地,特征提取网络包括resnet-50网络和动态注意力头;特征提取网络具体包括:将预处理的图像输入resnet-50网络,将resnet-50网络的输出进行反卷积操作,并输入动态注意力头,得到检测特征图。

9、进一步地,动态注意力头的计算公式为:

10、w(f)=πc(πs(πl(f)·f)·f)·f (4)

11、其中,πl(·)、πs(·)和πc(·)分别是作用于维度l、s和c上的三个不同的注意力函数,f表示特征张量;

12、其中,πl(·)表示尺度感知注意力,具体计算公式为:

13、

14、其中,f(·)表示1×1卷积计算,

15、πs(·)表示空间意识注意力,具体计算公式为:

16、

17、其中,k表示稀疏采样位置数,pk+δpk表示自学习空间偏移量,δmk表示自学习位置pk上的重要标量;

18、πc(·)表示任务感知注意力,具体计算公式为:

19、

20、其中,fc表示任务维度的特征切片通道数为c,表示学习控制激活阈值的超函数。

21、进一步地,自监督学习网络包括视觉语言语义分割模块和原型语义对比学习模块;

22、其中,视觉语言语义分割模块中,初始检测特征图通过特征处理层,经过全局平均池化注意力与卷积计算得到检测特征;将检测特征与预训练文本编码器生成的语言向量的输入跨模态交叉促进结构,使用类别权重进行平滑处理的运算,得到结合文本信息的视觉特征,通过残差结构加权得到最终检测特征;将最终检测特征与语言向量进行映射操作,得到预测视觉得分图;将映射网络初始化后生成监督视觉得分图作为伪标签,自监督训练模型;

23、其中,原型语义对比学习模块中,通过输入初始检测特征图和预测视觉得分图,计算得到正负原型,并基于中心点偏移的逐像素聚合实现原型计算,得出正负原型对比损失;

24、自监督学习网络将最终检测特征与预测视觉得分图经过级联卷积操作得到最终检测特征图。

25、进一步地,跨模态交叉促进结构,利用文本信息促进视觉特征的提取,使用残差连接来实现视觉特征的更新,具体包括:特征向量经过全局平均池化得到具体公式为:

26、v=conv1(attnpooling(res5)) (9)

27、v′avg=conv1(avgpooling(v)) (10)

28、其中,res5表示特征向量;

29、经过不同输出维度全连接层得到与具体公式为:

30、vfc=fc(v) (11)

31、v′fc=fc(v′avg) (12)

32、与语言向量进行点积运算,再通过特征平滑处理,再通过softmax函数得到再与v′fc进行交叉运算与卷积操作后得到具体公式包括:

33、vr=conv1(v′fc⊙softmax(pred(vfc⊙l))) (13)

34、其中,特征平滑处理的具体公式为:

35、

36、其中,i=1,2,…,n,j=1,2,...,d,λ表示类别权重,predi表示第i个类别的预测值,predj表示其余所有类别的预测值;

37、最后通过残差连接更新特征,得到最终的视觉特征

38、vf=v+λrvr (14)

39、其中,λr表示控制残差的缩放参数;

40、通过计算预训练语言向量与投影视觉特征之间的余弦相似性,得到预测视觉得分图s。

41、进一步地,原型语义对比学习模块采用预测得分图作为除与行人重叠目标外的空间存在度的指标,将c表示为除行人类外的其他背景类别,其中|c|=n-1,表示由s通过上采样得到,使用加入参数τ′的softmax函数δ将归一化为具体公式为:

42、

43、将目标特征定义为通过对目标特征进行逐像素聚合得到,将行人位置标签的真实值通过中心点计算得到中心图通过计算与真实框中心点的距离,将与真实框中心点偏移未超过一定值的像素点位表述为正样本,实现基于中心点偏移的聚合方法;

44、其中,逐像素聚合的计算公式为:

45、

46、其中,表示通道为d的n-1个其他类别的负原型,表示特征图权重,目标特征在每个位置i=1,2,…,h′w′逐像素聚合。

47、进一步地,正负原型对比损失,包括:加入了特征和原型正则化项,最大化正样本对之间的相似性和最小化负样本对之间的相似性来学习数据的表示,具体计算公式为:

48、

49、其中,将中心图代替去完成逐像素聚合得到正原型p+,对标注了行人的每个逐像素特征ej进行监督,其作为对比损失函数lpsc额外监督的查询,使得所有行人语义靠近p+且远离每个pc-,ej由表示真实框位置信息的中心点图计算得来,其中j为>0的位置且|g>0|的最终数量为m;

50、自监督学习网络还包括:受到ls、lvls和lpsc同时监督,具体公式为:

51、l=ls+λvls·lvls+λpsc·lpsc (19)

52、其中,ls=λcls·lcls+λl1·ll1+λciou·lciou,lcls表示预测分类标签的损失,ll1和lciou分别表示l1损失和ciou损失,lvls表示视觉语言语义分割的损失,λvls、λpsc、λcls、λl1和λciou分别表示对应权重。

53、进一步地,检测器使用混合匹配策略,具体包括:混合一对一匹配以及一对多匹配的混合分层匹配策略,其中,浅层网络通过一对多匹配分层检测器进行预测,深层网络通过一对一分层检测器进行预测;并加入一种标签递增策略来约束浅层网络的匹配效果;

54、其中,在一对多匹配分层检测器中,通过对l1层迭代检测器应用一对多匹配方案处理查询q,并分别对每个检测器层的输出进行预测,对每层中使用最优传输匹配策略,并计算相应的损失,具体公式为:

55、

56、其中,lota表示最优传输匹配策略,pl表示检测器输出的预测锚框;

57、在一对一匹配分层检测器中,对l2层迭代检测器应用一对一匹配方案处理查询q,得到相同数量的预测,在每层的预测锚框与真实标签gt对之间进行二分匹配,使用匈牙利算法进行估计,具体公式为:

58、

59、其中,lhungarian由一个分类损失、一个l1回归损失和一个diou损失组成,g表示真实标签gt对。

60、进一步地,在混合匹配策略中,使用标签递增策略优化训练过程,具体包括:当浅层网络预测不够准确时,让gt提供更少的标签,防止不准确锚框被分配为正样本,影响模型的训练;深层网络的预测相比浅层网络更准确时,让gt提供更多的标签,匹配更多的正样本锚框;

61、其中,标签递增策略的具体公式为:

62、其中,k*表示动态估计标签数量,k表示初始标签数量,t表示检测器总层数,t表示当前检测器层数。

63、相比于现有技术,本发明的有益效果如下:

64、1、本发明通过语言语义分割模块来实现模型自监督训练,使得模型对行人类别识别性能更好。

65、2、本发明利用视觉语言语义映射完成特征提取网络的初始化,使用跨模态交叉促进结构结合跨模态信息进一步增强了模型的显式上下文建模能力。同时加入原型语义对比学习使模型对行人类别有更好的识别能力,为模型添加了对行人语义的额外监督。

66、3、本发明为解决检测中存在的尺度问题,提出为特征提取网络增加动态注意力头,该模块充分利用各层次特征中的语义信息,在多个维度上提升了模型的感知能力。

67、4、本发明集合预测中,通过混合标签分配策略,使模型在保证精度的同时增加更多的正样本,从而优化训练过程。

本文地址:https://www.jishuxx.com/zhuanli/20240929/310309.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表