一种军事大模型的微调训练方法、装置以及设备与流程

- 国知局

- 2024-10-21 14:52:34

本发明涉及军事知识应用,尤其涉及一种军事大模型的微调训练方法、装置以及设备。

背景技术:

1、在军事知识领域的问答场景中,用户倾向于通过直接而高效的问答方式,快速获取准确且权威的军事知识。鉴于军事知识的庞大性和事实的唯一性标准,对问答系统提出了极高的准确性要求。然而,当前的大模型尽管在语言理解和生成方面展现出强大的能力,却常因语言预测规律引发的“不实生成”而构造出与实际情况不符的回答。这种不实生成直接挑战了问答系统评估标准的唯一性,即回答必须严格符合军事知识的事实标准。

2、在尝试通过军事知识微调大模型以提升其准确性的过程中,由于训练次数不足时,模型难以充分学习军事知识的细节,导致回答不够准确;而过度增加训练次数,则可能引发模型过拟合现象,使得模型对问题的表述方式变得过于敏感,即便是针对同一问题的不同表述方式,也可能产生幻觉回答,对事实性知识进行编造,导致错误知识的输出,从而降低了系统的泛化能力和实用性。因此,如何在保证准确性的同时,避免过拟合,成为军事知识问答系统优化中的关键挑战。

技术实现思路

1、有鉴于此,本发明的目的在于提出一种军事大模型的微调训练方法、装置以及设备,旨在解决如何降低大模型在军事知识领域的事实性回答时存在幻觉回答的概率等问题。

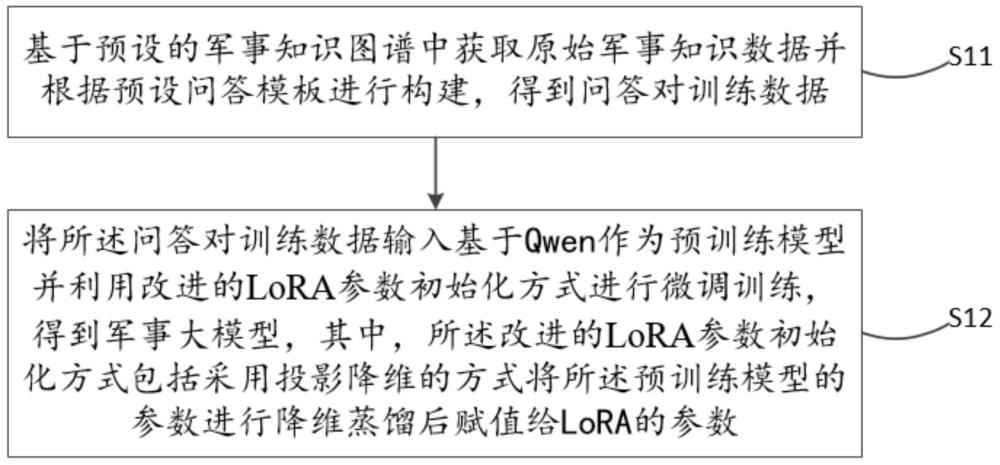

2、为实现上述目的,本发明提供一种军事大模型的微调训练方法,所述方法包括:

3、基于预设的军事知识图谱中获取原始军事知识数据并根据预设问答模板进行构建,得到问答对训练数据;

4、将所述问答对训练数据输入基于qwen作为预训练模型并利用改进的lora参数初始化方式进行微调训练,得到军事大模型,其中,所述改进的lora参数初始化方式包括采用投影降维的方式将所述预训练模型的参数进行降维蒸馏后赋值给lora的参数。

5、优选的,所述lora的参数包括第一参数和第二参数;所述采用投影降维的方式将所述预训练模型的参数进行降维蒸馏后赋值给lora的参数,包括:

6、对所述预训练模型的参数进行去中心化操作,得到初始矩阵;

7、通过计算所述初始矩阵的协方差矩阵,对所述协方差矩阵进行特征值的分解,得到特征值与特征向量,对所述特征值进行降序排列,并取前r个最大的所述特征值对应的所述特征向量作为行向量组成特征向量矩阵;

8、根据所述特征向量矩阵对所述第一参数以及所述第二参数进行初始化,得到第一矩阵以及第二矩阵。

9、优选的,所述对所述预训练模型的参数进行去中心化操作,得到初始矩阵,包括:

10、利用对所述预训练模型的参数进行去中心化操作,得到初始矩阵;其中,表示所述预训练模型的参数,表示所述初始矩阵,表示第i列的一维向量,表示第i列的平均值,n表示所述预训练模型的参数的列数,共有n个列向量。

11、优选的,所述通过计算所述初始矩阵的协方差矩阵,包括:

12、利用计算所述初始矩阵的协方差矩阵;其中,表示所述初始矩阵,表示的转置矩阵,s表示所述协方差矩阵。

13、优选的,所述根据所述特征向量矩阵对所述第一参数以及所述第二参数进行初始化,得到第一矩阵以及第二矩阵,包括:

14、利用对所述第一参数进行初始化,得到所述第一矩阵,利用对所述第二参数进行初始化,得到所述第二矩阵;其中,表示所述预训练模型的参数,表示维的所述特征向量矩阵,表示的转置矩阵,表示的转置矩阵,表示所述第一矩阵,表示所述第二矩阵,m表示所述预训练模型的参数的行数,共有m个行向量。

15、优选的,所述将所述问答对训练数据输入基于qwen作为预训练模型并利用改进的lora参数初始化方式进行微调训练,包括:

16、通过设置包括训练轮次、学习率以及批次大小的超参数,并采用单机多gpu显卡的方式进行模型训练,并在反向传播进行参数更新时,汇总多个gpu显卡上的梯度到其中一个显卡进行参数更新,更新完成后再分发给其它的gpu显卡上的模型,完成多个显卡之间的参数同步。

17、优选的,所述方法还包括:

18、基于所述问答对训练数据随机采样预设条数的样本,对样本中的问题进行相似问题的替换,得到的问答对作为评估测试数据,根据所述评估测试数据评估所述军事大模型,得到评估结果,根据所述评估结果确定所述军事大模型是否达到标准。

19、为实现上述目的,本发明还提供一种军事大模型的微调训练装置,所述装置包括:

20、数据构建单元,用于基于预设的军事知识图谱中获取原始军事知识数据并根据预设问答模板进行构建,得到问答对训练数据;

21、模型训练单元,用于将所述问答对训练数据输入基于qwen作为预训练模型并利用改进的lora参数初始化方式进行微调训练,得到军事大模型,其中,所述改进的lora参数初始化方式包括采用投影降维的方式将所述预训练模型的参数进行降维蒸馏后赋值给lora的参数。

22、为了实现上述目的,本发明还提出一种军事大模型的微调训练设备,包括处理器、存储器以及存储在所述存储器内的计算机程序,所述计算机程序被所述处理器执行以实现如上述实施例所述的一种军事大模型的微调训练方法的步骤。

23、为了实现上述目的,本发明还提出一种计算机可读存储介质,所述计算机可读存储介质上存储有计算机程序,所述计算机程序被处理器执行以实现如上述实施例所述的一种军事大模型的微调训练方法的步骤。

24、为了实现上述目的,本发明还提出一种计算机程序产品,包括计算机程序/指令,所述计算机程序/指令被处理器执行时实现如上述实施例所述的一种军事大模型的微调训练方法的步骤。

25、有益效果:

26、以上方案,通过基于预设的军事知识图谱构建问答对训练数据,确保了训练数据的准确性和专业性,从而提高了军事大模型在回答相关问题时的准确性和可靠性,能够有效减少模型生成“幻觉回答”的可能性,保证了军事信息的真实性和权威性;采用改进的lora参数初始化方式,即通过投影降维技术对预训练模型的参数进行降维蒸馏后赋值给lora参数,显著降低了训练过程中的计算复杂度,提高了训练效率,同时,由于lora参数聚焦于模型中的关键信息,使得微调训练更加精准,进一步提升了模型在军事知识领域的表现能力和泛化能力。

27、以上方案,通过实现lora参数初始化过程,包括去中心化、协方差矩阵计算、特征值分解等步骤,使得模型在训练过程中能够更好地学习到军事知识的内在规律和结构,从而增强了模型对于不同问法或相似问题的泛化能力,减少了过拟合现象。

28、以上方案,在训练过程中,通过采用单机多gpu显卡并行计算的方式,不仅加快了训练速度,还通过梯度汇总和参数同步机制,确保了多个gpu显卡之间训练的一致性和稳定性,该方式便于根据实际硬件资源灵活调整,具有良好的可扩展性。

29、以上方案,通过随机采样并替换相似问题构建评估测试数据,为军事大模型提供了全面而客观的评估标准,这种评估机制能够及时发现模型在回答特定类型问题时的不足,并根据评估结果调整训练策略或优化模型结构,确保军事大模型达到既定标准,满足实际应用需求。

本文地址:https://www.jishuxx.com/zhuanli/20241021/319636.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

上一篇

约减装置及方法与流程

下一篇

返回列表