车辆多目标智能动态融合跟踪方法

- 国知局

- 2024-09-11 14:17:43

本发明涉及计算机视觉、视频分析和模式识别,特别是车辆多目标智能动态融合跟踪方法。

背景技术:

1、车辆目标的多目标跟踪技术在智能交通系统(its)、自动驾驶汽车、视频监控和安全监控等领域发挥着至关重要的作用。传统的跟踪方法,如基于规则的跟踪算法和卡尔曼滤波器,主要依赖于目标的运动信息和外观特征,但它们在处理复杂交通场景时存在局限性,如目标遮挡、光照变化和相机运动等问题。此外,随着时间的积累,传统跟踪算法的误差也容易发散,影响跟踪的精度和稳定性。

2、深度学习和数据关联技术的发展为车辆多目标跟踪带来了新的解决方案。深度学习模型,如卷积神经网络(cnn),能够从大量数据中自动学习到鲁棒的目标特征表示,而数据关联算法,如匈牙利算法和深度匹配网络,能够有效地解决多目标之间的匹配问题。然而,现有的基于深度学习的跟踪方法在实时性和泛化能力上仍面临挑战,尤其是在动态和复杂的交通环境中。为了提高车辆多目标跟踪的准确性和鲁棒性,研究者们提出了结合运动模型和深度学习特征的混合跟踪框架。其中,改进的bot-sort算法通过集成相机运动补偿、卡尔曼滤波器状态估计和iou与reid特征融合等技术,有效地解决了动态相机场景下的目标跟踪问题。相机运动补偿可以校正由于相机运动引起的目标位置变化,卡尔曼滤波器用于预测目标的运动状态,而iou与reid特征融合则结合了目标的运动信息和外观特征,提高了目标匹配的准确性。

3、尽管如此,车辆多目标跟踪系统的性能仍然受到先验模型精确性和实时性的限制。例如,reid特征提取模型通常在特定的数据集上训练,可能缺乏足够的泛化能力来处理实际应用中的多样化场景。此外,实时性要求也限制了算法的复杂度,尤其是在资源受限的设备上部署高性能跟踪算法时。

4、与现有技术对比如下;

5、对比专利1:一种融合图像和激光点云的三维多目标跟踪方法,授权公告日,2020/9/11;授权公告日号:cn110675431b,该发明涉及一种融合图像和激光点云的三维多目标跟踪方法,融合激光雷达的点云以及相机的图像数据,充分发挥点云数据和图像数据之间互补的优势,通过提取目标的三维空间位置信息,点云特征、图像特征,对检测目标与跟踪轨迹之间进行匹配,并结合卡尔曼滤波器对跟踪轨迹进行状态估计,得到准确稳定的三维多目标跟踪。本发明可用于各类无人车中的行人、车辆等运动目标的跟踪和预测,也可以用于安防监控以及无人机对地目标侦察等领域。该方法包括以下步骤:s1.从激光雷达获取点云数据,检测出目标的三维空间位置信息并提取点云特征;s2.从相机获取图像数据,将目标三维边界投影到图像平面,并提取投影区域的图像特征;s3.计算检测到的目标和跟踪轨迹在点云三维空间位置信息、点云特征以及图像特征上的相似度矩阵,并对三个相似度矩阵进行合并;所述步骤s3还包括如下步骤:s31.用t表示视频图像的帧号,在t=0时,将检测的每一个目标初始化为一个跟(x,y,z,θ,l,w,h,vx,vy,vz),其中(x,y,z)为目标的中心点,l为目标的长度,w为目标的宽度,h为目标的高度,θ为目标朝向,vx为目标在x轴方向上的速度,vy为目标在y轴方向上的速度,vz为目标在z轴方向上的速度;s32.在t>0时,首先通过卡尔曼滤波器,预测t-1帧的轨迹在t帧的三维空间位置信息;s33.计算目标和所述跟踪轨迹预测的点云三维空间位置信息、点云特征以及图像特征上的相似度矩阵,并对三个相似度矩阵进行合并;s4.将合并的相似度矩阵通过匈牙利算法计算目标和轨迹之间的二分图匹配关系,并结合卡尔曼滤波器对跟踪轨迹进行状态估计,实现对三维目标的跟踪。

6、虽然同样涉及图像目标跟踪,而本文并未使用激光雷达点云数据,也不是在三维空间内进行目标跟踪,通过新的卡尔曼次优估计以及算法层面的相机动态补偿和re-id特征库和采用k-d树数据关联,实现了纯视觉层面的平面车辆多目标检测。

7、对比专利2:一种基于运动模型的自动化城市公交客车多目标跟踪算法,授权公告日,2023/10/3;授权公告日号:cn116843720a,该发明涉及一种基于运动模型的自动化城市公交客车多目标跟踪算法,属于智能车辆技术领域,主要包括初始化模块,预测模块,轨迹关联模块。初始化模块读取检测文件获取当前帧中每个目标的检测框信息,根据阈值将检测框分为高分检测框和低分检测框,送入轨迹关联模块中;预测模块包括为上一帧中的轨迹分别设置对应的自适应状态转移矩阵,通过卡尔曼滤波获得上一帧中的轨迹在当前帧的预测边界框和协方差矩阵;轨迹关联模块将当前帧校正后的预测边界框先后和高分检测框及低分检测框进行交并比计算。本发明通过结合自适应状态转移矩阵的卡尔曼滤波及相机运动补偿,提高了多目标跟踪算法在自动化城市公交客车上的跟踪效果。具体包括如下步骤:步骤1:初始化模块,用于读取由检测器生成的检测文件,获取当前帧中每个目标的检测框信息并根据阈值将检测框分为高分检测框和低分检测框,送入轨迹关联模块中;步骤2:预测模块,包括为上一帧中的轨迹分别设置对应的自适应状态转移矩阵,通过卡尔曼滤波获得上一帧中的轨迹在当前帧的预测边界框和协方差矩阵,使用相机运动补偿进行相邻两帧的图像配准,通过图像配准得到相邻两帧的仿射变换矩阵,拆分仿射变换矩阵为缩放旋转和转换两部分,将这两部分分别和卡尔曼滤波获得的预测边界框和协方差矩阵结合,校正得到更加贴合目标真实位置的预测边界框和协方差矩阵;步骤3:轨迹关联模块,将当前帧校正后的预测边界框先后和高分检测框及低分检测框进行交并比计算,重叠度高并且大于阈值的预测边界框和检测框再放进匈牙利算法进行数据关联,成功和校正后预测边界框关联上的检测框则被认为是当前帧中的轨迹。

8、虽然同样涉及卡尔曼滤波以及轨迹关联,而本文使用了更有效的卡尔曼次优估计并优化了噪声测量矩阵和测量噪声矩阵,并且使用动态相机补偿技术,而且使用了re-id特征来解决目标遮挡重入导致id切换问题,轨迹关联采用iou和re-id融合来获取关联结果,并且使用k-d树数据结构维护re-id特征库。

技术实现思路

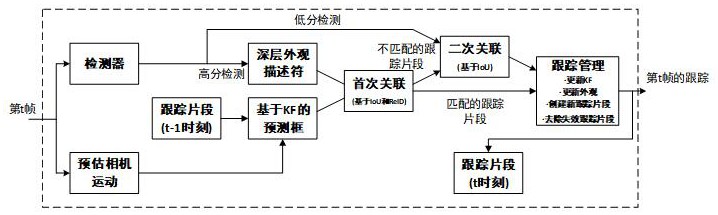

1、为解决上述技术问题,本发明提出了车辆多目标智能动态融合跟踪方法,该方法通过优化数据关联策略、引入实时性能优化技术和提高模型的泛化能力,旨在提供一种鲁棒、准确且高效的车辆跟踪解决方案。

2、为实现上述目的,本发明采取的技术方案是:使用卡尔曼次优估计提高边界框宽高与目标的拟合度;使用动态相机补偿校正因相机运动导致的误差;使用iou和re-id融合的特征关联方式减少id切换的概率。

3、车辆多目标智能动态融合跟踪方法,包括如下步骤:

4、(1)使用目标检测器对视频序列的每一帧进行目标检测,获取车辆目标的位置和大小信息,得到检测结果集合;

5、(2)利用卡尔曼滤波器对车辆目标的运动进行建模和状态估计,使用八元组的方法表示:

6、

7、其中xc(k),yc(k),w(k),h(k)分别代表当前目标中心的横纵坐标以及目标框的宽和高,为下一帧预测的中心的横纵坐标以及目标框的宽和高,第k帧的测量向量为:

8、

9、其中,分别代表目标中心在图像平面上的二维坐标的测量值,zw(k),zh(k)分别代表目标的宽度和高度的测量值;

10、(3)使用相机运动补偿技术,通过图像配准估计相机的运动,并校正卡尔曼滤波器的预测,以适应动态相机场景;

11、(4)将当前帧的检测结果与已有的跟踪轨迹进行关联,使用改进的iou和re-id特征融合方法来增强关联的鲁棒性;

12、(5)解决全局分配问题,将检测到的车辆目标与现有轨迹相关联,并更新或维护跟踪轨迹。

13、作为本发明进一步改进,步骤(2)中利用卡尔曼滤波器对车辆目标的运动进行建模和状态估计中重建了新的噪声协方差向量qk和测量噪声协方差rk:

14、

15、其中,σp=0.05,σv=0.00625,σm=0.05,qk用来量化在状态预测步骤中的不确定性,矩阵内每个元素分别代表了目标宽度、高度、宽度变化率和高度变化率的预测不定性;rk用来量化在状态更新步骤中,由测量过程引入的不确定性,矩阵内的元素分别代表目标宽度和高度测量的不确定性。

16、作为本发明进一步改进,步骤(3)中的相机运动补偿技术包括如下步骤:

17、(3-1)从视频序列的连续两帧中提取图像关键点;

18、(3-2)使用稀疏光流算法跟踪关键点,从而估计特征点在两帧之间的运动;

19、(3-3)通过局部异常因子等方法剔除动态车辆目标引起的异常点,以更准确地估计背景的刚体运动;

20、(3-4)使用ransac算法从跟踪的点对中求解仿射变换矩阵

21、

22、其中,a11,,a22表示缩放因子,a12,,a21表示旋转因子,a13,,a23表示平移因子;

23、(3-5)构造变换矩阵和平移向量用于将仿射变换应用于卡尔曼滤波器的状态向量:

24、

25、其中,为仿射矩阵中的旋转部分;使用变换矩阵更新卡尔曼滤波器的预测状态向量

26、

27、并更新卡尔曼滤波器的预测协方差矩阵pk|k-1:

28、

29、(3-6)利用计算得到的更新卡尔曼滤波的参数:

30、

31、其中,kk为更新后的卡尔曼增益,为使用观测值zk更新后的状态估计向量,pk|k为更新后的估计误差协方差。

32、作为本发明进一步改进,步骤(4)中使用改进的iou和re-id特征融合方法来关联当前帧的检测结果与已有的跟踪轨迹包括如下步骤:

33、(4-1)计算预测的跟踪边界框与当前帧中检测到的目标边界框之间的iou距离dioui,j:

34、dioui,j=1-iou(i,j)

35、其中,i是预测的跟踪索引,j是当前帧中检测到的对象索引。

36、(4-2)对于当前帧中的每个检测以及每个跟踪,使用特征提取网络提取re-id特征,并计算它们之间的余弦距离

37、

38、其中,θemb为外观距离阈值,θiou为iou距离阈值,

39、(4-3)使用最小值策略,将iou距离和调整后的外观距离结合起来,形成最终的成本矩阵ci,j:

40、

41、(4-4)使用匈牙利算法来最小化成本矩阵c的总和,从而完成当前帧检测与现有跟踪之间的最佳关联,并根据关联结果,更新匹配跟踪的状态,包括位置、尺寸和外观特征。本发明中,所用的re-id特征提取网络为改进后的轻量级网络,旨在从目标的图像中提取出能够表征目标外观的高维特征,并保存到特征库中,然后在设置的生命周期内比较这些特征的相似度来识别目标,使用k-d树存储提取到的re-id特征,通过余弦相似度,欧氏距离等尺度维护k-d树索引从而实现更快的特征匹配。

42、有益效果:本发明的车辆多目标智能动态融合跟踪方法通过融合kalman滤波器的运动预测、iou与reid特征的联合匹配以及相机运动补偿,显著提升了复杂交通场景下车辆目标跟踪的准确性和鲁棒性。该方法特别适用于智能交通系统、自动驾驶汽车、视频监控和安全监控等领域,能够有效处理目标遮挡、光照变化、相机运动和多目标交互等问题,同时算法优化满足了实时处理的需求,适合快速响应的应用场景。此外,该方法的模块化设计易于集成和扩展,提高了在多样化交通环境中的跟踪性能,减少了误匹配概率,对于提升智能交通系统和自动驾驶汽车的安全性与效率具有重要意义。

本文地址:https://www.jishuxx.com/zhuanli/20240911/290068.html

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 YYfuon@163.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表